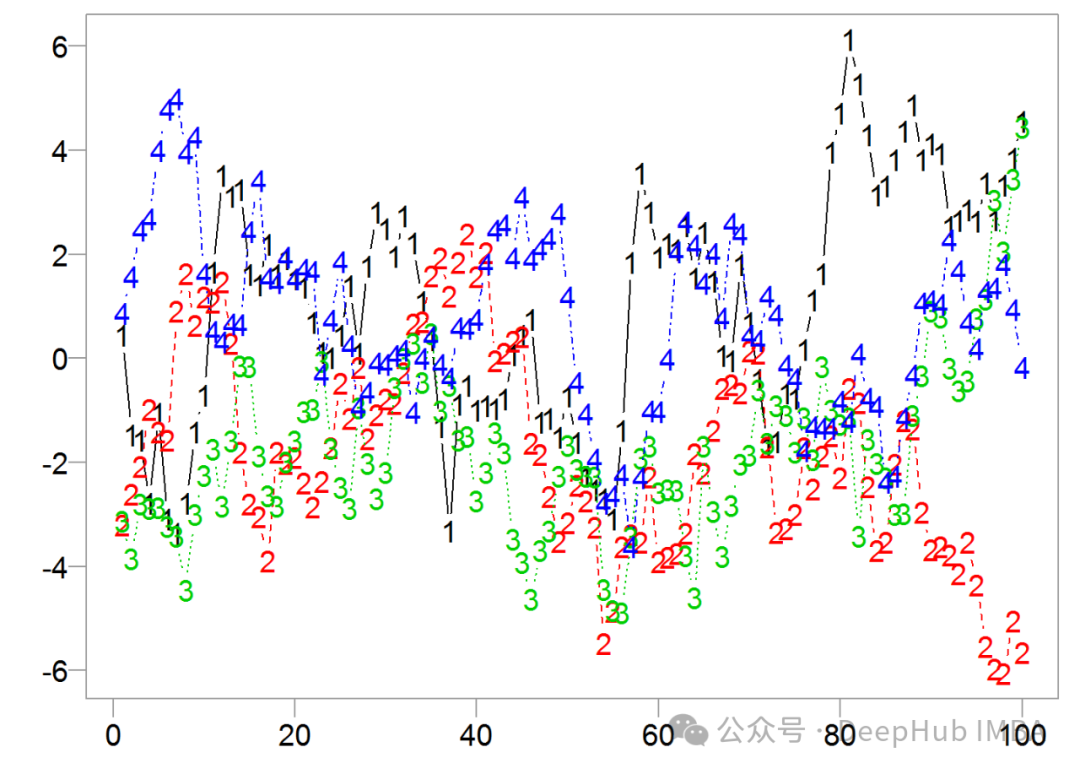

高效的时间序列可视化:减少认知负荷获得更清晰的洞察

在本文中,我们将探讨使真实世界的**疫苗接种数据**来可视化单个时间序列和多个时间序列。

零基础学习人工智能—Python—Pytorch学习(六)

前言本文主要讲神经网络的上半部分。这篇文章开始有很多公式了,这些公式都很简单,但是如果是不经常在脑海里思考公式的人,那可能需要多花点时间做一下自我训练,个人感觉,也就几天时间,就能把自己感觉给调整出来。习惯了公式看下面内容就会轻松很多,另外如果要深入学习人工智能,熟练的认知公式也是个必须的事情。另外

XGBoost中正则化的9个超参数

正则化是一种强大的技术,通过防止过拟合来提高模型性能。本文将探索各种XGBoost中的正则化方法及其优势。

【AsyncOpenAI vs OpenAI】在异步函数中调用OpenAI API进行流式输出

同步编程是指程序在执行一个任务时,必须等待该任务完成才能继续执行下一个任务。相反,异步编程允许程序在等待某个任务完成的同时,继续执行其他任务,从而提高程序的效率和响应速度。

【备忘】CogVLM2环境搭建2 —— 使用问题,triton无法编译

如果想看搭建基础环境的,请参考,虽然环境跑起来了,但是第一通对话就不成功,显示如下问题留意其中最后几行,triton在编译中(compiler.py)有问题。问题出在编译中使用系统的gcc,链接了系统的cuda库的libcuda.so编译报错,返回值为1(即异常返回),所以triton编译不成功,没

【已解决】onnx无法找到CUDA的路径

环境变量没问题的话,一般就是cudnn和cuda以及oxxn的版本不匹配。查看好自己cudnn和cuda对应oxxn版本后,输入这个。换成你需要的版本,如我是cuda12.x以及cudnn8.x。oxnn找到了gpu,但是还是不能调用。

Midjourney Imagine API 申请及使用(大陆地区)

通过以上内容的介绍,我们已经了解了Mural API Midjourney API 的使用方法。有了这个 API,我们可以在本地进行调用AI画图来实现自己的需求,实现与官方 Midjourney 一模一样的对接。大家可能好奇,这个 API 的价格套餐是怎样的呢?

为什么选择Python学习人工智能与机器学习?

丰富的库和框架Python拥有广泛的库和框架支持,如TensorFlow、Keras、PyTorch、Scikit-learn等,这些都是专门为机器学习和深度学习开发的。这些工具大大简化了算法的实现、数据的处理和模型的训练过程。

小白学大模型:LLaMA-Factory 介绍与使用

最近这一两周看到不少互联网公司都已经开始秋招提前批了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。Efficient fine-tuning对于将大型语

什么是人工智能 (AI)

什么是人工智能 (AI)

Chainlit一个快速构建成式AI应用的Python框架,无缝集成与多平台部署

Chainlit 是一个开源 Python 包,用于构建和部署生成式 AI 应用的开源框架。它提供了一种简单的方法来创建交互式的用户界面,这些界面可以与 LLM(大型语言模型)驱动的应用程序进行通信。Chainlit 旨在帮助开发者快速构建基于文本的 AI 应用,如聊天机器人、问答系统等,并且支持实

再谈Agent:Dify智能体实现Txet2SQL

什么是Agent?Agent的是能够在一定环境中自主运作并完成特定任务的程序或者系统。自主性:Agent能够在没有人为干预的情况下运行,并独立做出决策。适应性:Agent能够根据环境的变化调整自己的行为。反应性:Agent能够对环境中的变化做出快速反应。预动性:Agent不仅对环境做出反应,还能主动

使用Python和scikit-learn实现支持向量机(SVM)

支持向量机是一种二类分类模型,它的基本思想是在特征空间中找到一个最优的超平面,能够将不同类别的数据点分隔开来,并且使得两侧距离最近的数据点(支持向量)到超平面的距离最大化。对于非线性可分的数据集,SVM通过核函数将数据映射到高维空间,使得数据线性可分。# 定义绘制决策边界和支持向量的函数# 确定绘图

MaskRCNN 在 Windows 上的部署教程

在’train’模式下,主要关注dataset、weights和logs参数,确保它们正确指向了训练所需的数据集、权重文件和日志目录。在’splash’模式下,除了上述参数外,还需要关注image或video参数,确保它们正确指向了要检测的目标图像或视频文件。同时,weights参数应指向一个已训练

从零开始微调阿里的qwen_vl_chat模型

通过这个重定向,标准错误输出和标准输出都会被写入 train.log 文件。这个脚本文件名为 finetune_lora_single_gpu.sh,通常用于单 GPU 上进行 LoRA(Low-Rank Adaptation)的微调。模型训练完会保存在output_qwen文件中,想要修改去fin

使用TensorRT进行加速推理(示例+代码)

TensorRT 是 NVIDIA 开发的一款高性能深度学习推理引擎,旨在优化神经网络模型并加速其在 NVIDIA GPU 上的推理性能。它支持多种深度学习框架,并提供一系列优化技术,以实现更高的吞吐量和更低的延迟。TensorRT(NVIDIA Tensor Runtime)是由 NVIDIA 开

【人工智能】Python融合机器学习、深度学习和微服务的创新之路

本文探讨了AI技术的发展历程、创新应用和微服务架构的作用。技术进步:AI技术在算法和应用方面的显著进展。微服务架构:提高了AI系统的灵活性和可扩展性。挑战与展望:数据隐私、伦理和未来技术趋势的挑战和机遇。

2024年AI前20岗位薪酬出炉!搞AI大模型的远超同行?

AI相关,细分技术领域,薪资前20岗位,都有哪些。今天这篇文章与铁铁们分享一下。

AI舌苔诊病(文心快码Baidu Comate)进行代码解析与完成项目二创

可以从我的插件栏上看到我测试了很多款的工具,其实使用文心快码Baidu Comate的时间还是最多的,大模型有很多,都是喂数据,喂的多的我相信百度说第二就没人敢说第一了,所以对于AI代码助手来说,我选择百度的文心快码,好用。

anaconda修改安装的默认环境

📚✨🎃。