AI人工智能深度学习算法:在缺陷检测中的应用

AI人工智能深度学习算法:在缺陷检测中的应用1. 背景介绍1.1 缺陷检测的重要性在现代制造业中,产品质量是关键因素之一。缺陷检测是确保产品符合预期质量标准的重要环节。传统的人工检测方法存在效率低下、疲劳造成的错误率高等

人工智能-机器/深度学习---算法

本文讲的主要是深度学习中常见的几种神经网络算法 比如GANs CNN等

差分隐私与联邦学习安全原理与代码实战案例讲解

差分隐私与联邦学习安全原理与代码实战案例讲解作者:禅与计算机程序设计艺术 / Zen and the Art of Computer Programming1. 背景介绍1.1 问题的由来在大数据时代,数据隐私

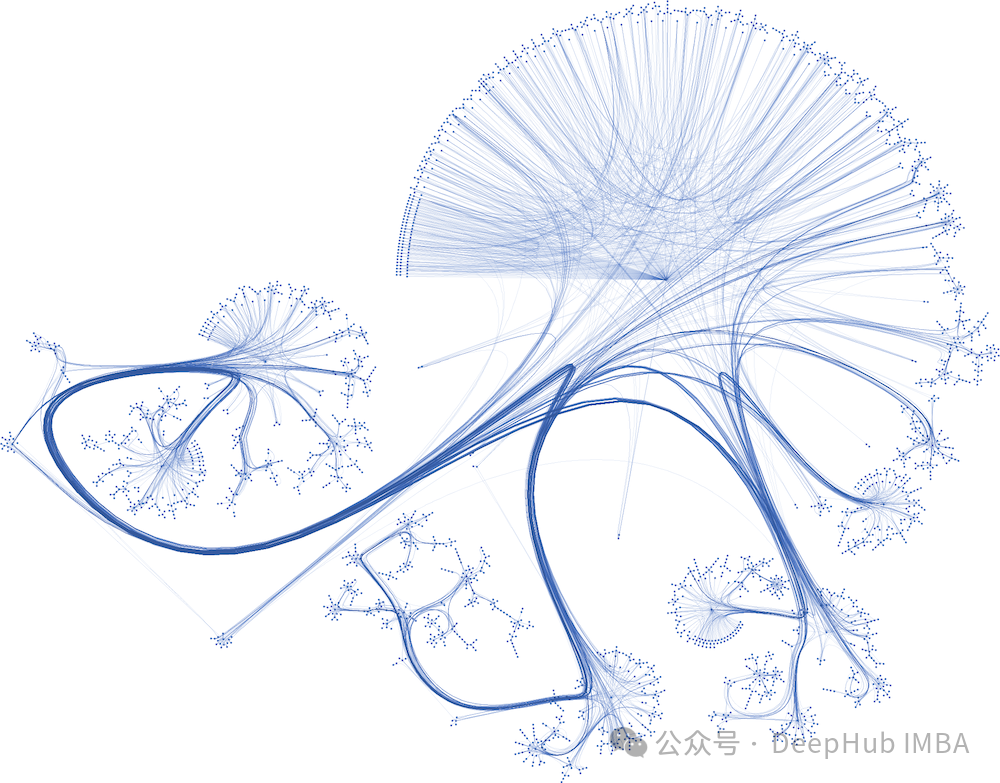

图神经网络实战(13)——经典链接预测算法

链接预测 (Link prediction) 可以帮助我们理解和挖掘图中的关系,并在社交网络、推荐系统等领域提供更准确的预测和决策支持。为了解决链接预测问题,研究者们提出了多种方法。本节将介绍基于局部和全局邻域的启发式方法。

【深度学习】AI换脸,EasyPhoto: Your Personal AI Photo Generator【一】

稳定扩散Web UI(Stable Diffusion Web UI,简称SD-WebUI)是一个综合项目,它基于Gradio库为稳定扩散模型提供了一个浏览器界面。本文提出了一款新颖的WebUI插件——EasyPhoto,旨在实现AI人像生成。通过使用5到20张相关图片对特定用户ID的数字替身进行训

PrestoonSpark:利用Spark加速Hive查询

PrestoonSpark:利用Spark加速Hive查询1. 背景介绍在大数据时代,数据量的爆炸式增长给传统的数据处理系统带来了巨大的挑战。Apache Hive作为建立在Hadoop之上的数据仓库工具,支持使用类SQL语言进行数据查询,为大数据分析提供了重

使用 PyTorch 创建的多步时间序列预测的 Encoder-Decoder 模型

本文提供了一个用于解决 Kaggle 时间序列预测任务的 encoder-decoder 模型,并介绍了获得前 10% 结果所涉及的步骤。

2024-04-10 问AI: 在深度学习中,Adam优化器是什么?

Adam优化器(Adaptive Moment Estimation)是一种在深度学习中广泛使用的优化算法,用于更新和计算模型中的参数,以便最小化或最大化损失函数。综上所述,Adam优化器以其自适应的特性、高效的内存使用和在多种问题上的优秀表现,成为了深度学习领域中最受欢迎的优化算法之一。在使用Ad

人工智能与网络安全:机器学习在安全领域的应用

1. 背景介绍1.1 问题的由来网络安全一直是计算机科学领域的一大挑战。随着技术的发展,网络攻击手段也日益多样化和复杂化,传统的安全防护手段已经难以应对。这其中,机器学习技术的应用提供了新的可能。1.2 研究现状目前,人工智能在网络安全领域

OpenVoiceV2本地部署教程,苹果MacOs部署流程,声音响度统一,文字转语音,TTS

OpenVoice的一个突破性功能是其能够进行zero-shot跨语言声音克隆。它可以将声音克隆到未包含在训练数据集中的语言中,而无需为这些语言提供大量说话者的训练数据。但事实上,与具有丰富标记数据的传统监督学习相比,Zero-shot learning在未知类别上通常面临较低的准确性,特别是在复杂

图神经网络版本的Kolmogorov Arnold(KAN)代码实现和效果对比

今天我们就来使用KAN创建一个图神经网络Graph Kolmogorov Arnold(GKAN),来测试下KAN是否可以在图神经网络方面有所作为。

Spark内存计算引擎原理与代码实例讲解

Spark内存计算引擎原理与代码实例讲解1.背景介绍在当今大数据时代,数据处理和分析成为了许多企业和组织的核心需求。Apache Spark作为一种快速、通用的大数据处理引擎,凭借其内存计算优势和高度容错性,在各行各业中得到了广泛应用。Spark内存计算引擎是其核心组件之一,它通

Hive UDF自定义函数原理与代码实例讲解

Hive UDF自定义函数原理与代码实例讲解作者:禅与计算机程序设计艺术1. 背景介绍1.1 Hive SQL的局限性Hive SQL 是一种强大的数据仓库查询语言,提供了丰富的内置函数来处理数据

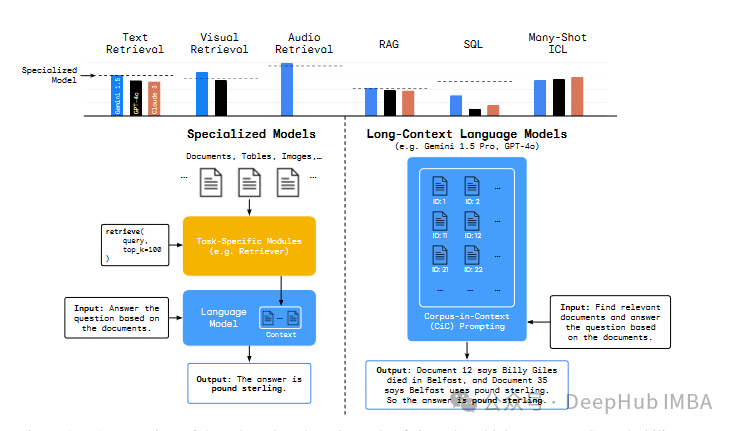

DeepMind的新论文,长上下文的大语言模型能否取代RAG或者SQL这样的传统技术呢?

关于长上下文大型语言模型是否真正利用其巨大的上下文窗口,以及它们是否真的更优越

AI大模型的训练与优化

高效的训练算法和自动化技术是提高大规模机器学习模型训练效率和性能的关键。通过不断引入新算法、优化现有算法,并利用自动化技术进行超参数优化、模型选择和调试排错,可以进一步提升AI模型训练的效率和质量,推动人工智能技术的发展和应用。

【AI大数据计算原理与代码实例讲解】Kafka

【AI大数据计算原理与代码实例讲解】Kafka1. 背景介绍1.1 大数据时代的到来随着互联网、物联网和云计算的快速发展,海量的数据正以前所未有的规模和速度被生成。这些数据来自于各种来源,如社交媒体、移动设备、传感器等

Hadoop 原理与代码实例讲解

Hadoop 原理与代码实例讲解1. 背景介绍1.1 大数据时代的到来随着互联网、移动设备和物联网的快速发展,数据的产生量呈现出爆炸式增长。根据国际数据公司(IDC)的预测,到2025年,全球数据量将达到175ZB(1ZB=1万亿G

Anaconda的环境快速迁移(目前windows,未来更新linux)

日常办公经常需要在新机器上部署运行环境并进行代码调试,尤其是在AI迅速发展的今天,python已经成为了强有力的AI领域编程语言之一。为了方便对不同windows下python代码工程进行快速部署。本文主要从工具环境的安装、原环境的快速打包、新环境的安装三个方面进行讲解。

毕业设计:基于python的农产品价格预测系统 大数据 深度学习

毕业设计:基于python的农产品价格预测系统用深度学习技术和大数据分析方法,实现了对农产品价格的准确预测。通过深入研究农产品价格波动规律、特征提取、预测模型构建等关键技术,我们的系统能够在复杂的市场环境中快速准确地预测农产品价格。对于计算机专业、软件工程专业、人工智能专业、大数据专业的毕业生而言,