人工智能系统的安全持续集成与交付

人工智能系统的安全持续集成与交付作者:禅与计算机程序设计艺术1. 背景介绍随着人工智能技术的快速发展,人工智能系统在各个领域得到了广泛应用,从智能助理、自动驾驶、医疗诊断到金融投资等,人工智能系统正在深入人类生活的方方面面。然而,人工智能系统作为一种复杂的软件系统,在开

基于LIDC-IDRI肺结节肺癌数据集的人工智能深度学习分类良性和恶性肺癌(Python 全代码)全流程解析(二)

通过切片和提取,我们获取了肺癌的恶性程度评级,这些评级在1到5之间。我们将大于3的评级归类为恶性,小于3的评级归类为良性。为了让模型更好地理解这些标签,我们用1表示良性,0表示恶性,最后将标签数据转换为one-hot编码格式。这个模型的输入是来自三个不同角度的图像和对应的标签。这些矩阵随后被堆叠,并

【AI大数据计算原理与代码实例讲解】Kafka

【AI大数据计算原理与代码实例讲解】Kafka1. 背景介绍1.1 大数据时代的挑战随着互联网、物联网、移动互联网等技术的快速发展,数据呈现出爆炸式增长的趋势。据统计,全球每天产生的数据量高达2.5EB(1EB=10^

OpenCV与AI深度学习 | 如何使用YOLOv9分割图像中的对象

在我们之前的文章中,我们使用 YOLOv8 探索了令人兴奋的对象分割世界。分割使计算机视觉比简单的对象检测更进一步。检测可以识别图像中对象的存在和位置,而分割则更进一步,仔细勾勒出每个对象的确切边界。这使得人们能够更细致地了解视觉场景,其应用范围从自动驾驶汽车到医学图像分析。今天,我们将在此基础上研

AI人工智能 Agent:基础理论解析

AI人工智能 Agent:基础理论解析1. 背景介绍在21世纪的今天,人工智能(Artificial Intelligence, AI)已经成为科技领域的热点。AI技术的迅猛发展正在深刻改变我们的生活方式、工作模式和社会结构。人工智能Agent,作为AI的基本构成元素,是我们理解

Spark GraphX图计算引擎原理与代码实例讲解

Spark GraphX图计算引擎原理与代码实例讲解1.背景介绍在当今大数据时代,图计算已成为一种非常重要的数据处理范式。图数据结构可以用来表示复杂的关系型数据,如社交网络、Web链接、交通网络等。传统的关系型数据库和NoSQL数据库在处理这类数据时往往效率低下。为了

2024年6月上半月30篇大语言模型的论文推荐

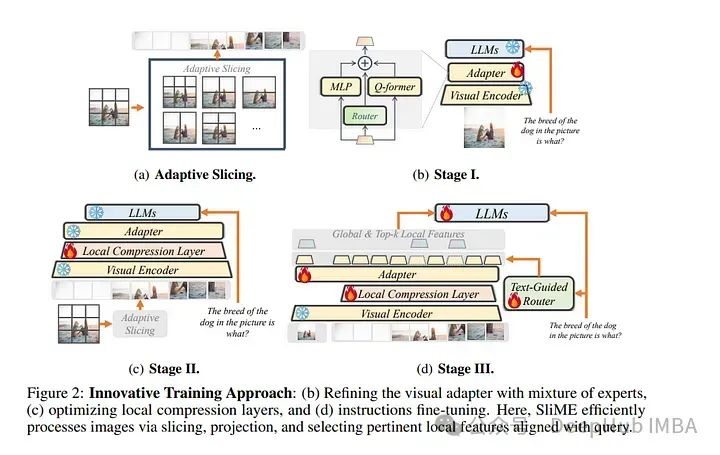

大语言模型(LLMs)在近年来取得了快速发展。本文总结了2024年6月上半月发布的一些最重要的LLM论文,可以让你及时了解最新进展。

FlinkTaskManager的性能指标与故障诊断

FlinkTaskManager的性能指标与故障诊断1.背景介绍1.1 Flink简介Apache Flink是一个开源的分布式流处理和批处理框架,由Apache软件基金会开发。Flink以数据并行和流水线方式执行任

SparkExactlyonce语义原理与实例

SparkExactly-once语义原理与实例1.背景介绍在现代分布式系统中,数据处理是一个关键的环节。由于数据量的不断增长和计算需求的复杂性,单机系统已经无法满足实时处理大数据的要求。因此,分布式计算框架应运而生,Apache Spark作为一种通用的分布式计算引擎,

字节发布文生图模型PuLID:高效身份ID特征定制,单张图像克隆AI虚拟分身

字节研究团队近日提出了一种新型的文生图身份ID定制方法PuLID(Pure and Lightning ID Customization)。相较于传统的微调方法,PuLID无需复杂的参数优化就可以实现高效的身份ID定制,且能最大程度减少对原始模型行为的干扰。PuLID是通过将轻量级的Lightnin

开源模型应用落地-qwen1.5-7b-chat-LoRA微调代码拆解

深入学习qwen1.5-7b-chat模型官方微调脚本

如何在Linux服务器上安装Stable Diffusion WebUI

如何在Linux服务器上安装Stable Diffusion WebUI

【AI大数据计算原理与代码实例讲解】Yarn

【AI大数据计算原理与代码实例讲解】Yarn1.背景介绍在大数据时代,数据的处理和分析变得至关重要。Yarn(Yet Another Resource Negotiator)作为Hadoop生态系统中的资源管理框架,极大地提升了大数据处理的效率和灵活性。Yarn的出现解决了传

Kafka Producer原理与代码实例讲解

Kafka Producer 原理与代码实例讲解1. 背景介绍Apache Kafka 是一个分布式流处理平台,它提供了一种统一、高吞吐、低延迟的方式来处理实时数据流。Kafka 被广泛应用于日志收集、消息系统、数据管道、流式处理等多种场景。其中,Kafka Produ

《AI学习笔记》大模型-微调/训练区别以及流程

之前一直对于大模型的微调和训练这两个名词不是很清晰,所有找了一个时间来弄明白到底有什么区别以及到底要怎么去使用去做。并且上手实践一下。

AIAgent安全与访问控制机制

AIAgent安全与访问控制机制1. 背景介绍人工智能技术正在以前所未有的速度发展,作为关键底层技术之一的AIAgent在各行各业中扮演着越来越重要的角色。AIAgent不仅能够自主进行信息搜索、数据处理、决策分析等复杂任务,还可以通过与人类用户的交互实现更加智能化的服务。然而,随着A

毕业设计-基于深度学习的钢材表面缺陷识别系统 YOLO python 卷积神经网络 人工智能

毕业设计选题-基于深度学习的遥感图像飞机目标检测系统的毕业设计。该系统通过结合深度学习和计算机视觉技术,实现了对遥感图像中飞机目标的准确检测和识别。设计采用创新的方法对数据集进行处理,并调整训练参数以提高训练效果。通过在不同网络模型上进行训练和分析,得到了令人满意的结果。这个毕业设计为计算机毕业生提

【AI大数据计算原理与代码实例讲解】Spark SQL

在当今大数据时代,海量数据的存储和处理给传统的数据处理方式带来了巨大挑战。企业需要从海量数据中快速获取有价值的信息,以支持业务决策和创新。然而,传统的数据处理技术如关系型数据库,在面对TB甚至PB级别的数据时,在性能和扩展性方面都显得力不从心。统一分析平台的崛起随着大数据技术的发展,越来越多的企业开

人工智能--搭建人工神经网络

本文详细讲解了人工神经网络的核心组成部分和关键技术。从神经元、感知器到多层感知器的演进,再到损失函数、梯度下降算法和反向传播算法的实际应用,读者可以全面理解神经网络的工作原理及其在实际问题中的应用。通过手工搭建神经网络的示例,读者不仅能够加深对神经网络内部运作的理解,还能够通过修改和扩展代码来探索更

Seq2Seq在安全领域的应用实践

非常感谢您委托我撰写这篇专业的技术博客文章。作为一位世界级人工智能专家、程序员、软件架构师,我会遵循您提供的目标和约束条件,以专业的技术语言,结合深入的研究和准确的信息,为您呈现一篇内容丰富、结构清晰、实用价值高的技术博客文章。下面我将开始正文的撰写:Seq2Seq在安全领域的应用实践