AI:129-基于深度学习的极端天气事件预警

本文探讨了在气象领域应用深度学习技术进行极端天气事件预警的重要性和方法。随着气候变化对全球气象系统的影响日益显著,提前预测和应对极端天气事件变得至关重要。深度学习作为人工智能的一支,通过对庞大的气象数据进行学习和分析,为天气预测提供了新的可能性。文章首先介绍了深度学习在极端天气事件预警中的应用。通过

AI:130-基于深度学习的室内导航与定位

在当今数字化时代,人工智能技术正以惊人的速度不断发展,为我们的生活带来了翻天覆地的变化。其中,基于深度学习的室内导航与定位技术无疑是引领这一浪潮的关键驱动力之一。这一领域的突破性进展不仅在商业和工业应用中具有重要价值,还为我们创造了更加智能、便捷的生活方式。

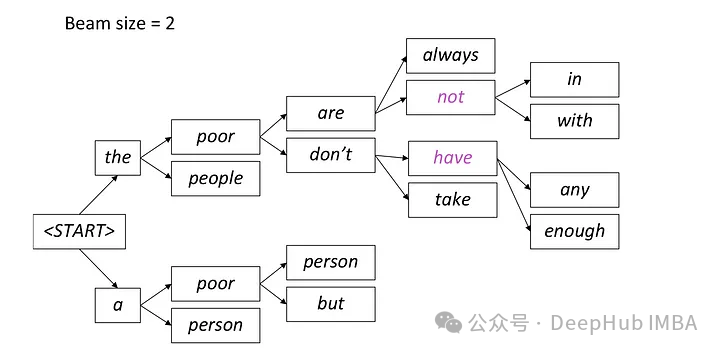

自然语言生成任务中的5种采样方法介绍和Pytorch代码实现

在自然语言生成任务(NLG)中,采样方法是指从生成模型中获取文本输出的一种技术。本文将介绍常用的5中方法并用Pytorch进行实现。

AI:128-基于机器学习的建筑物能源消耗预测

随着社会的不断发展和建筑业的快速增长,建筑物的能源消耗问题日益凸显。为了提高能源利用效率、降低能源成本,人工智能技术在建筑能源管理中发挥着越来越重要的作用。本文将探讨基于机器学习的建筑物能源消耗预测方法,并提供一个简单的代码实例。

人工智能应用的“繁花时代”,各大企业何以破局AI模型挑战

中电金信联合国电南自利用源启·行业AI平台的基础技术支撑,结合大数据、微服务等技术,基于国产软硬件系统,在统一标准规范体系、安全管理体系、运维保障体系下,构建了面向新能源“产营运维管”的全栈国产化数智平台,完成针对电力设备运行的智能预警算法在线建模、训练和优化,实现运行状态异常检测及预警,预测设备劣

[晓理紫]AI专属会议截稿时间订阅

如果你感觉对你有所帮助,请关注我,每日准时为你推送最新AI专属会议信息。

Transformer技术深度剖析:AI语言处理的新纪元

Transformer技术深度剖析:AI语言处理的新纪元

AI别墅设计

生成平面图的流程:第一步:根据对大量训练样本的学习首先对整体布局操作东西南北的房间和中间客厅的进深及分布进行确定,包括确定楼梯的型号和方位朝向,确定厨房餐厅的方位位置关系和尺寸。虽然房屋平面图属于图像但是普通的图像处理处理算法,如:图像识别技术只是识别图像中有什么位置距离大小等无法用于图像生成,GA

深度学习的新进展:探索人工智能的未来

深度学习技术起源于神经网络的研究,它通过构建深度神经网络模型来模拟人类大脑的学习过程。深度神经网络由多个隐藏层组成,每一层都包含大量的神经元,这些神经元通过权重和偏置进行连接,形成一个复杂的网络结构。通过大量的数据训练,深度神经网络可以自动提取数据的特征,并学习到数据之间的复杂关系,从而实现分类、回

毕业设计:基于深度学习的多语言文本相似度检测系统 人工智能 python

毕业设计:基于深度学习的多语言文本相似度检测系统 通过利用深度学习技术和自然语言处理方法,该系统能够自动计算和评估不同语言之间的文本相似度。系统通过学习语义表示和语义匹配模型,实现了对多语言文本的有效表示和语义匹配。该系统在多语言文本相似度检测任务上取得了显著的性能提升,为用户提供了更准确、可靠的多

AI引爆算力需求,思腾推出支持大规模深度学习训练的高性能AI服务器

近日人工智能研究公司OpenAI公布了其大型语言模型的最新版本——GPT-4,可10秒钟做出一个网站,60秒做出一个游戏,参加了多种基准考试测试,它的得分高于88%的应试者;随后百度CEO李彦宏宣布正式推出大语言模型“文心一言”,作为百度全新一代知识增强大语言模型,其能够与人对话互动、回答问题、协助

【人工智能AI】是什么?

人工智能(Artificial Intelligence),英文缩写为AI。它是研究、开发用于模拟延伸和扩展人的智能的理论方法技术及应用系统的一门新的技术科学。(百度百科)人工智能的基本原理:机器从「特定的」大量数据中总结规律,形成某些「特定的知识」,然后将这种「知识」应用到现实场景中去解决实际问题

AI数字人:sadtalker让照片开口说话

西安交通大学也开源了人工智能SadTalker模型,通过从音频中学习生成3D运动系数,使用全新的3D面部渲染器来生成头部运动,可以实现图片+音频就能生成高质量的视频。通过人脸图像和一段语音音频生成说话的头部视频仍然包含许多挑战。即不自然的头部运动、扭曲的表情和身份修改。研究团队认为这些问题主要是因为

Lag-Llama:第一个时间序列预测的开源基础模型介绍和性能测试

在本文中,我们将探讨Lag-Llama的架构、功能以及训练方式。还会将lagllama应用于一个预测项目中,并将其与其他深度学习方法Temporal Fusion Transformer (TFT) 和DeepAR进行性能比较。

神经网络与人类智能的融合:实现人工智能的高峰

1.背景介绍人工智能(Artificial Intelligence, AI)是一门研究如何让计算机模拟人类智能行为的科学。人类智能包括学习、理解语言、认知、决策等多种能力。在过去几十年中,人工智能研究取得了显著的进展,尤其是在图像识别、语音识别、自然语言处理等领域。然而,人工智能仍然远远不及人类在

数据预处理和特征工程在AI大模型中的重要性

1.背景介绍在AI领域,数据预处理和特征工程是构建高性能模型的关键环节。在本文中,我们将深入探讨数据预处理和特征工程在AI大模型中的重要性,并揭示一些最佳实践、技巧和技术洞察。1. 背景介绍AI大模型通常需要处理大量、复杂的数据,以实现高性能和准确度。数据预处理和特征工程是将原始数据转换为模型可以理

引用率高怎么降重 神码ai

引用前人的研究,可以帮助我们更好地支持自己的观点,但过高的引用率可能会让我们的论文显得冗余。如何有效降低引用率呢?通过合理使用脚注和参考文献,我们可以向读者展示我们引用的内容的来源和依据,同时避免过度引用他人的研究成果。通过理解引用的目的、使用伪原创功能、修改句子结构、用自己的语言表述、删除不必要的

人工智能之配置环境教程二:在Anaconda中创建虚拟环境并在VsCode中使用

孟莉苹,女,西安工程大学电子信息学院,2021级硕士研究生,张宏伟人工智能课题组。研究方向:机器视觉与人工智能。电子邮件:[email protected]安装前先下载安装包,建议在博主已准备好的百度网盘链接中下载:百度网盘链接:https://pan.baidu.com/s/1FgjTixyrP0

毕业设计选题-基于深度学习的车道线检测算法识别系统 人工智能 机器学习 卷积神经网络

毕业设计选题:基于深度学习的车道线识别系统的毕业设计。该系统利用先进的计算机视觉技术,通过深度学习算法,准确识别道路上的车道线,为自动驾驶和驾驶辅助系统提供重要的信息。为计算机专业、软件工程专业、人工智能专业和大数据专业的毕业生提供了一个令人兴奋和有意义的研究课题。不论您是对深度学习技术着迷的同学,