Pytorch安装

Pytorch的详细安装过程

pytorch-scheduler(调度器)

scheduler(调度器)是一种用于调整优化算法中学习率的机制。学习率是控制模型参数更新幅度的关键超参数,而调度器根据预定的策略在训练过程中动态地调整学习率。优化器负责根据损失函数的梯度更新模型的参数,而调度器则负责调整优化过程中使用的特定参数,通常是学习率。调度器通过调整学习率帮助优化器更有效地

【扩散模型思考记录(二)】什么是隐空间?为什么要引入隐空间?

引入隐变量空间(latent space)是生成模型中常用的技术,如变分自编码器(VAE)和生成对抗网络(GAN)。通过这种方法,可以将复杂的高维数据分布映射到一个相对简单的低维隐变量空间,从而简化采样过程。引入隐变量空间的核心思想是通过一个相对简单的低维表示来捕捉数据的复杂分布。这使得我们可以从标

如何从PyTorch迁移到MindSpore

相信做AI开发的小伙伴,有一大半用的都是PyTorch.我之前也是一直用PyTorch做开发。上个月参加了华为昇思25天打卡营,官方提供了充足的算力支持,几乎是不限时间不限量的那种,也让我体验了一把算力自由,好好感受了一番昇思框架。昇思真的是很好用的国产AI框架,但是因为之前的开发都是基于PyTor

python入门——OSError: [WinError 127] 找不到指定的程序。 Error loading

最近在使用torch的时候突然出现错误,显示OSError: [WinError 127] 找不到指定的程序。我看了一些解决方法,说要重装torch,但我这前几天还没问题,好在我还记得最近下载的包有哪些,最后删除了seaborn包得以解决,在此分享。用anaconda进入环境,然后删除包。

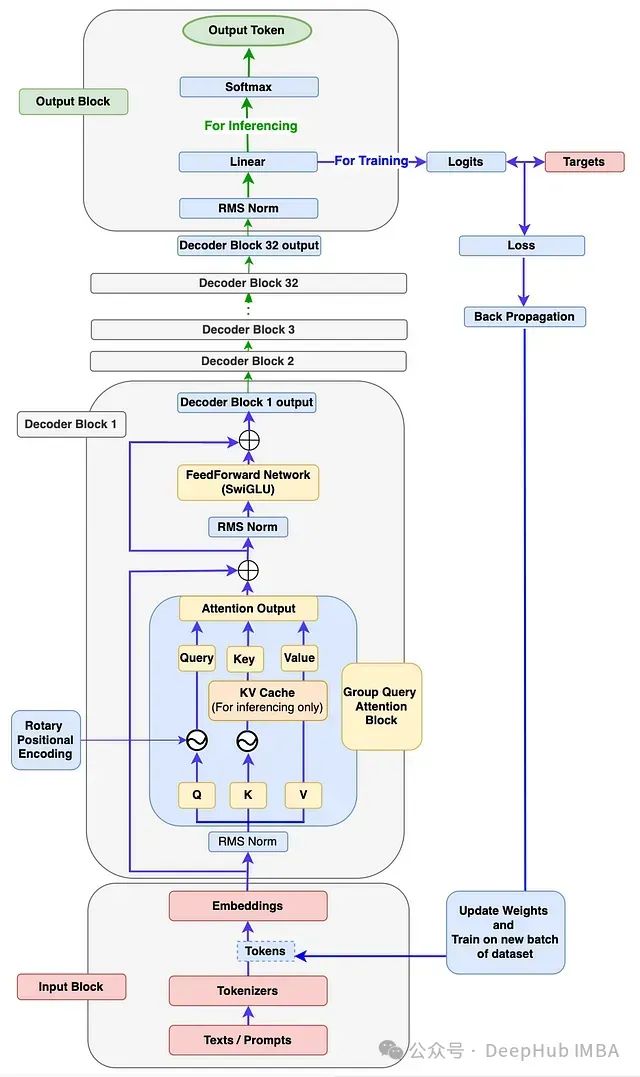

使用PyTorch从零构建Llama 3

本文将详细指导如何从零开始构建完整的Llama 3模型架构,并在自定义数据集上执行训练和推理。

最新大模型架构TTT模型代码解析(一)

这项来自斯坦福大学、加州大学伯克利分校、加州大学圣迭戈分校和 Meta 的研究提出了一个新颖的序列建模方法,称为测试时训练(Test-Time Training, TTT)层。TTT 层通过用机器学习模型取代 RNN 的隐藏状态,并使用输入 token 的实际梯度下降来压缩上下文。研究表明,这种方法

【无线感知】【P7】WIFI 感知实战2- 数据集处理

slide_size = 200 (滑动窗口,帧与帧之间存在overlap,less than window_size!1: 先通过 csv_import 提取训练input,label 到txt(只运行一次,大概18分钟)运行 cross_vali_data_convert_merg

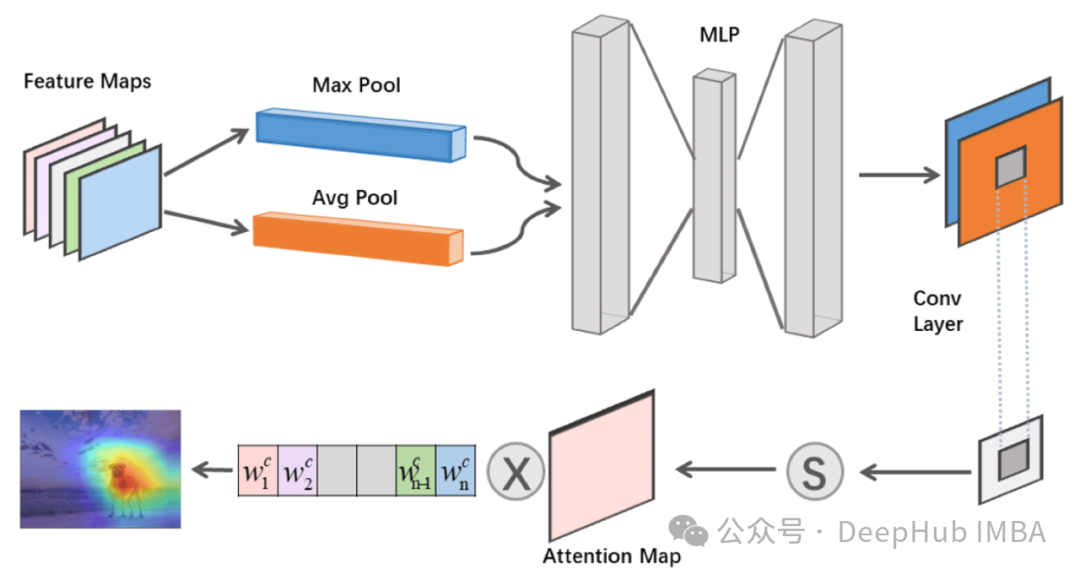

CNN中的注意力机制综合指南:从理论到Pytorch代码实现

本文将全面介绍CNN中的注意力机制,从基本概念到实际实现,为读者提供深入的理解和实践指导。

查看、指定使用的 GPU 数量和编号

在使用 PyTorch 框架时,可以通过以下步骤查看可用的 GPU 数量,指定使用的 GPU 编号,并在代码中体现这一点。

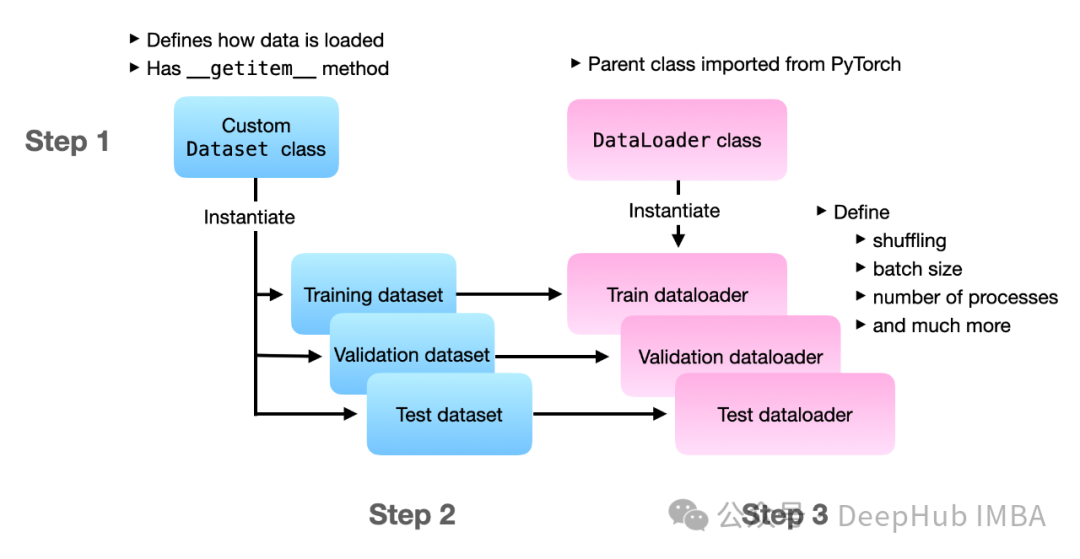

PyTorch数据处理:torch.utils.data模块的7个核心函数详解

本文将深入介绍PyTorch中 torch.utils.data 模块的7个核心函数,这些工具可以帮助你更好地管理和操作数据。

一文彻底搞懂大模型参数高效微调(PEFT)

最近这一两周看到不少互联网公司都已经开始秋招提前批了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。。更多实战和面试交流,加入我们。

使用 Python TorchRL 进行多代理强化学习

本文将深入探讨如何使用 TorchRL 解决 MARL 问题,重点关注多代理环境中的近端策略优化(PPO)。

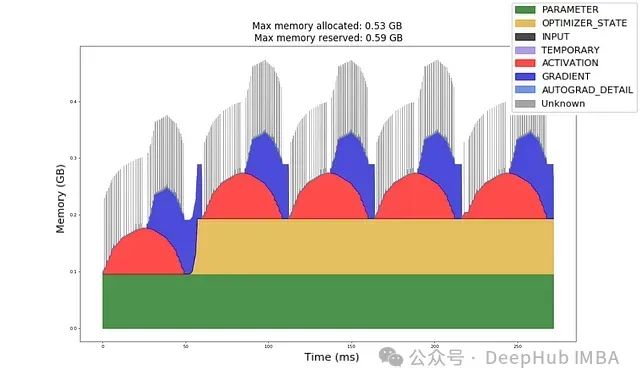

深入理解GPU内存分配:机器学习工程师的实用指南与实验

给定一个模型架构、数据类型、输入形状和优化器,你能否计算出前向传播和反向传播所需的GPU内存量?

手把手教你快速安装gpu版本的pytorch

比如pytorch版本是1.10.1(需要对应),环境创建时python版本是3.8 (需要对应),cuda 12.3(比它小的都可以),那么下面几个可以下载,选一个下载,最好装到一个英文路径下。第五步:验证torch安装是否成功,import torch成功说明安装成功,如果torch.cuda.

小白学大模型:LLaMA-Factory 介绍与使用

最近这一两周看到不少互联网公司都已经开始秋招提前批了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。Efficient fine-tuning对于将大型语

图解Pytorch学习率衰减策略(一)

在深度学习中,学习率是一个非常重要的超参数,它控制了模型在每次权重更新时的步长。学习率衰减策略是指在训练过程中逐步减少学习率,从而使得模型更稳定地收敛到最优解。本文将介绍:LinearLR、StepLR、MultiStepLR、ExponentialLR、CosineAnnealingLR、Redu

anaconda修改安装的默认环境

📚✨🎃。

pytorch里tensor用法总结

通过这篇总结,希望可以帮助pytorch学习者更好掌握Tensor的基本用法。

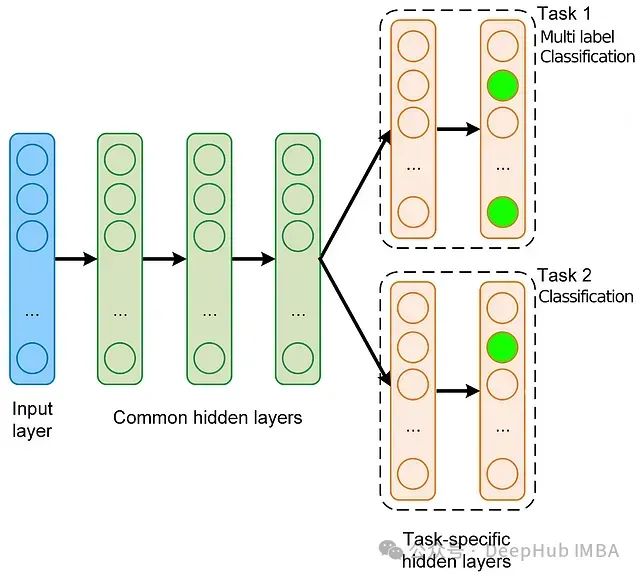

深度学习实战:手把手教你构建多任务、多标签模型

在本文中,我们将基于流行的 MovieLens 数据集,使用稀疏特征来创建一个多任务多标签模型,并逐步介绍整个过程。所以本文将涵盖数据准备、模型构建、训练循环、模型诊断,最后使用 Ray Serve 部署模型的全部流程。