手推机器学习 吴恩达 神经网络BP反向传播矩阵推导(上篇)

吴恩达机器学习 神经网络BP反向传播算法 基础篇

18张图,直观理解为什么神经网络这么有效?

迄今,人们对神经网络的一大疑虑是,它是难以解释的黑盒。本文则主要从理论上理解为什么神经网络对模式识别、分类效果这么好,其本质是通过一层层仿射变换和非线性变换把原始输入做扭曲和变形,直至可以非常容易被区分不同的类别。实际上,反向传播算法(BP) 其实就是根据训练数据不断地微调这个扭曲的效果。.....

【机器学习算法】神经网络与深度学习-9 递归神经网络

递归神经网络RNN,用来解决序列型,有滞后性问题的神经网络

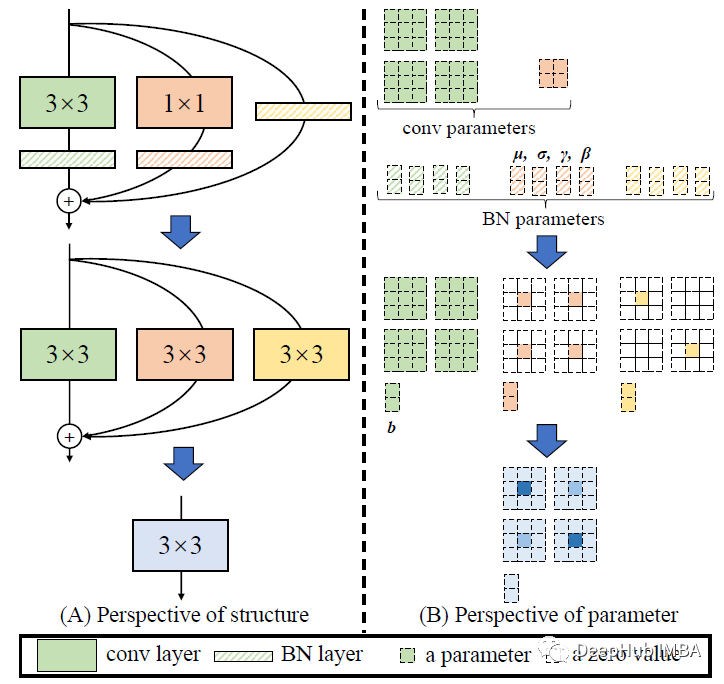

RepVGG论文详解以及使用Pytorch进行模型复现

RepVGG 是2021 CVPR的一篇论文,在本文中首先介绍了他如何过河拆桥,白嫖了多分枝架构的性能,然后再使用Pytorch复现RepVGG模型,告诉你如何进行白嫖的操作。

使用神经网络实现对天气的预测

使用神经网络实现对天气的预测

【机器学习算法】神经网络与深度学习-5 深度学习概述

深度学习概述,为之后普通深度网络DNN和深度信念网络DBN(会在自动特征学习中说其中的一种,它的变型太多了)和卷积神经网络CNN,打下框架

【机器学习网络】BP神经网络与深度学习-6 深度神经网络(deep neural Networks DNN)

深度神经网络(deep neural Networks DNN)

cpu和gpu已过时,npu和apu的时代开始

🌎CPU是中央处理器。其实就是机器的“大脑”,也是布局谋略、发号施令、控制行动的“总司令官”。CPU的结构主要包括运算器(ALU,ArithmeticandLogicUnit)、控制单元(CU,ControlUnit)、寄存器(Register)、高速缓存器(Cache)和它们之间通讯的数据、控制

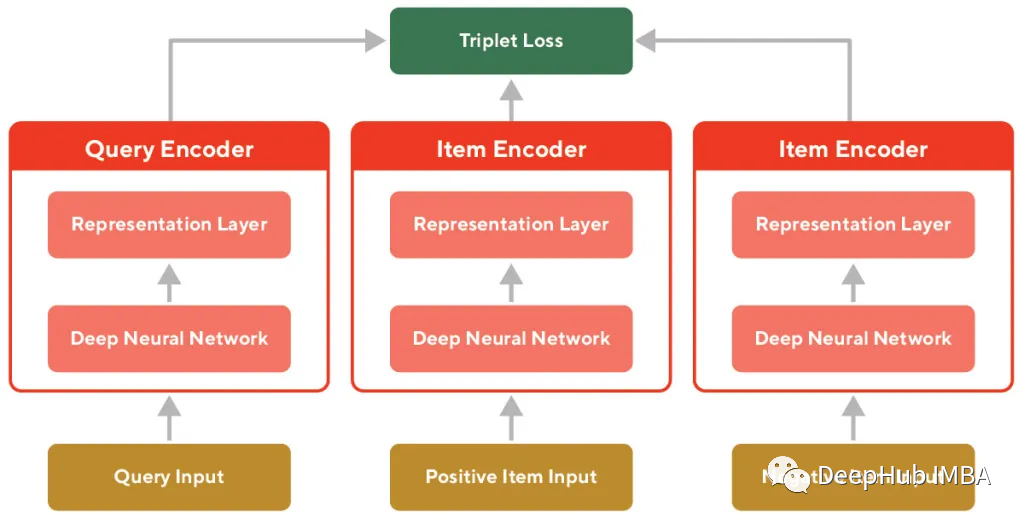

使用三重损失和孪生神经网络训练大型类目的嵌入表示

在这篇文章中,描述了一种通过在网站内部的用户搜索数据上使用自监督学习技术来训练高质量的可推广嵌入的方法。

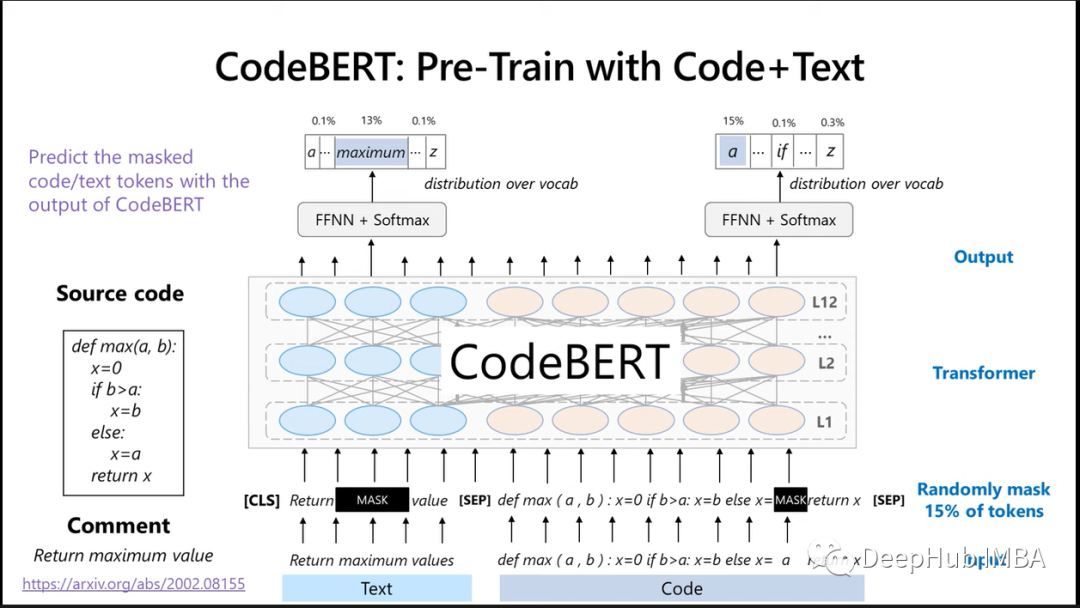

代码的表示学习:CodeBERT及其他相关模型介绍

本文将对论文进行简要概述,并使用一个例子展示如何使用。在最后除了CodeBert以外,还整理了最近一些关于他的研究之上的衍生模型。

【机器学习算法】神经网络和深度学习-1 神经网络概述和感知机介绍

神经网络与深度学习是最近的热门话题,产生了很多人工智能上的应用。神经网络概述和感知机介绍

CPU、GPU、NPU的区别

CPU、GPU、NPU的区别

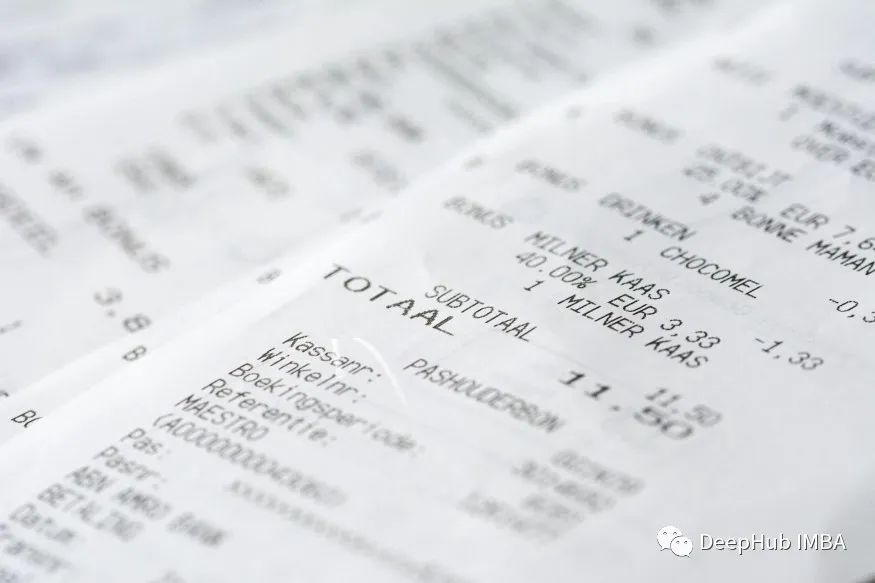

微调LayoutLM v3进行票据数据的处理和内容识别

在本文中,我们将在微软的最新Layoutlm V3上进行微调,并将其性能与Layoutlm V2模型进行比较。

【深度学习】(三)图像分类

上一章介绍了深度学习的基础内容,这一章来学习一下图像分类的内容。图像分类是计算机视觉中最基础的一个任务,也是几乎所有的基准模型进行比较的任务。从最开始比较简单的10分类的灰度图像手写数字识别任务mnist,到后来更大一点的10分类的cifar10和100分类的cifar100任务,到后来的image

神经网络加上注意力机制,精度不升反降?

明明人家论文里都证实了显著涨点的,到我这咋就不行了呢?

备赛笔记:神经网络

信息熵为信息量的量度,对于事件x的信息熵为-log(p(x)),x发生概率越小,信息熵越大,信息量越大。1独热矢量(one-hotvector)样本本身人为打的标签,这里相当于对样本分类,某一样本在这一类概率为1,其他概率为0,标签矩阵维数代表分类数量。监督学习(supervisedlearning

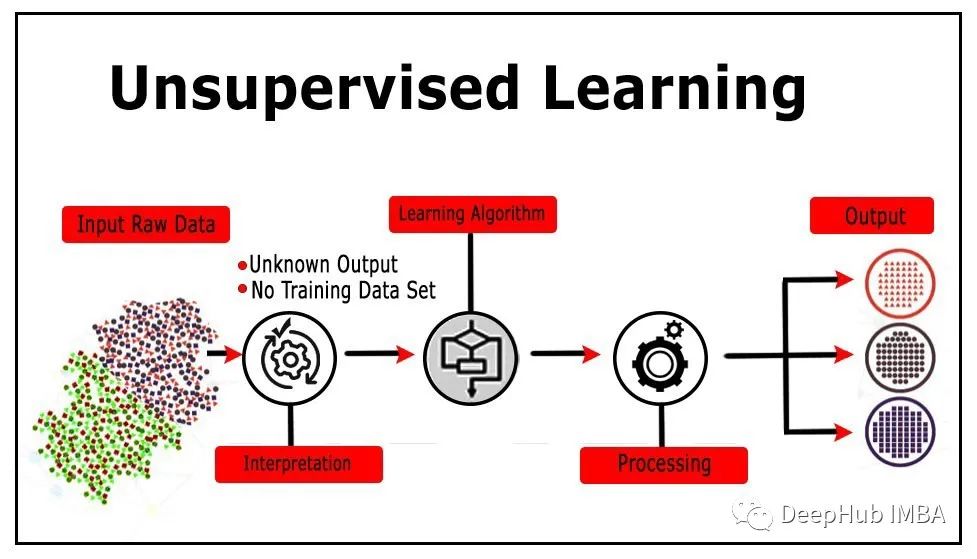

无监督学习的12个最重要的算法介绍及其用例总结

无监督学习(Unsupervised Learning)是和监督学习相对的另一种主流机器学习的方法,无监督学习是没有任何的数据标注只有数据本身。

用YOLOv5ds训练自己的数据集,注意点!

YOLOv5ds训练以及预测过程的问题解决。目前检测和分割都可以进行预测!

Python实现基于图神经网络的异构图表示学习和推荐算法研究

安装依赖Python 3.7CPU异构图表示学习(附录)基于对比学习的关系感知异构图神经网络(Relation-aware Heterogeneous Graph Neural Network with Contrastive Learning, RHCO)见 readme基于图神经网络的学术推荐算

基于GAN的时序缺失数据填补前言(1)——RNN介绍及pytorch代码实现

本专栏将主要介绍基于GAN的时序缺失数据填补。提起时序数据,就离不开一个神经网络——循环神经网络(Recurrent Neural Network, RNN)。RNN是一类用于处理序列数据的神经网络。RNN对具有序列特性的数据非常有效,它能挖掘数据中的时序信息。因为在介绍时序缺失数据填补,就离不开R