图像预训练模型的起源解说和使用示例

这篇文章简要介绍了图像预训练模型过去的演变,并总结了现在的一些热门话题。

Keras深度学习实战(2)——使用Keras构建神经网络

Keras 是用 Python 编写的高级神经网络 API,它的核心思想在于实现快速实验,该库提供了很多实用工具,可以简化构建复杂神经网络的过程。在本节中,我们将使用 Keras 库构建神经网络,感受 Keras 快速模型构建的特性。

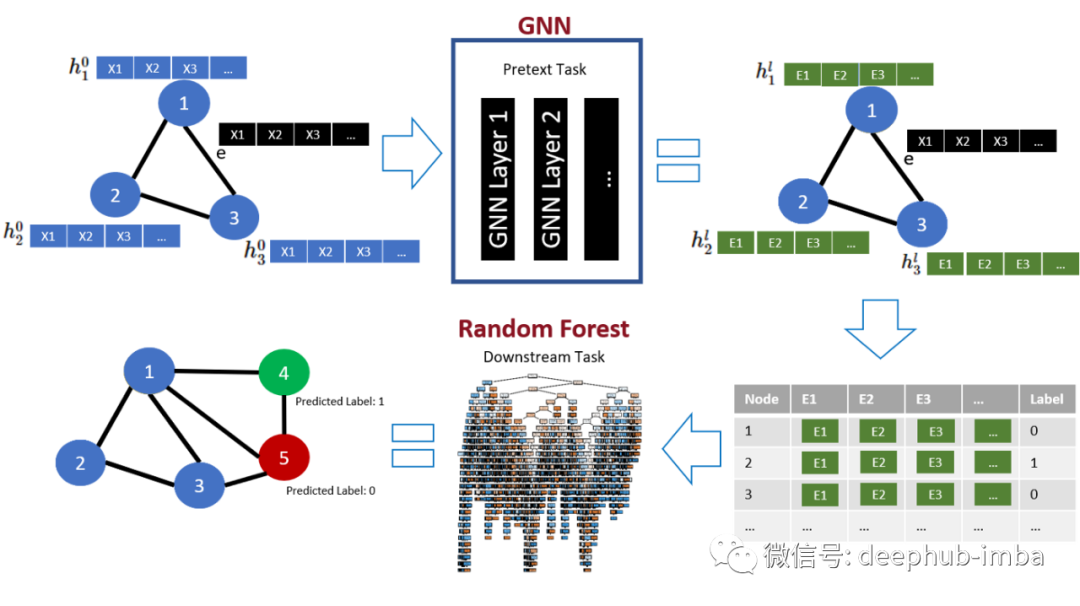

改善图形神经网络,提升GNN性能的三个技巧

本文总结了一些技巧来提高 GNN 模型的性能。

学习笔记:深度学习(4)——卷积神经网络(CNN)PyTorch实践篇

小白PyTorch超快上手,采用CNN做了一个手写数字识别,一个MINST手写数字预测,以及尝试了Kaggle的Spaceship Titanic案例。

从零到一实现神经网络(python):二

由单层感知机中的信号传递机制过渡到神经网络中的信号传递机制,通过一个包含2个隐藏层的4层神经网络实现了前向信号传播,介绍了sigmoid激活函数以及输出层经常用于误差计算的softmax函数

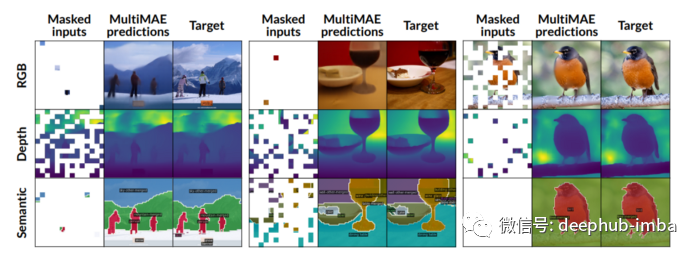

MultiMAE:一种简单、灵活且有效的 ViT 预训练策略

Multi-modal Multi-task Masked Autoencoders (MultiMAE),也是一种预训练策略,可以对掩码进行自动编码处理并执行多模态和多任务的训练。

【进阶篇】全流程学习《20天掌握Pytorch实战》纪实 | Day02 | 图片数据建模流程范例

不定期学习《20天掌握Pytorch实战》,有兴趣就跟着专栏一起吧~

神经网络学习小记录70——Pytorch 使用Google Colab进行深度学习

神经网络学习小记录70——Pytorch 使用Colab进行深度学习学习前言什么是Google ColabColab官网利用Colab进行训练一、数据集与预训练权重的上传1、数据集的上传2、预训练权重的上传二、打开Colab并配置环境1、笔记本的创建2、环境的简单配置3、深度学习库的下载4、数据集的

Keras深度学习实战(1)——神经网络基础与模型训练过程详解

神经网络是一种性能强大的学习算法,其灵感来自大脑的运作方式。类似于神经元在大脑中彼此连接的方式,神经网络获取输入后,通过某些函数在网络中进行传递输入信息,连接在其后的一些神经元会被激活,从而产生输出。本文主要介绍神经网络中重要的基础知识,然后使用 Python 从零开始构建神经网络的训练流程,包括前

掌握神经网络的法宝(二)

本文为大家展示了神经网络的最优化和误差反向传播法,希望能打大家有所帮助~~

墨奇科技博客|计算机视觉在前端应用中的实践 II

在上一篇博客中,我们简单介绍了如何基于 OpenCV.js 或 Rust/WebAssembly 设计并实现技术方案,在前端业务中实现计算机视觉类(下文简称 CV)的功能。感兴趣的同学可以点击下方链接回顾上一期博客:墨奇科技博客 | 计算机视觉在前端应用中的实践Ⅰhttps://blog.csdn.

掌握神经网络的法宝(一)

上一章的介绍,相信大家对于神经网络的框架模式有了一定的了解,而这一章我准备来给大家介绍一下掌握神经网络所需的数学基础。

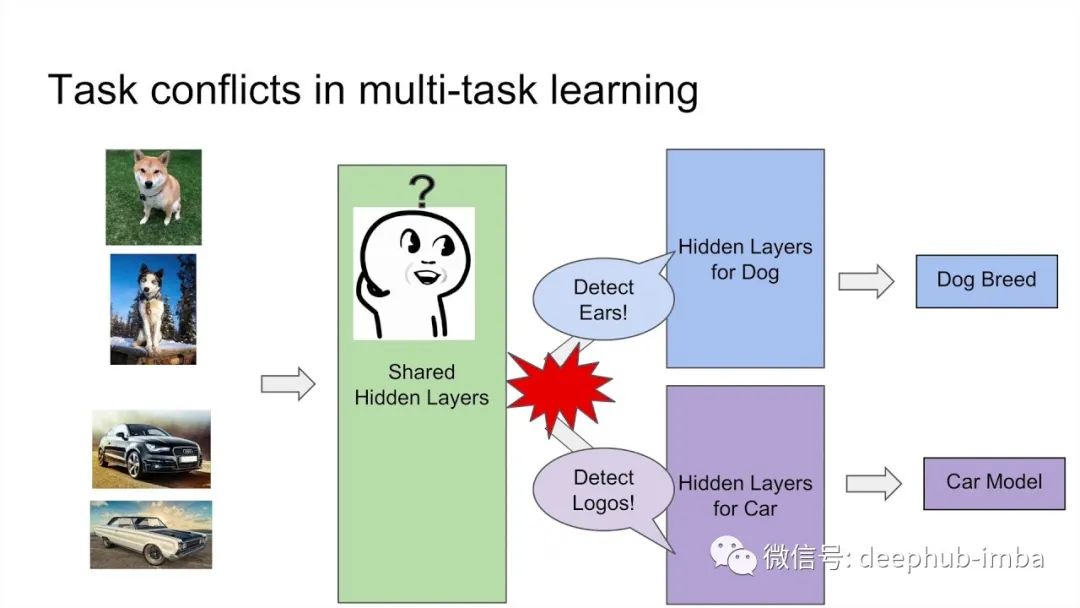

多任务学习中的网络架构和梯度归一化

多任务学习(Multi-task learning, MTL),旨在用其他相关任务来提升主要任务的泛化能力,多个任务共享一个结构并在一次正向传递中产生多个推理。

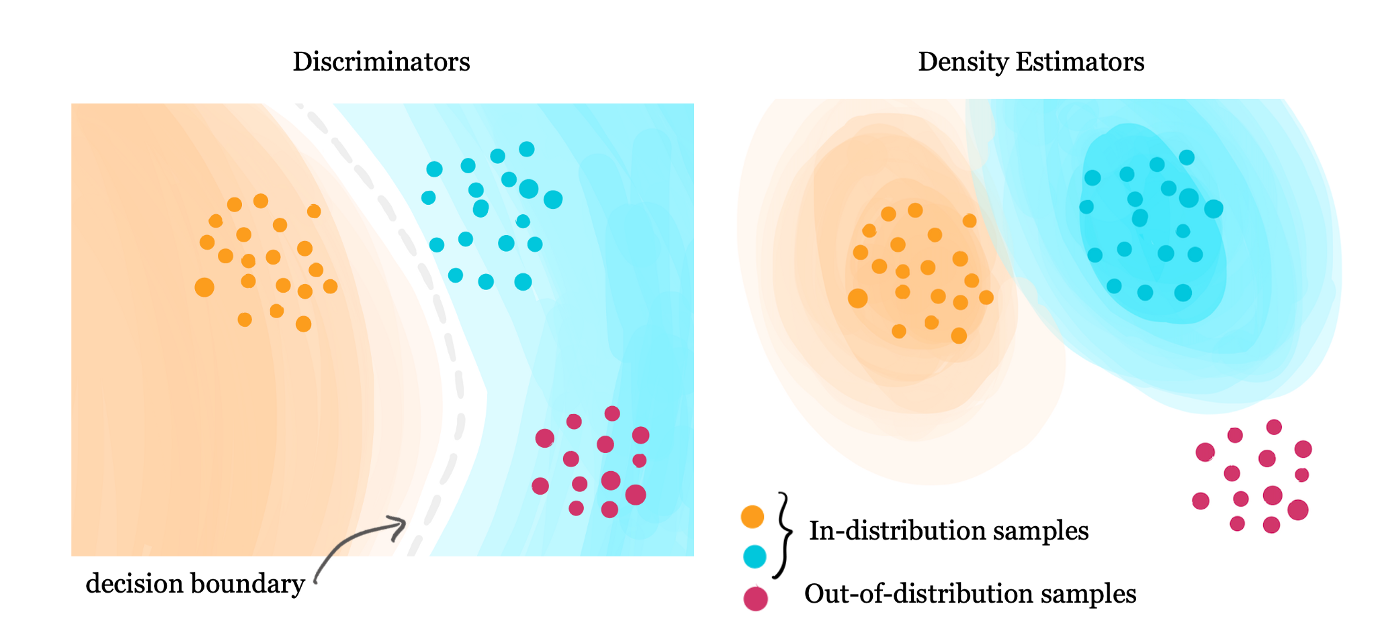

使用分布外数据去除不需要的特征贡献,提高模型的稳健性

分布外数据增强训练可以提高 DNN 的准确性和效率,通过抗性训练可以让 DNN 更加健壮,让模型更不容易受到扰动的影响。

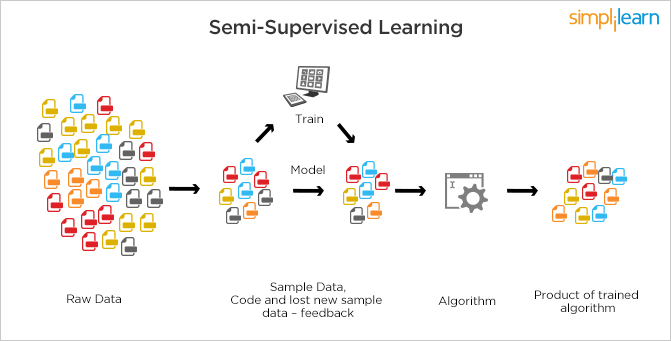

计算机视觉的半监督模型:Noisy student, π-Model和Temporal Ensembling

今天我将讨论一些在过去十年中出现的主要的半监督学习模型。

深度学习敲门砖——神经网络

深度学习以神经网络为出发点!可以说深度学习,就是叠加了很多层的神经网络!

【初始篇】实战必读中文免费文档书—《20天掌握Pytorch实战》

一起来学点新东西,充实自己!

JoJoGAN One-Shot Face Stylization:使用 StyleGAN 创建 JoJo风格人脸头像

JoJoGAN 是一种One-Shot风格迁移模型,可让将人脸图像的风格迁移为另一种风格。

深度学习项目示例 使用自编码器进行模糊图像修复

本文将介绍使用深度学习技术实现一个对图像进行去模糊处理的项目的完整流程,希望对你有所帮助

深度学习的显卡对比评测:2080ti vs 3090 vs A100

显卡大幅降价了但是还可以再等等,新的40系列显卡也要发售了,所以我们先看看目前上市的显卡的性能对比,这样也可以估算下40显卡的性能,在以后购买时作为参考。