持续学习常用6种方法总结:使ML模型适应新数据的同时保持旧数据的性能

持续学习是指在不忘记从前面的任务中获得的知识的情况下,按顺序学习大量任务的模型。

训练深度学习神经网络的常用5个损失函数

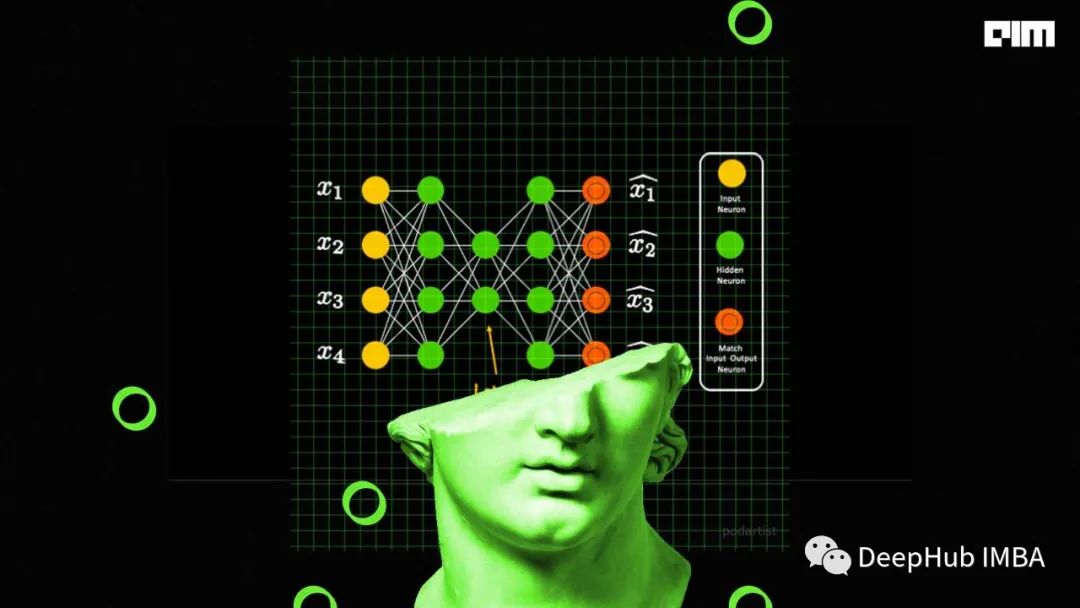

损失函数的选择与神经网络模型从示例中学习的特定预测建模问题(例如分类或回归)有关。在本文中我们将介绍常用的一些损失函数

BP反向传播网络

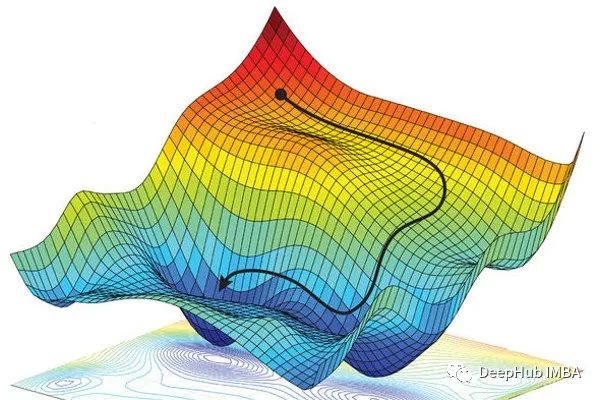

本文介绍了如何通过反向传播误差修正模型参数,从梯度下降法等原理处学习如何进行反向传播,进而了解为什么模型参数的修正和激活函数相关。

在线薅 达摩院-人工智能训练师(高级)证书

人工智能训练师(高级)

使用PyG进行图神经网络的节点分类、链路预测和异常检测

在这篇文章中,我们将回顾节点分类、链接预测和异常检测的相关知识和用Pytorch Geometric代码实现这三个算法。

带掩码的自编码器(MAE)最新的相关论文推荐

7-9月的MAE相关的9篇论文推荐

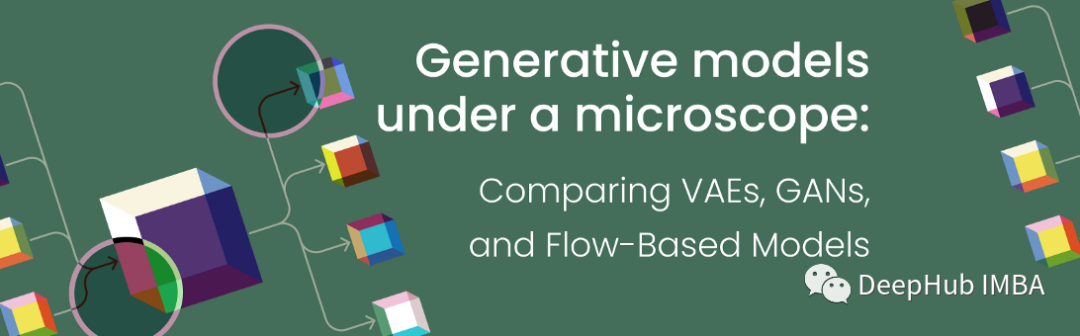

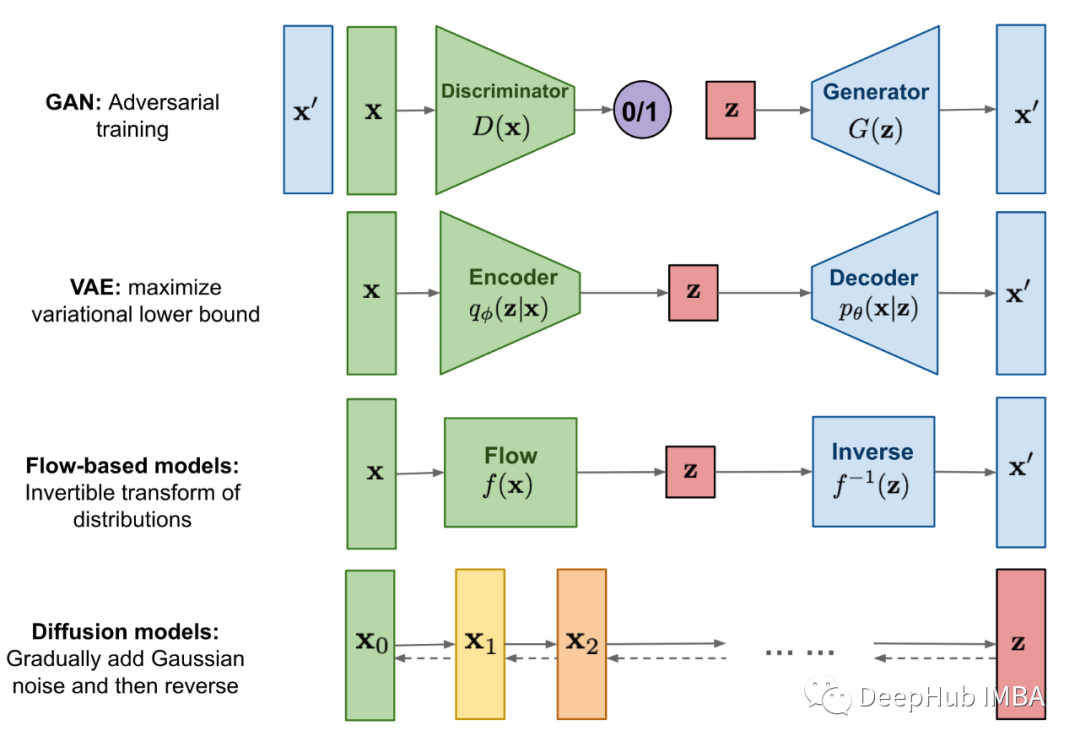

生成模型VAE、GAN和基于流的模型详细对比

生成算法有很多,但属于深度生成模型类别的最流行的模型是变分自动编码器(VAE)、gan和基于流的模型。

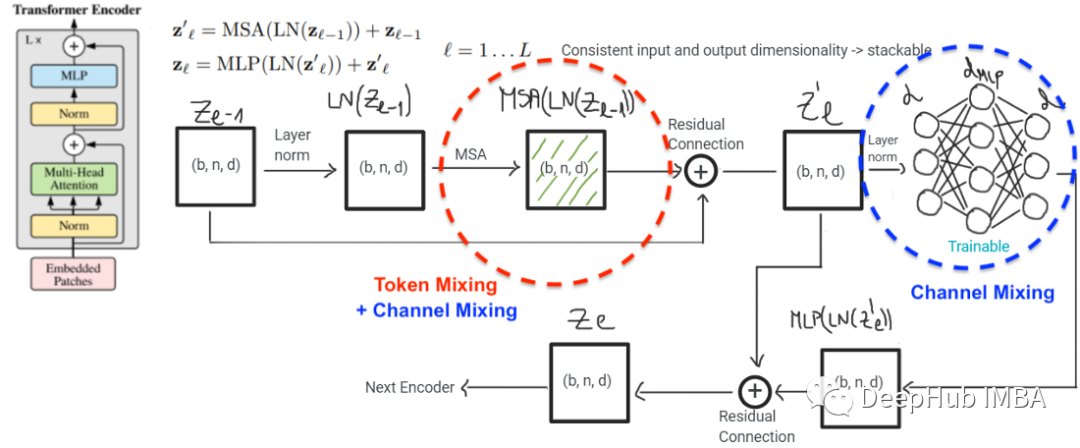

Vision Transformer和MLP-Mixer联系和对比

本文的主要目标是说明MLP-Mixer和ViT实际上是一个模型类,尽管它们在表面上看起来不同。

深度学习模型理解-CNN-手写数据字代码

图像(不同的数据窗口数据)和滤波矩阵(一组固定的权重:因为每个神经元的多个权重固定,所以又可以看做一个恒定的滤波器filter)做内积(逐个元素相乘再求和)的操作就是所谓的『卷积』操作,也是卷积神经网络的名字来源。非严格意义上来讲,下图中红框框起来的部分便可以理解为一个滤波器,即带着一组固定权重的神

GAM注意力机制

GAM解析,使用Pytorch实现GAM attention

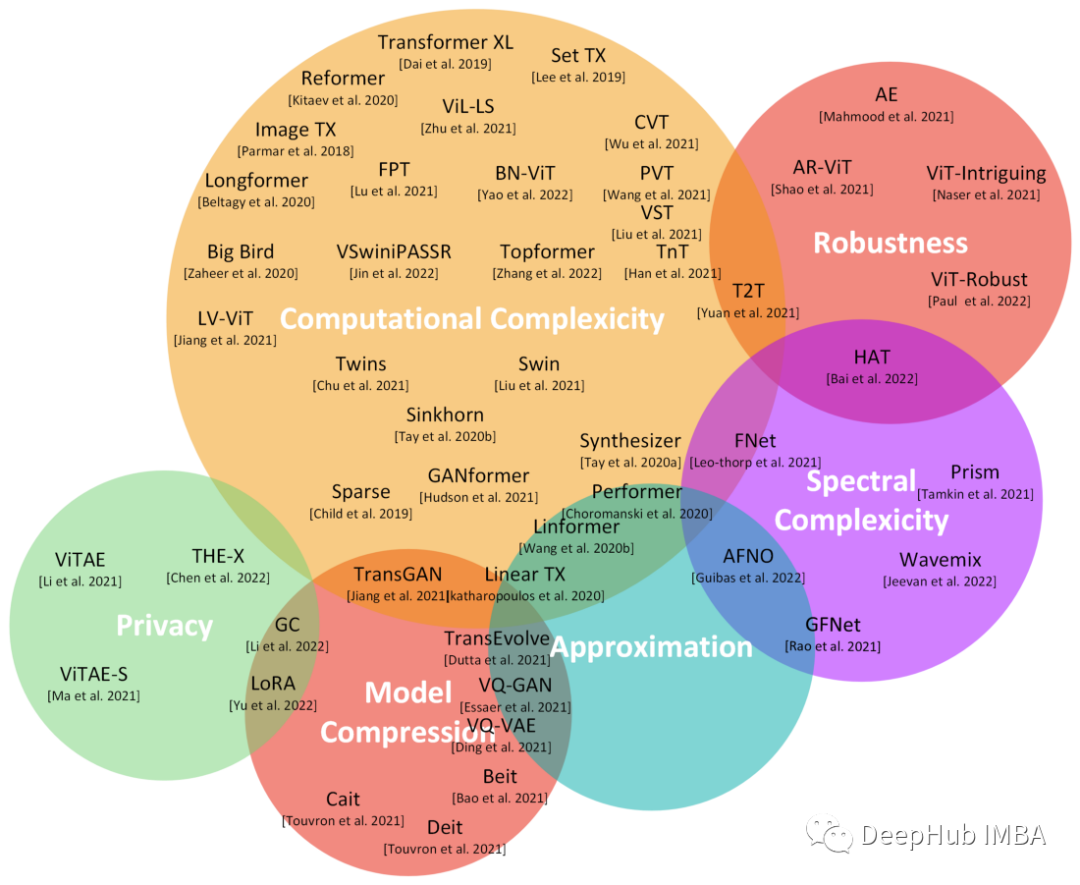

transformers的近期工作成果综述

在本文中,对基于transformer 的工作成果做了一个简单的总结,将最新的transformer 研究成果(特别是在2021年和2022年发表的研究成果)进行详细的调研。

NNDL 实验五 前馈神经网络(1)二分类任务

前馈神经网络基础

使用Keras Tuner进行自动超参数调优的实用教程

在本文中将介绍如何使用 KerasTuner,并且还会介绍其他教程中没有的一些技巧,例如单独调整每一层中的参数或与优化器一起调整学习率等。

【论文导读】 - 关于联邦图神经网络的3篇文章

图神经网络( GNNs )凭借其强大的处理实际应用中广泛存在的图数据的能力,受到了广泛的研究关注。然而,随着社会越来越关注数据隐私,GNNs面临着适应这种新常态的需要。这导致了近年来联邦图神经网络( FedGNNs )研究的快速发展。虽然前景广阔,但这一跨学科领域感兴趣的研究者来说是极具挑战性的。对

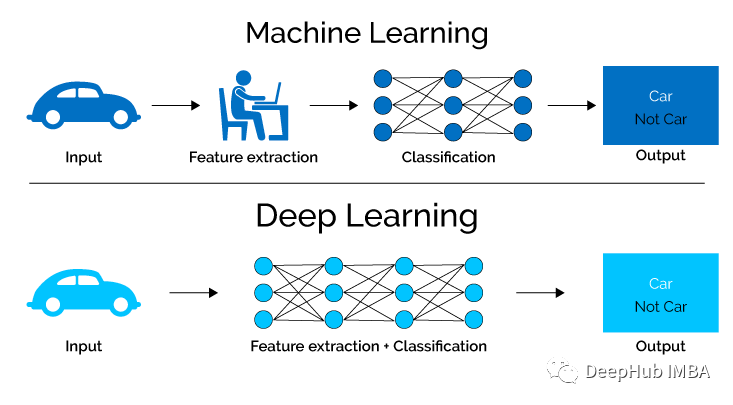

最基本的25道深度学习面试问题和答案

如果你最近正在参加深度学习相关的面试工作,那么这些问题会对你有所帮助。

扩散模型的极简介绍

扩散模型是什么,如何工作以及他如何解决实际的问题

基于文化算法优化的神经网络预测研究(Matlab代码实现)

从两个层面分别模拟生物的进化和文化的进化,两个过程既相互独立又相互影响,是一种基于知识的双层进化系统。该算法优点就在于,可以从每次的搜索中提取解决问题的有效信息,并反馈指导种群的搜索过程,在精度和效率上都使算法有效提升。

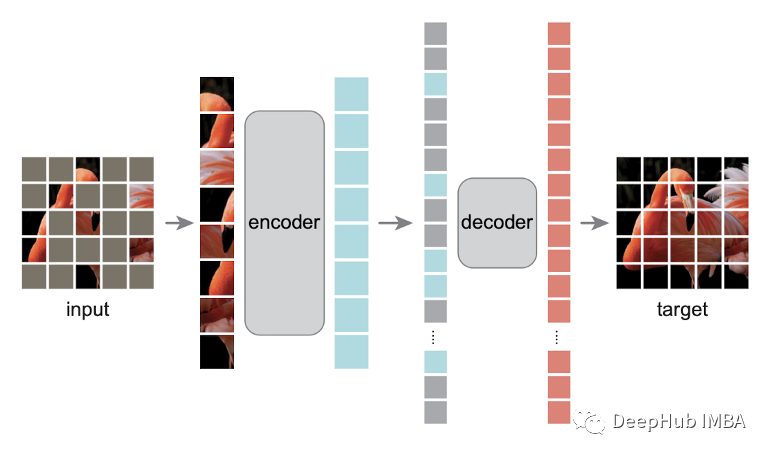

带掩码的自编码器MAE在各领域中的应用总结

NLP,图像,视频,多模态,设置时间序列和图机器学习中都出现了MAE的身影

猿创征文|深度学习基于前馈神经网络完成鸢尾花分类

在梯度下降法中,目标函数是整个训练集上的风险函数,这种方式称为批量梯度下降法(Batch Gradient Descent,BGD)。 批量梯度下降法在每次迭代时需要计算每个样本上损失函数的梯度并求和。当训练集中的样本数量NN很大时,空间复杂度比较高,每次迭代的计算开销也很大。为了减少每次迭代的计算