torch、torchvision、torchaudio安装对应cuda版本(cuda 12.1情况下)

如果安装cuda 11.8版本的,把最后的cu121改成cu118即可。目前支持最高cuda 12.2。因为网上 pip install torch 等全部默认安装cpu版本,推理速度慢。所有安装cuda版本的包会更快。

阿里开源语音理解和语音生成大模型FunAudioLLM

阿里开源大模型FunAudioLLM,一个创新的框架,旨在促进人类与大型语言模型(LLMs)之间的自然语音交互。FunAudioLLM的核心是两个开创性的模型:用于语音理解的SenseVoice和用于语音生成的CosyVoice。

【机器学习】Google开源大模型Gemma2:原理、微调训练及推理部署实战

Gemma 是 Google 推出的轻量级、先进的开放模型系列,采用与 Gemini 模型相同的研究成果和技术构建而成。它们是仅使用解码器的文本到文本大型语言模型(提供英语版本),为预训练变体和指令调整变体具有开放权重。Gemma 模型非常适合各种文本生成任务,包括问题解答、摘要和推理。由于它们相对

【大模型】大模型中的稀疏与稠密——一场效率与性能的较量

稀疏模型与稠密模型,作为深度学习领域的两股重要力量,各自承载着不同的使命与愿景。在探索未知的征途中,它们既是竞争对手,也是合作伙伴,共同推动着人工智能技术向前迈进。未来,随着算法创新和硬件技术的进步,我们有理由相信,稀疏与稠密的融合将开启深度学习的新篇章,引领我们进入一个更加智能、高效、可持续的AI

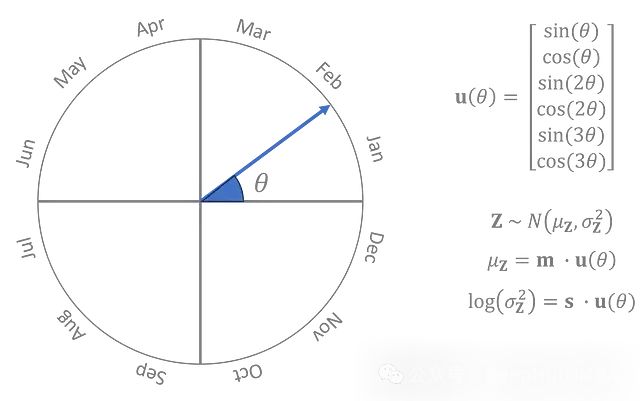

将VAE用于时间序列:生成时间序列的合成数据

本文将使用**一维卷积层**、**策略性的步幅选择**、**灵活的时间维度**和**季节性依赖的先验**来模拟温度数据。

人工智能算法能否预测奥运会足球?

如果您对人工智能算法预测奥运足球有疑问,不妨来与我详细探讨一下。人工智能算法,作为当代科技的前沿领域,其核心在于使计算机系统具备模拟人类智能行为的能力。这类算法通过对大量数据的处理和分析,实现对复杂问题的求解和决策。在体育预测领域,人工智能算法的应用尤为广泛,其中常用的算法主要包括机器学习、深度学习

使用BatchNorm替代LayerNorm可以减少Vision Transformer训练时间和推理时间

让我们简要回顾一下深度神经网络中BatchNorm的基本概念。这个想法最初是由Ioffe和Szegedy在一篇论文中引入的,作为加速卷积神经网络训练的一种方法。假设zᵃᵢ表示深度神经网络给定层的输入,其中a是从a=1,…,Nₛ运行的批次索引,i是从i=1,…,C运行的特征索引。这里Nₛ是一个批次中的

Llama3.1技术报告简要解读--附PDF

Llama3.1的简要解读。总结几点,大而好:405B参数直接对标GPT4 (Scaling law)中杯(8B)和大杯(70B)的上下文直接干到128K了,超过目前同类参数模型一个等级。15T的Token,强调数据的重要性!!!包括数据准备、数据处理、数据清洗、数据构造,数据配比等等,数据是基石,

IsaacLab 从入门到精通(一) 环境配置和依赖安装

本系列文章将针对机器人操作任务中的强化学习平台IsaacLab提供较为全面的教程

数据缺失补全方法综述

数据缺失是数据分析和机器学习中的一个普遍问题,可能由于多种原因(如传感器故障、数据录入错误、系统故障等)导致。缺失数据不仅会影响模型的性能,还可能导致错误的推断和决策。为了应对这一挑战,研究者们提出了多种数据缺失补全方法。本文综述了几种常见的缺失数据补全技术,包括简单插补、基于模型的插补、机器学习方

Skeleton Recall Loss 分割领域的新突破:极大的减少了资源消耗,还能提高性能

精确分割在当今众多领域都是一项关键需求比如说自动驾驶汽车的训练、医学图像识别系统,以及通过卫星图像进行监测。在许多其他领域,当感兴趣的对象微小但至关重要时,例如研究血管流动、手术规划、检测建筑结构中的裂缝或优化路线规划,需要更高的精度。此前已经做了大量工作来解决这种具有挑战性的分割问题。此前已经做了

什么是端到端(End-to-End)?

端到端方法在人工智能领域的应用前景广阔,其优势在于简化流程和全局优化。然而,在实际应用中,我们需要根据具体场景权衡其优劣势,选择合适的方法。在数据稀缺、高可解释性需求和多任务复杂系统中,传统方法可能仍然具有不可替代的价值。通过结合端到端方法与传统方法的优势,我们可以更好地应对现实中的各种挑战,推动人

Linux服务器Mamba2安装及example运行问题

Mamba 从发表到现在已经有段时间了,先前的Mamba代码有些地方不完善或者需要对源码做些修改后编译,最近可能需要用到Mamba,发现之前实现的Vision Mamba块,注释掉了一些源码可能会导致训练速度下降,然后官方实现了Mamba2,这里尝试安装,做一些记录,防止服务器重置🫤。

源大模型的快速部署与高效推理——GGUF格式模型介绍与使用教程

源2.0 是浪潮信息发布的新一代基础语言大模型。我们开源了全部的3个模型源2.0-102B,源2.0-51B和源2.0-2B。并且我们提供了预训练,微调,推理服务的相关脚本,以供研发人员做进一步的开发。源2.0是在源1.0的基础上,利用更多样的高质量预训练数据和指令微调数据集,令模型在语义、数学、推

大模型日报|11 篇必读的大模型论文

大模型日报|11 篇必读的大模型论文

CVPR 2024最佳论文分享:Mip-Splatting: 无混叠3D高斯溅射

本文介绍了一篇获得CVPR2024最佳论文提名的论文。该论文提出了一种名为Mip-Splatting的无混叠三维高斯溅射方法,结合多级混合技术和2D、3D Mip滤波器,显著减少了混叠伪影。该方法在多尺度数据训练和测试中表现优越,提升了渲染质量和计算效率。

深度学习的前沿主题:GANs、自监督学习和Transformer模型

深度学习的前沿技术包括生成对抗网络(GANs)、自监督学习和Transformer模型。GANs通过生成器和判别器的对抗训练生成高质量数据,自监督学习利用数据的内在结构在无标签数据上学习有效特征,Transformer模型则通过自注意力机制在自然语言处理和计算机视觉任务中表现出色。这些技术在图像生成

并行训练技术概述

首先想要说明的是,并行训练和分布式训练的概念其实都能讲,但前者可能更侧重于技术实施,而后者更倾向于设备,网络等资源层面的分布式,在本专栏,我们都一视同仁。从个人观点来说,如果偏软件点,说并行最好了。并行训练是指将机器学习或者深度学习模型的训练任务给分解成多个子任务,然后在多个计算设备上去并行地进行训

大模型日报|20 篇必读的大模型论文

大模型日报|20 篇必读的大模型论文

【人工智能】Transformers之Pipeline(十):视频分类(video-classification)

本文对transformers之pipeline的视频分类(video-classification)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline使用代码极简的代码部署计算机视觉中的视频分类(video-classificatio