MaxPool2d详解--在数组和图像中的应用

选择卷积核覆盖时的最大值,ceil_mode控制卷积核超出原始数据后是否进行保留函数:参数要求代码:结果:代码:结果:代码:结果:

语义分割系列7-Attention Unet(pytorch实现)

本文介绍了AttentionUnet模型和其主要中心思想,并在pytorch框架上构建了Attention Unet模型,构建了Attention gate模块,在数据集Camvid上进行复现。

ImageNet1K的下载与使用

ImageNet不用多说,它包含了非常多的图片,总共有2w多个分类,但是显然太多。所以一般更常用的是ImageNet1K数据集,该数据集包含1000个类别。

pytorch复现U-Net 及常见问题汇总(2021.11.14亲测可行)

目录2021.11.14复现过程:训练过程常见问题整理:之前简单地写了一个pytorch的U-net 复现过程,有很多小伙伴在评论里有很多疑问,抽空又复现了一遍,简单整理了常见的问题。之前写的教程:U-net复现pytorch版本 以及制作自己的数据集并训练_candice5566的博客-CSDN博

在运行yolo5的v5.0版本detect.py时遇到的一些错误

跟着小土堆的视频教学自己遇到的一些问题。

【pytorch】ResNet18、ResNet20、ResNet34、ResNet50网络结构与实现

ResNet18、ResNet20、ResNet34、ResNet50网络结构与实现

卷积神经网络学习—Resnet50(论文精读+pytorch代码复现)

卷积神经网络学习—Resnet50(论文精读+pytorch代码复现)

【Pytorch】torch.nn.LeakyReLU()

Hello!ଘ(੭ˊᵕˋ)੭昵称:海轰标签:程序猿|C++选手|学生简介:因C语言结识编程,随后转入计算机专业,获得过国家奖学金,有幸在竞赛中拿过一些国奖、省奖…已保研学习经验:扎实基础 + 多做笔记 + 多敲代码 + 多思考 + 学好英语!唯有努力💪本文仅记录自己感兴趣的内容文章仅作为个人学习笔

GPU版本PyTorch详细安装教程

注意:30系列的的显卡暂时不支持cuda11以下版本!!!一、安装显卡驱动第一步:右击右下角开始,在设备管理器中查看计算机显卡型号,例如我的显卡是GTX1050:第二步:进入英伟达官网,下载对应显卡驱动:官方驱动 | NVIDIAhttps://www.nvidia.cn/Download/inde

pytorch的下载解决方案(下载出错、下载过慢问题)

第一次下载pytorch往往会出现一些问题,比如不知道如何下载,或者下载过慢等问题,由此本文给出以下解决放方案,并给出图示解决。

Yolov5--从模块解析到网络结构修改(添加注意力机制)

文章目录1.模块解析(common.py)01. Focus模块02. CONV模块03.Bottleneck模块:04.C3模块05.SPP模块2.为yolov5添加CBAM注意力机制最近在进行yolov5的二次开发,软件开发完毕后才想着对框架进行一些整理和进一步学习,以下将记录一些我的学习记录。

Pytorch机器学习(八)—— YOLOV5中NMS非极大值抑制与DIOU-NMS等改进

Pytorch机器学习(八)—— YOLOV5中NMS非极大值抑制与DIOU-NMS等改进文章目录系列文章目录 前言 一、pandas是什么? 二、使用步骤 1.引入库 2.读入数据 总结前言在目标检测的预测阶段时,会输出许多候选的anchor box,其中有很多是明显重叠的预测边界框都围绕着同

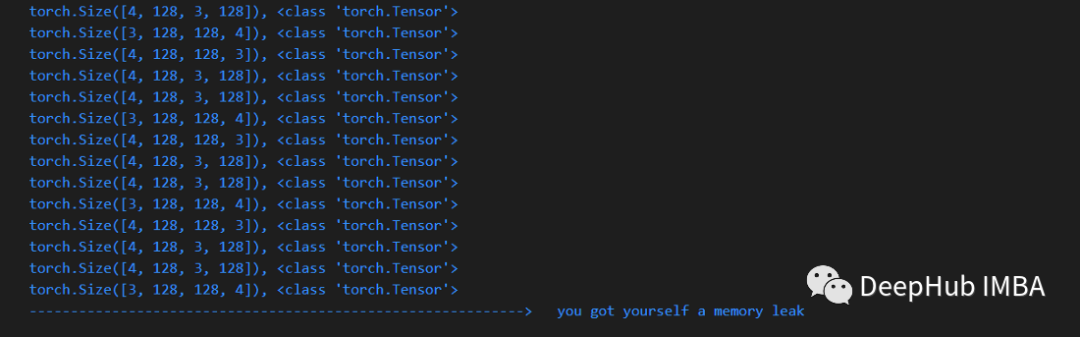

使用上下文装饰器调试Pytorch的内存泄漏问题

装饰器是 python 上下文管理器的特定实现。本片文章将通过一个pytorch GPU 调试的示例来说明如何使用它们。

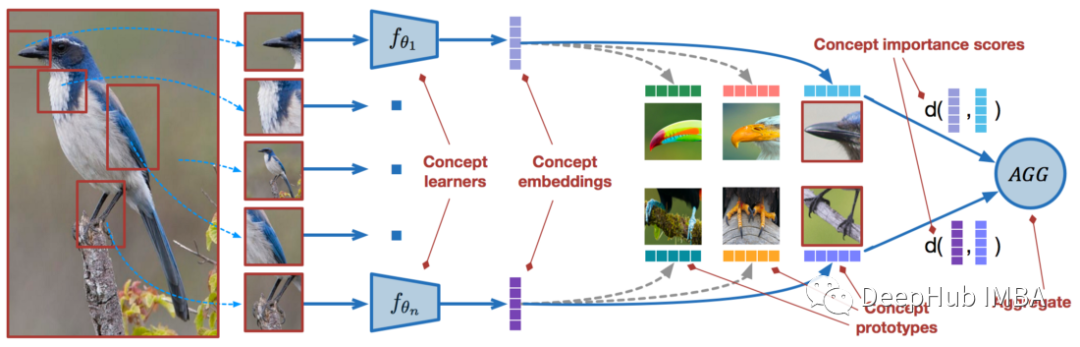

使用PyTorch进行小样本学习的图像分类

我们将从几个样本中学习的问题被称为“少样本学习 Few-Shot learning”。我们将从几个样本中学习的问题被称为“少样本学习 Few-Shot learning”。少样本学习是机器学习的一个子领域。

CSDN独家 | 全网首发 | Pytorch深度学习·理论篇(2023版)目录

本专栏将通过系统的深度学习实例,从可解释性的角度对深度学习的原理进行讲解与分析,通过将深度学习知识与Pytorch的高效结合,帮助各位新入门的读者理解深度学习各个模板之间的关系,这些均是在Pytorch上实现的,可以有效的结合当前各位研究生的研究方向,设计人工智能的各个领域,是经过一年时间打磨的精品

基于yolov5框架实现人流统计(目标检测算法、目标追踪算法以及越界识别功能)+手机获取统计人数

基于yolov5框架实现人流统计(主要AI算法包括:目标检测算法、目标追踪算法以及越界识别功能)+手机获取统计人数(喵提醒)

PyTorch中的多GPU训练:DistributedDataParallel

本文将介绍DistributedDataParallel,DDP 基于使用多进程而不是使用多线程的 DP,可以扩充到多机多卡的环境,所以他是分布式多GPU训练的首选。

Pytorch+Python实现人体关键点检测

用Python+Pytorch工程代码对人体进行关键点检测和骨架提取,并实现可视化。

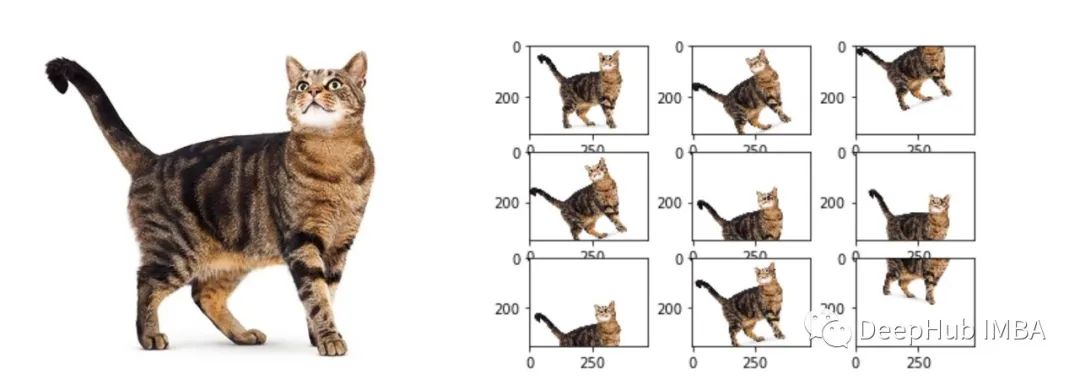

12个常用的图像数据增强技术总结

扩展用于训练模型的数据量的过程称为数据增强。通过训练具有多种数据类型的模型,我们可以获得更“泛化”的模型。

最新CUDA/cuDNN与Pytorch保姆级图文安装教程(速查字典版)

最新CUDA/cuDNN与Pytorch保姆级图文安装教程:CUDA下载、安装、多版本切换、卸载;解析CUDA、cuDNN、NVIDIA驱动、Pytorch间的版本对应关系