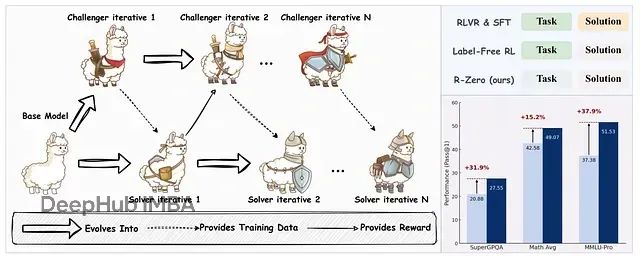

R-Zero:通过自博弈机制让大语言模型无需外部数据实现自我进化训练

R-Zero框架实现了大语言模型在无外部训练数据条件下的自主进化与推理能力提升。

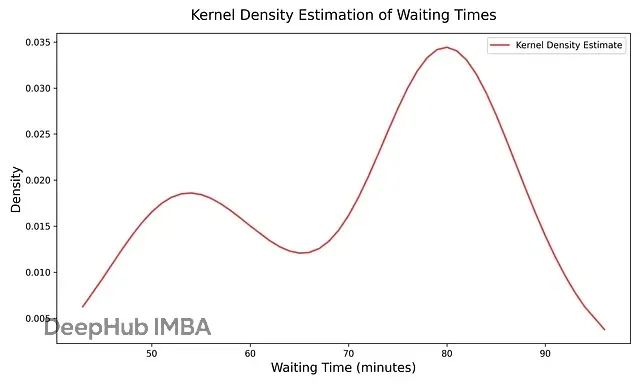

数据分布平滑化技术:核密度估计KDE解决直方图不连续问题

直方图提供了分布的粗略概念,但存在跳跃性和块状特征。核密度估计通过在数据点上放置平滑曲线并求和的方式解决了这一问题,提供了密度的连续视图。

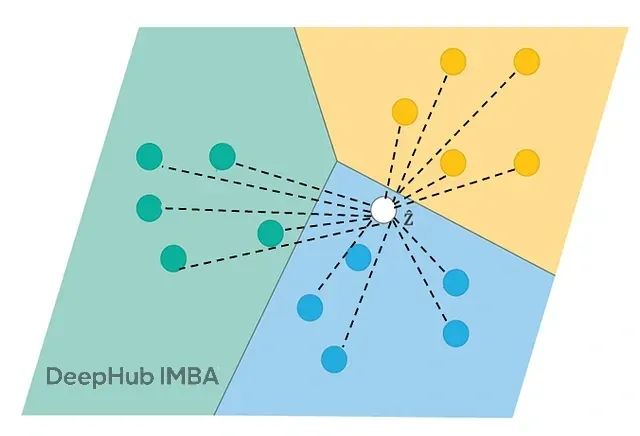

匹配网络处理不平衡数据集的6种优化策略:有效提升分类准确率

匹配网络(**Matching Networks**)是基于度量的元学习方法,通过计算查询样本与支持集中各样本的相似性实现分类。

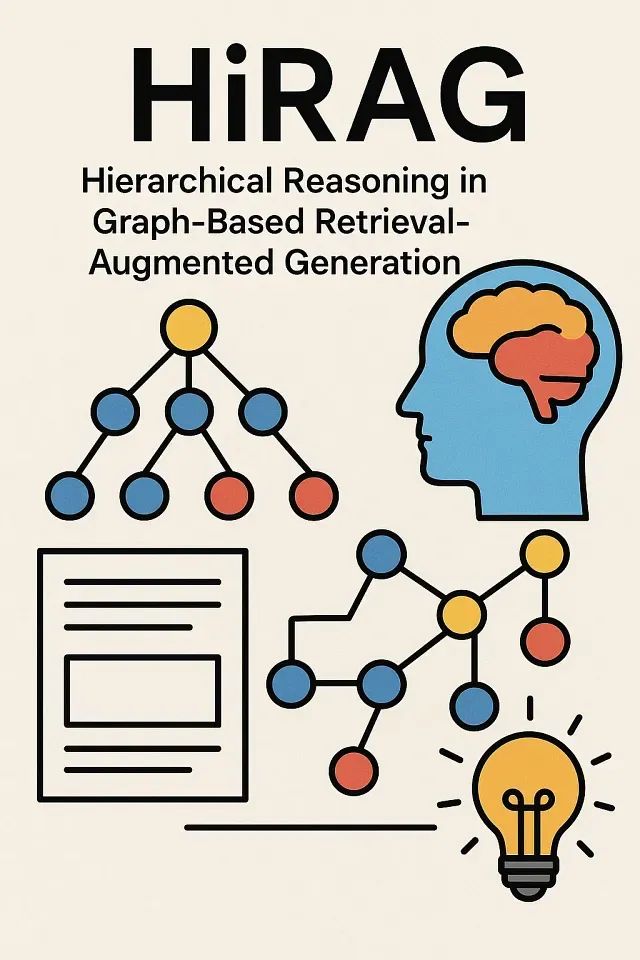

HiRAG:用分层知识图解决复杂推理问题

该系统基于图检索增强生成(GraphRAG)的核心思想,通过引入层次化架构来处理不同抽象层次的知识复杂度。

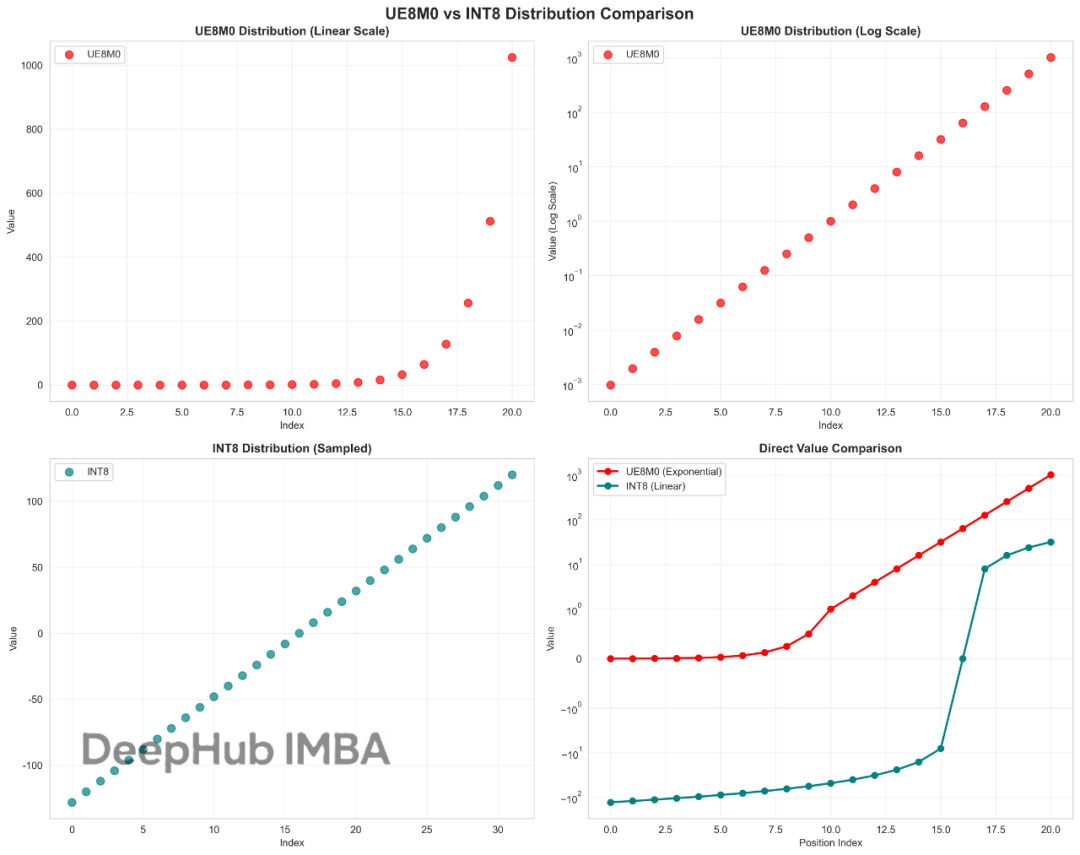

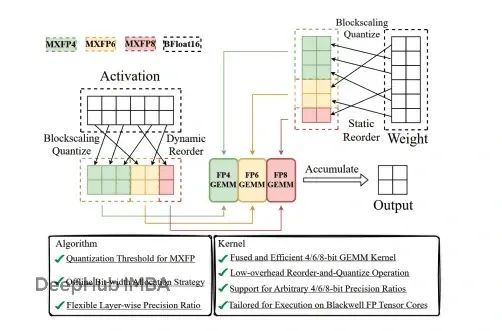

这也许就是DeepSeek V3.1性能提升的关键:UE8M0与INT8量化技术对比与优势分析

UE8M0作为FP8格式家族中的一个特殊变体,我们今天来看看这个UE8M0到底是什么。

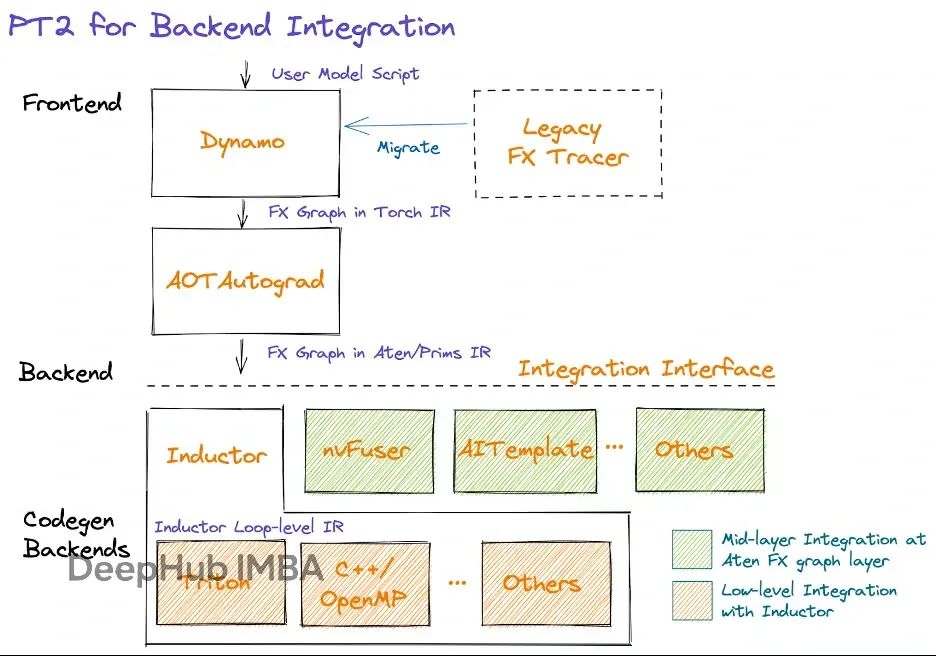

PyTorch 2.0性能优化实战:4种常见代码错误严重拖慢模型

我们将深入探讨图中断(graph breaks)和多图问题对性能的负面影响,并分析PyTorch模型开发中应当避免的常见错误模式。

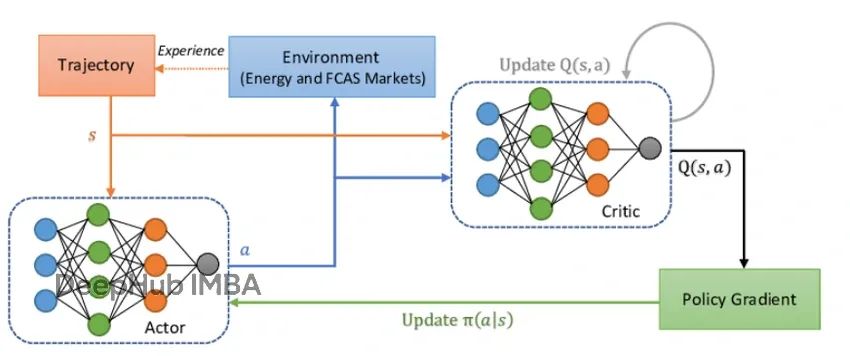

近端策略优化算法PPO的核心概念和PyTorch实现详解

本文提供了PPO算法的完整PyTorch实现方案,涵盖了从理论基础到实际应用的全流程。

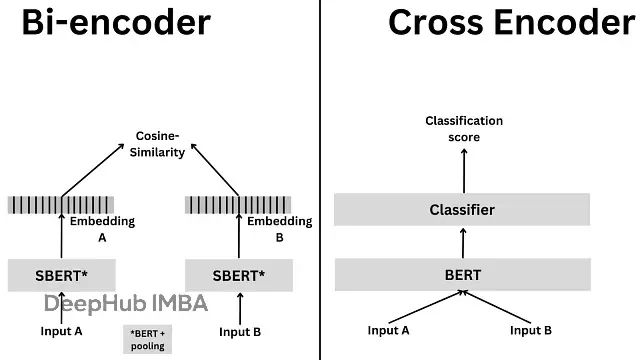

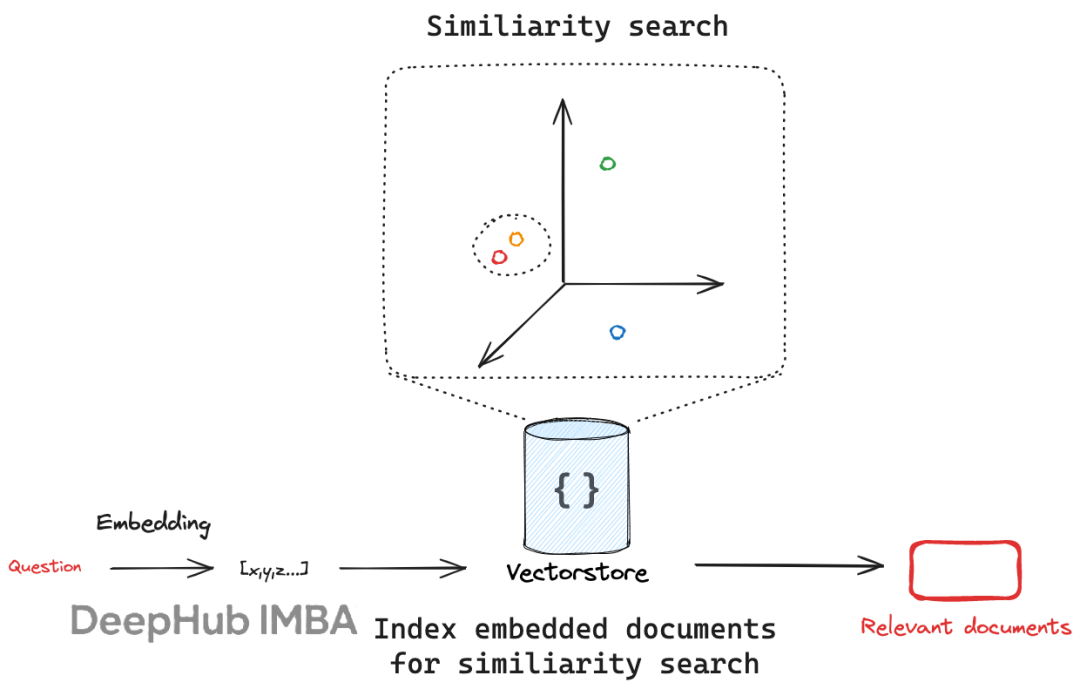

RAG系统文本检索优化:Cross-Encoder与Bi-Encoder架构技术对比与选择指南

本文将深入分析这两种编码架构的技术原理、数学基础、实现流程以及各自的优势与局限性,并探讨混合架构的应用策略。

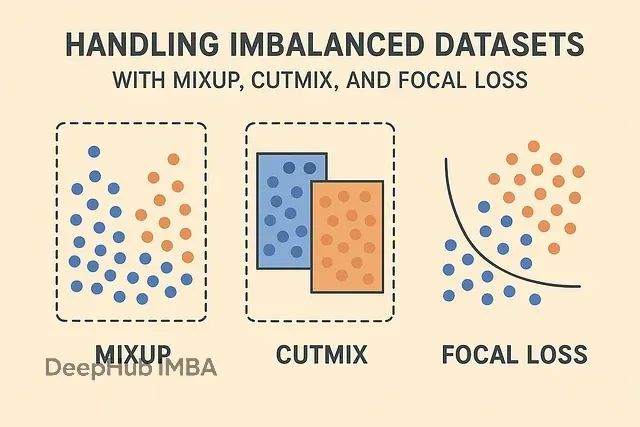

让模型不再忽视少数类:MixUp、CutMix、Focal Loss三种技术解决数据不平衡问题

针对不平衡数据集的挑战,研究界通常采用数据增强技术与损失函数优化相结合的策略。

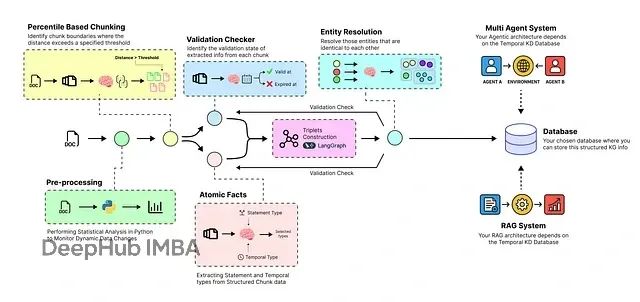

构建时序感知的智能RAG系统:让AI自动处理动态数据并实时更新知识库

本文将构建一个端到端的时序智能体管道,实现从原始数据到动态知识库的转换,并在此基础上构建多智能体系统以验证其性能表现。

MXFP4量化:如何在80GB GPU上运行1200亿参数的GPT-OSS模型

GPT-OSS通过创新的量化技术实现了突破性进展。该系统能够在单个80GB GPU上运行1200亿参数模型,同时保持竞争性的基准测试性能。

AMD Ryzen AI Max+ 395四机并联:大语言模型集群推理深度测试

本文介绍使用四块Framework主板构建AI推理集群的完整过程,并对其在大语言模型推理任务中的性能表现进行了系统性评估。

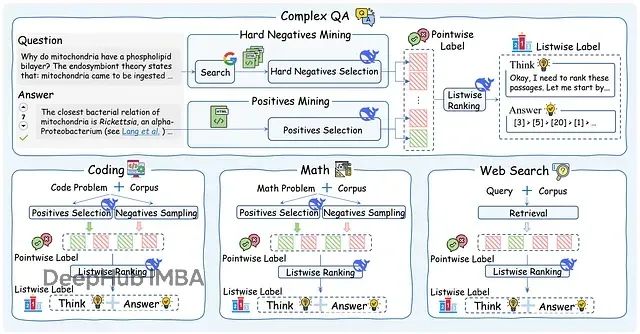

ReasonRank:从关键词匹配到逻辑推理,排序准确性大幅超越传统方法

本文深入分析ReasonRank,一个采用自动化数据合成框架和两阶段训练策略(监督微调+强化学习)的先进段落重排器,该系统在信息检索领域实现了突破性的推理能力

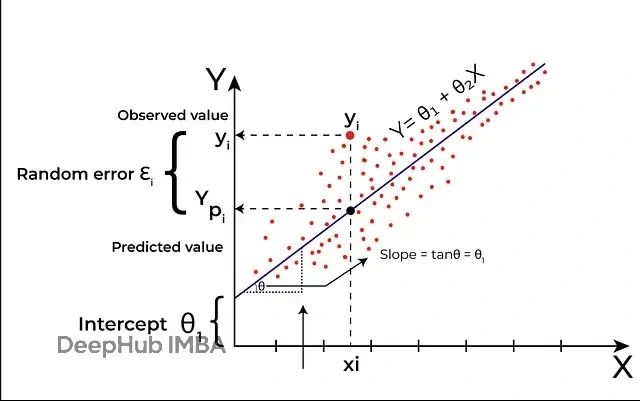

MARS算法理论和Python代码实现:用分段回归解决非线性时间序列预测问题

本文将深入探讨MARS算法的核心原理,并详细阐述其在时间序列预测任务中的应用策略与技术实现。

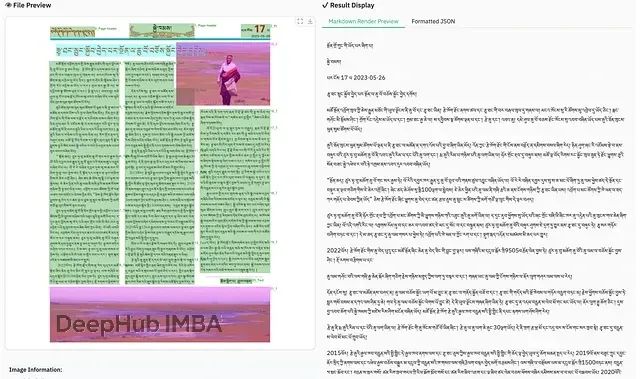

Dots.ocr:告别复杂多模块架构,1.7B参数单一模型统一处理所有OCR任务

本文将深入分析Dots.ocr的技术架构特点、性能表现以及在实际应用中的价值,探讨这一模型如何在参数效率与处理能力之间找到最佳平衡点。

JAX快速上手:从NumPy到GPU加速的Python高性能计算库入门教程

JAX代表了Python高性能数值计算领域的重要进展。通过提供与NumPy兼容的接口,结合强大的函数转换能力以及基于加速线性代数的高效硬件执行

提升LangChain开发效率:10个被忽视的高效组件,让AI应用性能翻倍

本文将系统分析LangChain框架中十个具有重要价值但使用率相对较低的核心组件,通过技术原理解析和实践案例说明,帮助开发者构建更高效、更智能、更具适应性的AI应用系统。

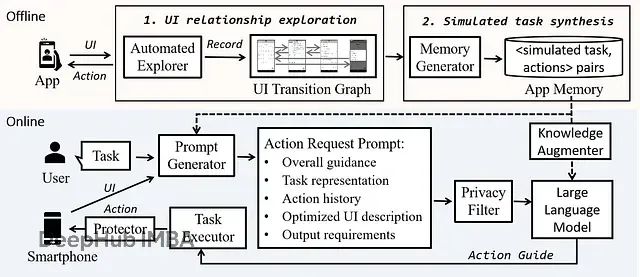

大型动作模型LAM:让企业重复任务实现80%效率提升的AI技术架构与实现方案

本文将深度剖析LAMs的技术架构,详细阐述其核心组件的设计原理、功能实现机制以及在实际业务场景中的应用模式

使用LangGraph从零构建多智能体AI系统:实现智能协作的完整指南

本文将通过构建AI研究助手的完整案例,展示如何使用LangGraph框架实现这种架构转变,从理论基础到具体实现,帮助你掌握下一代AI系统的构建方法。

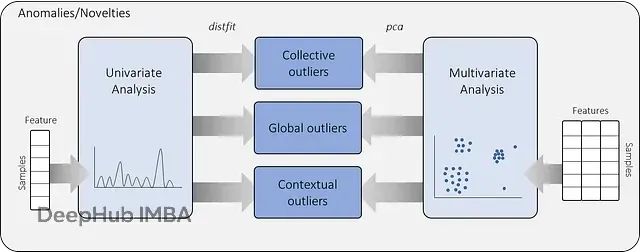

PCA多变量离群点检测:Hotelling's T2与SPE方法原理及应用指南

本文将系统阐述基于PCA的异常值检测理论框架,重点介绍霍特林T²统计量和SPE/DmodX(平方预测误差/距离建模残差)两种核心方法,并通过连续变量和分类变量的实际案例,详细演示无监督异常值检测模型的构建过程。