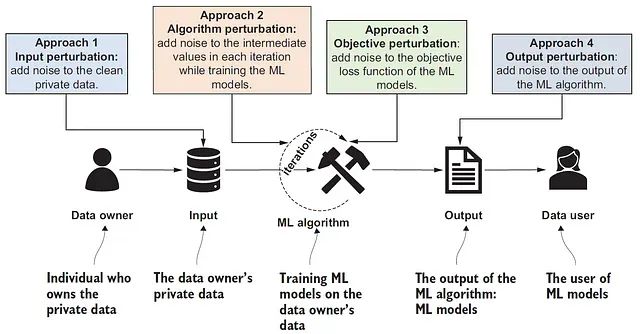

差分隐私机器学习:通过添加噪声让模型更安全,也更智能

本文探讨如何在模型训练过程中平衡实用性与形式化隐私保证这一关键问题。我们采用带有噪声梯度更新的模拟DP-SGD算法实现差分隐私机器学习。

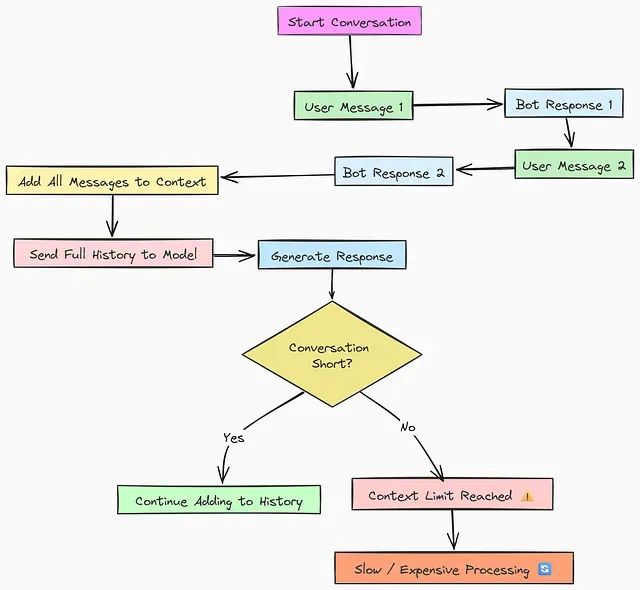

AI代理内存消耗过大?9种优化策略对比分析

本文将深入探讨并实现九种从基础到高级的内存优化技术,涵盖从简单的顺序存储方法到复杂的类操作系统内存管理策略。通过系统性的代码实现和性能评估,我们将分析每种技术的适用场景、优势特点以及潜在限制。

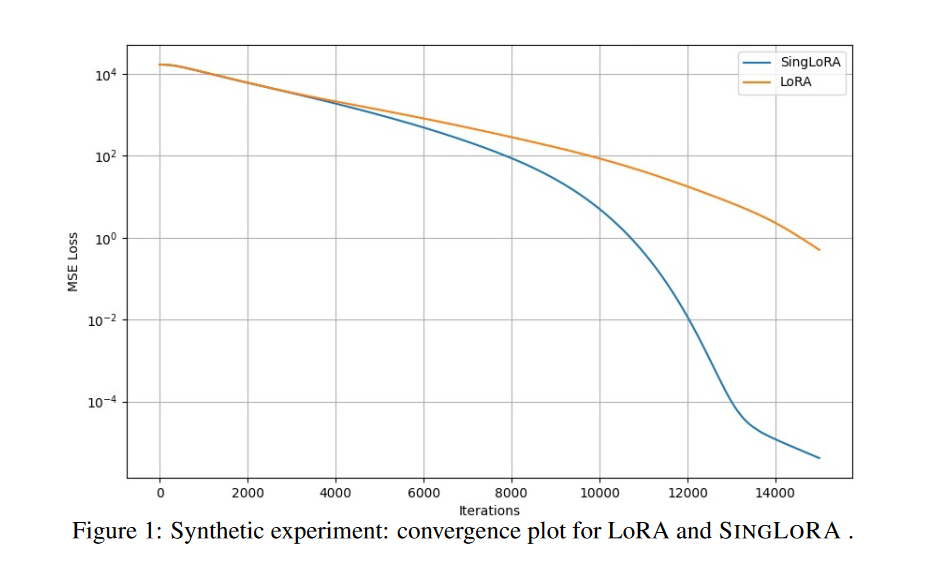

SingLoRA:单矩阵架构减半参数量,让大模型微调更稳定高效

SingLoRA作为一种创新的低秩适应方法,通过摒弃传统的双矩阵架构,采用单矩阵对称更新策略,在简化模型结构的同时显著提升了训练稳定性和参数效率。

告别低效代码:用对这10个Pandas方法让数据分析效率翻倍

本文将介绍 10 个在数据处理中至关重要的 Pandas 技术模式。这些模式能够显著减少调试时间,提升代码的可维护性,并构建更加清晰的数据处理流水线。

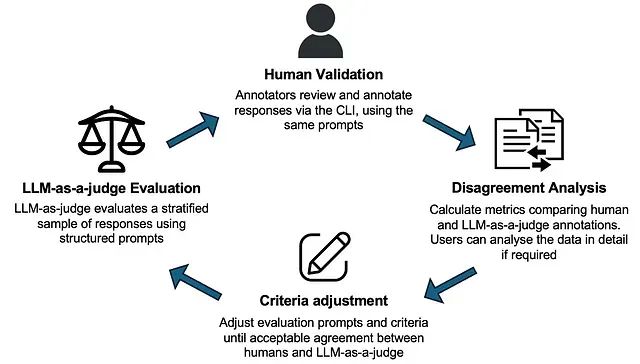

让大语言模型在不知道答案时拒绝回答:KnowOrNot框架防止AI幻觉

KnowOrNot开源框架通过创建可保证的"知识库外"测试场景,评估AI系统是否能够正确识别其知识边界并在信息不足时采取适当的拒绝回答策略。

贝叶斯状态空间神经网络:融合概率推理和状态空间实现高精度预测和可解释性

本文将BSSNN扩展至反向推理任务,即预测*X∣y*,这种设计使得模型不仅能够预测结果,还能够探索特定结果对应的输入特征组合。

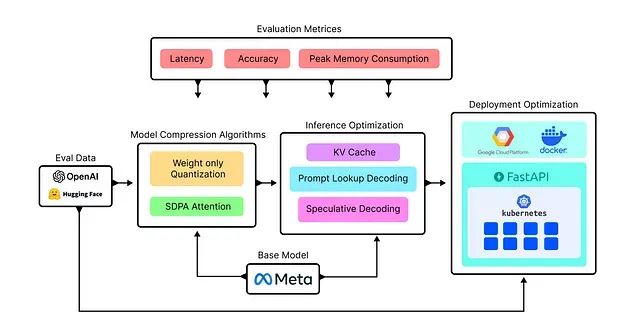

构建高性能LLM推理服务的完整方案:单GPU处理172个查询/秒、10万并发仅需15美元/小时

本文将通过系统性实验不同的优化技术来构建自定义LLaMA模型服务,目标是高效处理约102,000个并行查询请求,并通过对比分析确定最优解决方案。

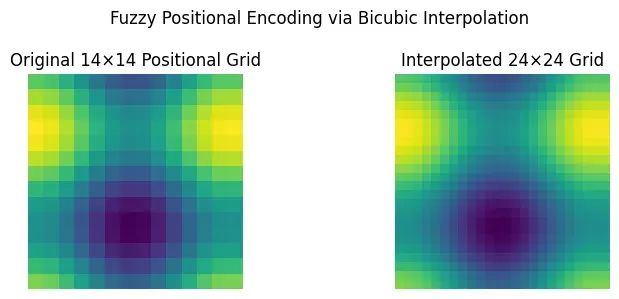

ViTAR:模糊位置编码让视觉Transformer适配任意分辨率图像

ViTAR代表了视觉Transformer技术的重要进步,特别是在处理多样化和高分辨率图像数据的应用场景中表现出显著优势。

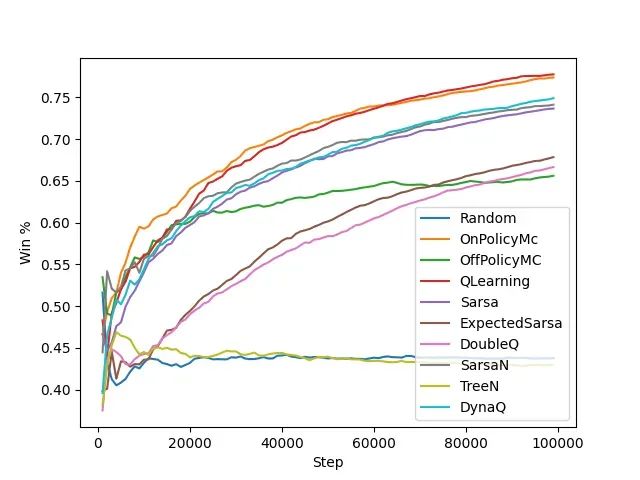

强化学习算法基准测试:6种算法在多智能体环境中的表现实测

本文构建了多智能体强化学习的系统性评估框架,选择井字棋和连珠四子这两个具有代表性的双人博弈游戏作为基准测试环境。通过引入模型动物园策略和自我对战机制,研究探索了各种表格方法在动态对抗环境中的学习能力和收敛特性。

刚发布的最新版本怎么用?YOLOv13新手教程带你快速上手

本文将详细介绍YOLOv13的完整实现流程,涵盖数据集准备、模型训练、验证评估以及实际应用等关键环节。

Flow Matching生成模型:从理论基础到Pytorch代码实现

本文将系统阐述Flow Matching的完整实现过程,包括数学理论推导、模型架构设计、训练流程构建以及速度场学习等关键组件。通过本文的学习,读者将掌握Flow Matching的核心原理,获得一个完整的PyTorch实现

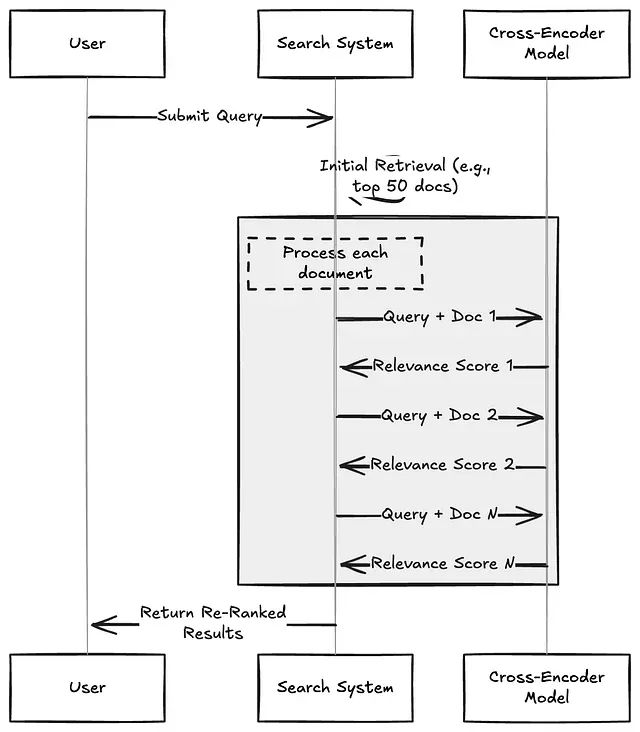

信息检索重排序技术深度解析:Cross-Encoders、ColBERT与大语言模型方法的实践对比

本文将深入分析三种主流的重排序技术:Cross-Encoders(交叉编码器)、ColBERT以及基于大语言模型的重排序器,并详细阐述各方案在实际应用中的性能表现、成本考量以及适用场景。

Python 3.14七大新特性总结:从t-string模板到GIL并发优化

本文基于当前最新的beta 2版本,深入分析了Python 3.14中的七项核心新特性。

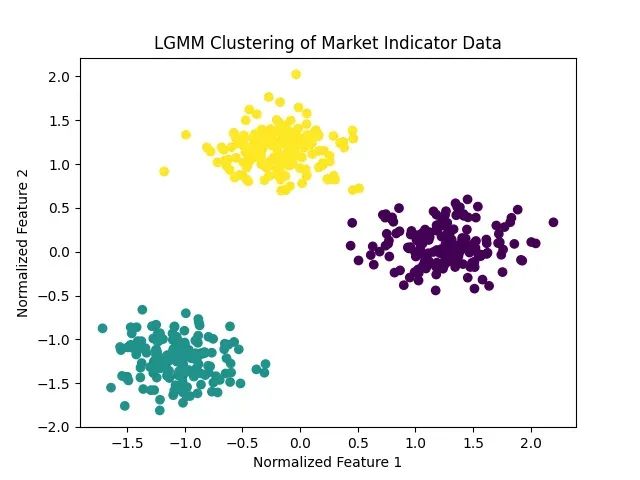

量化交易隐藏模式识别方法:用潜在高斯混合模型识别交易机会

本文将从技术实现角度阐述LGMM相对于传统方法的优势,通过图表对比分析展示其效果,并详细说明量化分析师和技术分析师如何应用此方法优化投资决策。

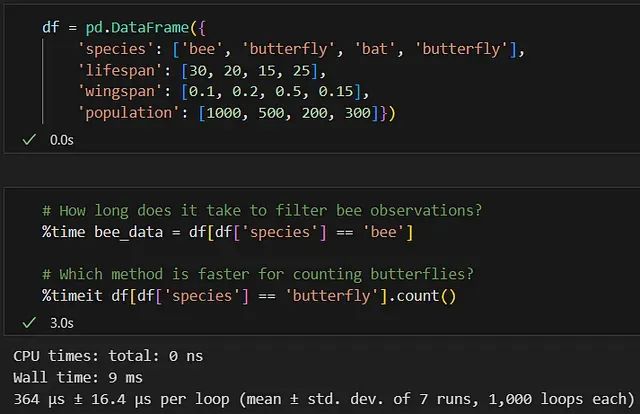

掌握这10个Jupyter魔法命令,让你的数据分析效率提升3倍

本文将详细介绍十个在实际数据科学项目中最为实用的魔法命令,并通过传粉者数据分析项目进行具体演示。

大语言模型也可以进行图像分割:使用Gemini实现工业异物检测完整代码示例

本文将通过一个实际应用场景——工业传送带异物检测,详细介绍如何利用Gemini的图像分割能力构建完整的解决方案。

CUDA性能优化实战:7个步骤让并行归约算法提升10倍效率

本文深入探讨了一个经典的并行计算算法——并行归约(Parallel Reduction)的性能优化过程,通过七个渐进式的优化步骤,展示了如何将算法性能提升至极致。

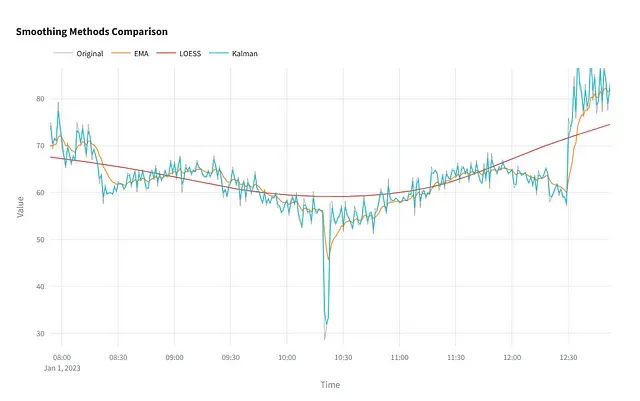

Python时间序列平滑技术完全指南:6种主流方法原理与实战应用

本文将系统介绍六种广泛应用的时间序列平滑技术,从技术原理、参数配置、性能特征以及适用场景等多个维度进行深入分析。

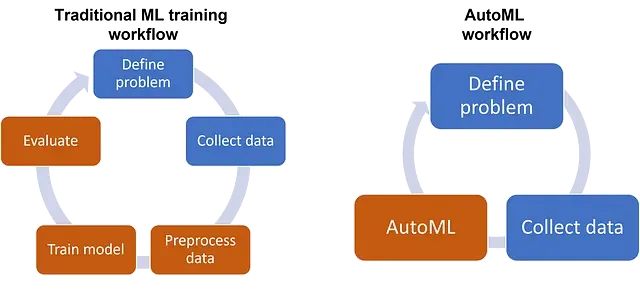

Python AutoML框架选型攻略:7个工具性能对比与应用指南

本文将系统介绍在实际项目中经过验证的主要Python AutoML库,分析各自的技术特点和适用场景。

大数据集特征工程实践:将54万样本预测误差降低68%的技术路径与代码实现详解

本文通过实际案例演示特征工程在回归任务中的应用效果,重点分析包含数值型、分类型和时间序列特征的大规模表格数据集的处理方法。