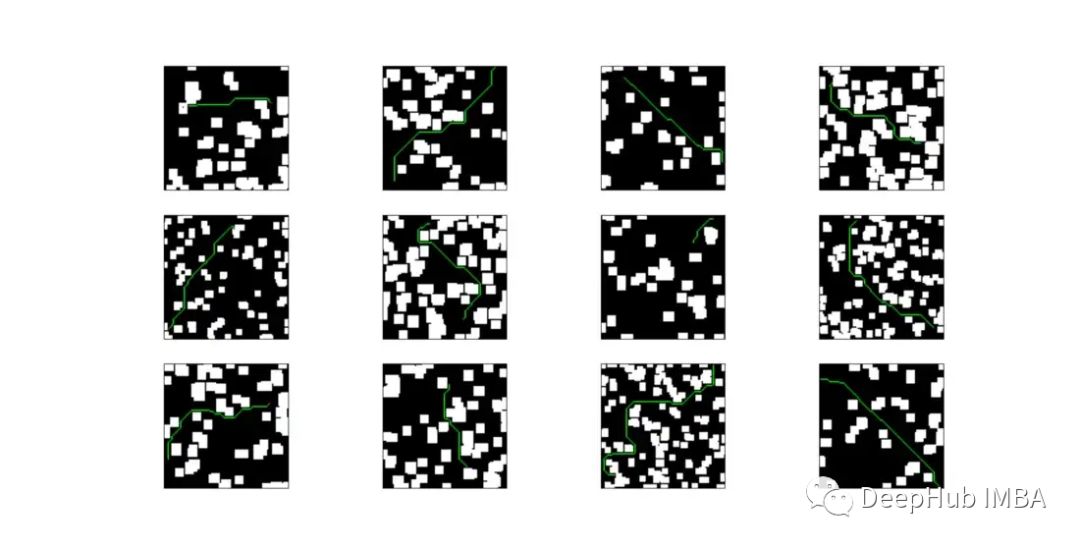

使用CNN进行2D路径规划

本文将CNN应用于解决简单的二维路径规划问题。主要使用Python, PyTorch, NumPy和OpenCV。

这20个Pandas函数可以完成80%的数据科学工作

Pandas 是数据科学社区中使用最广泛的库之一,本文将提供最常用的 Pandas 函数以及如何实际使用它们的样例。

使用Stable-Diffusion生成视频的完整教程

本文是关于如何使用cuda和Stable-Diffusion生成视频的完整指南,将使用cuda来加速视频生成,并且可以使用Kaggle的TESLA GPU来免费执行我们的模型。

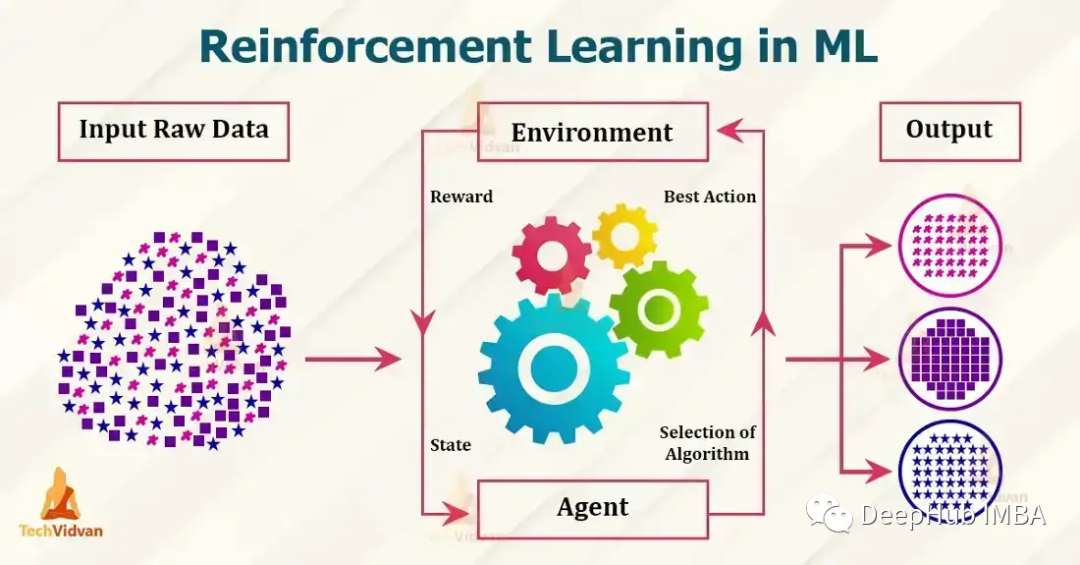

7个流行的强化学习算法及代码实现

目前流行的强化学习算法包括 Q-learning、SARSA、DDPG、A2C、PPO、DQN 和 TRPO。 这些算法已被用于在游戏、机器人和决策制定等各种应用中,并且这些流行的算法还在不断发展和改进,本文我们将对其做一个简单的介绍。

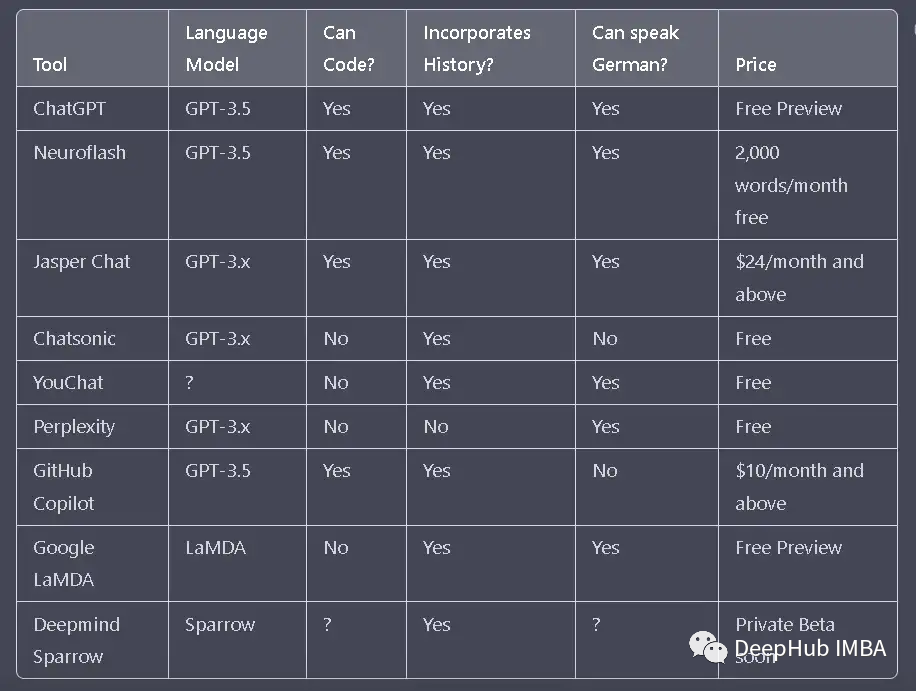

2023 年8个ChatGPT 的替代品

OpenAI 于 2022 年 11 月下旬推出的 ChatGPT 在网络世界引起了不小的轰动。其实还有许多其他的机器人在本文中,我将整理8 个 ChatGPT 替代方案。

8种时间序列分类方法总结

对时间序列进行分类是应用机器和深度学习模型的常见任务之一。本篇文章将涵盖 8 种类型的时间序列分类方法。这包括从简单的基于距离或间隔的方法到使用深度神经网络的方法。这篇文章旨在作为所有时间序列分类算法的参考文章。

深度学习中高斯噪声:为什么以及如何使用

在数学上,高斯噪声是一种通过向输入数据添加均值为零和标准差(σ)的正态分布随机值而产生的噪声。

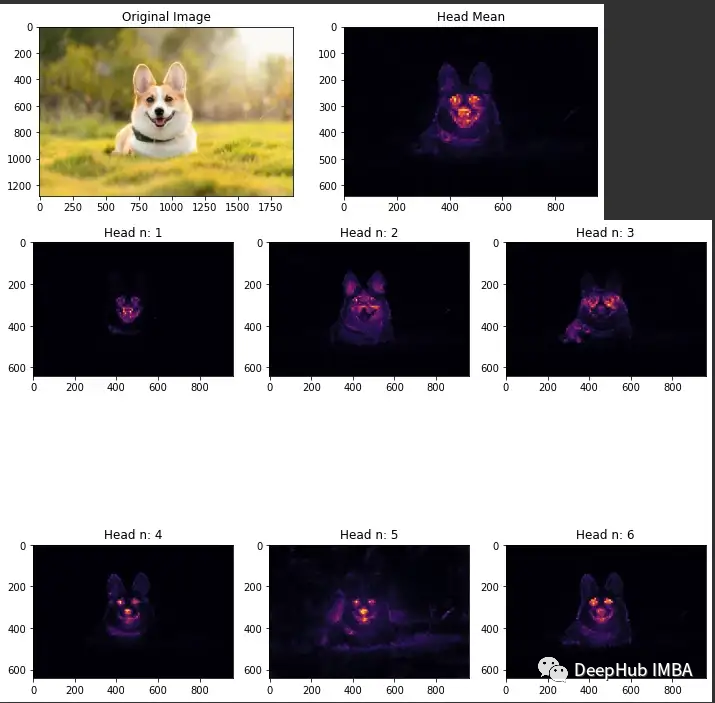

可视化VIT中的注意力

ViT中最主要的就是注意力机制,所以可视化注意力就成为了解ViT的重要步骤,所以我们这里介绍如何可视化ViT中的注意力

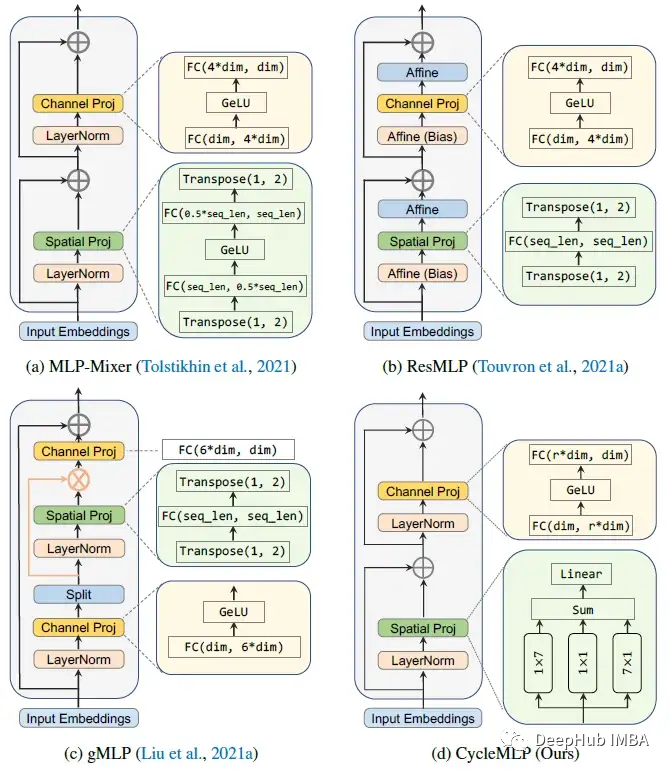

CycleMLP:一种用于密集预测的mlp架构

CycleMLP有两个优点。(1)可以处理各种大小的图像。(2)利用局部窗口实现了计算复杂度与图像大小的线性关系。

Jupyter Lab 的 10 个有用技巧

JupyterLab是 Jupyter Notebook「新」界面。它包含了jupyter notebook的所有功能,并升级增加了很多功能。

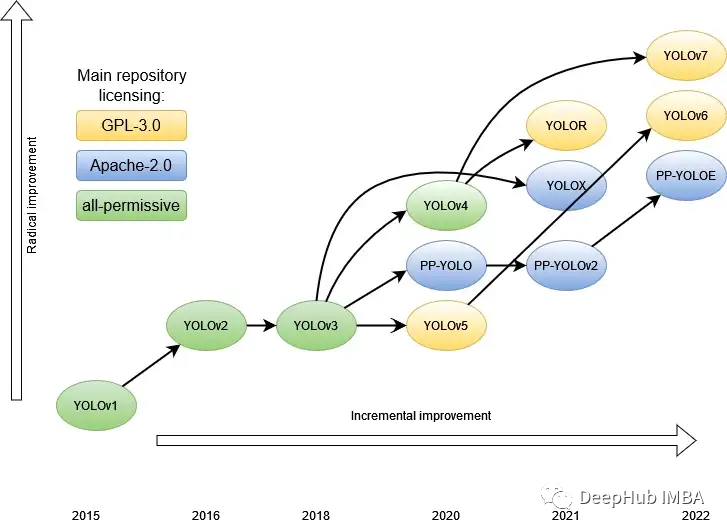

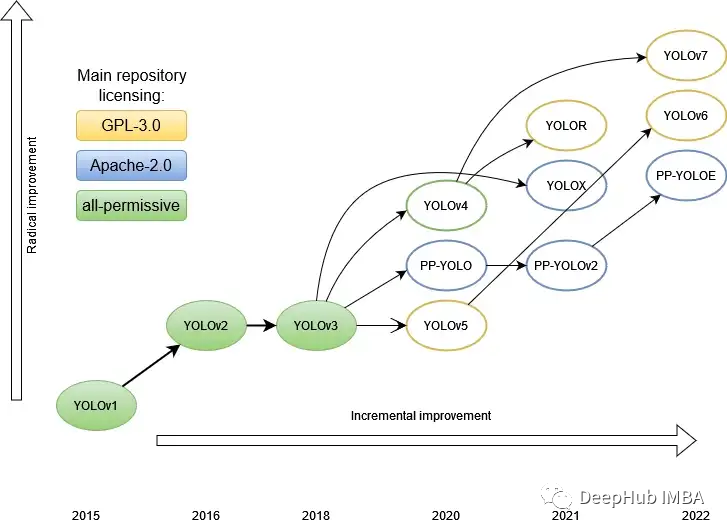

YOLO家族系列模型的演变:从v1到v8(下)

昨天的文章中,我们回顾了 YOLO 家族的前 9 个架构。本文中将继续总结最后3个框架,还有本月最新发布的YOLO V8.

YOLO家族系列模型的演变:从v1到v8(上)

YOLO V8已经在本月发布了,我们这篇文章的目的是对整个YOLO家族进行比较分析。

使用Stable Diffusion和Pokedex的描述生成神奇宝贝图片

还记得我们以前使用GAN、Clip、DALL-E生成神奇宝贝的文章吗,现在是时候使用Stable Diffusion了

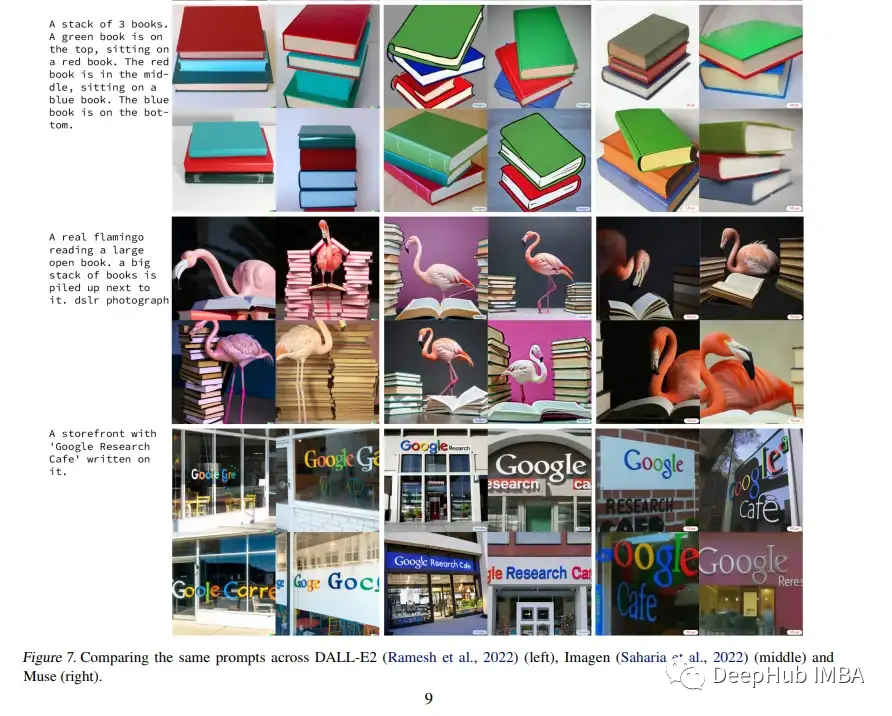

论文推荐:谷歌Masked Generative Transformers 以更高的效率实现文本到图像的 SOTA

在23年1月新发布的论文 Muse中:Masked Generative Transformers 生成文本到图像利用掩码图像建模方法来达到了最先进的性能,零样本 COCO 评估的 FID 分数为 7.88,CLIP 分数为 0.32——同时明显快于扩散或传统自回归模型。

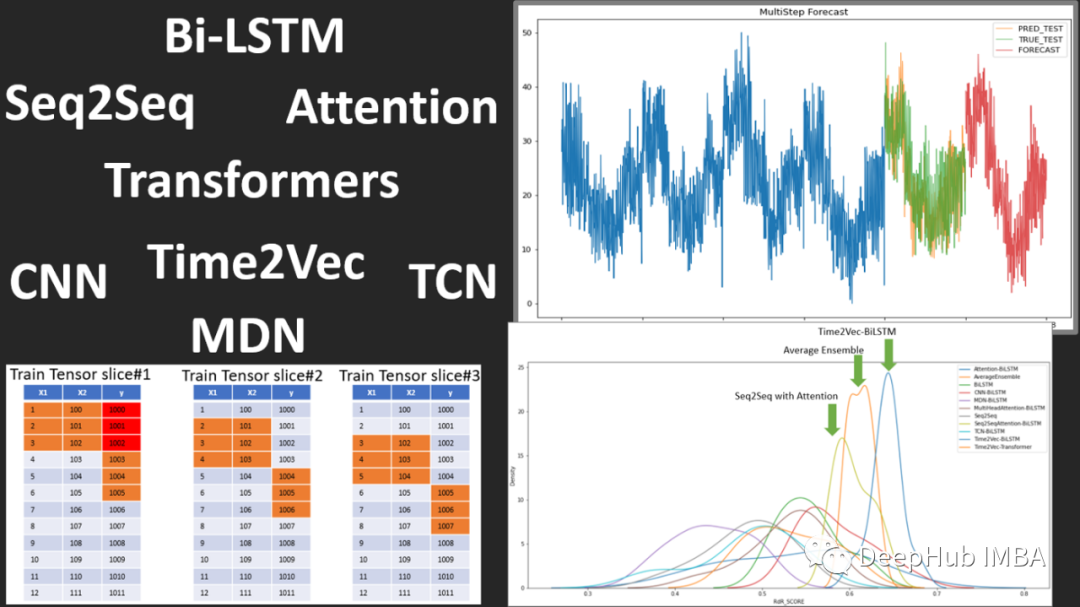

2022年深度学习在时间序列预测和分类中的研究进展综述

2022年时间序列预测中transformers衰落和时间序列嵌入方法的兴起,还有异常检测、分类也取得了进步,本文将尝试介绍一些在过去一年左右的时间里出现的更有前景和关键的论文

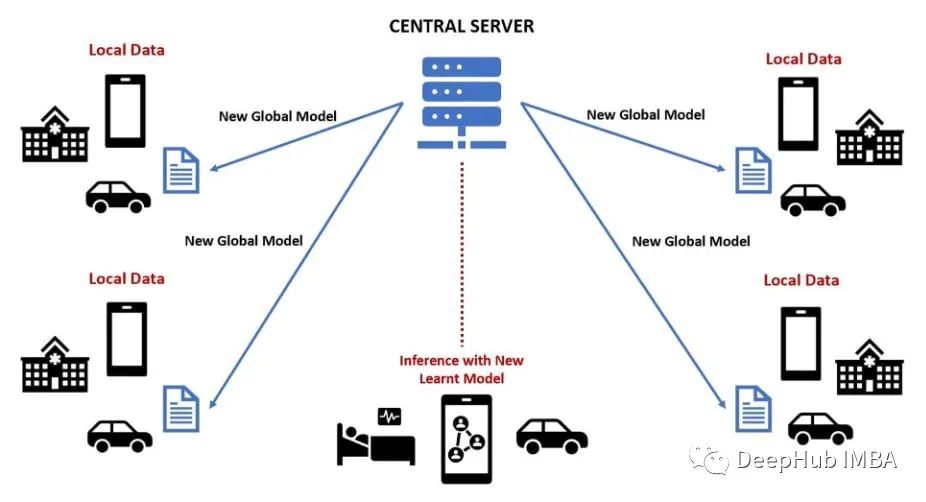

联邦学习 (FL) 中常见的3种模型聚合方法的 Tensorflow 示例

联合学习 (FL) 是一种出色的 ML 方法,它使多个设备(例如物联网 (IoT) 设备)或计算机能够在模型训练完成时进行协作,而无需共享它们的数据。

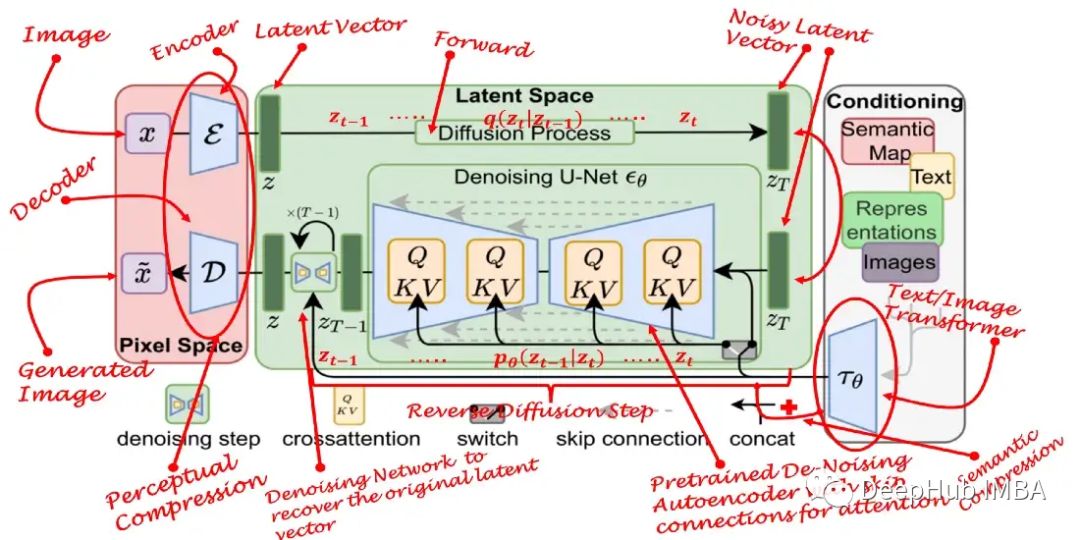

Diffusion 和Stable Diffusion的数学和工作原理详细解释

扩散模型的兴起可以被视为人工智能生成艺术领域最近取得突破的主要因素。而稳定扩散模型的发展使得我们可以通过一个文本提示轻松地创建美妙的艺术插图。所以在本文中,我将解释它们是如何工作的。

TensorFlow和PyTorch的实际应用比较

TensorFlow和PyTorch是两个最受欢迎的开源深度学习框架,本文与其他文章的特性的对比不同,我们将以实际应用出发,从性能、可伸缩性和其他高级特性方面比较TensorFlow和PyTorch。

9个时间序列交叉验证方法的介绍和对比

在本文中,我们收集了时间序列的常用的9种交叉验证方法。这些包括样本外验证(holdout)或流行的K-fold交叉验证的几个扩展。

使用Flask快速部署PyTorch模型

今天我将通过一个简单的案例:部署一个PyTorch图像分类模型,介绍如何启动和运行我们的模型