5个开源MCP服务器:扩展AI助手能力,高效处理日常工作

本文基于实际部署和使用经验,精选了五种开源MCP服务器实现,从配置到应用场景进行全面剖析,助您快速构建具备环境交互能力的AI系统。

基于马尔可夫链的状态转换,用概率模型预测股市走势

马尔可夫链本质上是一个依据特定概率规则从一个状态转移至另一个状态的数学系统。其核心特征在于:**系统的下一个状态仅依赖于当前状态,而非之前的状态序列**。

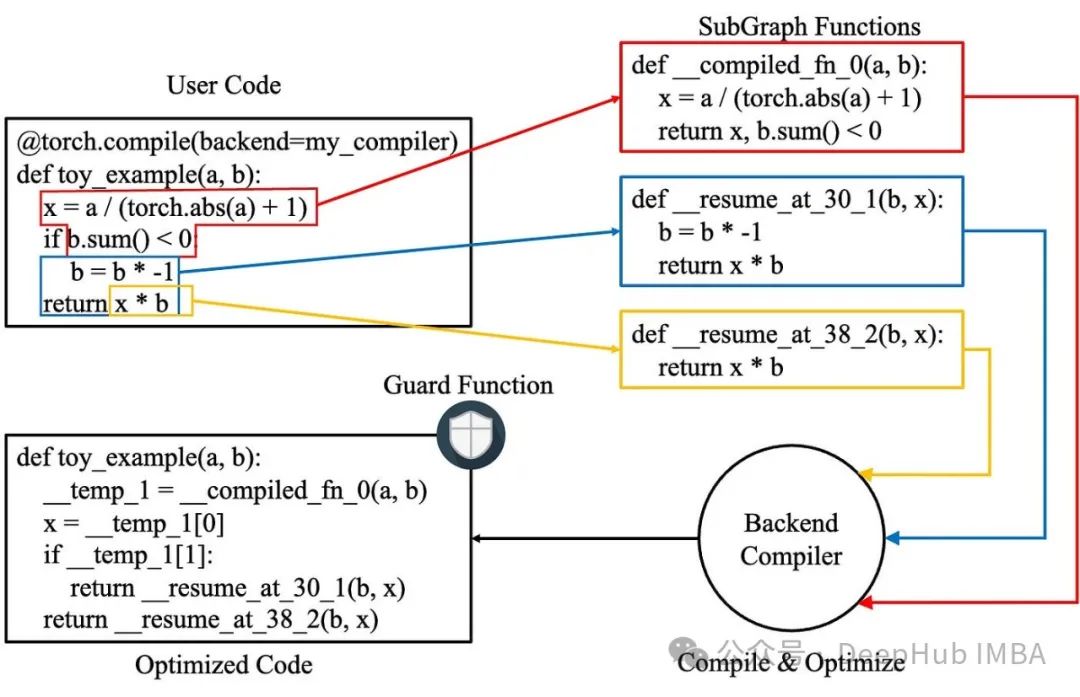

深入解析torch.compile:提升PyTorch模型性能、高效解决常见问题

torch.compile为PyTorch用户提供了强大的性能优化工具,但在实际应用中仍需谨慎处理各种潜在问题。通过系统化的调试策略、深入的组件分析和针对性的优化措施,用户可以有效提升模型性能并解决常见问题。

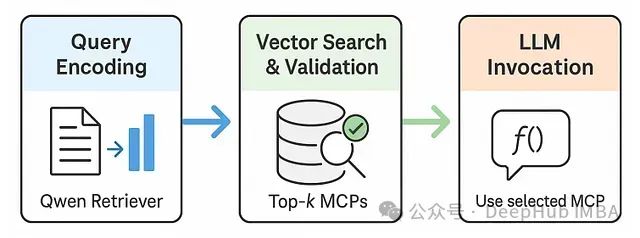

RAG-MCP:基于检索增强生成的大模型工具选择优化框架

RAG-MCP框架不仅具有学术价值,更解决了AI助手和自主代理发展面临的核心瓶颈。随着我们期望LLM在动态环境中执行日益复杂的任务,其高效利用多样化外部工具的能力变得尤为关键。

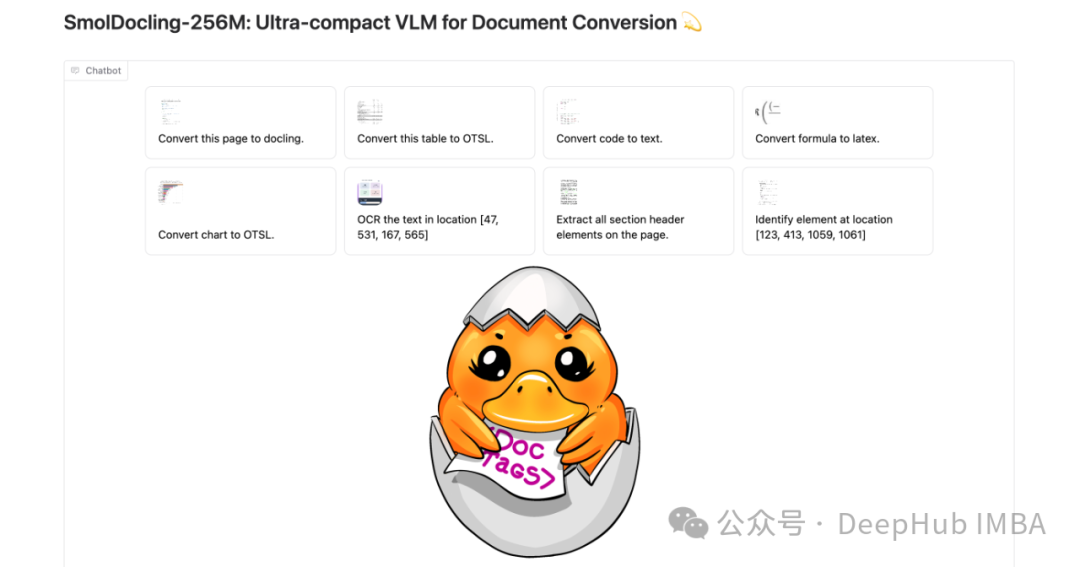

SmolDocling技术解析:2.56亿参数胜过70亿参数的轻量级文档处理模型

SmolDocling基于Hugging Face SmolVLM-256M模型开发而来,是一款体积显著小于同类产品的紧凑型模型。与主流视觉模型相比,其体积减小了5-10倍,仅包含2.56亿个参数。尽管规模较小,其性能水平却足以与参数量为其27倍的大型视觉模型相媲美。

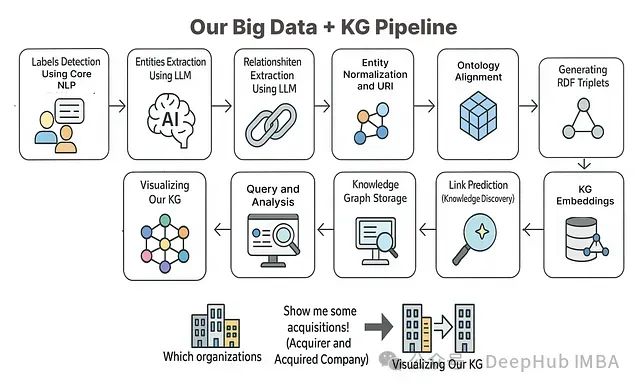

从零构建知识图谱:使用大语言模型处理复杂数据的11步实践指南

本文将基于相关理论知识和方法构建一个完整的端到端项目,系统展示如何利用知识图谱方法对大规模数据进行处理和分析。

Pandas数据合并:10种高效连接技巧与常见问题

Pandas库中的merge和join函数提供了强大的数据整合能力,但不恰当的使用可能导致数据混乱。基于对超过1000个复杂数据集的分析经验,本文总结了**10种关键技术**,帮助您高效准确地完成数据合并任务。

PINN应用案例:神经网络求解热扩散方程高质量近似解

PINN框架的关键组成是一个特殊设计的损失函数,其中包含微分方程残差项。该残差项量化了神经网络解与PDE描述的物理定律之间的偏离程度。

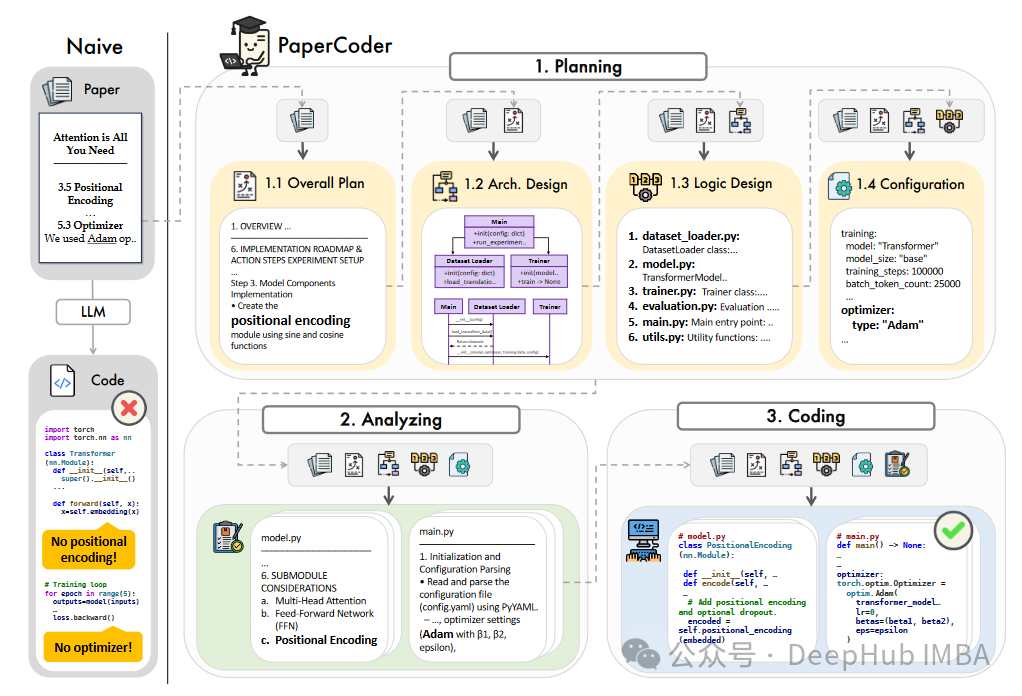

PaperCoder:一种利用大型语言模型自动生成机器学习论文代码的框架

本文介绍了一种名为PaperCoder的新型多智能体LLM框架,旨在自动生成机器学习研究论文的代码库。

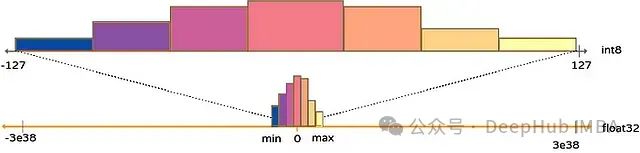

PyTorch量化感知训练技术:模型压缩与高精度边缘部署实践

本文将深入探讨模型量化的原理、主要量化技术类型以及如何使用PyTorch实现这些技术。

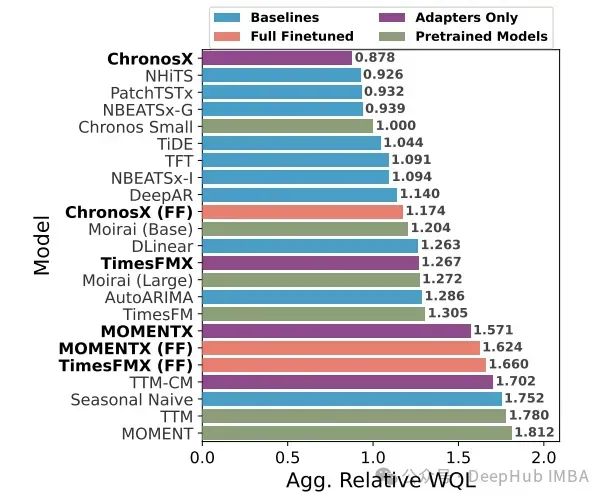

ChronosX: 可使用外生变量的时间序列预测基础模型

本文将系统剖析ChronosX的工作机制,并深入探讨其在多种基准测试中的表现。

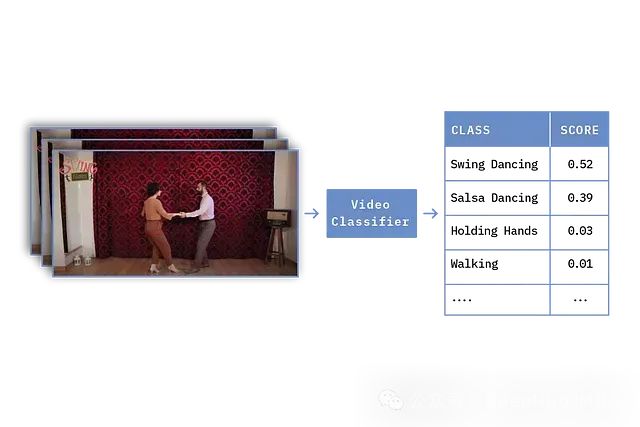

PyTorchVideo实战:从零开始构建高效视频分类模型

本文展示了如何使用PyTorchVideo和PyTorch Lightning构建视频分类模型的完整流程。通过合理的数据处理、模型设计和训练策略,我们能够高效地实现视频理解任务。

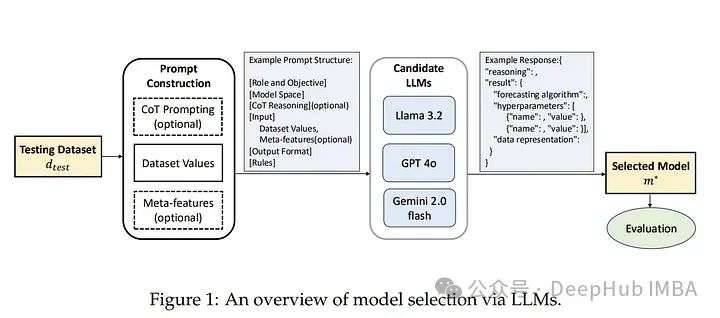

基于大型语言模型的高效时间序列预测模型选择

本文作者提出了一种基于大型语言模型(LLM)的模型选择范式。核心思想是利用LLM(如LLaMA 3.2、GPT-4o、Gemini 2.0)在零样本推理中的知识和推理能力,代替传统的性能矩阵来直接推荐最优模型。

在AMD GPU上部署AI大模型:从ROCm环境搭建到Ollama本地推理实战指南

本文以 AMD Radeon RX 7900XT 为例在 Linux 环境下解决了 ROCm 部署的诸多技术挑战。

防止交叉验证中的数据泄露:提升模型在实际环境中的性能

本文将深入探讨如何构建真正稳健的验证策略,确保模型在面对真实世界数据时依然能保持预期的性能。

提升AI训练性能:GPU资源优化的12个实战技巧

本文系统阐述的优化策略为提升 AI/ML 工作负载中的 GPU 资源利用率提供了全面技术指导。通过实施数据处理并行化、内存管理优化以及模型设计改进等技术手段

使用Torch Compile提高大语言模型的推理速度

在本文中,我们将探讨torch.compile的工作原理,并测量其对LLMs推理性能的影响。

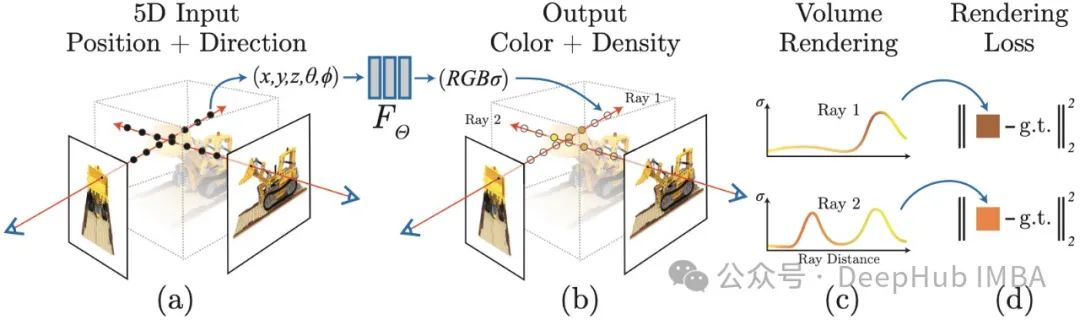

神经辐射场(NeRF)实战指南:基于PyTorch的端到端实现

本文将系统性地引导读者使用PyTorch构建完整的神经辐射场(NeRF)处理流程。从图像加载到高质量三维场景渲染,文章将详细讨论实现过程中的关键技术点和优化策略。

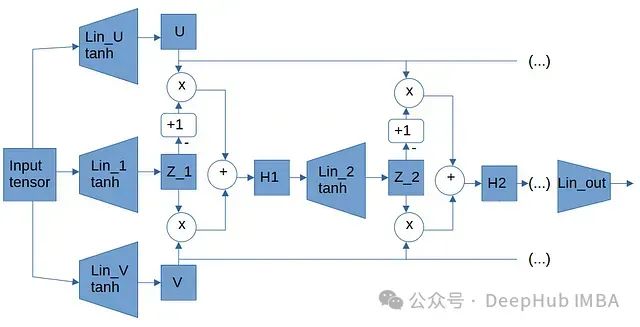

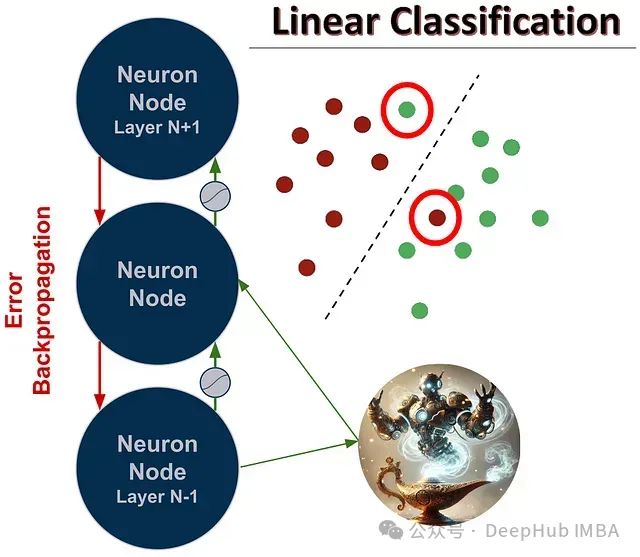

Perforated Backpropagation:神经网络优化的创新技术及PyTorch使用指南

Perforated Backpropagation技术代表了深度学习基础构建模块的重要革新,通过仿生学习机制重塑了人工神经元的计算范式。

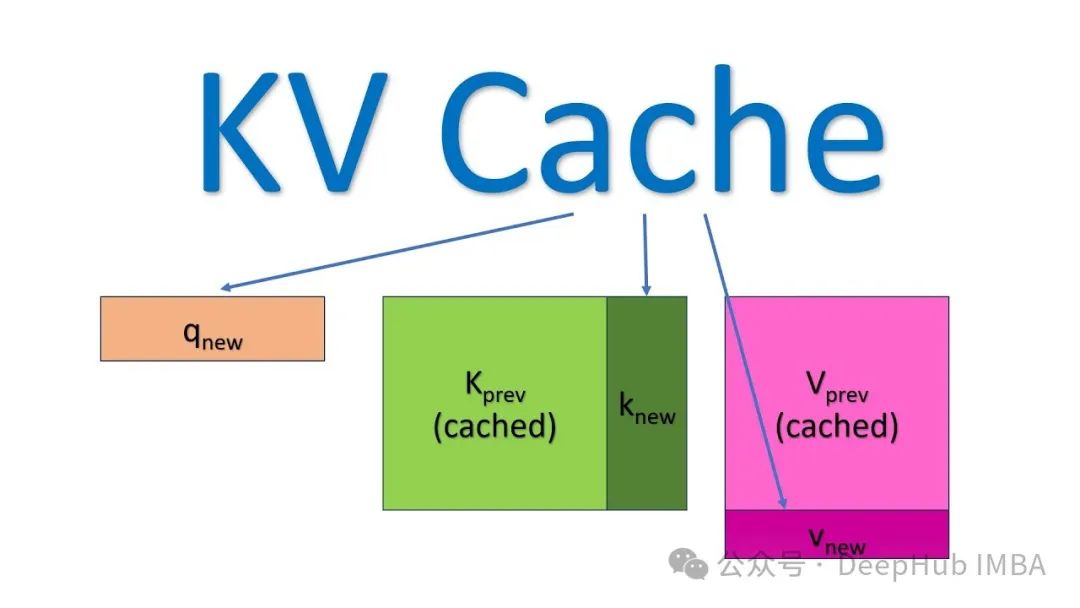

加速LLM大模型推理,KV缓存技术详解与PyTorch实现

本文详细阐述了KV缓存的工作原理及其在大型语言模型推理优化中的应用,文章不仅从理论层面阐释了KV缓存的工作原理,还提供了完整的PyTorch实现代码,展示了缓存机制与Transformer自注意力模块的协同工作方式。