广义优势估计(GAE):端策略优化PPO中偏差与方差平衡的关键技术

GAE的理论基础建立在资格迹(eligibility traces)和时序差分λ(TD-λ)之上,是近端策略优化(PPO)算法的重要基础理论

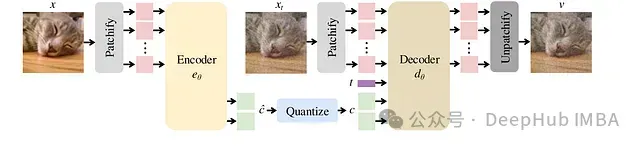

FlowMo: 模式搜索+扩散模型提升图像Token化性能

这个研究提出了FlowMo,一种基于Transformer的扩散自编码器,在多种比特率条件下实现了图像Token化的最新技术水平

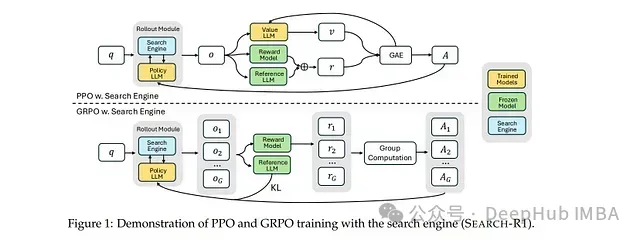

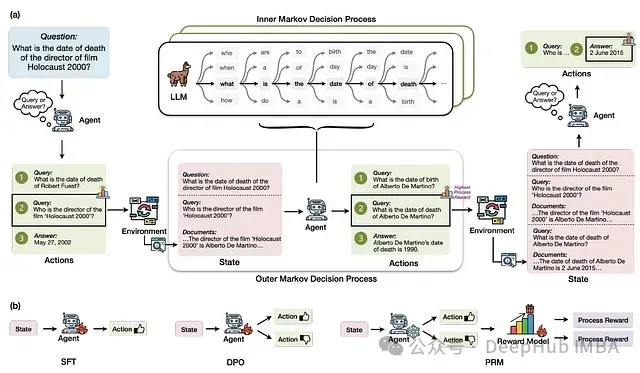

SEARCH-R1: 基于强化学习的大型语言模型多轮搜索与推理框架

该模型的核心创新在于**完全依靠强化学习机制(无需人工标注的交互轨迹)**来学习最优的搜索查询策略及基于检索知识的推理方法,从而显著提升问答任务的性能表现。

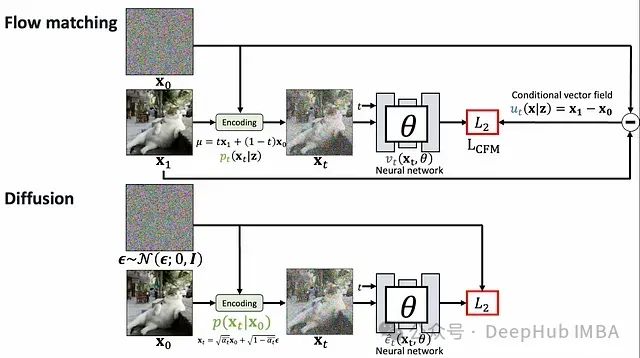

生成AI的两大范式:扩散模型与Flow Matching的理论基础与技术比较

生成模型已成为人工智能领域的关键突破,赋予机器创建高度逼真的图像、音频和文本的能力。在众多生成技术中,扩散模型和Flow Matching尤为引人注目。

融合AMD与NVIDIA GPU集群的MLOps:异构计算环境中的分布式训练架构实践

本文将深入探讨如何混合AMD/NVIDIA GPU集群以支持PyTorch分布式训练。

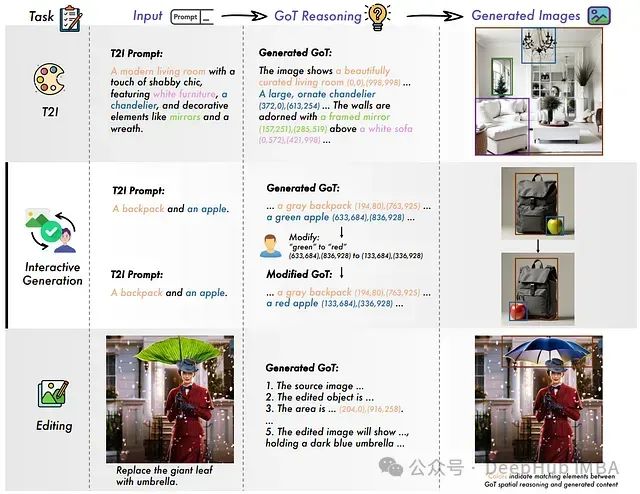

GoT:基于思维链的语义-空间推理框架为视觉生成注入思维能力

GoT框架通过引入"思维链"机制突破了这一限制,该机制在生成图像前会展开结构化推理过程。

RAG-Gym: 基于过程监督的检索增强生成代理优化框架

本文介绍了RAG-Gym框架,这是一种通过在搜索过程中实施细粒度过程监督来增强信息搜索代理的统一优化方法。

MiTS与PoTS:面向连续值时间序列的极简Transformer架构

本文详细阐述了使原始Transformer架构能够高效处理连续值时间序列数据所需的最小化结构调整方案。

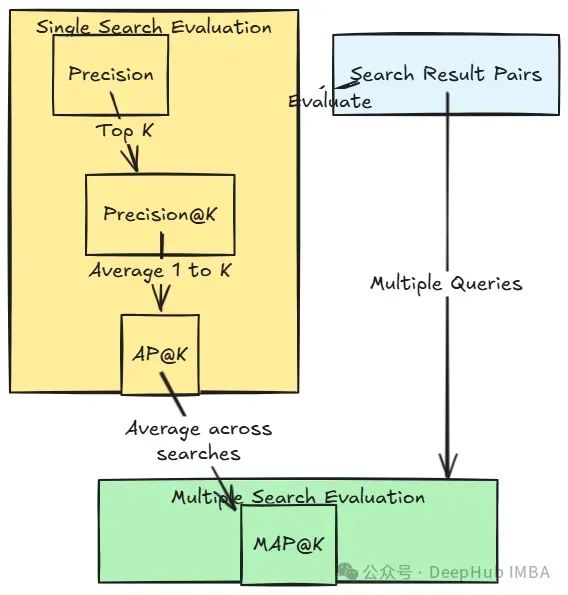

信息检索系统评估指标的层级分析:从单点精确度到整体性能度量

现代评估指标体系正是基于这些真实用户行为模式设计的,并且随着研究不断深入,评估方法也在持续演进以捕获更多细微交互特征。

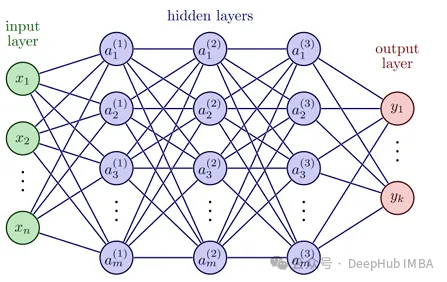

PyTorch PINN实战:用深度学习求解微分方程

PINN通过将物理定律(具体表现为微分方程)融入训练过程,显著提高了数据利用效率。

时间序列特征提取:18 种高效工具库及其应用分析

时间序列特征提取是数据科学工作流程中的关键环节,能够将原始时间序列数据转化为具有分析价值的特征表示。本文详细介绍 18 种专业的 Python 库

SigLIP 2:多语言语义理解、定位和密集特征的视觉语言编码器

SigLIP 2 是一个新型多语言视觉-语言编码器系列,通过整合基于字幕的预训练、自监督学习机制(包括自蒸馏和掩码预测)以及在线数据管理策略,对原始 SigLIP 模型进行了显著改进。

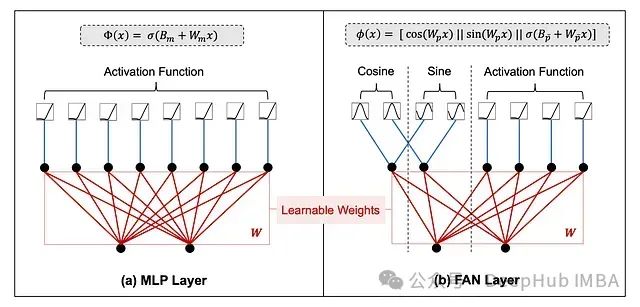

FANformer:融合傅里叶分析网络的大语言模型基础架构

FANformer通过将傅里叶分析网络(Fourier Analysis Network, FAN)整合到Transformer的注意力机制中,形成了一种创新的模型结构。

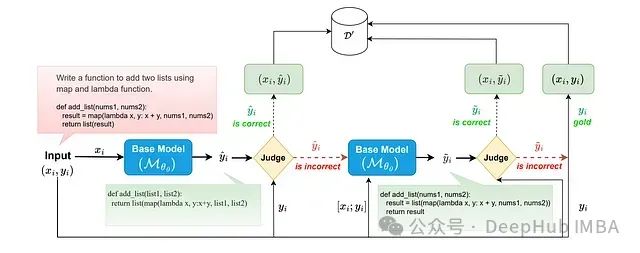

S3FT选择性自监督微调:通过智能选择训练样本提升大模型整体表现

选择性自我监督微调(Selective Self-to-Supervised Fine-Tuning,S3FT)是一种创新的大语言模型微调方法,该方法通过部署专门的语义等价性判断器来识别训练集中模型自身生成的正确响应。

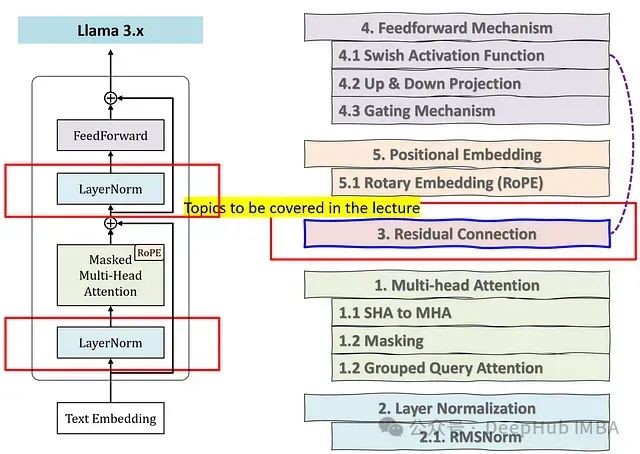

大语言模型中的归一化技术:LayerNorm与RMSNorm的深入研究

本文将系统分析归一化技术的必要性,并详细阐述为何原始Transformer架构中的LayerNorm在LLama模型中被RMSNorm所替代的技术原理。

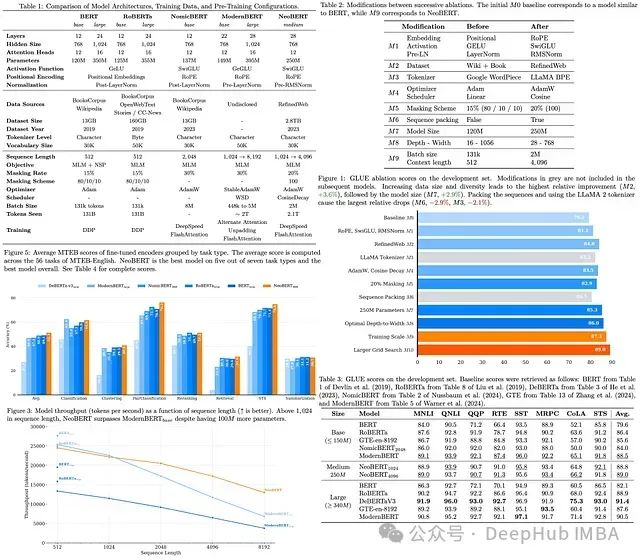

NeoBERT:4096 tokens上下文窗口,参数更少但性能翻倍

NeoBERT代表了双向编码器模型的新一代技术发展,通过整合前沿架构改进、现代大规模数据集和优化的预训练策略,有效缩小了传统编码器与高性能自回归语言模型之间的性能差距。

Chain of Draft: 借鉴人类草稿思维让大型语言模型更快地思考

这个研究探讨了大型语言模型(LLMs)在执行复杂推理任务时面临的计算资源消耗与响应延迟问题。研究特别聚焦于思维链(Chain-of-Thought, CoT)提示范式的效率局限性。

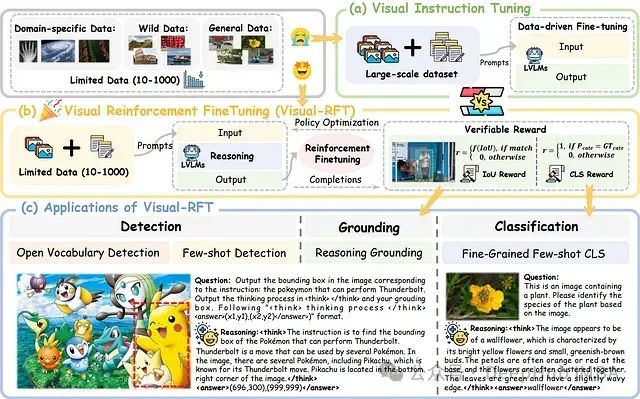

Visual-RFT:基于强化学习的视觉语言模型微调技术研究

Visual-RFT 的核心理念在于促进模型通过渐进式推理进行学习,而非简单地记忆标准答案。该方法鼓励模型生成多样化的响应并进行自主推理,随后基于答案正确性的验证信号调整学习方向。

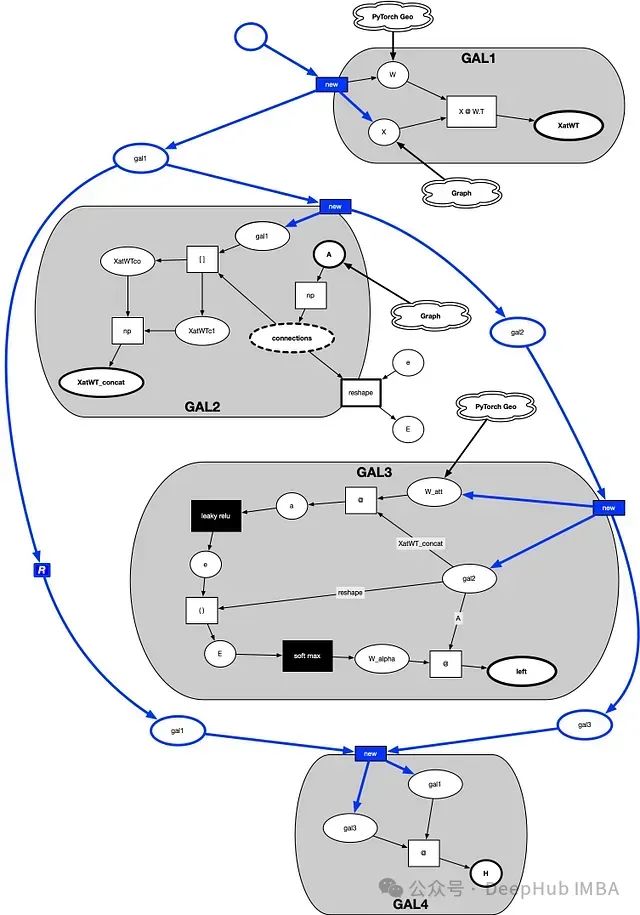

深入解析图神经网络注意力机制:数学原理与可视化实现

本文旨在通过可视化方法和数学推导,揭示图神经网络自注意力层的内部运作机制。我们将采用"位置-转移图"的概念框架,结合NumPy编程实现,一步步拆解自注意力层的计算过程,使读者能够直观理解注意力权重是如何生成并应用于图结构数据的。

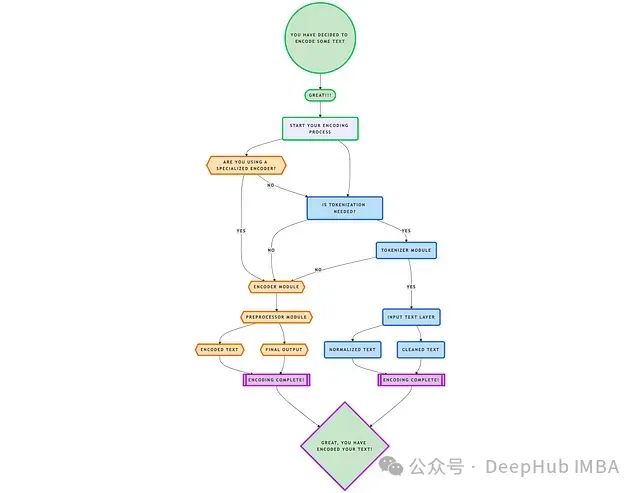

深入解析Tiktokenizer:大语言模型中核心分词技术的原理与架构

Tiktokenizer通过整合这些方法,构建了一个通用且适应性强的工具,能够应对各种文本处理场景的需求。