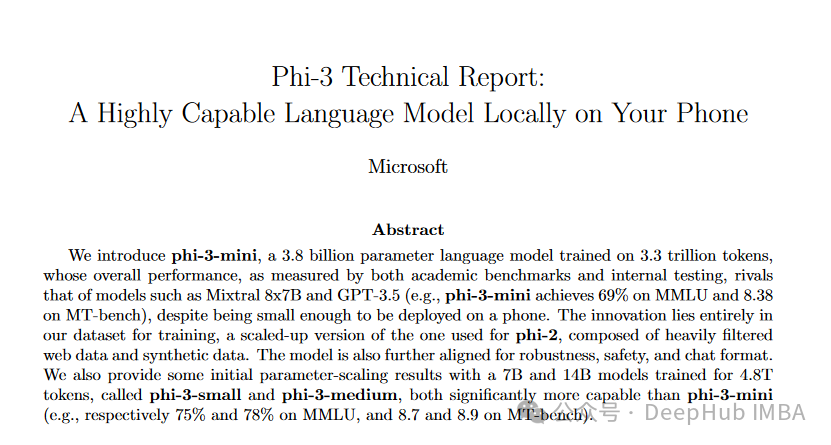

微软Phi-3,3.8亿参数能与Mixtral 8x7B和GPT-3.5相媲美,量化后还可直接在IPhone中运行

Phi-3是一系列先进的语言模型,专注于在保持足够紧凑以便在移动设备上部署的同时,实现高性能

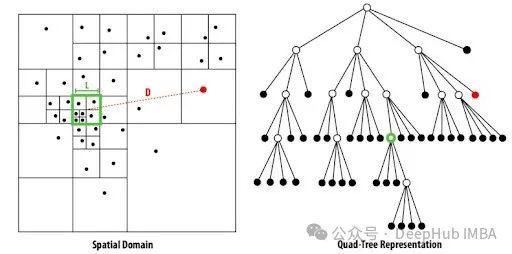

Barnes-Hut t-SNE:大规模数据的高效降维算法

Barnes-Hut t-SNE优化了原始 t-SNE 算法的计算效率,使其能够在实际应用中更为广泛地使用。

5种搭建LLM服务的方法和代码示例

在这篇文章中,我们将总结5种搭建开源大语言模型服务的方法,每种都附带详细的操作步骤,以及各自的优缺点。

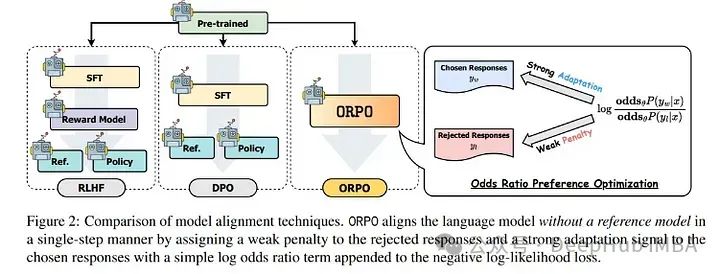

使用ORPO微调Llama 3

ORPO是一种新的微调技术,它将传统的监督微调和偏好对齐阶段结合到一个过程中。我们将使用ORPO和TRL库对新的Llama 3 8b模型进行微调。

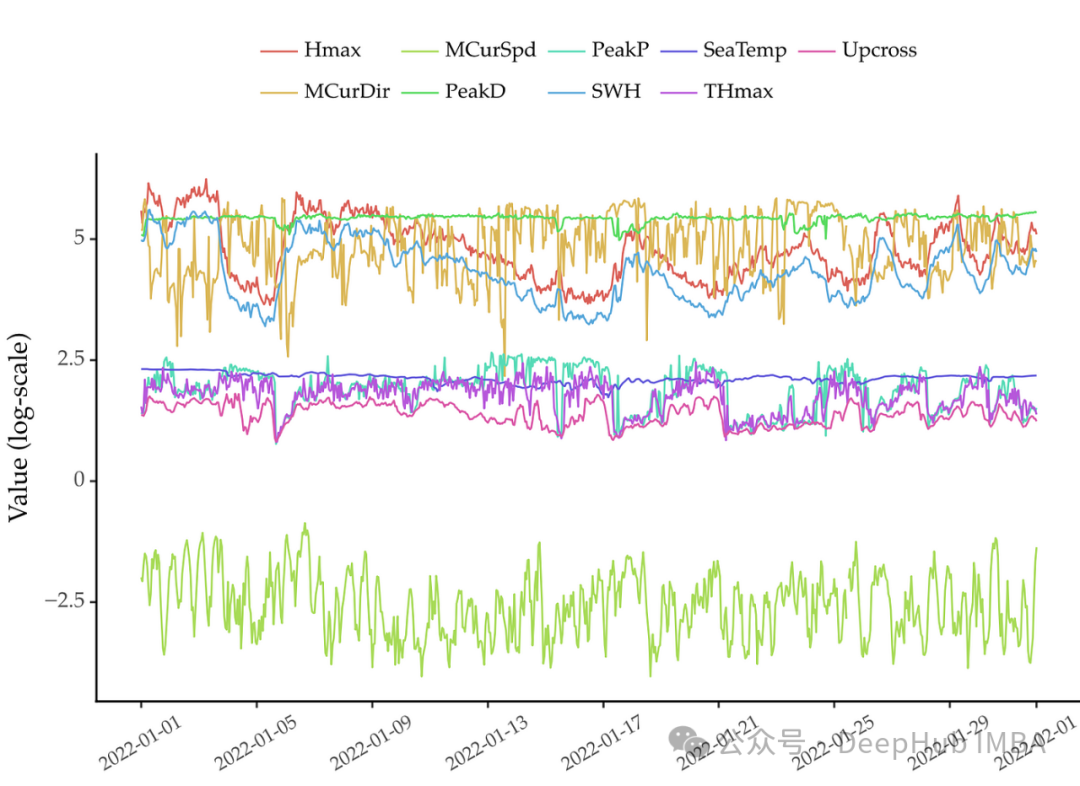

掌握时间序列特征工程:常用特征总结与 Feature-engine 的应用

本文将通过使用feature-engine来简化这些特征的提取

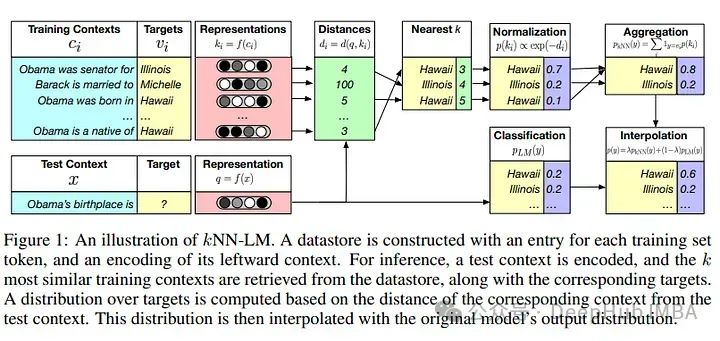

RAG 2.0架构详解:构建端到端检索增强生成系统

当前RAG的问题在于各个子模块之间并没有完全协调,就像一个缝合怪一样,虽然能够工作但各部分并不和谐,所以我们这里介绍RAG 2.0的概念来解决这个问题。

PyTorch小技巧:使用Hook可视化网络层激活(各层输出)

这篇文章将演示如何可视化PyTorch激活层。可视化激活,即模型内各层的输出,对于理解深度神经网络如何处理视觉信息至关重要,这有助于诊断模型行为并激发改进。

ORPO偏好优化:性能和DPO一样好并且更简单的对齐方法

ORPO是另一种新的LLM对齐方法,这种方法甚至不需要SFT模型。通过ORPO,LLM可以同时学习回答指令和满足人类偏好。

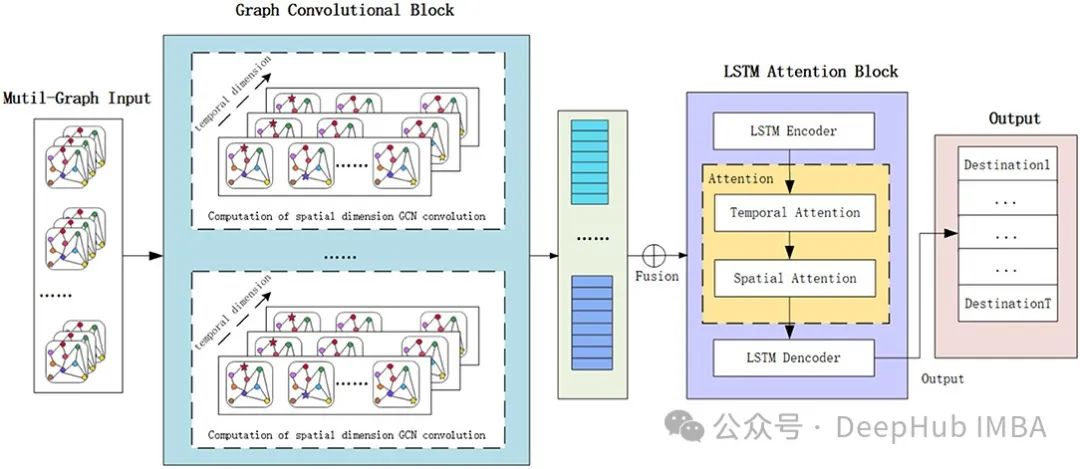

时空图神经网络ST-GNN的概念以及Pytorch实现

对于时空图神经网络Spatail-Temporal Graph来说,最简单的描述就是在原来的Graph基础上增加了时间这一个维度,也就是说我们的Graph的节点特征是会随着时间而变化的。

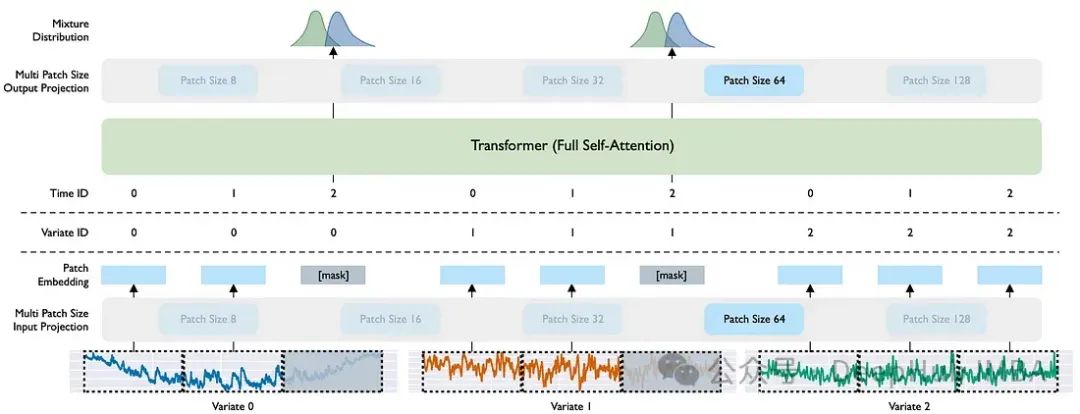

Moirai:Salesforce的时间序列预测基础模型

在本文中,我们将探索用于时间序列预测的 Salesforce 新发布的基础模型 Moirai。最后我们还对比Moirai 与其他两个基础模型之间的差异

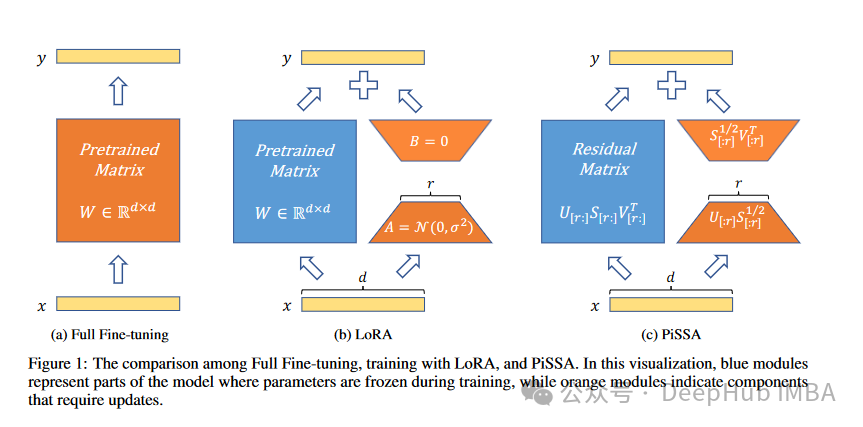

PiSSA :将模型原始权重进行奇异值分解的一种新的微调方法

我们开始看4月的新论文了,这是来自北京大学人工智能研究所、北京大学智能科学与技术学院的研究人员发布的Principal Singular Values and Singular Vectors Adaptation(PiSSA)方法。

10个大型语言模型(LLM)常见面试问题和答案解析

今天我们来总结以下大型语言模型面试中常问的问题

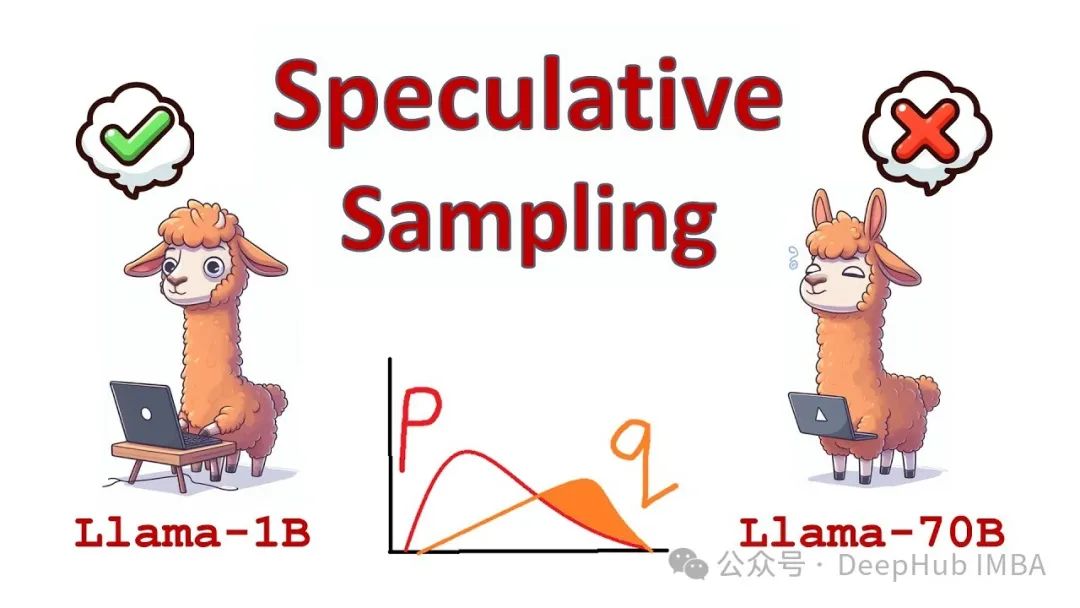

推测解码:在不降低准确性的情况下将LLM推理速度提高2 - 3倍

在本篇文章我们将详细讨论推测解码,这是一种可以将LLM推理速度提高约2 - 3倍而不降低任何准确性的方法。我们还将会介绍推测解码代码实现,并看看它与原始transformer 实现相比到底能快多少。

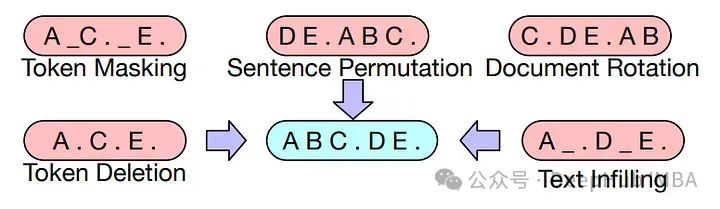

5种常用于LLM的令牌遮蔽技术介绍以及Pytorch的实现

本文将介绍大语言模型中使用的不同令牌遮蔽技术,并比较它们的优点,以及使用Pytorch实现以了解它们的底层工作原理。

为什么大型语言模型都在使用 SwiGLU 作为激活函数?

SwiGLU可以说是在大语言模型中最常用到的激活函数,我们本篇文章就来对他进行详细的介绍。

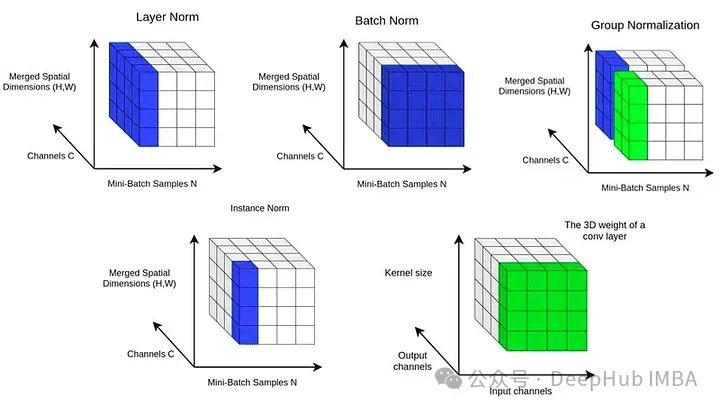

归一化技术比较研究:Batch Norm, Layer Norm, Group Norm

本文将使用合成数据集对三种归一化技术进行比较,并在每种配置下分别训练模型。记录训练损失,并比较模型的性能。

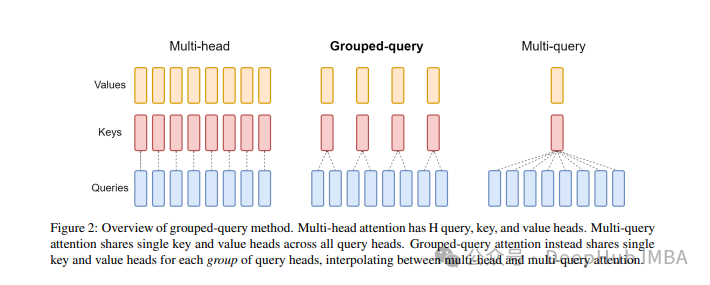

大模型中常用的注意力机制GQA详解以及Pytorch代码实现

分组查询注意力 (Grouped Query Attention) 是一种在大型语言模型中的多查询注意力 (MQA) 和多头注意力 (MHA) 之间进行插值的方法,它的目标是在保持 MQA 速度的同时实现 MHA 的质量。

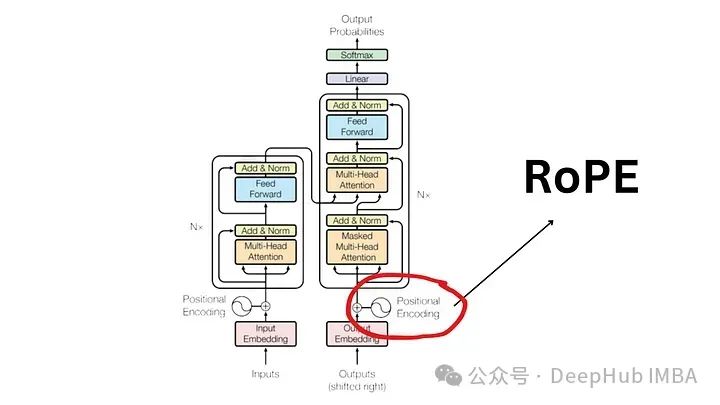

大语言模型中常用的旋转位置编码RoPE详解:为什么它比绝对或相对位置编码更好?

旋转位置嵌入是最先进的 NLP 位置嵌入技术。大多数流行的大型语言模型(如 Llama、Llama2、PaLM 和 CodeGen)已经在使用它。在本文中,我们将深入探讨什么是旋转位置编码,以及它们如何巧妙地融合绝对位置嵌入和相对位置嵌入的优点。

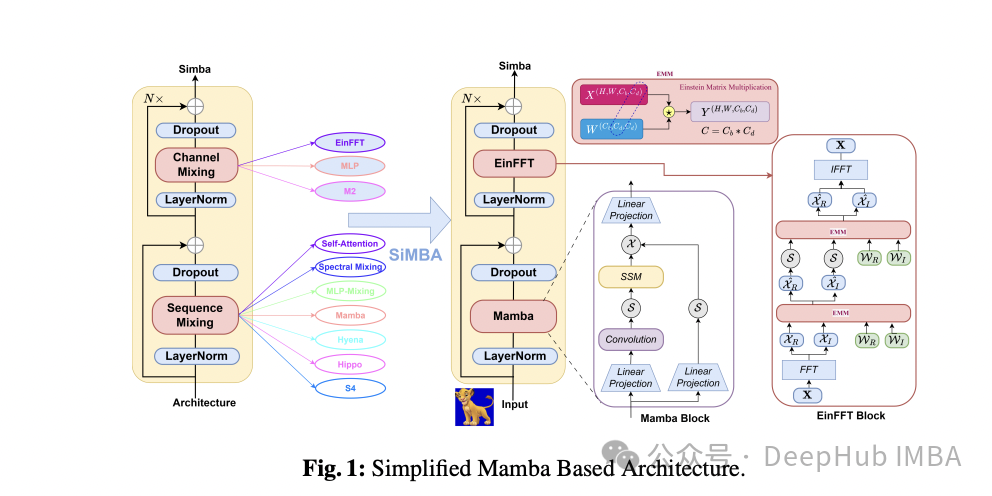

SiMBA:基于Mamba的跨图像和多元时间序列的预测模型

这是3月26日新发的的论文,微软的研究人员简化的基于mamba的体系结构,并且将其同时应用在图像和时间序列中并且取得了良好的成绩。

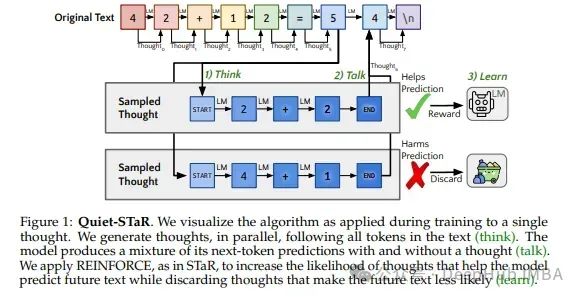

Quiet-STaR:让语言模型在“说话”前思考

本文将介绍一篇3月的论文Quiet-STaR:这是一种新的方法,通过鼓励LLM发展一种“内心独白”的形式来解决这一限制,这种基本原理生成有助于LLM通过完成任务或回答问题所涉及的步骤进行推理,最终获得更准确和结构良好的输出。