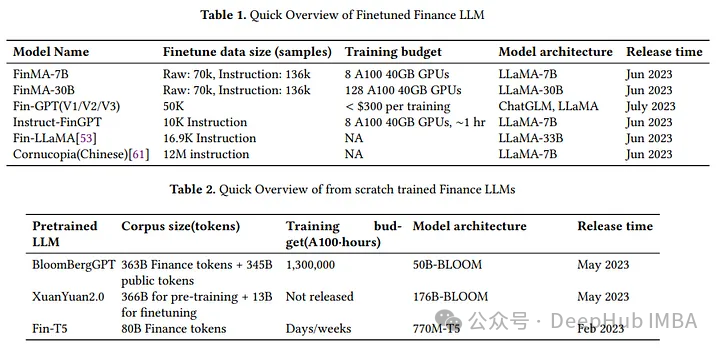

论文推荐:大语言模型在金融领域的应用调查

这篇论文总结了现有LLM在金融领域的应用现状,推荐和金融相关或者有兴趣的朋友都看看

使用核模型高斯过程(KMGPs)进行数据建模

核模型高斯过程是机器学习和统计学中对传统高斯过程的一种扩展。要理解kmgp,首先掌握高斯过程的基础知识,然后了解核模型是如何发挥作用的。

2024年1月的论文推荐

又到月底了,在月初推荐论文的基础上又整理了10篇推荐阅读的论文

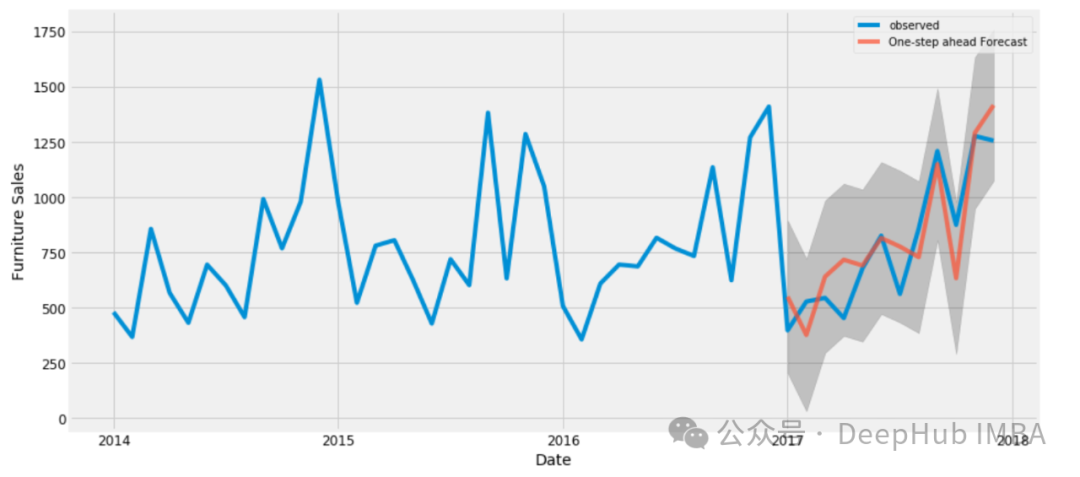

使用Transformer 模型进行时间序列预测的Pytorch代码示例

本文可以作为学习使用Transformer 模型的时间序列预测的一个起点。

使用mergekit 合并大型语言模型

在本文中我们将介绍各种合并算法,研究如何实现它们,并深入研究它们的工作原理。还将使用mergekit工具合并Mistral、WizardMath和CodeLlama模型。

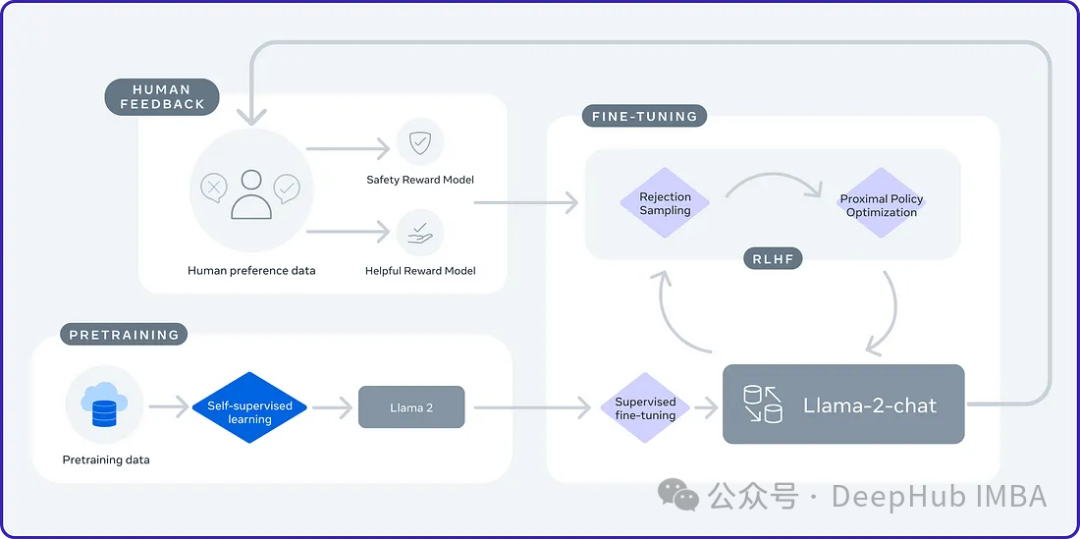

Mistral AI vs. Meta:顶级开源LLM比较

本文将比较Mistral 7B vs Llama 2 7B and Mixtral 8x7B vs Llama 2 70B

通过4个任务比较LangChain和LlamaIndex

LlamaIndex和LangChain是构建LLM应用程序的两个框架。LlamaIndex专注于RAG用例,LangChain得到了更广泛的应用。

Vision Mamba:将Mamba应用于计算机视觉任务的新模型

Mamba是LLM的一种新架构,与Transformers等传统模型相比,它能够更有效地处理长序列。就像VIT一样现在已经有人将他应用到了计算机视觉领域

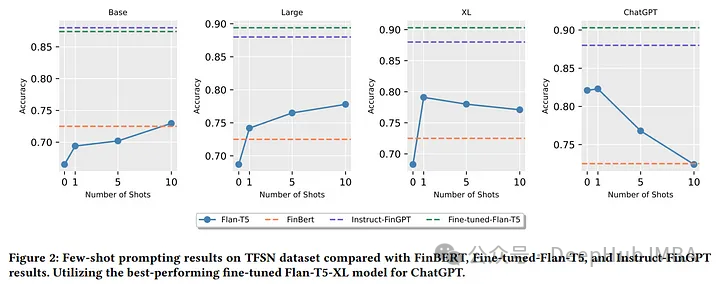

针对特定领域较小的语言模型是否与较大的模型同样有效?

作者全面分析了微调大语言模型(llm)及其在金融情绪分析中的零样本和少样本的能力。

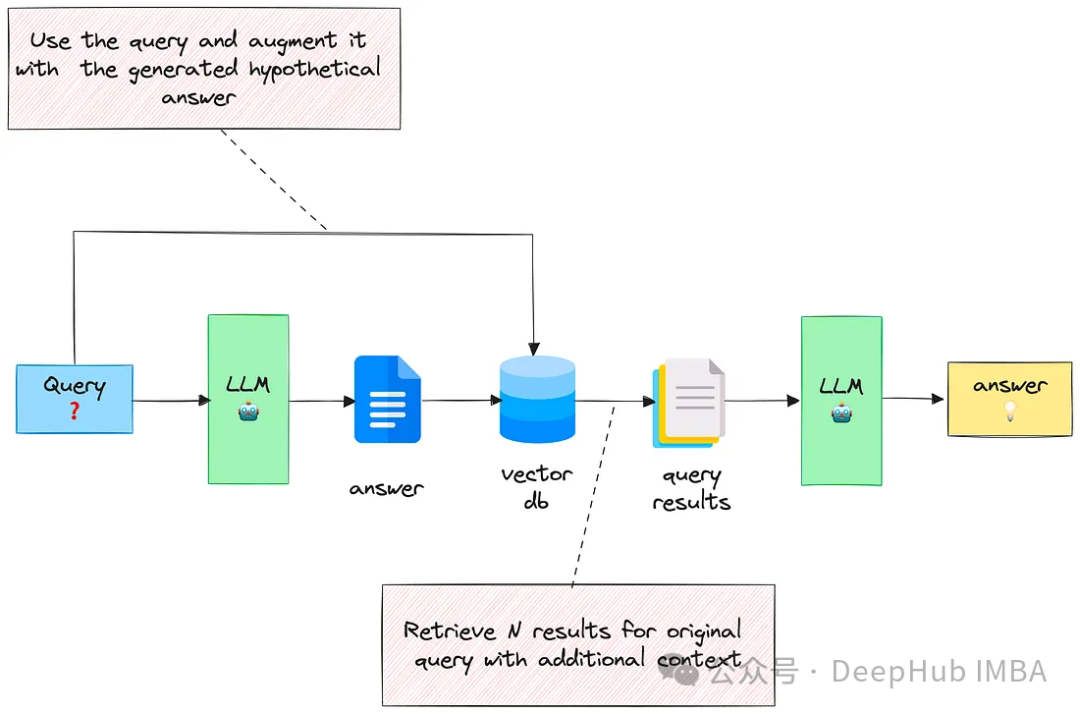

RAG中的3个高级检索技巧

本文将探讨三种有效的技术来增强基于rag的应用程序中的文档检索,通过结合这些技术,可以检索与用户查询密切匹配的更相关的文档,从而生成更好的答案。

4种通过LLM进行文本知识图谱的构建方法对比介绍

本文将介绍和比较使用LLM转换非结构化文本的四种方法,这些方法在不同的场景中都可能会用到。

使用SPIN技术对LLM进行自我博弈微调训练

SPIN从AlphaGo Zero和AlphaZero等游戏中成功的自我对弈机制中汲取灵感。它能够使LLM参与自我游戏的能力。

Tokenization 指南:字节对编码,WordPiece等方法Python代码详解

计算机要处理语言,首先需要将文本转换成数字形式。这个过程由一个称为标记化 Tokenization。

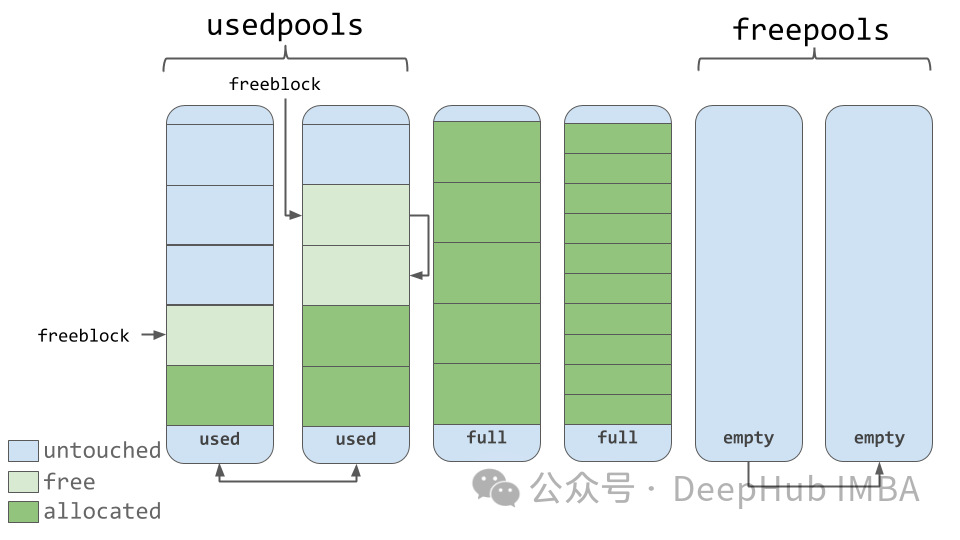

提高代码效率的6个Python内存优化技巧

有许多方法可以显著优化Python程序的内存使用,这些方法可能在实际应用中并没有人注意,所以本文将重点介绍Python的内置机制,掌握它们将大大提高Python编程技能。

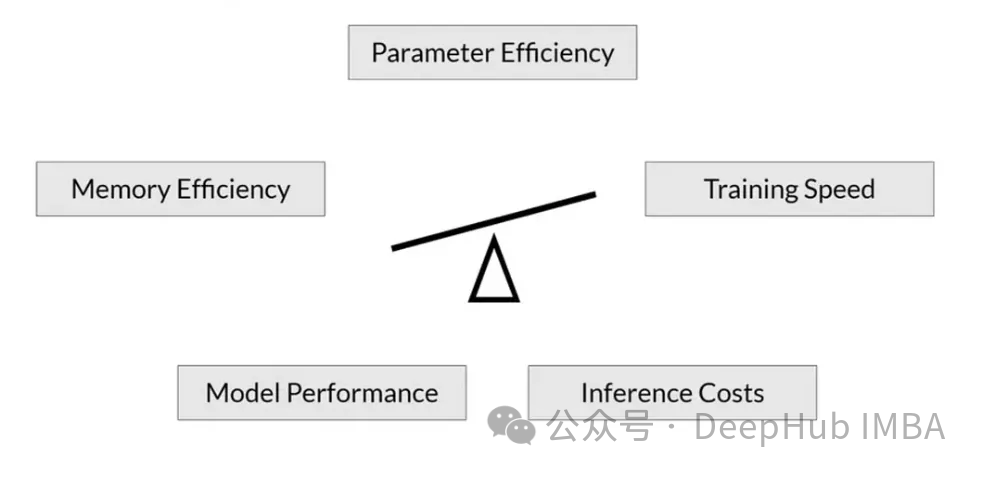

RoSA: 一种新的大模型参数高效微调方法

随着语言模型不断扩展到前所未有的规模,对下游任务的所有参数进行微调变得非常昂贵,PEFT方法已成为自然语言处理领域的研究热点。PEFT方法将微调限制在一小部分参数中,以很小的计算成本实现自然语言理解任务的最先进性能。

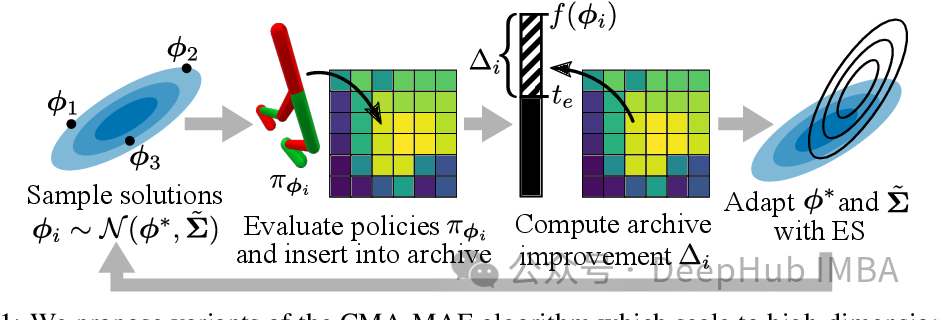

基于协方差矩阵自适应演化策略(CMA-ES)的高效特征选择

特征选择是指从原始特征集中选择一部分特征,以提高模型性能、减少计算开销或改善模型的解释性。

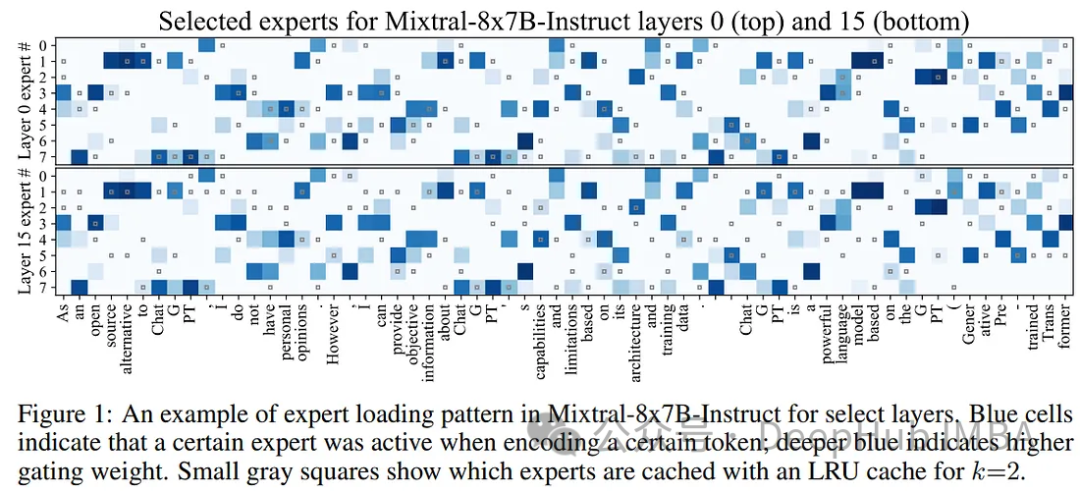

使用Mixtral-offloading在消费级硬件上运行Mixtral-8x7B

在本文中,将解释Mixtral-offloading的工作过程,使用这个框架可以节省内存并保持良好的推理速度,我们将看到如何在消费者硬件上运行Mixtral-8x7B,并对其推理速度进行基准测试。

在Colab上测试Mamba

本文整理了一个能够在Colab上完整运行Mamba代码,代码中还使用了Mamba官方的3B模型来进行实际运行测试。

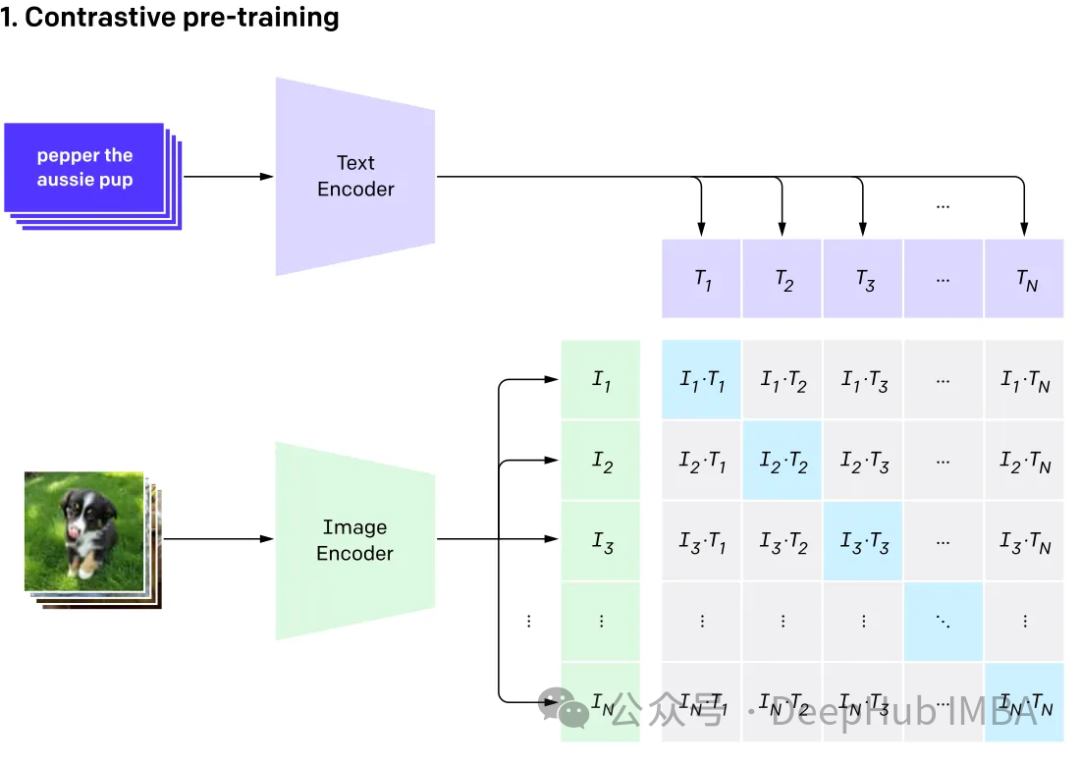

使用CLIP和LLM构建多模态RAG系统

在本文中我们将探讨使用开源大型语言多模态模型(Large Language Multi-Modal)构建检索增强生成(RAG)系统。本文的重点是在不依赖LangChain或LLlama index的情况下实现这一目标,这样可以避免更多的框架依赖。