又到月底了,在月初推荐论文的基础上又整理了10篇推荐阅读的论文

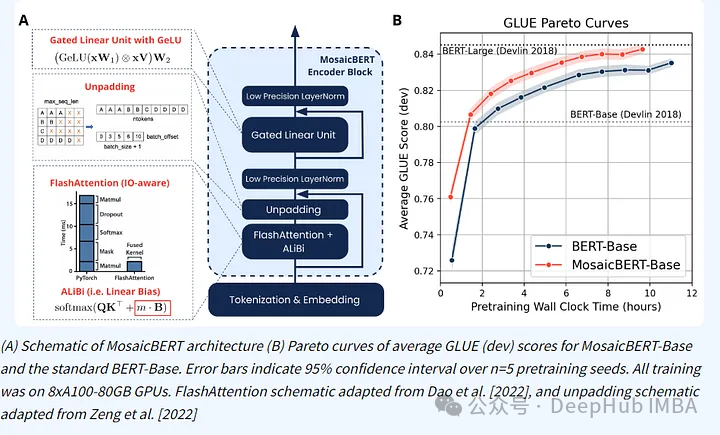

1、MosaicBERT

一种用于快速预训练的双向编码器。MosaicBERT是针对快速预训练优化的自定义BERT架构。主要架构修改:FlashAttention, ALiBi,门控线性单元和低精度的LayerNorm。

2、Improving Text Embeddings with Large Language Models.

https://arxiv.org/abs/2401.00368

微软研究人员训练了一个基于Mistral的纯解码器,他们使用GPT-4和两步提示技术创建了合成检索训练数据。

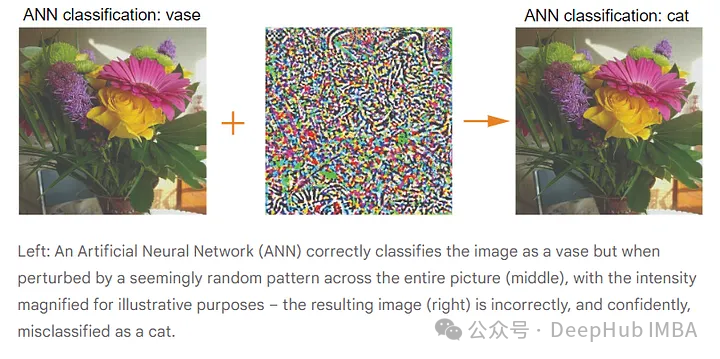

3、Images altered to trick machine vision can influence humans too

为了欺骗机器视觉而改变的图像也可以影响人类。新的研究表明,即使是为了迷惑计算机视觉系统而对数字图像进行的细微改变,也会影响人类的感知,这个研究很有意思。

4、Boundary Attention: Learning to Find Faint Boundaries at Any Resolution.

https://arxiv.org/abs/2401.00935

识别图像中的边缘和曲线是传统的计算机视觉挑战。但是当引入噪声、质量变化或分布外实例时,许多现有的方法表现不佳。这种新发现的方法只有207k个参数并且在传感器读数上工作得非常好。

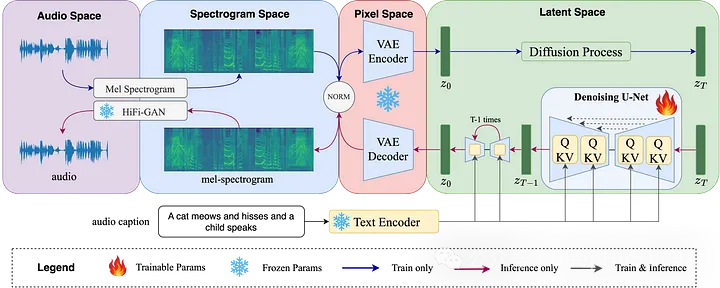

5、Auffusion: Leveraging the Power of Diffusion and Large Language Models for Text-to-Audio Generation

利用扩散和大型语言模型进行文本到音频的生成。受文本到图像扩散模型的启发,Auffusion系统在文本到音频(TTA)创作方面取得了突破。它非常擅长将文本转换成高质量的音频,尤其是复杂的输入。

6、Context-Aware Interaction Network for RGB-T Semantic Segmentation

https://arxiv.org/abs/2401.01624v1

CAINet是研究人员开发的一种用于改进RGB-T语义分割的创新技术,这对自动驾驶至关重要。该系统以独特的方式混合了许多数据类型,强调了每种数据形式的互补性。

7、RAG makes LLMs better and equal

https://www.pinecone.io/blog/rag-study/

一项研究评估了在检索增强生成(RAG)任务中开源语言模型与闭源等效模型的性能。关键研究结果表明,GPT4-Turbo优于其他方法,而Mixtral-8x7B的性能与GPT3.5-turbo相当,即使在超过10亿个块的庞大数据集上,RAG方法的有效性仍然保持稳健。

8、Transformers are Multi-State RNNs

https://arxiv.org/abs/2401.06104

Transformers是多状态rnn。新的研究表明,只有解码器的Transformers可以类似于具有无限隐藏状态的rnn,或者作为具有特定数量隐藏状态的有限rnn。

9、Scalable Pre-training of Large Autoregressive Image Models.

https://arxiv.org/abs/2401.08541

苹果发布了一项研究,详细介绍了被称为AIM的自回归视觉模型的开发,该模型显示了类似于llm的缩放特征。这些模型已经证明,它们的性能随着模型大小和数据量的增加而提高。

10、Quantifying Language Models’ Sensitivity to Spurious Features in Prompt Design or: How I learned to start worrying about prompt formatting

https://arxiv.org/abs/2310.11324

目前的大语言模型对提示格式非常敏感,如果修改提示,在不影响含义的情况下显示出显著的性能变化。尽管模型大小或样本数量增加,这种敏感性仍然存在。所以论文建议对具有不同提示格式的模型进行评估,以准确衡量其能力,因为具有统一提示格式的模型之间缺乏性能相关性,这对直接模型比较的有效性提出了挑战。