使用‘消除’技术绕过LLM的安全机制,不用训练就可以创建自己的nsfw模型

在本文中,我们将探索一种称为“abliteration”的技术,它可以在不进行再训练的情况下取消LLM审查。这种技术有效地消除了模型的内置拒绝机制,允许它响应所有类型的提示。

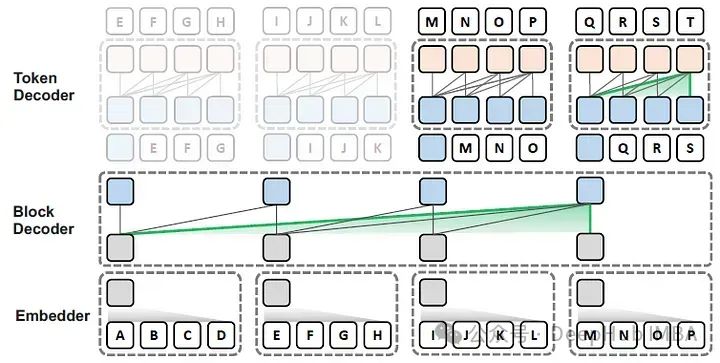

Block Transformer:通过全局到局部的语言建模加速LLM推理

在这篇论文中,作者提出了Block Transformer架构,该架构通过在较低层次之间的粗糙块(每个块代表多个令牌)的自注意力来模拟全局依赖性,并在较高层次的每个局部块内解码细粒度的令牌,

创造未来知识管理新篇章:Ollama与AnythingLLM联手打造个人与企业的安全知识库!

Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型。通过简单的安装指令,用户可以执行一条命令就在本地运行开源大型语言模型,如Llama 2。Ollama极大地简化了在Docker容器内部署和管理LLM的过程,使得用户能够快速地在本地运行大型语言模型。打造个性化聊天机器人:用

从提示工程到代理工程:构建高效AI代理的策略框架概述

本框架旨在提供一个实用的思维模型,虽不全面,但足以作为一个起点,随后可根据实际需要进行细化和扩展。

为什么你的RAG不起作用?失败的主要原因和解决方案

本文的目标是揭示普通RAG失败的主要原因,并提供具体策略和方法,使您的RAG更接近生产阶段。

LLMs之Dify:Dify的简介、安装和使用方法、案例应用之详细攻略

LLMs之Dify:Dify的简介、安装和使用方法、案例应用之详细攻略目录Dify的简介Dify的安装和使用方法Dify的案例应用Dify的简介2023年5月,Dify正式发布,这是一个开源的LLM应用程序开发平台。它直观的界面结合了人工智能工作流程、RAG管道、代理能力、模型管理、可观察性特性等

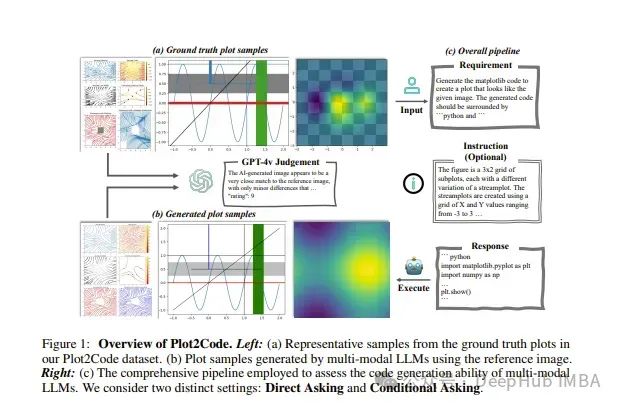

2024年5月第四周LLM重要论文总结

本文总结了2024年5月第四周发表的一些最重要的LLM论文。这些论文的主题包括模型优化和缩放到推理、基准测试和增强性能。

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

论文详细研究了一个经过微调的模型会发生什么,以及它在获得新知识后的反应会发生什么。

2024年5月大语言模型论文推荐:模型优化、缩放到推理、基准测试和增强性能

这篇文章将要总结了2024年5月发表的一些最重要的大语言模型的论文。这些论文涵盖了塑造下一代语言模型的各种主题,从模型优化和缩放到推理、基准测试和增强性能。

整合LlamaIndex与LangChain构建高级的查询处理系统

本篇文章将介绍如何将LlamaIndex和LangChain整合使用,创建一个既可扩展又可定制的代理RAG(Retrieval-Augmented Generation)应用程序,利用两种技术的强大功能,开发出能够处理复杂查询并提供精准答案的高效应用程序。

DeepSparse: 通过剪枝和稀疏预训练,在不损失精度的情况下减少70%的模型大小,提升三倍速度

这篇论文提出了一种高稀疏性基础大型语言模型(LLMs)的新方法,通过有效的预训练和部署,实现了模型在保持高准确度的同时,显著提升了处理速度。

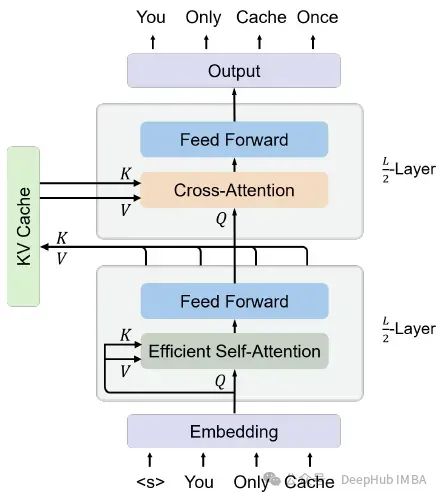

You Only Cache Once:YOCO 基于Decoder-Decoder 的一个新的大语言模型架构

这是微软再5月刚刚发布的一篇论文提出了一种解码器-解码器架构YOCO,因为只缓存一次KV对,所以可以大量的节省内存。

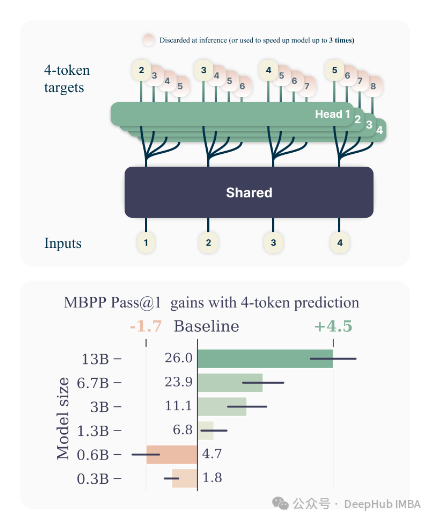

论文推荐:用多词元预测法提高模型效率与速度

作者们提出了一种创新的多词元预测方法,该方法在提高大型语言模型(LLMs)的样本效率和推理速度方面展示了显著优势。

LLM2Vec介绍和将Llama 3转换为嵌入模型代码示例

通过LLM2Vec,我们可以使用LLM作为文本嵌入模型。但是简单地从llm中提取的嵌入模型往往表现不如常规嵌入模型

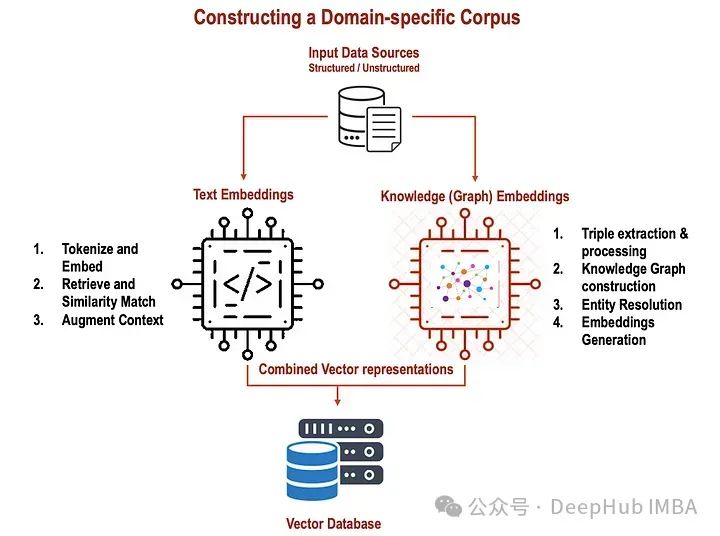

整合文本和知识图谱嵌入提升RAG的性能

在RAG模型中,文本嵌入和知识嵌入都允许对输入文本和结构化知识进行更全面、上下文更丰富的表示。这种集成增强了模型在答案检索、答案生成、对歧义的鲁棒性和结构化知识的有效结合方面的性能,最终导致更准确和信息丰富的响应。

如何准确的估计llm推理和微调的内存消耗

在本文中,我将介绍如何计算这些模型用于推理和微调的最小内存。这种方法适用于任何的llm,并且精确的计算内存总消耗。

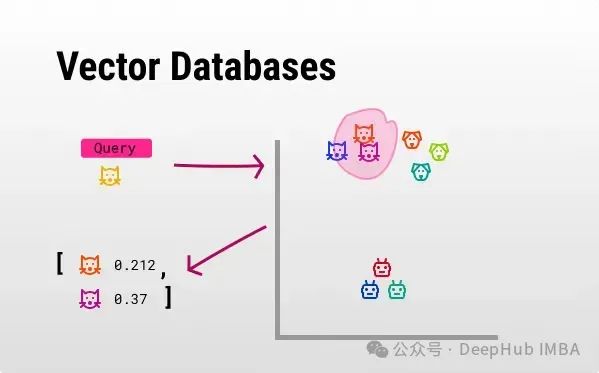

开源向量数据库比较:Chroma, Milvus, Faiss,Weaviate

本文为你提供四个重要的开源向量数据库之间的全面比较,希望你能够选择出最符合自己特定需求的数据库。

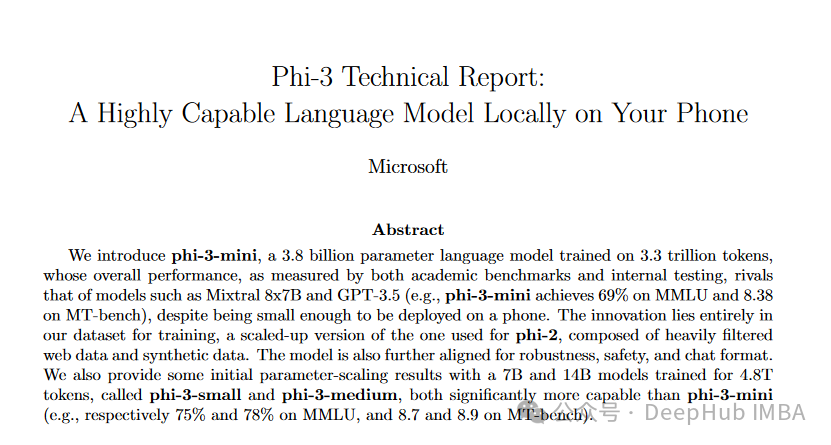

微软Phi-3,3.8亿参数能与Mixtral 8x7B和GPT-3.5相媲美,量化后还可直接在IPhone中运行

Phi-3是一系列先进的语言模型,专注于在保持足够紧凑以便在移动设备上部署的同时,实现高性能

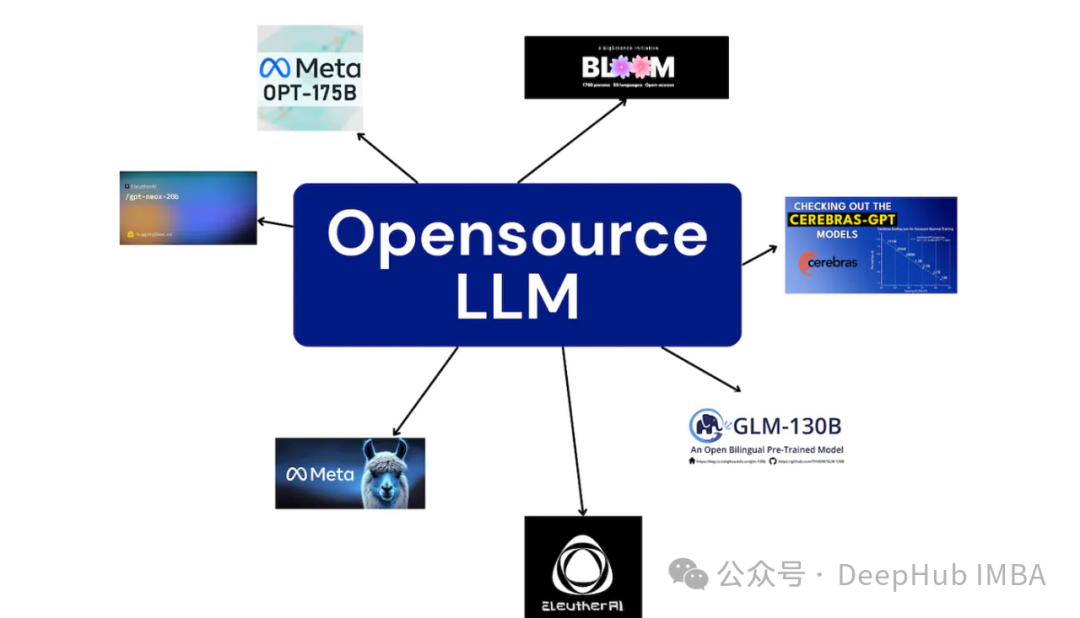

5种搭建LLM服务的方法和代码示例

在这篇文章中,我们将总结5种搭建开源大语言模型服务的方法,每种都附带详细的操作步骤,以及各自的优缺点。

使用ORPO微调Llama 3

ORPO是一种新的微调技术,它将传统的监督微调和偏好对齐阶段结合到一个过程中。我们将使用ORPO和TRL库对新的Llama 3 8b模型进行微调。