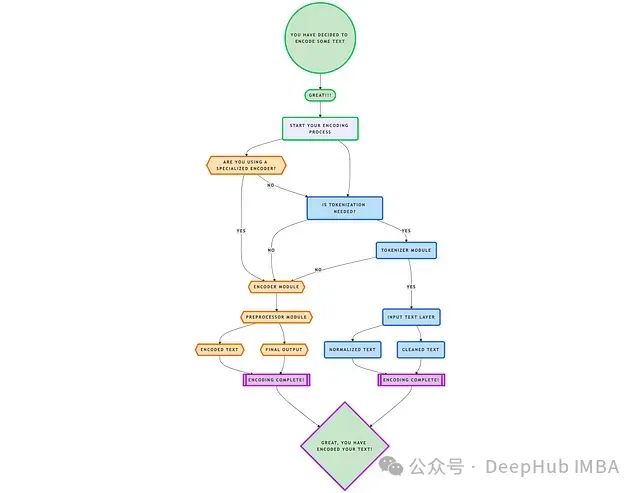

深入解析Tiktokenizer:大语言模型中核心分词技术的原理与架构

Tiktokenizer通过整合这些方法,构建了一个通用且适应性强的工具,能够应对各种文本处理场景的需求。

LLM模型添加自定义Token代码示例:为Llama 3.2模型添加思考与回答标记

本文将介绍如何为大型语言模型(LLM)添加自定义token并进行训练,使模型能够有效地利用这些新增token。

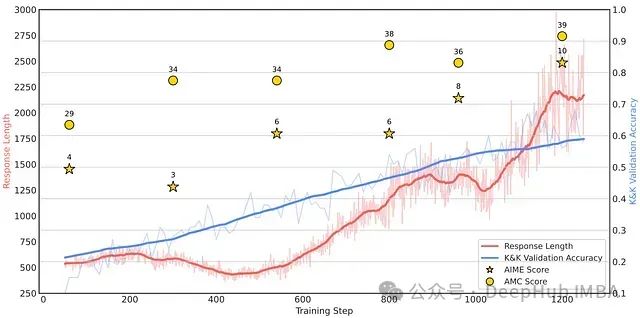

Logic-RL: 小模型也能强推理,通过基于规则的强化学习提升大语言模型结构化推理能力

这篇论文探讨了基于规则的强化学习(RL)如何解锁LLM中的高级推理能力。通过在受控的逻辑谜题上进行训练并强制执行结构化的思考过程,即使是相对较小的模型也能开发出可转移的问题解决策略。

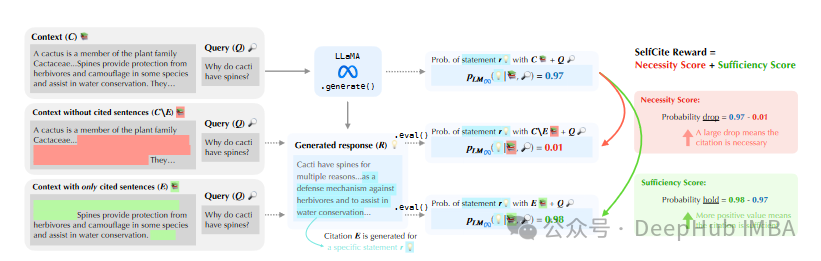

SelfCite: 通过自监督奖励提升LLM对上下文内容的引用质量

SelfCite 提出了一种新颖的自监督方法,通过上下文消融技术和自监督奖励机制,提升大型语言模型 (LLM) 对上下文内容的引用质量,生成更准确、更可靠的句子级别引用,从而提高基于上下文的生成任务的整体性能。

SmolLM2:多阶段训练策略优化和高质量数据集,小型语言模型同样可以实现卓越的性能表现

,SmolLM2 通过创新的多阶段训练策略、高质量数据集的构建与优化,以及精细的模型后训练调优,在 1.7B 参数规模下实现了卓越的性能表现,并在多个基准测试中超越了同等规模甚至更大规模的语言模型。

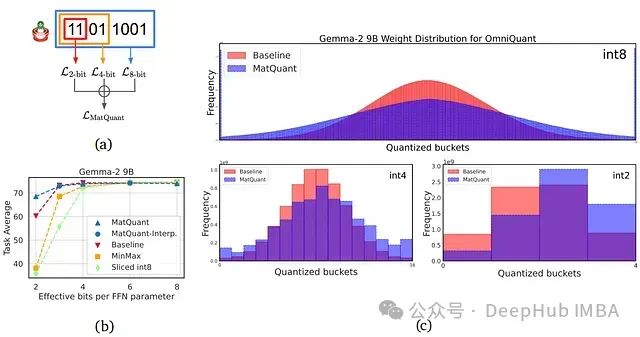

DeepMind发布Matryoshka(套娃)量化:利用嵌套表示实现多精度LLM的低比特深度学习

本文将介绍 Google DeepMind 提出的 Matryoshka 量化技术,该技术通过从单个大型语言模型 (LLM) 实现多精度模型部署,从而革新深度学习。我们将深入研究这项创新技术如何提高 LLM 的效率和准确性。

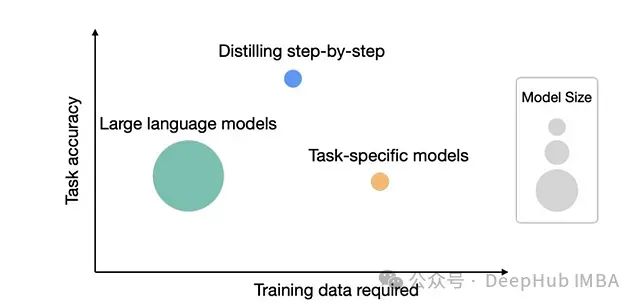

知识蒸馏方法探究:Google Distilling Step-by-Step 论文深度分析

Google Research 团队发表的论文《Distilling Step-by-Step!》提出了一种创新的知识蒸馏方法,不仅能有效减小模型规模,还能使学生模型在某些任务上超越其教师模型。

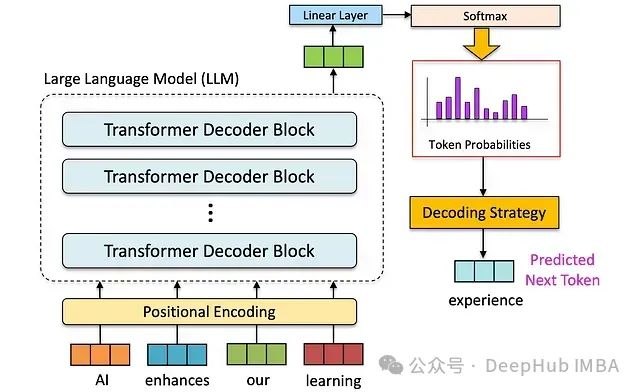

大语言模型的解码策略与关键优化总结

本文系统性地阐述了大型语言模型(Large Language Models, LLMs)中的解码策略技术原理及其实践应用。

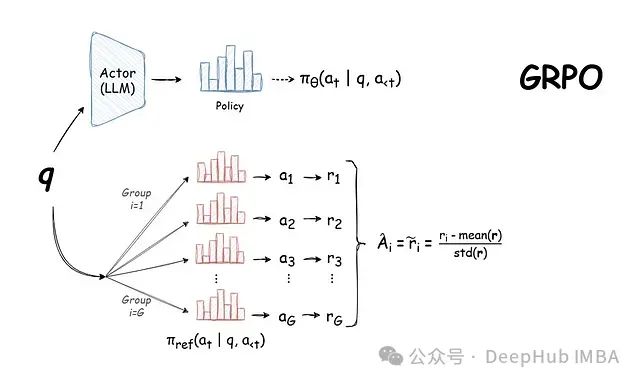

DeepSeek 背后的技术:GRPO,基于群组采样的高效大语言模型强化学习训练方法详解

本文将深入分析 GRPO 的工作机制及其在语言模型训练领域的重要技术突破,并探讨其在实际应用中的优势与局限性。

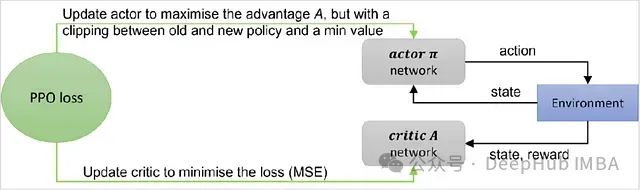

近端策略优化(PPO)算法的理论基础与PyTorch代码详解

近端策略优化(Proximal Policy Optimization, PPO)算法作为一种高效的策略优化方法,在深度强化学习领域获得了广泛应用。特别是在大语言模型(LLM)的人类反馈强化学习(RLHF)过程中,PPO扮演着核心角色。本文将深入探讨PPO的基本原理和实现细节。

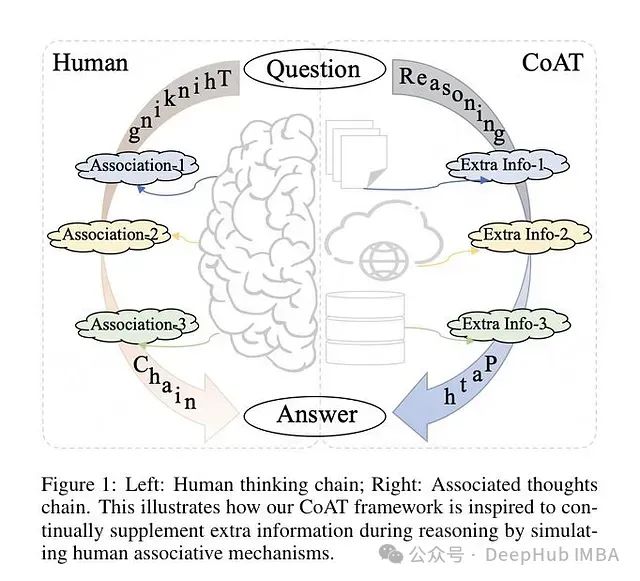

CoAT: 基于蒙特卡洛树搜索和关联记忆的大模型推理能力优化框架

研究者提出了一种新的关联思维链(Chain-of-Associated-Thoughts, CoAT)方法,该方法通过整合蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)和关联记忆机制来提升大语言模型(LLMs)的推理能力。

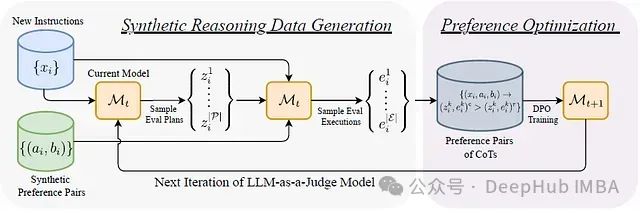

EvalPlanner:基于“计划-执行”双阶段的大语言模型评估框架

EvalPlanner[1],这是一种创新的LLM评估算法。该算法采用计划-执行的双阶段范式,首先生成无约束的评估计划,随后执行该计划并做出最终判断。这种方法显著提升了评估过程的系统性和可靠性。

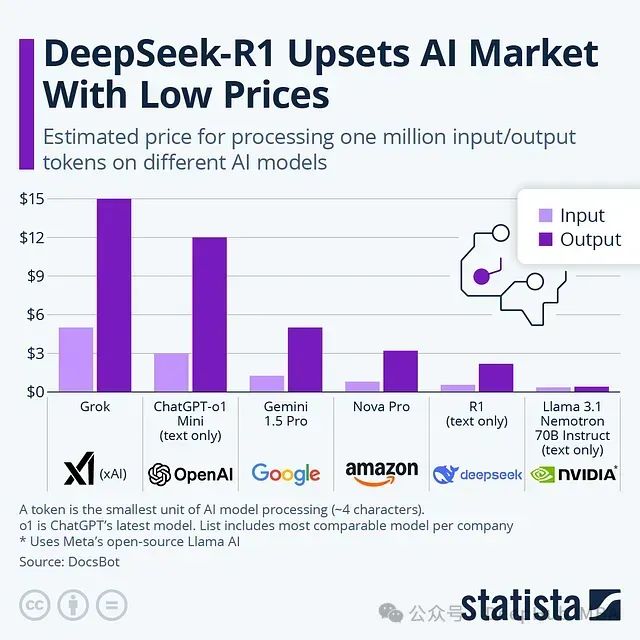

DeepSeek技术报告解析:为什么DeepSeek-R1 可以用低成本训练出高效的模型

DeepSeek-R1 通过创新的训练策略实现了显著的成本降低,同时保持了卓越的模型性能。本文将详细分析其核心训练方法。

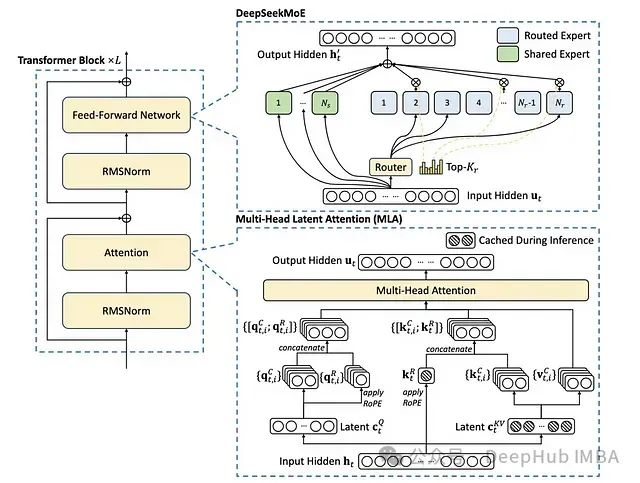

DeepSeek背后的技术基石:DeepSeekMoE基于专家混合系统的大规模语言模型架构

DeepSeekMoE是一种创新的大规模语言模型架构,通过整合专家混合系统(Mixture of Experts, MoE)、改进的注意力机制和优化的归一化策略,在模型效率与计算能力之间实现了新的平衡。

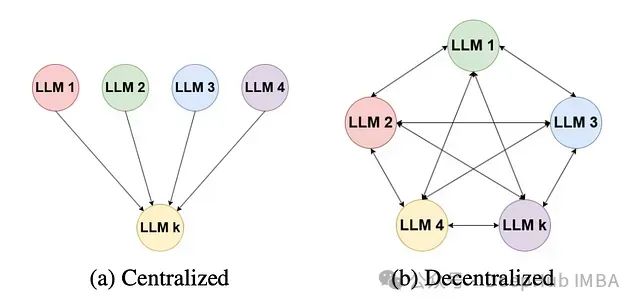

面向长文本的多模型协作摘要架构:多LLM文本摘要方法

论文提出的方法旨在处理长文本文档输入,这类文档可能包含数万字,通常超出大多数标准LLM的上下文窗口限制,论文建立了一个两阶段处理流程

Meta-CoT:通过元链式思考增强大型语言模型的推理能力

Meta-CoT 基于链式思考(CoT)方法,使 LLMs 不仅能够建模推理步骤,还能够模拟“思考”过程。这种转变类似于人类在面对难题时的探索、评估和迭代方式。

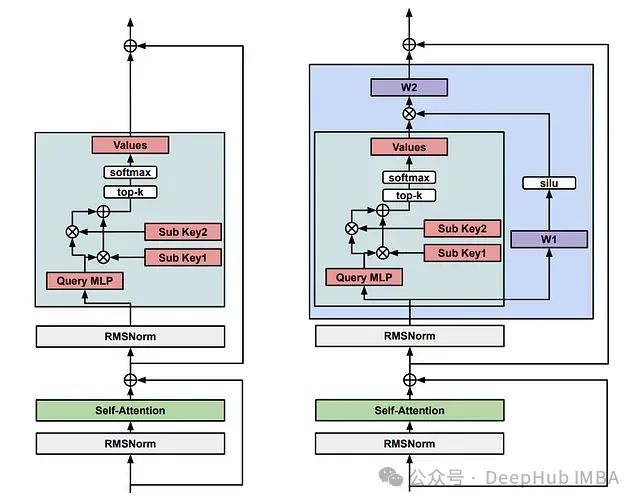

记忆层增强的 Transformer 架构:通过可训练键值存储提升 LLM 性能的创新方法

Meta 研究团队通过开发**记忆层**技术,成功实现了对现有大语言模型的性能提升。该技术通过替换一个或多个 Transformer 层中的前馈网络(FFN)来实现功能。

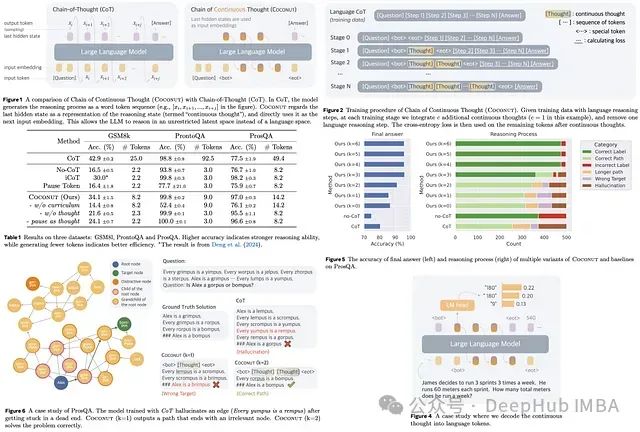

Coconut:基于连续潜在空间推理,提升大语言模型推理能力的新方法

Coconut的核心机制是在"语言模式"和"潜在模式"之间进行动态切换。语言模式下,模型采用标准语言模型的自回归方式生成token序列。

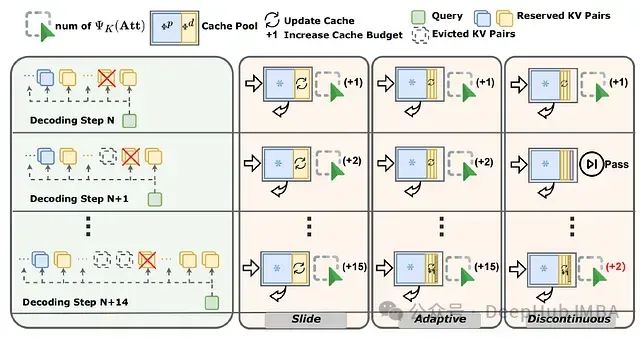

SCOPE:面向大语言模型长序列生成的双阶段KV缓存优化框架

SCOPE框架通过分离预填充与解码阶段的KV缓存优化策略,实现了高效的缓存管理。该框架保留预填充阶段的关键KV缓存信息,并通过滑动窗口、自适应调整和不连续更新等策略,优化解码阶段的重要特征选取,显著提升了长语言模型长序列生成的性能。

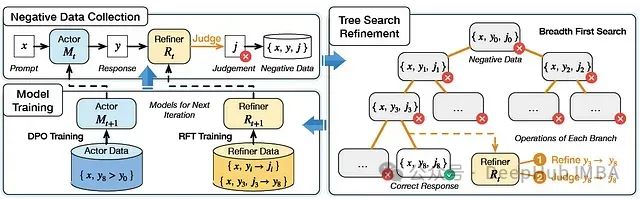

SPAR:融合自对弈与树搜索的高性能指令优化框架

SPAR框架通过自对弈和树搜索机制,生成高质量偏好对,显著提升了大语言模型的指令遵循能力。实验表明,SPAR在指令遵循基准测试中表现优异,尤其在模型规模扩展和判断能力方面展现出显著优势。