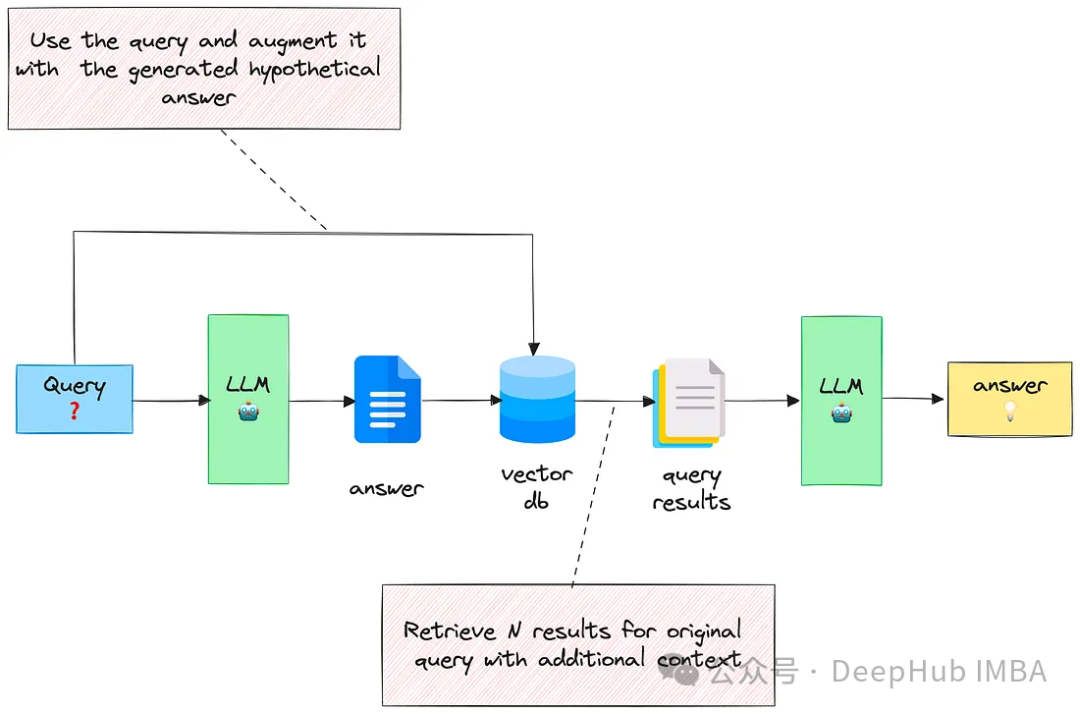

RAG中的3个高级检索技巧

本文将探讨三种有效的技术来增强基于rag的应用程序中的文档检索,通过结合这些技术,可以检索与用户查询密切匹配的更相关的文档,从而生成更好的答案。

4种通过LLM进行文本知识图谱的构建方法对比介绍

本文将介绍和比较使用LLM转换非结构化文本的四种方法,这些方法在不同的场景中都可能会用到。

使用SPIN技术对LLM进行自我博弈微调训练

SPIN从AlphaGo Zero和AlphaZero等游戏中成功的自我对弈机制中汲取灵感。它能够使LLM参与自我游戏的能力。

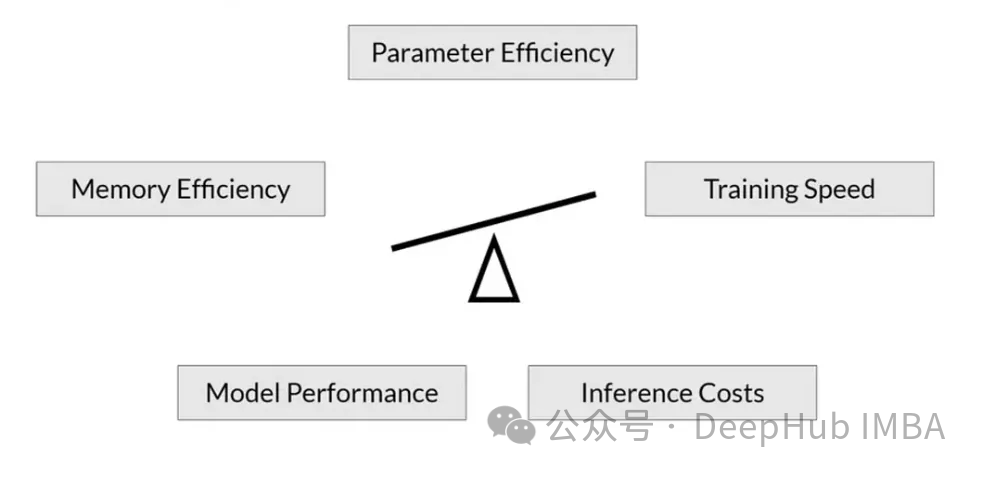

RoSA: 一种新的大模型参数高效微调方法

随着语言模型不断扩展到前所未有的规模,对下游任务的所有参数进行微调变得非常昂贵,PEFT方法已成为自然语言处理领域的研究热点。PEFT方法将微调限制在一小部分参数中,以很小的计算成本实现自然语言理解任务的最先进性能。

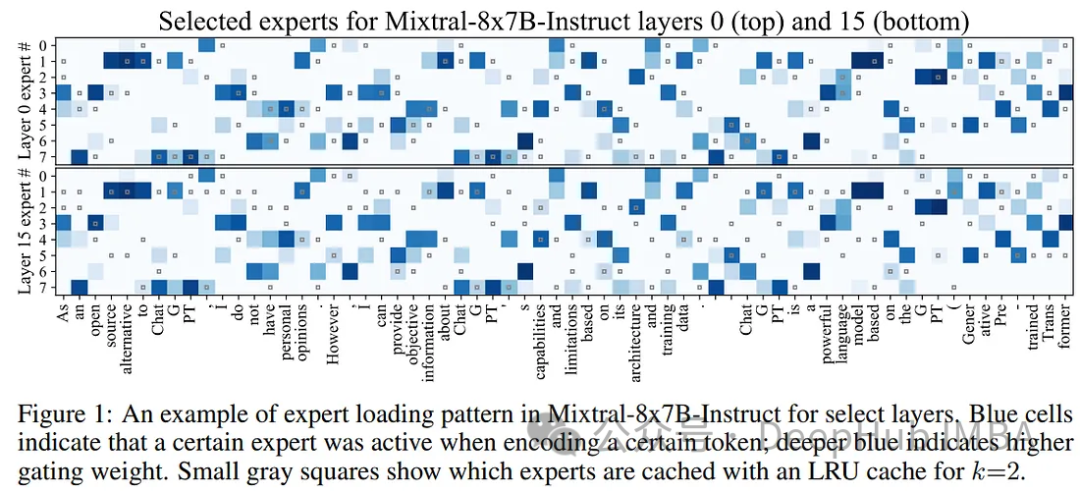

使用Mixtral-offloading在消费级硬件上运行Mixtral-8x7B

在本文中,将解释Mixtral-offloading的工作过程,使用这个框架可以节省内存并保持良好的推理速度,我们将看到如何在消费者硬件上运行Mixtral-8x7B,并对其推理速度进行基准测试。

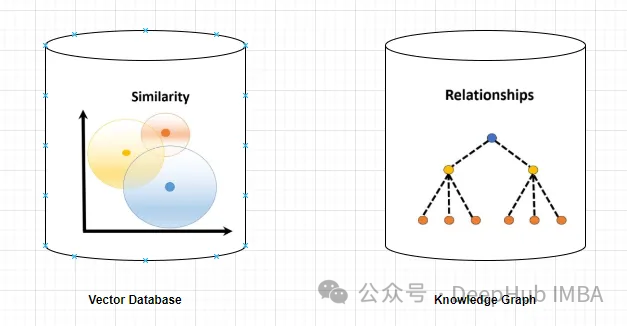

使用知识图谱提高RAG的能力,减少大模型幻觉

在使用大型语言模型(llm)时,幻觉是一个常见的问题。LLM生成流畅连贯的文本,但往往生成不准确或不一致的信息。防止LLM产生幻觉的方法之一是使用提供事实信息的外部知识来源,如数据库或知识图谱。

【AI视野·今日NLP 自然语言处理论文速览 第六十一期】Tue, 24 Oct 2023

AI视野·今日CS.NLP 自然语言处理论文速览Tue, 24 Oct 2023 (showing first 100 of 207 entries)Totally 100 papers👉上期速览✈更多精彩请移步主页Daily Computation and Language PapersLIN

如何避免LLM的“幻觉”(Hallucination)

生成式大语言模型(LLM)可以针对各种用户的 prompt 生成高度流畅的回复。然而,大模型倾向于产生幻觉或做出非事实陈述,这可能会损害用户的信任。

使用LOTR合并检索提高RAG性能

RAG结合了两个关键元素:检索和生成。本文将介绍使用使用Merge retriver改进RAG的性能

人工智能生成文本检测在实践中使用有效性探讨

本文介绍了关于如何检测ai生成文本的思路。可以使用的主要指标是生成文本的困惑度。还介绍了这种方法的一些缺点,包括误报的可能性。希望这有助于理解检测人工智能生成文本背后的细节。但是当我们讨论检测人工智能生成文本的技术时,这里的假设都是整个文本要么是人类编写的,要么是人工智能生成的。但是实际上文本往往部

人工智能生成文本检测在实践中使用有效性探讨

本文介绍了关于如何检测ai生成文本的思路。希望这有助于理解检测人工智能生成文本背后的细节。

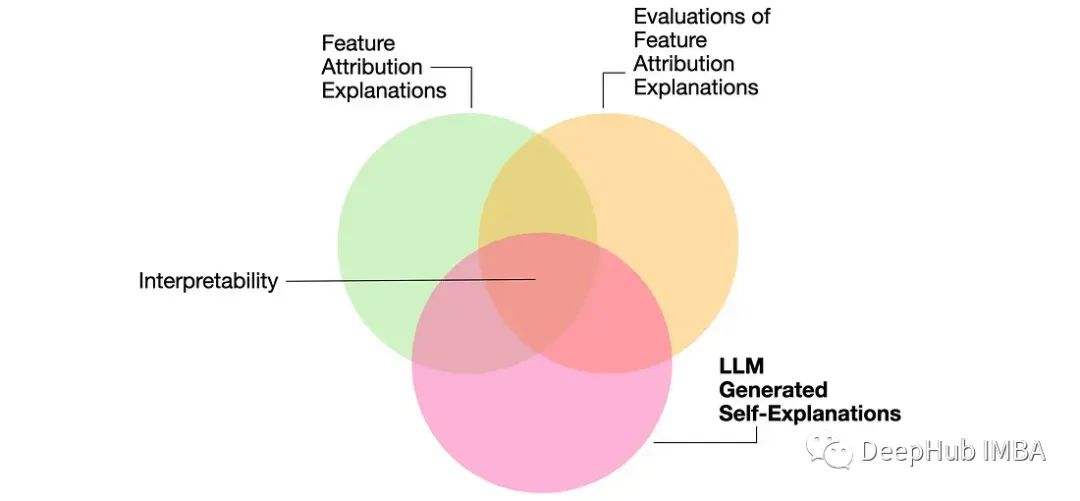

论文推荐:大型语言模型能自我解释吗?

这篇论文的研究主要贡献是对LLM生成解释的优缺点进行了调查。详细介绍了两种方法,一种是做出预测,然后解释它,另一种是产生解释,然后用它来做出预测。

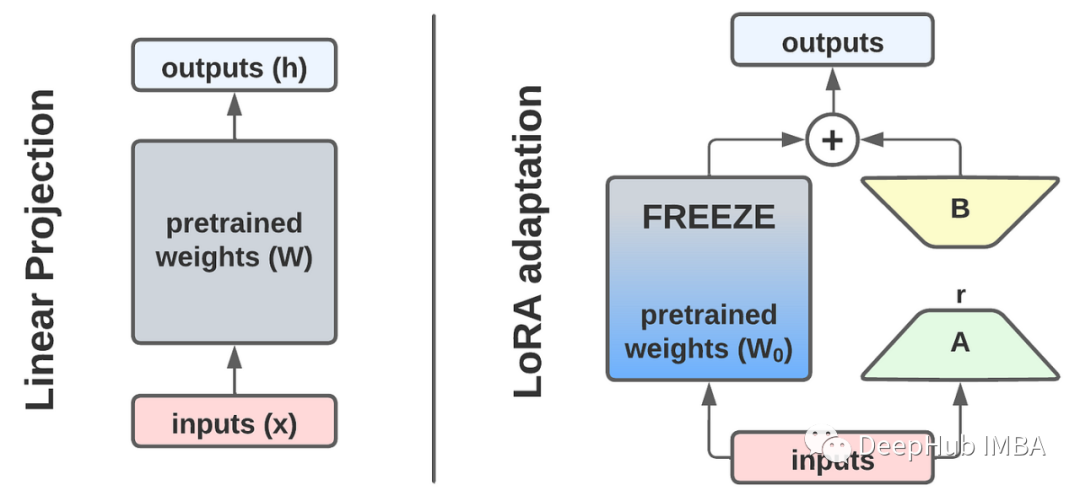

从头开始实现LoRA以及一些实用技巧

本文将首先深入研究LoRA,然后以RoBERTa模型例从头开发一个LoRA,然后使用GLUE和SQuAD基准测试对实现进行基准测试,并讨论一些技巧和改进。

人工智能的新篇章:深入了解大型语言模型(LLM)的应用与前景

人工智能的新篇章:深入了解大型语言模型(LLM)的应用与前景

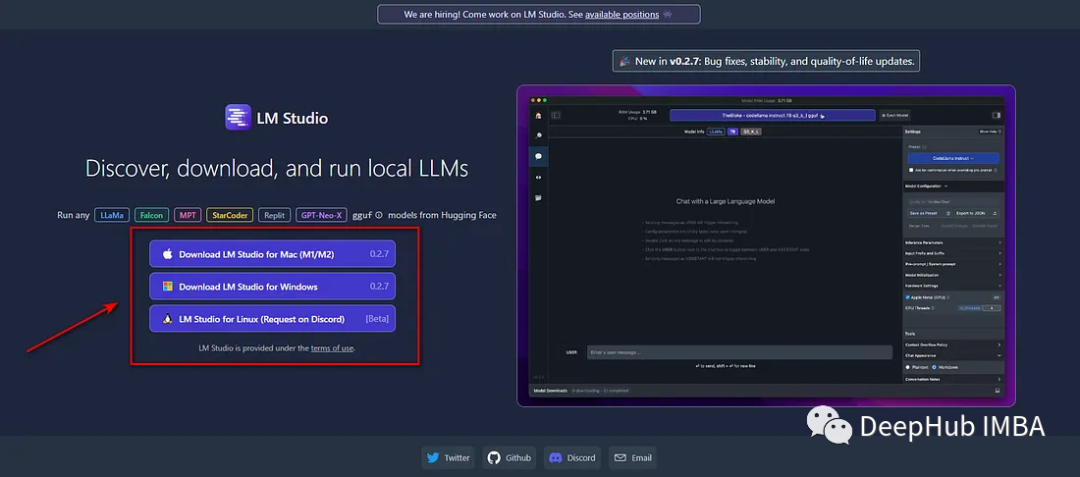

使用LM Studio在本地运行LLM完整教程

LM Studio是一个免费的桌面软件工具,它使得安装和使用开源LLM模型非常容易。

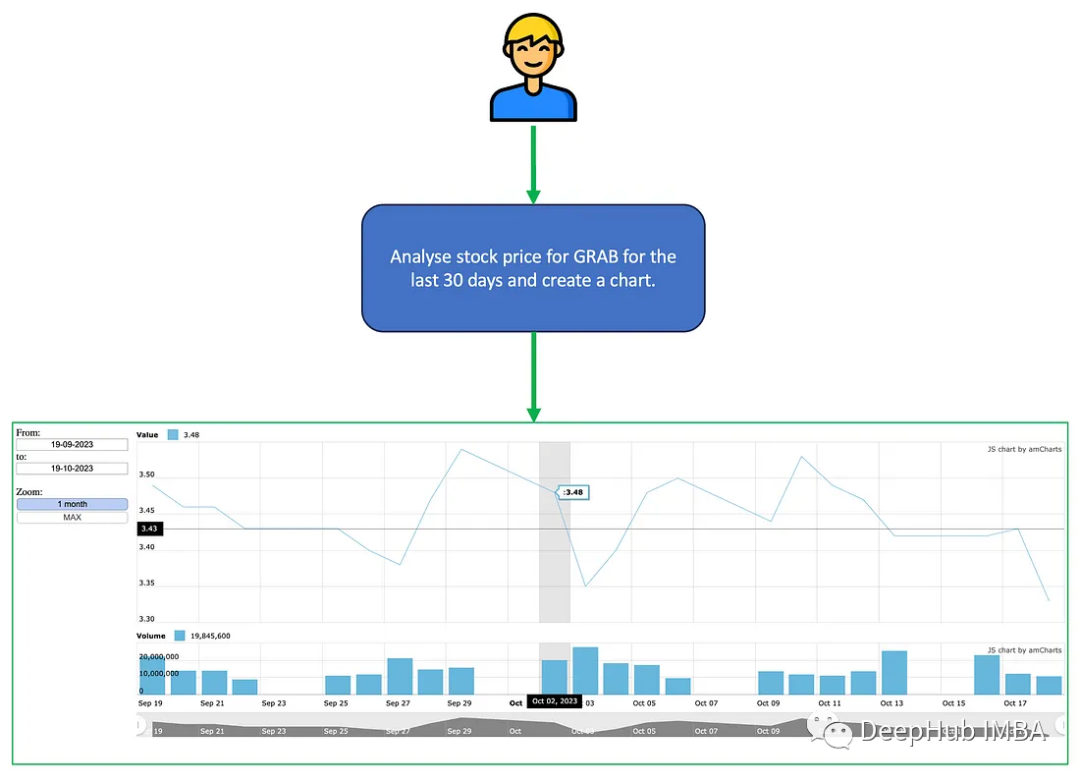

AutoGen多代理对话项目示例和工作流程分析

在这篇文章中,我将介绍AutoGen的多个代理的运行。这些代理将能够相互对话,协作评估股票价格,并使用AmCharts生成图表。

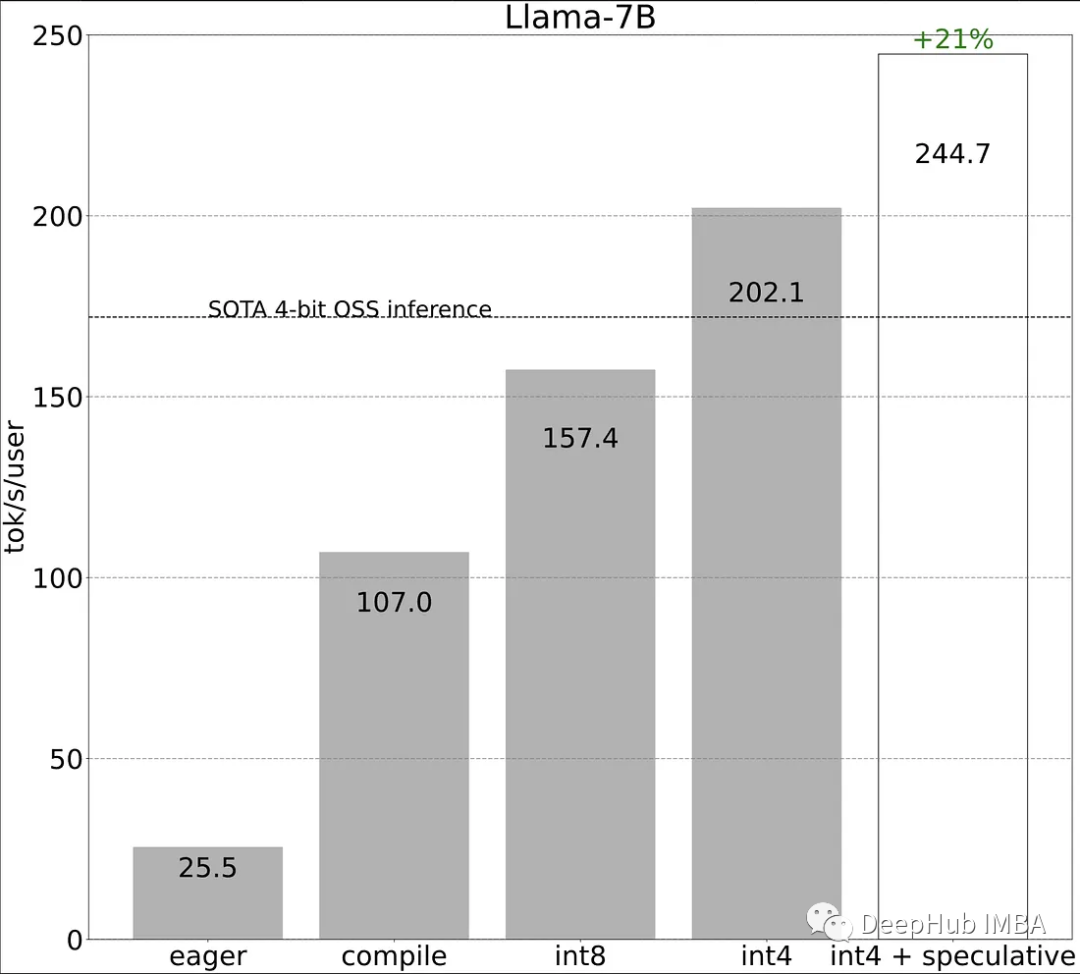

使用PyTorch II的新特性加快LLM推理速度

Pytorch团队提出了一种纯粹通过PyTorch新特性在的自下而上的优化LLM方法

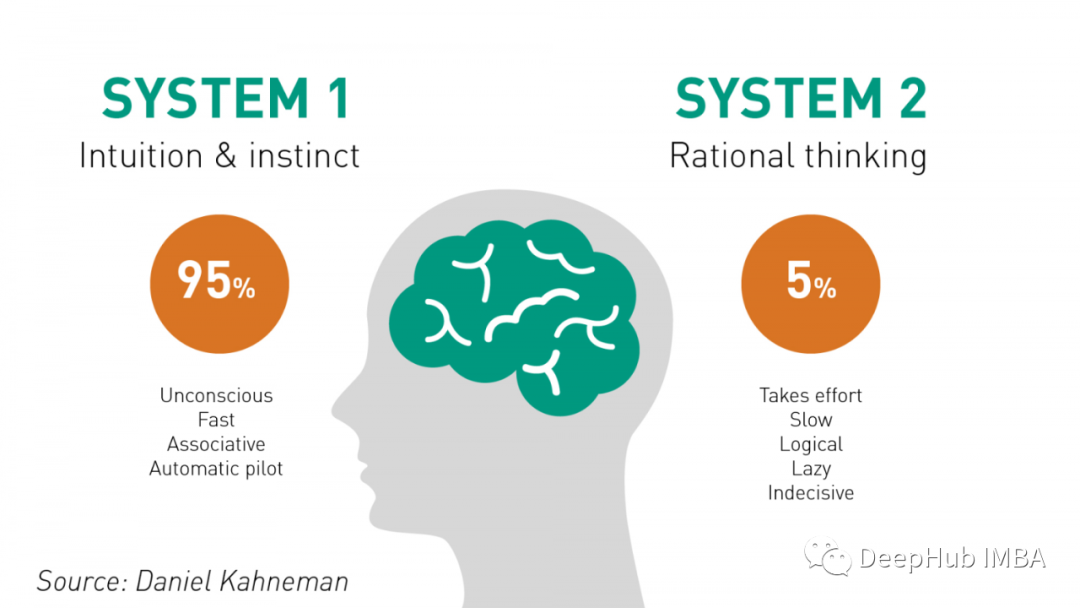

System 2 Attention:可以提高不同LLM问题的推理能力

S2A是LLM推理方法发展的一个重要里程碑。该方法与人类推理非常相似,避免了干扰。我们应该期待S2A在最近几个月成为推理研究的重要基线。

RAG应用程序的12种调优策略:使用“超参数”和策略优化来提高检索性能

本文从数据科学家的角度来研究检索增强生成(retrieve - augmented Generation, RAG)管道。讨论潜在的“超参数”,这些参数都可以通过实验来提高RAG管道的性能。

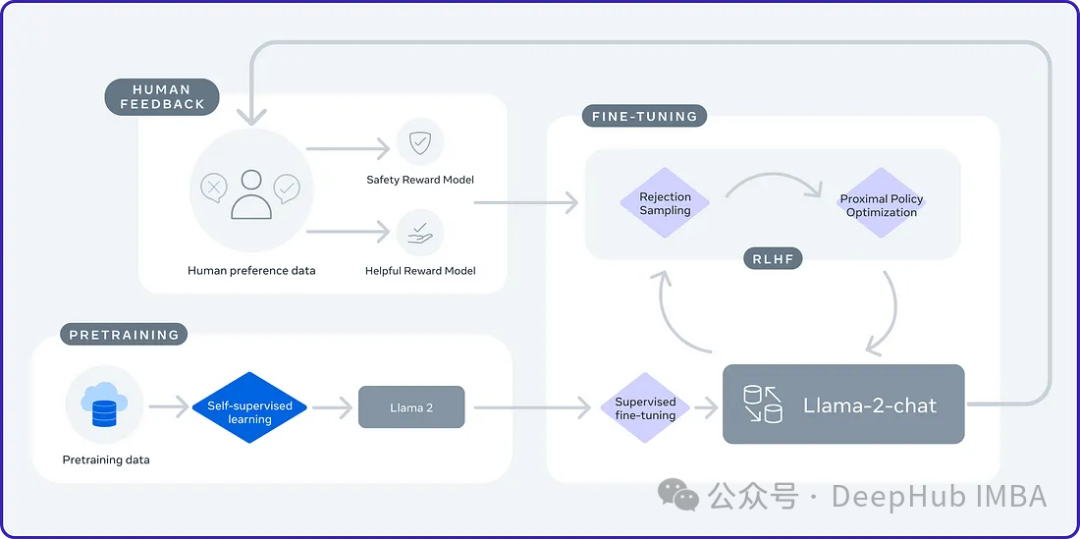

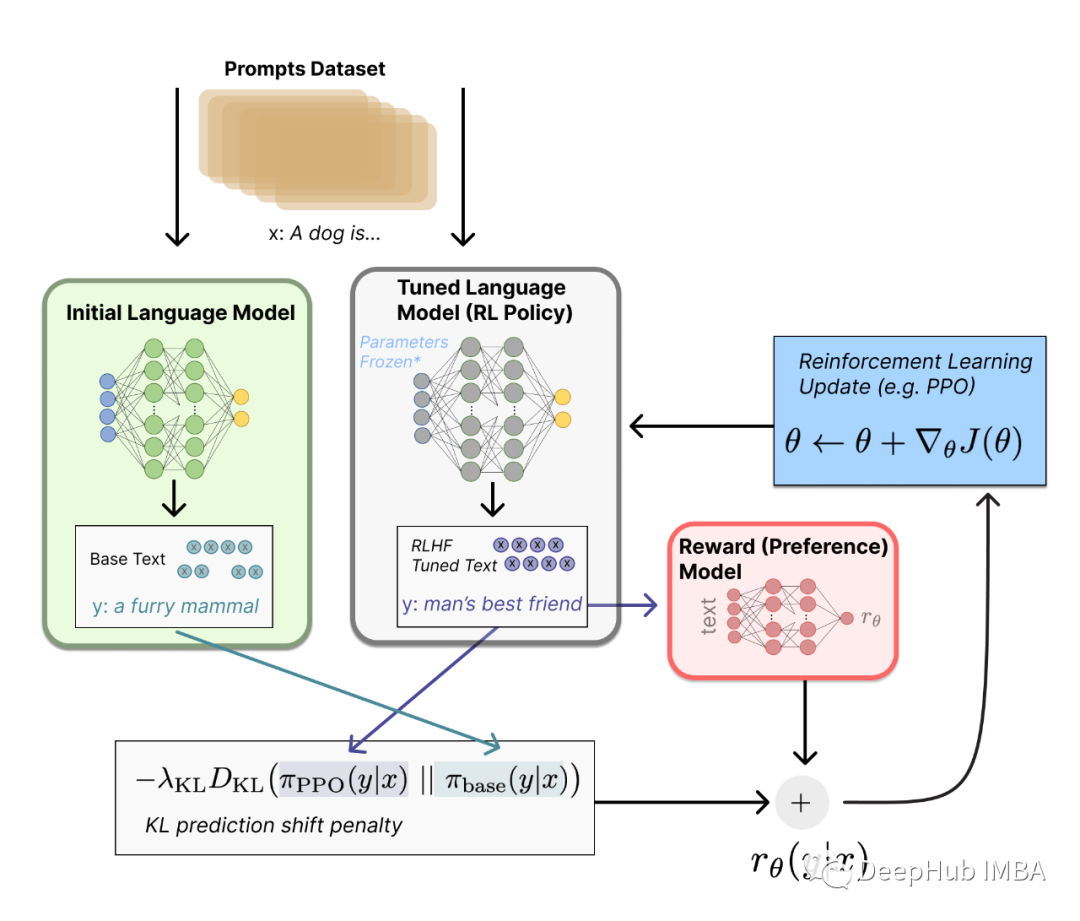

使用Huggingface创建大语言模型RLHF训练流程的完整教程

在本文中,我们将使用Huggingface来进行完整的RLHF训练。