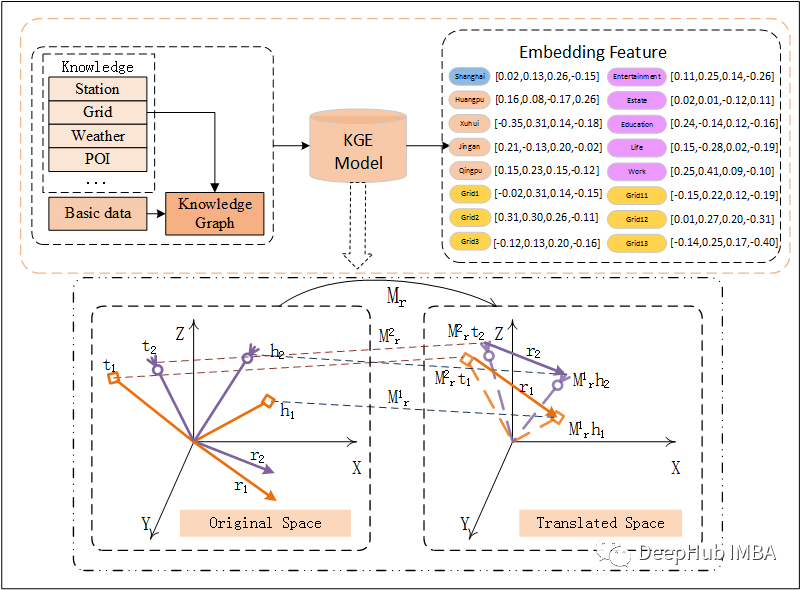

知识图谱嵌入模型 (KGE) 的总结和比较

知识图谱嵌入(KGE)是一种利用监督学习来学习嵌入以及节点和边的向量表示的模型。本文将常见的KGE 模型在捕获关系类型方面的比较

深度强化学习-TD3算法原理与代码

引言Twin Delayed Deep Deterministic policy gradient (TD3)是由Scott Fujimoto等人在Deep Deterministic Policy Gradient (DDPG)算法上改进得到的一种用于解决连续控制问题的在线(on-line)异策(

Ubuntu20.04安装cuDNN(包括WSL)

Nvidia官网cuDNN安装说明sudo apt-get install libcudnn8=8.x.x.x-1+cudaX.Y的替换是确定的,跟第一步下载cudnn-local-repo-xxxx.deb包有关,不需要重新下载。

【情人节专属】AI一键预测你和Ta的CP值

想知道你和心仪对象的CP指数有多少吗?AI一键就能预测。只需上传自己和心仪对象的照片,一键Run in ModelArts就可以知晓CP指数~

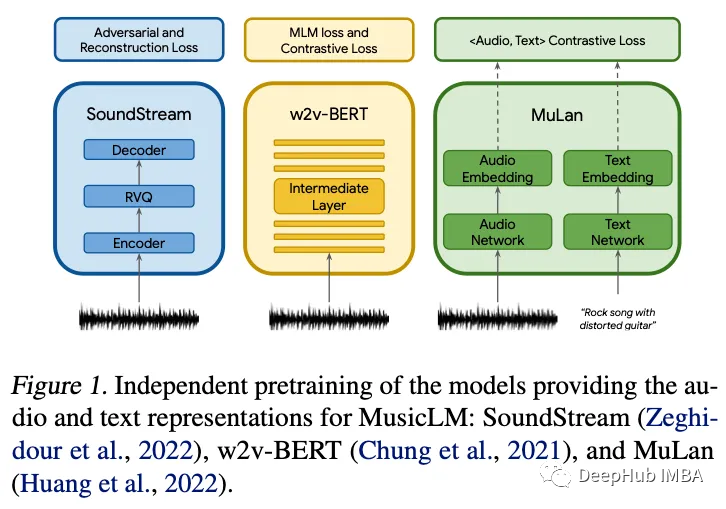

2023年2月的十篇深度学习论文推荐

本月的论文包括语言模型、扩散模型、音乐生成、多模态等主题。

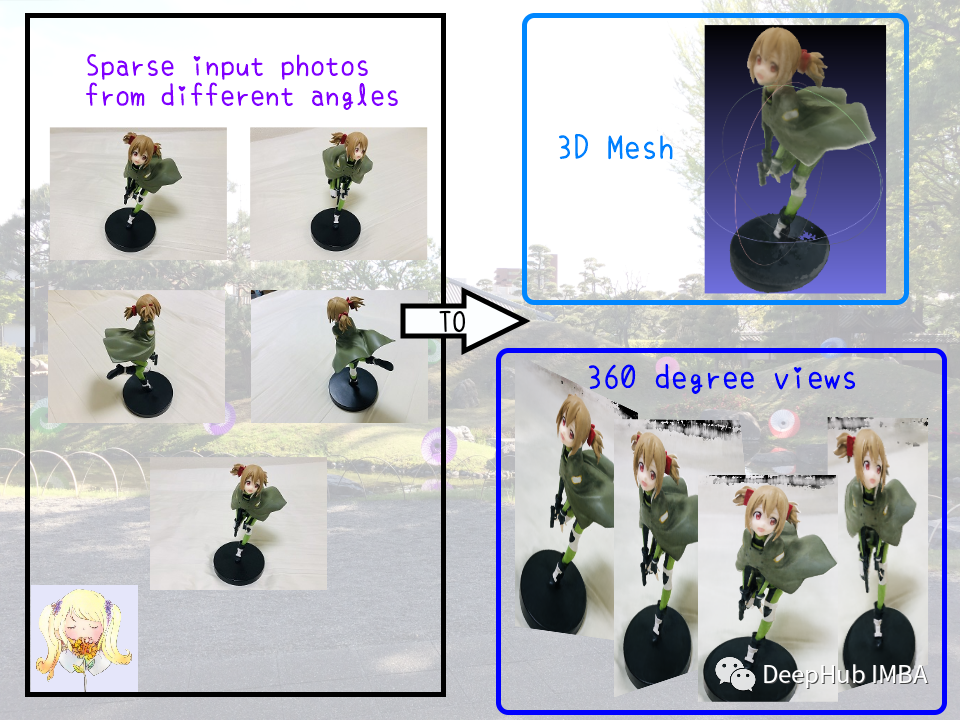

100行Pytorch代码实现三维重建技术神经辐射场 (NeRF)

提起三维重建技术,NeRF是一个绝对绕不过去的名字。本文通过100行的Pytorch代码实现最初的 NeRF 论文。

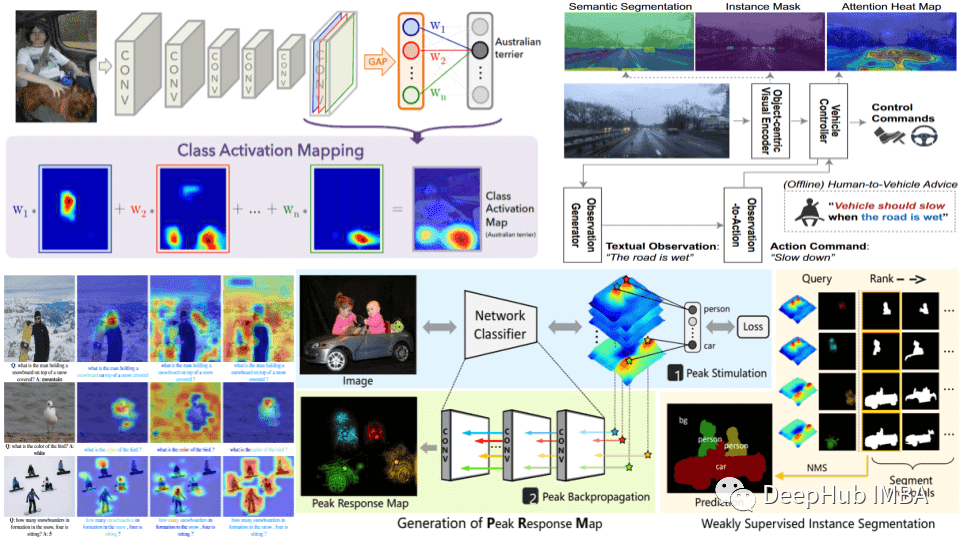

计算机视觉框架OpenMMLab开源学习(一):计算机视觉基础

前言:本系列主要对OpenMMlab开源框架进行学习,文章分为计算机视觉基础、图像分类、图像检测、图像分割等,适合人工智能领域入门及爱好者学习,可以快速了解OpenMMlab框架,为后续实战学习打下基础。大致可以分为这么几类:图像识别、目标检测、图像分割、图像增强、图像生成、视觉感知、人脸分类识别、

10个用于可解释AI的Python库

XAI的目标是为模型的行为和决定提供有意义的解释,本文整理了目前能够看到的10个用于可解释AI的Python库

GPT-3 vs Bert vs GloVe vs Word2vec 文本嵌入技术的性能对比测试

本文将GPT3与三种传统文本嵌入技术GloVe、Word2vec(Mikolov ,2013 年)和 BERT生成的嵌入进行性能的简单对比。

pytorch-lightning安装

一般pytorch-lightning 需要torch版本≥1.8.0。在安装pytorch-lightning时一定注意自己的torch是pip安装还是conda安装,两者要保持一致,不然会导致安装pytorch-lightning时会直接卸载掉你的torch,安装cpu版本的torch。http

使用scikit-learn为PyTorch 模型进行超参数网格搜索

scikit-learn是Python中最好的机器学习库,而PyTorch又为我们构建模型提供了方便的操作,要让PyTorch 模型可以在 scikit-learn 中使用的一个最简单的方法是使用skorch包

Mask R-CNN讲解

Mask R-CNN最全讲解

Diffusion models代码实战:从零搭建自己的扩散模型

这个系列曾经写过三篇文章专门讲代码,分别从数据集、超参数、loss设计、参数计算、Unet结构、正向过程、逆向过程等部分详细介绍了如何搭建DDPM。Diffusion models领域发展神速,最近半年代表作品有OpenAI的GLIDE、DALL-E 2,Google Brain的ImageGen,

YOLOv5中的CSP结构

深度学习入门小菜鸟,希望像做笔记记录自己学的东西,也希望能帮助到同样入门的人,更希望大佬们帮忙纠错啦~侵权立删。目录一、背景知识 -- CSPNet二、CSP结构分析1、总括2、CSP1_X结构3、CSP2_X三、源码分析(内含注释分析)一、背景知识 -- CSPNet有关CSPNet的介绍分析可以

语义分割系列6-Unet++(pytorch实现)

本文介绍了Unet++网络,在pytorch框架上复现Unet++,并在Camvid数据集上进行训练。

大数据毕设选题 - 深度学习口罩佩戴检测系统(python OpenCV YOLO)

🔥 Hi,大家好,这里是丹成学长的毕设系列文章!🔥 对毕设有任何疑问都可以问学长哦!这两年开始,各个学校对毕设的要求越来越高,难度也越来越大… 毕业设计耗费时间,耗费精力,甚至有些题目即使是专业的老师或者硕士生也需要很长时间,所以一旦发现问题,一定要提前准备,避免到后面措手不及,草草了事。为了

机器学习评估指标的十个常见面试问题

评估指标是用于评估机器学习模型性能的定量指标。本文整理了10个常见的问题。

【YOLOv7改进轻量化】第一章——引入轻量化骨干网络MobileOne

YOLOv7轻量化之MobileOne,原理+完整代码实现

计算机视觉框架OpenMMLab开源学习(三):图像分类实战

本篇主要偏向图像分类实战部分,使用MMclassification工具进行代码应用,熟悉其框架应用,为后续处理不同场景下分类问题提供帮助。

PatchCore原理与代码解读

随机下采样会丢失 \(\mathcal{M} \) 中的有用信息,本文使用coreset subsampling方法来减小 \(\mathcal{M} \),coreset selection旨在找到一个子集 \(\mathcal{S}\subset \mathcal{A}\),对于通过 \(\m