全面剖析OpenAI发布的GPT-4比其他GPT模型强在哪里

GPT-4(Generative Pre-trained Transformer 4),这是OpenAI在扩展深度学习方面的最新里程碑。GPT-4 是一个大型多模态模型(接受图像和文本输入,发出文本输出),虽然在许多现实世界场景中的能力不如人类,但在各种专业和学术基准上表现出人类水平的表现。输出依旧

Autoformer算法与代码分析

Autoformer的原理以及代码的详细分析

Amazon SageMaker测评分享,效果超出预期

一、前言随着科技的进步和社会的发展,人工智能得到了愈加广泛的重视,特别是最近大火的Chatgpt,充分展现了研发通用人工智能助手广阔的研究和应用前景。让越来越多的组织和企业跟风加入到人工智能领域的研究中,但机器学习的实施是一项极其复杂的工作,不仅需要专业技能,还涉及大量的试错。无论是“专业”,抑或是

17届全国大学生智能汽车竞赛 中国石油大学(华东)智能视觉组 --模型训练篇

如果你习惯使用jupyter notebook编写代码,这里也提供了jupyter版本的代码。在目录下的example.ipynb,有所有内容的完整代码。这部分的代码已上传到我的。模型的精度在比赛中非常关键,毕竟分类错误的罚时是非常狠的。

FEDformer 代码分析(1)

也就是说加上23维度的才是这个维度的,也就是本来的x是(1,96,7)的维度的,前面拼接上front,后面拼接上end后,变成了(1,119,7)这个维度的了。这个series_decomp_multi的里面有两个可学习的东西,一个是一个pooling,是kernel_size是24的大小的,另一个

VIT:Transformer进军CV的里程碑

Transformer[1]最初提出是针对NLP领域的,并且在NLP领域大获成功,几乎打败了RNN模型,已经成为NLP领域新一代的baseline模型。这篇论文也是受到其启发,尝试将Transformer应用到CV领域。通过这篇文章的实验,给出的最佳模型在ImageNet1K上能够达到88.55%的

番外篇 | 20+ 种注意力机制及代码 适用于YOLOv5/v7/v8(新增5种v7模板)

番外篇 | 20+ 种注意力机制及代码 适用于YOLOv5/v7/v8(新增5种v7模板🍀)

【AIGC】1、爆火的 AIGC 到底是什么 | 全面介绍

本文主要介绍 AIGC 是什么以及能用来干什么

不是所有数据增强都可以提升精度

即使引入噪声或裁剪图像的一部分,模型仍可以对图像进行分类,数据增强有一系列简单有效的方法可供选择,有一些机器学习库来进行计算视觉领域的数据增强,比如:imgaug (https://github.com/aleju/imgaug)它封装了很多数据增强算法,给开发者提供了方便。计算视觉领域的数据增强算

【深度学习】训练集、测试集和验证集

码字不易,如果各位看官感觉该文章对你有所帮助,麻烦点个关注,如果有任何问题,请留言交流。如需转载,请注明出处,谢谢。文章链接:目录一、深度学习的数据二、训练集、测试集和验证集三、训练集、测试集和验证集的比例一、深度学习的数据 在深度学习或机器学习的过程中,数据无疑是驱动模型的主要能量,通过训练

【深度学习】(1) CNN中的注意力机制(SE、ECA、CBAM),附Pytorch完整代码

大家好,今天和各位分享一下如何使用 Pytorch 构建卷积神经网络中的各种注意力机制,如:SENet,ECANet,CBAM。注意力机制的原理 和 TensorFlow2 的实现方式可以看我下面两篇博文:SENet、ECANet:https://blog.csdn.net/dgvv4/articl

UNet - 数据加载 Dataset

之前介绍完了Unet网络的搭建,接下来说一下要解决的任务data里面存放的是训练的数据predict 是存放的是需要预测的数据result 是predict里面预测出来的结果dataset 是数据加载的文件、model 是UNet网络、train是训练、predict是预测UNet模型训练,深度解析

OpenPose笔记——在编译好的OpenPose C++代码上跑自己的图片和视频

前面自编译好了OpenPose 的python,但是没找到用python跑视频的代码。。。最终,还是需要在C++工程里来跑。编译好的解决方案里面有很多例子上面一共17个例子,图片、文件夹、手、脸、热力图、输入流(摄像头)等多个例子包含在内,但是没有视频的例子。第一种运行的方式是 命令行运行打开cmd

独家丨前美团联合创始人王慧文“正在收购”国产AI框架OneFlow,光年之外欲添新大将...

文丨谭婧以ChatGPT为代表的AI大模型是2023年的科技C位。2023年3月27日,ChatGPT引发的“抓马连续剧”,又有新剧更新。前情提要:前美团联合创始人、高级副总裁王慧文发文宣布进入AI领域,称将打造中国的OpenAI。新闻标题一:《王慧文放话:我先投3个亿》当然,他现在的身份是美团非执

联邦学习:FedProx框架

联邦学习不同于传统的分布式优化的两个关键挑战:高度的系统和统计异构性。引入了一个框架,FedProx以解决异构性难题(统计异构 系统异构)。FedProx可以看作是FedAvg的泛化、重构。对于非独立分布(统计异质性)的训练数据,框架提供收敛性保证(统计异构);允许每个参与的设备执行可变数量的工作(

【Pytorch基础知识】数据的归一化和反归一化

搞清数据的归一化和反归一化,快速掌握将图片转为tensor进行系列操作后,再转为图片

PyTorch 深度学习实战 |用 TensorFlow 训练神经网络

为了更好地理解神经网络如何解决现实世界中的问题,同时也为了熟悉 TensorFlow 的 API,本篇我们将会做一个有关如何训练神经网络的练习,并以此为例,训练一个类似的神经网络。

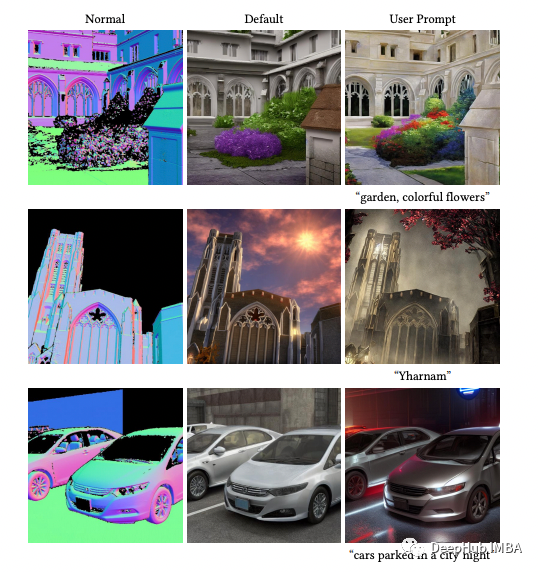

常用的ControlNet以及如何在Stable Diffusion WebUI中使用

ControlNet是斯坦福大学研究人员开发的Stable Diffusion的扩展,使创作者能够轻松地控制AI图像和视频中的对象

深度学习中FLOPS和FLOPs的区别与计算

我们在购买GPU或者计算目标检测模型复杂度的时候,一般会遇到FLOPS和FLOPs这两个指标,在此加以区分。

Windows端CUDA11.3+CUDNN+pytorch环境搭建

1、显卡驱动的安装最近,在学习pytorch深度学习,遇到很多的坑,环境配置也出现过问题,忍不住和大家进行分享,现在把环境搭建过程分享给大家。1.1、查看自己的显卡。具体操作:我的电脑-——属性——设备管理器——显示适配器1.2、驱动的下载、安装。在找到自己的显卡后,去NVIDIA官网下载安装驱动选