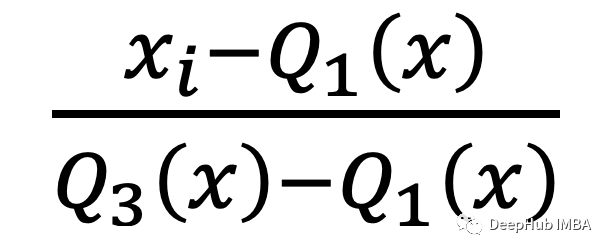

一个简单但是能上分的特征标准化方法

一般情况下我们在做数据预处理时都是使用StandardScaler来特征的标准化,如果你的数据中包含异常值,那么效果可能不好。

Pytorch(二) —— 激活函数、损失函数及其梯度

δ(x)=11+e−xδ′(x)=δ(1−δ)\delta(x)=\frac{1}{1+e^{-x}}\\\delta'(x)=\delta(1-\delta)δ(x)=1+e−x1δ′(x)=δ(1−δ)tanh(x)=ex−e−xex+e−x∂tanh(x)∂x=1−tanh2(x)tanh(

基于趋势和季节性的时间序列预测

分析时间序列的趋势和季节性,分解时间序列,实现预测模型

AI: 2021 年人工智能前沿科技报告02(更新中……)

AI: 2021 年人工智能前沿科技报告02(更新中……)2021 年对于人工智能技术和产业,依旧是不平凡的一年。随着算力、数据、算法等要素逐渐齐备,先进的算法结构不断涌现,各个研究方向研究成果不断突破,成熟的 AI 技术逐渐向代码库、平台和系统发展,实现产业和商业层面的落地应用,推动人工智能发展迈

【机器学习】向量化计算 -- 机器学习路上必经路

在求解矩阵中,往往有很多很好的,经过高度优化的线性代数库,如octave,matlib,python numpy, c++,java.我们使用这些线性代数库,可以短短几行实现 所要的效果。阅读本文内容(需要一点点线性代数的知识)例如 求公式:h(x)=∑i=1nθi∗xih(x) = \sum_{i

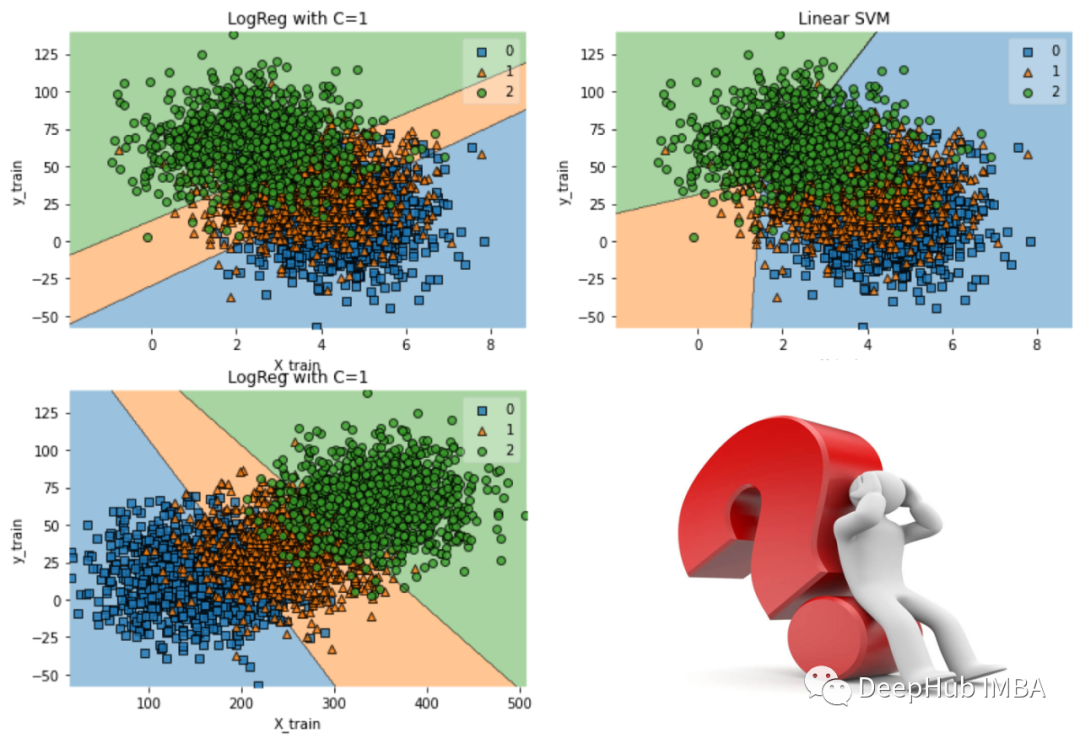

100+数据科学面试问题和答案总结 - 机器学习和深度学习

来自Amazon,谷歌,Meta, Microsoft等的面试问题,本文接着昨天的文章整理了机器学习和深度学习的问题

期末复习【机器学习】

期末复习【机器学习】

机器学习入门(一)

本文是在入手机器学习过程中的一些学习心得和总结,适合机器学习的基础阶段借鉴。 机器学习是一种从数据中总结规律的统计方法。机器学习中有各种用于总结规律并且进行预测或者分类的模型(算法),被广泛应用在物体识别、语音识别、放假预测和疾病诊断等领域。 ......

音频数据增强(一)——mixup和SpecAugment

目录1、mixup2、SpecAugment论文地址:https://arxiv.org/pdf/1710.09412.pdfmixup通过以下方式构建虚拟的训练样本:式中,(xi,yi)和(xj,yj)是从训练数据中随机抽取的两个样本,且λ∈[0,1]。因此,mixup通过结合先验知识,即特征向量

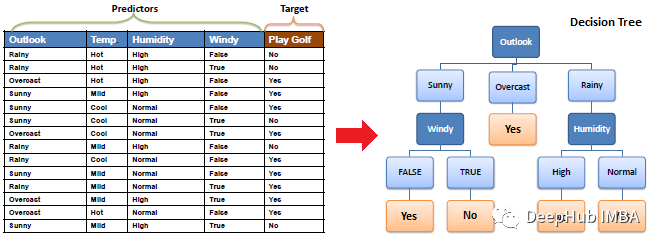

机器学习基础自学笔记——决策树(Decision Tree)

决策树基础知识:从信息熵决策熵到信息增益、信息增益率、基尼系数,到两种剪枝处理和随机森林,生动易懂配有自制插图

手把手带你玩转Spark机器学习-使用Spark进行数据降维

本章,我们将继续讲解无监督学习模型中降低数据维度的方法。不同于我们之前分享的回归、分类和聚类,降维方法并不是用来做模型预测的。降维方法从一个D维的数据输入提取出k维表示,k一般远远小于D。因此,降维方法本身是一种预处理方法,或者说是一种特征转换的方法,而不是模型预测的方法。降维方法中尤为重要的是,被

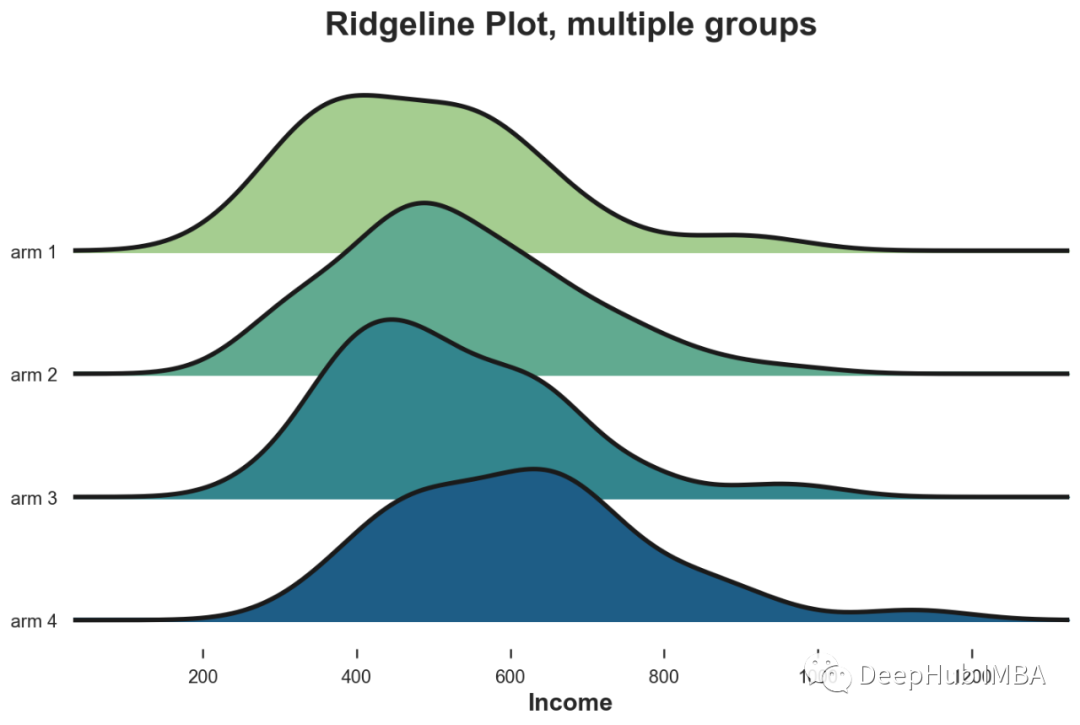

如何比较两个或多个分布:从可视化到统计检验的方法总结

比较一个变量在不同组中的分布是数据科学中的一个常见问题,在这篇文章中,我们将看到比较两个(或更多)分布的不同方法,并评估它们差异的量级和重要性。

评估和选择最佳学习模型的一些指标总结

在评估模型时,虽然准确性是训练阶段模型评估和应用模型调整的重要指标,但它并不是模型评估的最佳指标,我们可以使用几个评估指标来评估我们的模型。

人工智能如何用于静态生物特征验证

静态生物特征验证是一种常用的 AI 功能,它可以实时捕捉人脸,并可以在不提示用户移动头部或面部的情况下确定人脸是否属于真人。通过这种方式,该服务有助于提供获得积极反馈的便捷用户体验。静态生物特征验证需要 RGB 摄像头,并且能够通过细节(例如莫尔图案或纸上的反射)区分真人的面部和欺骗攻击(例如面部和

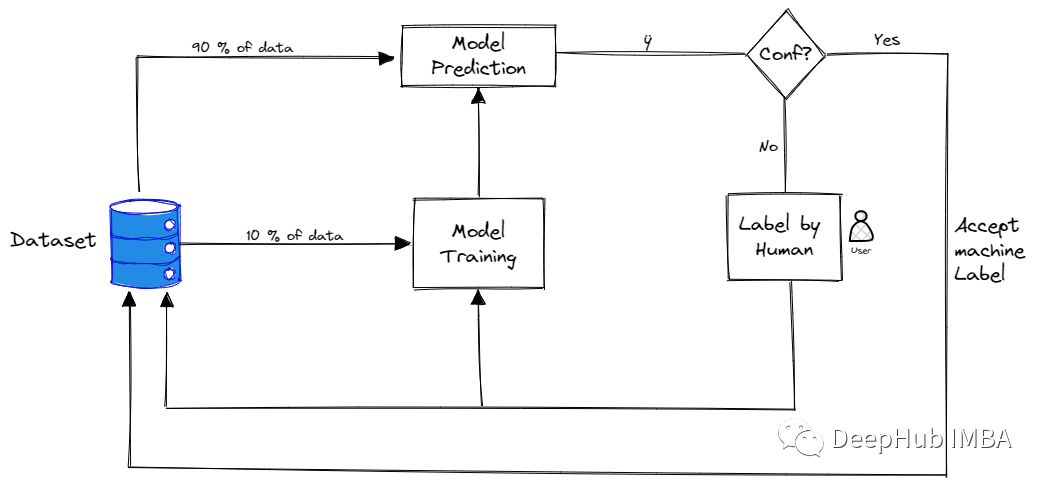

主动学习(Active Learning) 概述、策略和不确定性度量

主动学习是指对需要标记的数据进行优先排序的过程,这样可以确定哪些数据对训练监督模型产生最大的影响。

DeOldify实现老照片上色(附直接使用的工具代码) | 机器学习

老照片上色其实很早之前就想写了,也有不少人问了我这个项目。最近把DeOldify项目好好弄了弄。

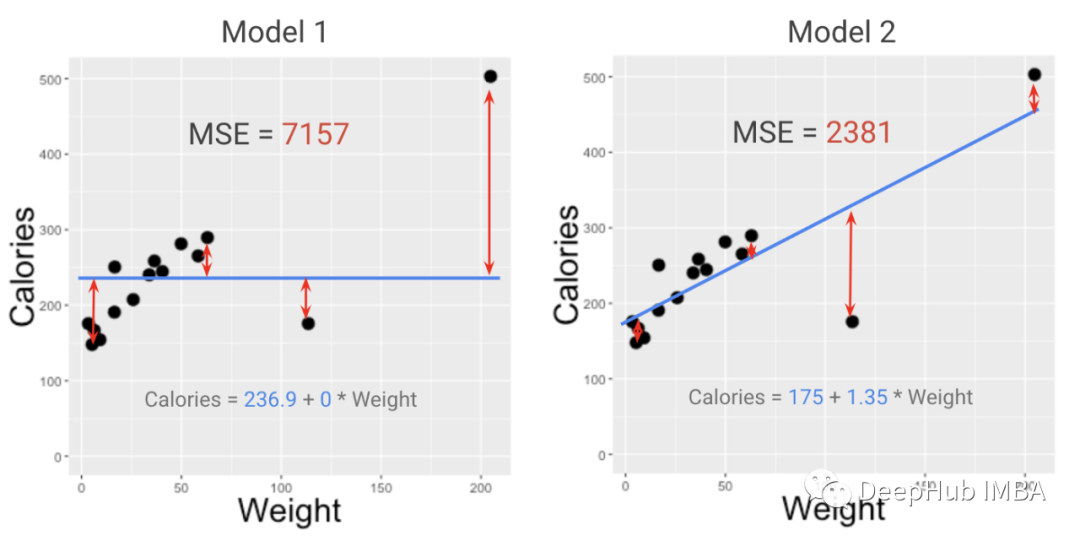

模型的度量指标和损失函数有什么区别?为什么在项目中两者都很重要?

在本文中,我将解释为什么需要两个独立的模型评分函数来进行评估和优化……甚至还可能需要第三个模型评分函数来进行统计测试。

ML之ME:分类预测问题中评价指标(AP/mAP)的简介、使用方法、代码实现、案例应用之详细攻略

ML之ME:分类预测问题中评价指标(AP/mAP)的简介、使用方法、代码实现、案例应用之详细攻略目录评价指标(AP/mAP)的简介1、AP的简介2、AP的理解3、AP与mAP区别及意义评价指标(AP/mAP)的案例应用1、具体比赛场景下的特殊定义(1)、AP (Average Precision)i

即将步入大四,开始我最真情的告白

大一下学期加入机器人实验室,开始接触ROS,从装Ubuntu双系统开始,就开始令我难忘的学习生活,开始学习ROS,学习古月老师的ROS入门21讲,后来有问题,就常常在CSDN上找答案,跟着师哥师姐做实验室的项目,在这个学习的过程中有想过放弃,有过滑水摸鱼,觉得自己是老师和师哥师姐的打工人,是给他们干

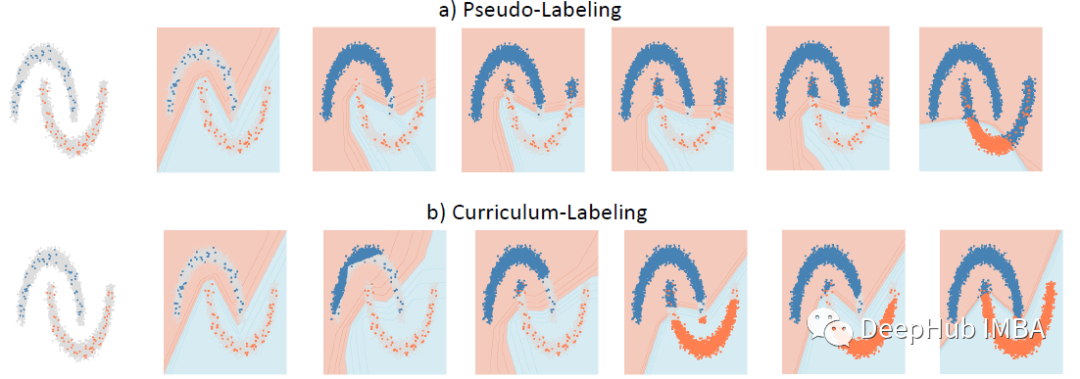

Curriculum Labeling:重新审视半监督学习的伪标签

Curriculum Labeling (CL),在每个自训练周期之前重新启动模型参数,优于伪标签 (PL)