主动学习(Active Learning) 概述、策略和不确定性度量

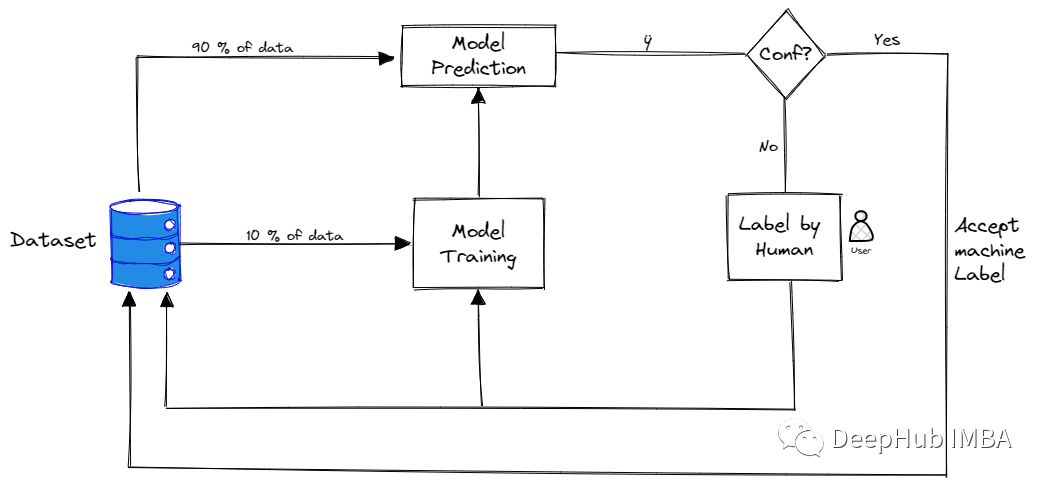

主动学习是指对需要标记的数据进行优先排序的过程,这样可以确定哪些数据对训练监督模型产生最大的影响。

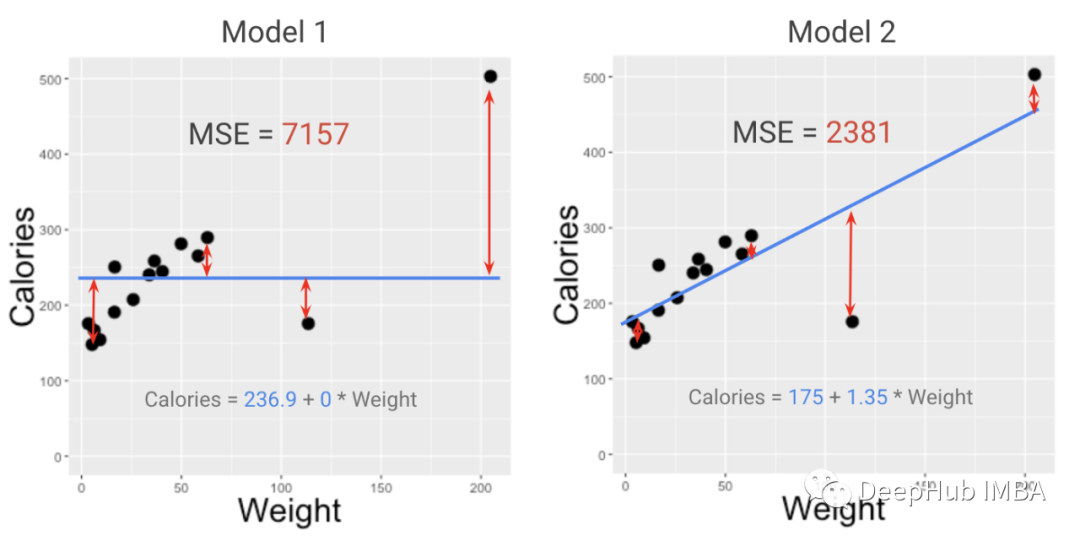

模型的度量指标和损失函数有什么区别?为什么在项目中两者都很重要?

在本文中,我将解释为什么需要两个独立的模型评分函数来进行评估和优化……甚至还可能需要第三个模型评分函数来进行统计测试。

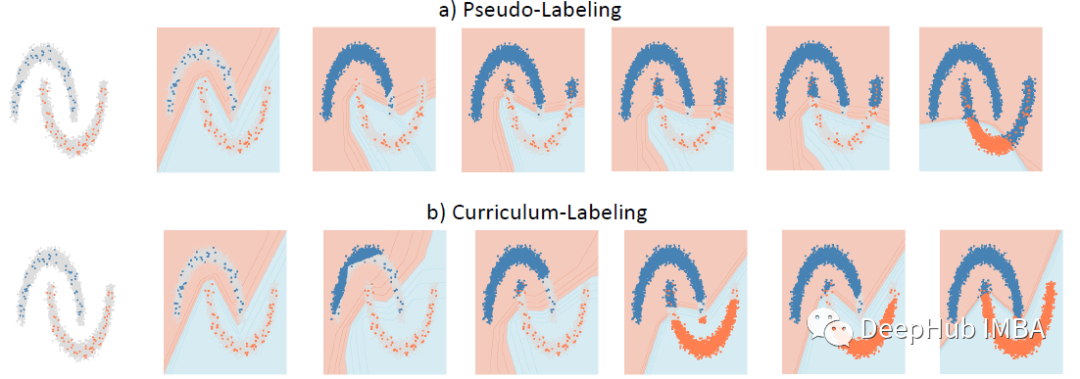

Curriculum Labeling:重新审视半监督学习的伪标签

Curriculum Labeling (CL),在每个自训练周期之前重新启动模型参数,优于伪标签 (PL)

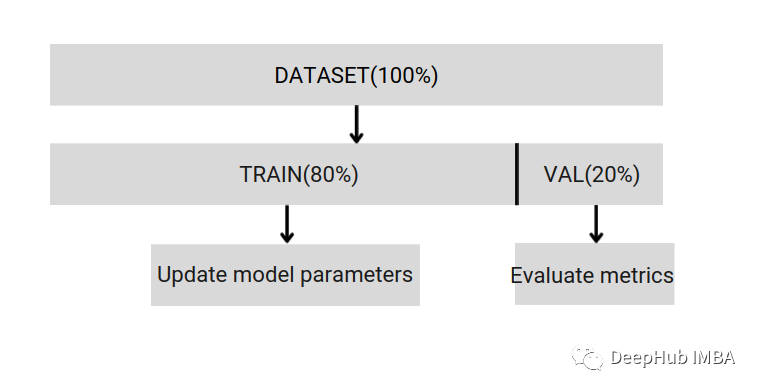

如何正确拆分数据集?常见的三种方法总结

拥有适当的验证策略是成功创建良好预测,使用AI模型的业务价值的第一步,本文中就整理出一些常见的数据拆分策略。

联合概率和条件概率的区别和联系

本文解释联合概率和条件概率之间区别和联系

使用神经网络模型创建一个龙与地下城怪物生成器

龙与地下城(DND)于1974年发行第一版,现在所有RPG游戏都有它的影子,在本文中我们将使用神经网络构建一个能够生成平衡数据的怪物生成器

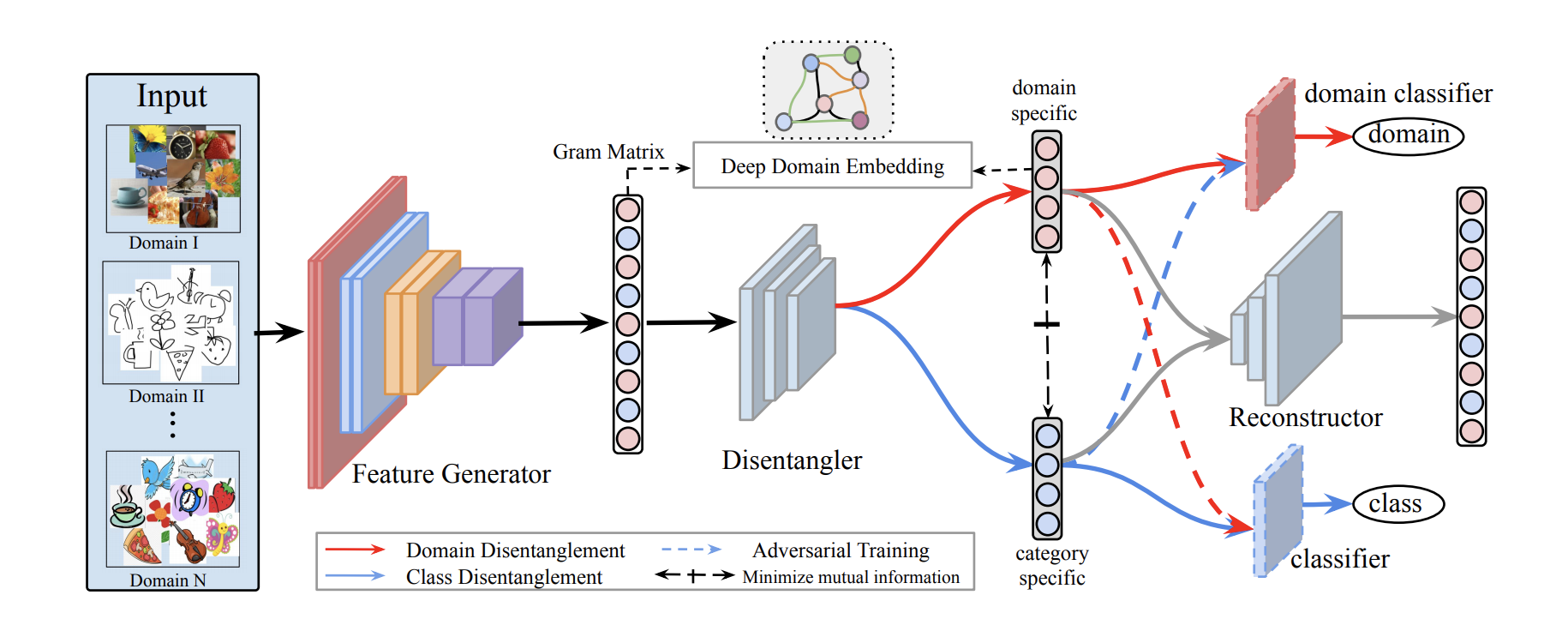

5篇关于特征嵌入的研究论文推荐

5篇最新的论文推荐

数据科学的面试的一些基本问题总结

在这篇文章中,将介绍如何为成功的面试做准备的,以及可以帮助我们面试的一些资源。

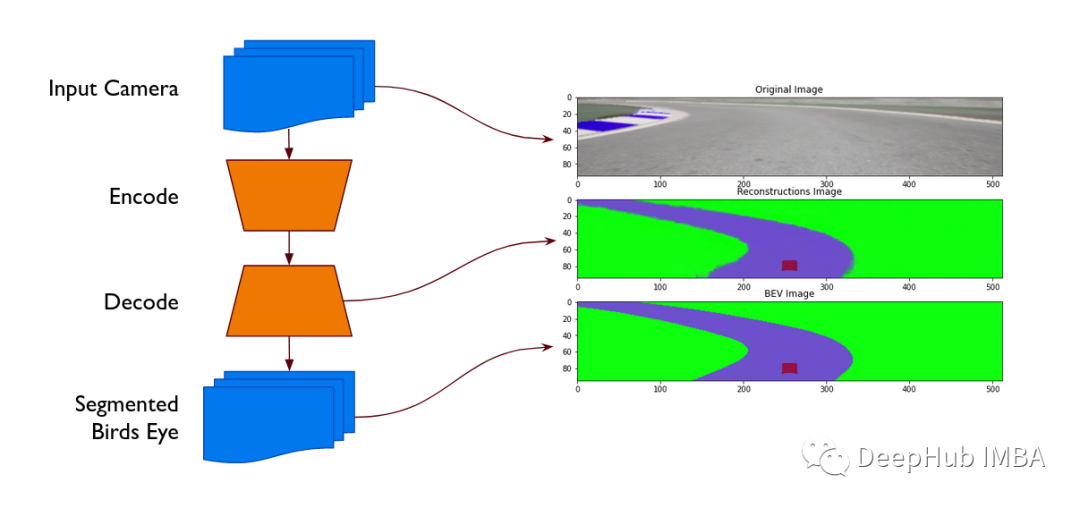

基于自动编码器的赛车视角转换与分割

本文将利用vae将汽车前置视像头的图像转换成分割后的鸟瞰图

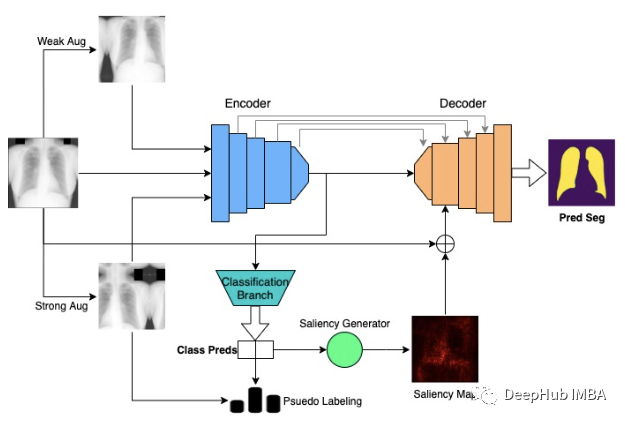

Multimix:从医学图像中进行的少量监督,可解释的多任务学习

在这篇文章中,我们解释了一个可用于联合学习分类和分割任务的新的稀疏监督多任务学习模型MultiMix。该论文使用四种不同的胸部x射线数据集进行了广泛的实验,证明了MultiMix在域内和跨域评估中的有效性。

使用贝叶斯优化进行深度神经网络超参数优化

在本文中,我们将深入研究超参数优化。

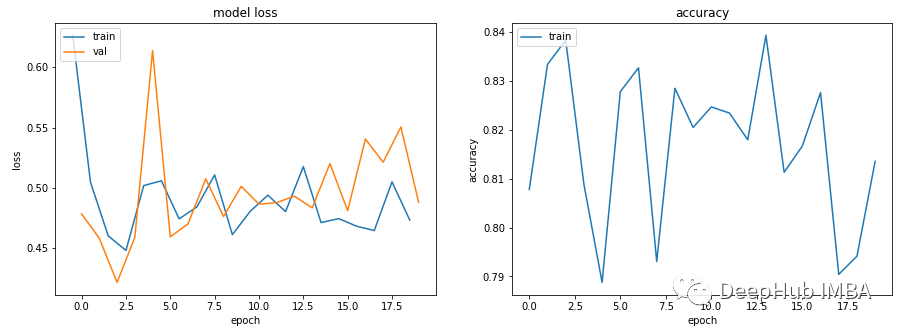

机器学习中训练和验证指标曲线图能告诉我们什么?

我们在训练和验证模型时都会将训练指标保存成起来制作成图表,这样可以在结束后进行查看和分析,但是你真的了解这些指标的图表的含义吗?

在不平衡数据上使用AUPRC替代ROC-AUC

ROC曲线和曲线下面积AUC被广泛用于评估二元分类器的性能。但是有时,基于精确召回曲线下面积 (AUPRC) 的测量来评估不平衡数据的分类却更为合适。

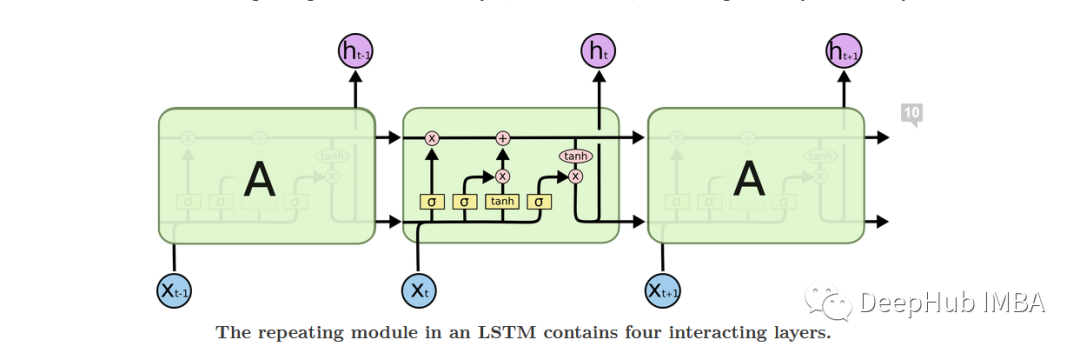

如何计算LSTM层中的参数数量

长短期记忆网络(通常称为“ LSTM”)是一种特殊的RNN,经过精心设计LSTM能够学习长期的依赖

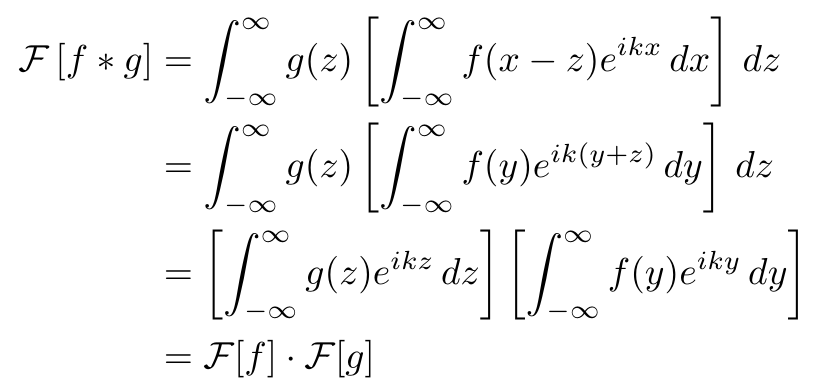

卷积神经网络中的傅里叶变换:1024x1024 的傅里叶卷积

本文介绍了卷积和DFT背后的数学理论,通过观察不同的光谱获得了一些想发,并且通过TensorFlow进行了实现,并验证了结果的正确性。

JAX介绍和快速入门示例

JAX 是一个由 Google 开发的用于优化科学计算Python 库,它可以被视为 GPU 和 TPU 上运行的NumPy,本文将介绍它的一些基本概念。

14个面试中常见的概率问题

在任何数据科学面试中,基本上都会问道一些有关概率的问题。 这在本文中我总结了一些相关的问题供大家参考。

论文推荐:TResNet改进ResNet 实现高性能 GPU 专用架构并且效果优于 EfficientNet

论文首先讨论了面向 FLOP 的优化引起的瓶颈。然后建议更好地利用 GPU 结构的设计。最后引入了一个新的 GPU 专用模型,称其为 TResNet。

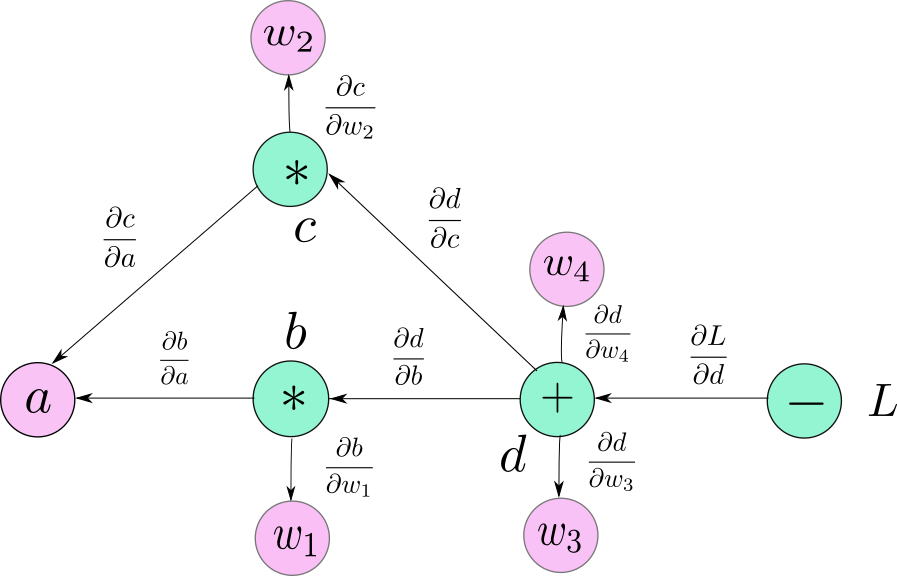

使用 Numpy 创建自己的深度学习框架

本文并不是为了造轮子,只是通过手动实现来介绍建基本深度学习框架所需组件和步骤

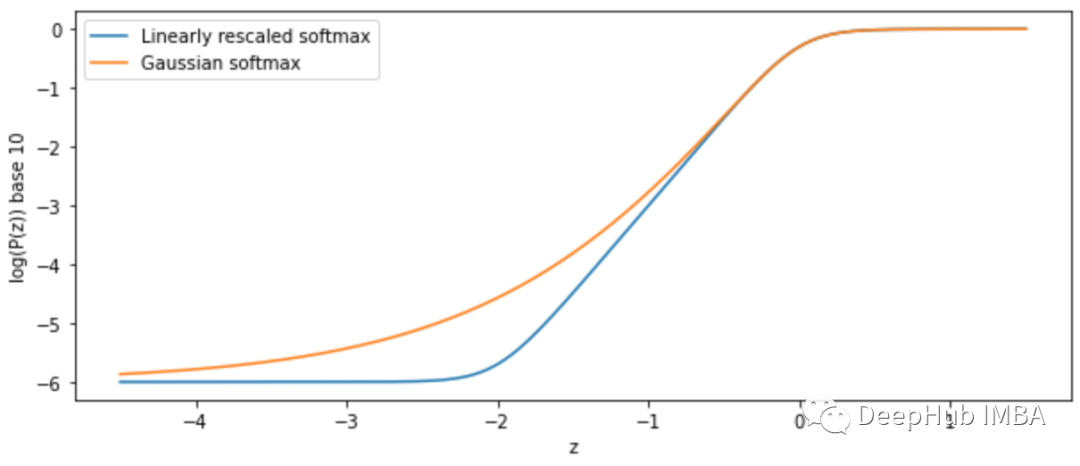

一个新的基于样本数量计算的的高斯 softmax 函数

本文提出了一种基于最小误差界和高斯统计量的softmax函数的安全快速扩展,可以在某些情况下作为softmax的替代