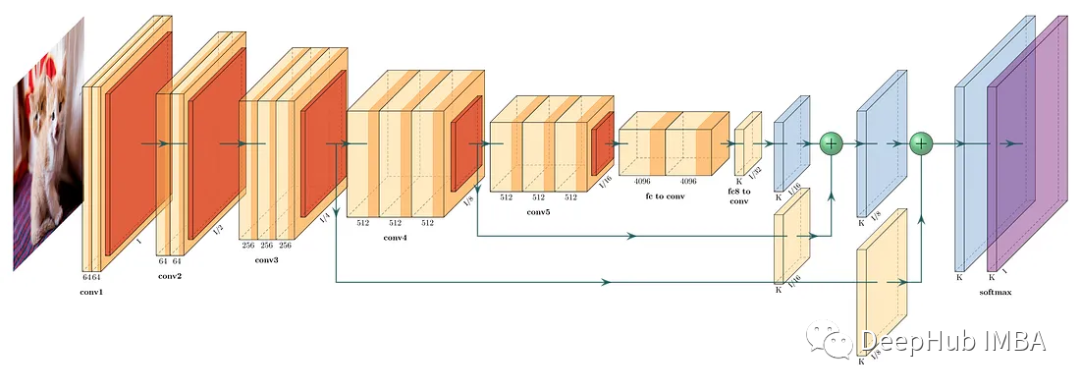

Transformer在计算机视觉中的应用-VIT、TNT模型

Transformer在计算机视觉中的应用-VIT算法

反向传播神经网络(BPNN)的实现(Python,附源码及数据集)

本文对反向传播神经网络(BPNN)的理论基础进行介绍,之后使用Python实现基于BPNN的数据预测,通俗易懂,适合新手学习,附源码及实验数据集。

RF模型(随机森林模型)详解

入门小菜鸟,希望像做笔记记录自己学的东西,也希望能帮助到同样入门的人,更希望大佬们帮忙纠错啦~侵权立删。一、RF简介RF模型属于集成学习中的bagging流派1、集成学习简介集成学习分为2派:(1)boosting:它组合多个弱学习器形成一个强学习器,且各个弱学习器之间有依赖关系。(2)baggin

CNN经典网络模型(五):ResNet简介及代码实现(PyTorch超详细注释版)

CNN经典网络模型之一:ResNet,本文包含其简介及代码,在PyTorch中实现,进行超详细注释,适合新生小白阅读学习~

经典神经网络论文超详细解读(七)——SENet(注意力机制)学习笔记(翻译+精读+代码复现)

SENet论文(《Squeeze-and-Excitation Networks》)超详细解读。翻译+总结。文末有代码复现

异构图神经网络 RGCN、RGAT、HAN、GNN-FILM + PyG实现

RGCN、RGAT、GNN-FILM代码替换十分简单,训练代码完全不用动,只要改模型代码即可,完全可以三者都尝试效果,HAN慎用,效果太吃matapath的设置,训练时间还长,不值得。

详解Inception结构:从Inception v1到Xception

详细介绍了GoogLeNet中Inception模块网络结构的发展历程,包括了Inception v1,Inception v2,Inception v3,Inception v4,Xception结构及特点。

ConvLSTM时空预测实战代码详解

ConvLSTM代码复现

【动手深度学习-笔记】注意力机制(四)自注意力、交叉注意力和位置编码

像这样的,查询、键和值来自同一组输入的注意力机制,被称为自注意力(self-attention)或者内部注意力(intra-attention)。总而言之,卷积神经网络和自注意力都拥有并行计算的优势,而且自注意力的最大路径长度最短。DETR中,为了保留特征的空间信息,没有将二维数据平铺为一维,而是分

2023年3月的10篇论文推荐

本文整理的是本月应该阅读的10篇论文,将包括多模态语言模型、扩散模型、机器翻译等主题。

GPT-4 和ChatGPT API的定价分析

OpenAI发布了他们的ChatGPT新机器学习模型GPT-4。GPT-4是GPT-3的一大进步,GPT-3是当前ChatGPT免费版本(GPT 3.5 Turbo)所运行的模型的基础,今天我们也来凑个热点,研究一下它们的定价

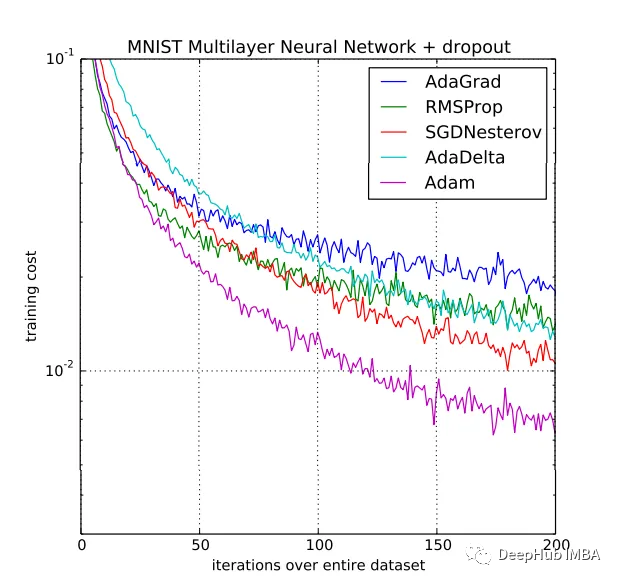

SDG,ADAM,LookAhead,Lion等优化器的对比介绍

本文将介绍了最先进的深度学习优化方法,帮助神经网络训练得更快,表现得更好。有很多个不同形式的优化器,这里我们只找最基础、最常用、最有效和最新的来介绍。

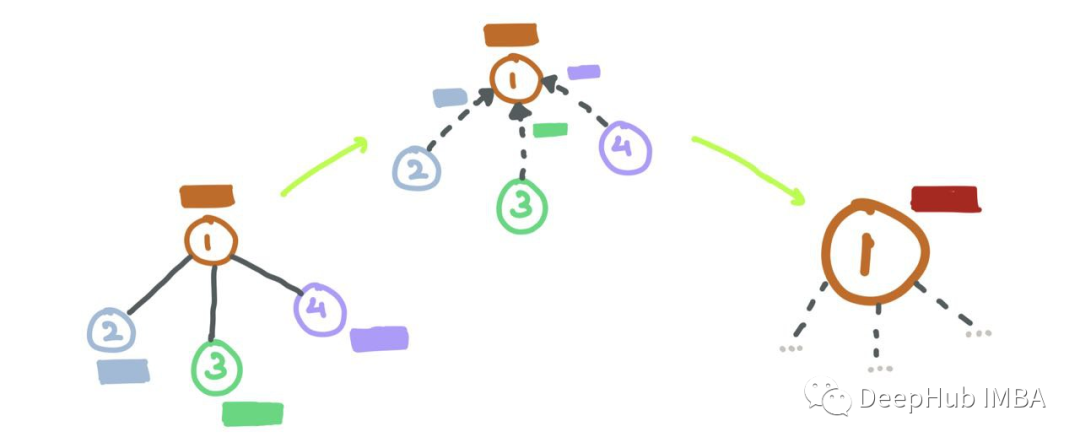

一文通俗讲解元学习(Meta-Learning)

©PaperWeekly 原创 ·作者 | 孙裕道学校 | 北京邮电大学博士生研究方向 | GAN图像生成、情绪对抗样本生成元学习(meta-learning)是过去几年最火爆的学习方法...

基于Halcon的MLP(多层感知神经网络)分类器分类操作实例

【代码】基于Halcon的MLP(多层感知神经网络)分类器分类操作实例。

图神经网络的数学原理总结

图深度学习(Graph Deep Learning) 多年来一直在加速发展。本文将流行的图神经网络及其数学细微差别的进行详细的梳理和解释

【轴承数据读取及信号处理专题】之EMD分解及统计特征提取

PHM 2012滚动轴承EMD分解和统计特征提取的代码实现

PlotNeuralNet + ChatGPT创建专业的神经网络的可视化图形

PlotNeuralNet:可以创建任何神经网络的可视化图表,并且这个LaTeX包有Python接口,我们可以方便的调用。

什么是图神经网络?

GNN 将深度学习的预测能力应用于丰富的数据结构,这些数据结构将对象及其关系描述为图中由线连接的点。

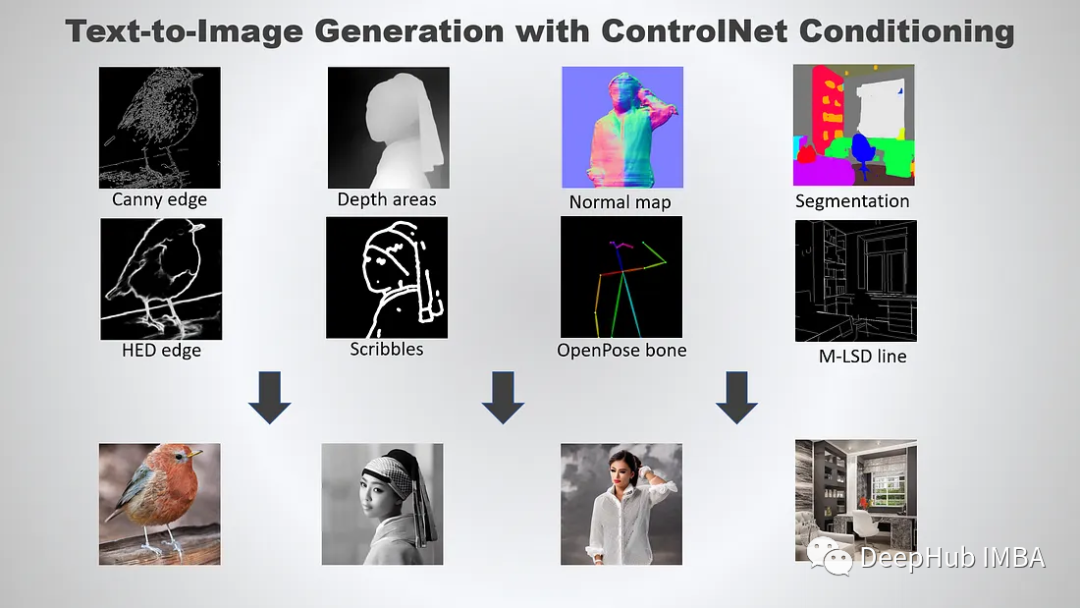

使用ControlNet 控制 Stable Diffusion

本文将要介绍整合HuggingFace的diffusers 包和ControlNet调节生成文本到图像,可以更好地控制文本到图像的生成