开源模型应用落地-qwen模型小试-调用Qwen2-VL-7B-Instruct-更清晰地看世界(一)

掌握Qwen2-VL提升职业发展增添强大的竞争力

Spark 和 NVIDIA GPU 加速深度学习

随着人们对深度学习( deep learning , DL )兴趣的日益浓厚,越来越多的用户在生产环境中使用 DL。由于 DL 需要强大的计算能力,开发人员正在利用 gpu 来完成他们的训练和推理工作。最近,为了更好地统一 Spark 上的 DL 和数据处理,作为的一项重大举措的一部分, GPU 成

时频分析法——连续小波变换(CWT)

连续小波变换利用一组基函数(称为小波)对信号进行分析。这些小波是由一个母小波通过平移和缩放生成的。母小波 ψ(t) 是一个平均值为零的波形,通常具有快速衰减的特性。通过调整缩放因子 a 和平移参数 b 来生成不同的小波,从而能够聚焦于信号的不同特性。小波变换可以定义为:其中f(t) 是输入信号;ψ(

天池 大模型逻辑推理 入门

第二届世界科学智能大赛逻辑推理赛道:复杂推理能力评估

机器学习,深度学习,AGI,AI的概念和区别

人工智能(AI)是指通过计算机系统模拟人类智能的技术和科学。AI的目标是创建能够执行通常需要人类智能的任务的系统,如视觉识别、语音识别、决策制定和语言翻译。AI的核心在于其能够处理和分析大量数据,从中提取有用的信息,并根据这些信息做出决策或预测。AI的发展可以追溯到20世纪50年代,当时科学家们开始

【深度学习】使用VScode远程服务器GPU进行训练

我这里使用的是mobaxterm来传输文件,视频中的作者使用的是另外一种软件,大家都可以尝试使用,我是因为电脑中本来就有这个mobaxterm就懒得下载up推荐的那个了。下载好mobaxterm之后我们打开它,点击。打开vscode,在插件管理处安装插件。回车之后即可连接成功!

AI生成人脸图像鉴别-数据集(附网盘地址)

百度网盘地址:链接: https://pan.baidu.com/s/1_3j0OwQF63eznPH1RR596g?pwd=1234 提取码: 1234 复制这段内容后打开百度网盘手机App,操作更方便哦。该数据集有5000张真实人脸照片,尺寸为1024*1024像素,即比例为1:1,均为人工筛选

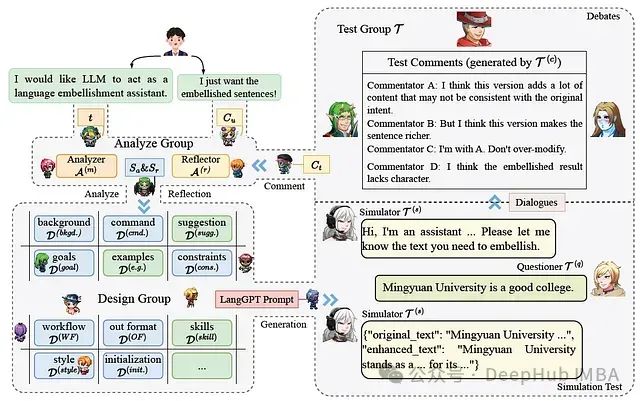

Minstrel自动生成结构化提示,让AI为AI写提示词的多代理提示生成框架

在人工智能快速发展的今天,如何有效利用大型语言模型(LLMs)成为了一个普遍关注的话题。这是9月份的一篇论文,提出了LangGPT结构化提示框架和Minstrel多代理提示生成系统,为非AI专家使用LLMs提供了强大支持。

Datawhale X 李宏毅苹果书 AI夏令营 Task2- 优化机器学习模型和深度学习初认识

一、初识线性模型在上一篇的Task1中,我们最后谈到了梯度下降在一维和二维情况下的过程,现在让我们进一步地讨论机器学习这个话题。Task1里,我们举了用今天的数值预测明天的观看量的例子,下面是根据真实数据所做的图,预测时所用到的模型函数是贴合现实的。从图中,我们可以清晰地看到红线与蓝线是几乎重合的,

斯坦福大学研究人员,推荐的课题申报AI提示词分享

请根据这份项目清单<插入项目>,为我的资助提案制定一个可行的项目时间表,用于我的职业发展计划,从<XX月>开始,为期<XX个月>。请就我如何满足这一评审标准:<插入具体评审标准>提供反馈,以及对我遗漏的内容和如何改进的建议。请就我如何满足这一评审标准:<插入具体评审标准>提供反馈,以及对我遗漏的内容

大模型API调用(一)简单用法

大模型API调用是指通过编程接口(API)访问大型人工智能模型,以实现自然语言处理、代码生成、内容创作等多种功能。大模型的API扮演了一个接口(Interface)的角色,它允许用户以编程方式与大模型进行交互,而无需深入了解模型内部的复杂结构和算法。这种模式类似于模型即服务(Model as a S

开源模型应用落地-业务优化篇(七)

通过多种技术整合,为降本增效赋能,让公司对你眼前一亮。本篇学习RocketMQ的实际使用。

SparkHBase整合原理与代码实例讲解

Spark-HBase整合原理与代码实例讲解1. 背景介绍1.1 问题的由来在大数据时代,数据量的快速增长使得传统的数据处理方式已经无法满足现有需求。Apache Spark和Apache HBase作为两个广泛使用的大数据处

数据可视化:PrestoHive数据可视化方案

数据可视化:Presto-Hive数据可视化方案1. 背景介绍1.1 数据可视化的重要性在当今大数据时代,企业每天都会产生海量的数据。如何有效地分析和利用这些数据,已经成为企业获得竞争优势的关键。数据可视化技术能够

vision mamba 原理篇

与 transformer中注意力机制不同,S6 将 1D 向量中的每个元素(例如文本序列)与在此之前扫描过的信息进行交互,从而有效地将二次复杂度降低到线性。然而,由于视觉信号(如图像)不像文本序列那样具有天然的有序性,因此无法在视觉信号上简单地对 S6 中的数据扫描方法进行直接应用。在 CSM 的

IJCAI 2024 | 时空数据(Spatial-Temporal)论文总结

2024 IJCAI(International Joint Conference on Artificial Intelligence, 国际人工智能联合会议)在2024年8月3日-9日在举行。本文总结了IJCAI2024有关的相关论文,如有疏漏,欢迎大家补充。:时空(交通)预测,气象预测,轨迹

Lumen5——AI视频制作,提取关键信息生成带有视觉效果的视频

模板系统:Lumen5 提供了多种预设视频模板,涵盖不同的使用场景(如市场营销、社交媒体视频等)。这些模板通过前端与后端的集成动态加载,用户可以快速选择并应用。模板样式的自动化设计可能使用了基于设计原则的推荐系统,确保视觉上的统一性。品牌元素定制:高级用户可以上传自定义的品牌标志、选择特定的字体和配

在Pytorch中为不同层设置不同学习率来提升性能,优化深度学习模型

为网络的不同层设置不同的学习率可能会带来显著的性能提升。本文将详细探讨这一策略的实施方法及其在PyTorch框架中的具体应用

【AI战略思考2】技术上不断聚焦和深入,精进一艺,一技胜万全

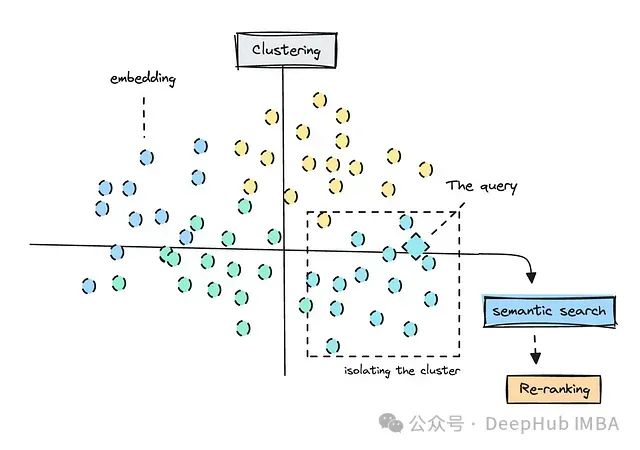

本篇博客确定了我大致的研究方向和原则:研究方向:nlp领域下的RAG技术应用方向,企业普遍存在的一个痛点和难点,且有较大的实用价值。原则:不断聚焦和深入