LYT-Net——轻量级YUV Transformer 网络低光照条件图像修复

低光照图像增强(LLIE)是计算机视觉(CV)领域的一个重要且具有挑战性的任务。在低光照条件下捕获图像会显著降低其质量,导致细节和对比度的丧失。这种退化不仅会导致主观上不愉快的视觉体验,还会影响许多CV系统的性能。LLIE的目标是在提高可见度和对比度的同时,恢复暗环境中固有的各种失真。低光照条件指的

多模态AI:原理、应用与未来展望

多模态AI技术正引领着人工智能的发展方向,通过融合多种数据类型,提供更智能的解决方案。尽管面临诸多挑战,未来的多模态AI系统将变得更加智能、自适应和强大,推动各行各业的智能化进程。通过不断探索和创新,我们将迎来一个更加智能化的未来。

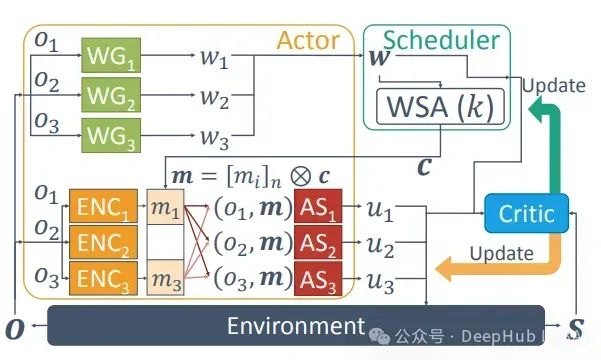

多代理强化学习综述:原理、算法与挑战

多代理强化学习是强化学习的一个子领域,专注于研究在共享环境中共存的多个学习代理的行为。每个代理都受其个体奖励驱动,采取行动以推进自身利益

大模型科普:大模型与传统AI的区别

本文详尽地介绍了大模型(特别是大规模语言模型LLM)的基本概念、与传统AI的区别、训练过程以及生成答案的机制,这对于理解当前AI技术的前沿进展非常有帮助。

开源模型应用落地-模型微调-模型研制-模型训练(二)

通过微调让预训练模型更好地适应各种特定任务的要求

Dify:一个简化大模型应用的开源平台

Dify 是一个开源的 AI 应用开发平台,旨在帮助开发者简化大语言模型 (LLM) 应用的开发、部署和管理。无论开发者是否拥有机器学习背景,Dify 通过友好的界面和强大的工具,帮助快速实现 AI 应用的构建与交付。它具备丰富的功能模块,涵盖提示工程、数据集管理、模型集成、API 部署以及 LLM

AI基本概念(人工智能、机器学习、深度学习)

一、概述ChatGPT 3.5是OpenAI在ChatGPT系列基础上进行改进的一款AI模型,它在自然语言处理方面展现出了非常强大的能力,能够进行对话、阅读、生成文本等多种任务。二、主要特点模型规模与参数:ChatGPT 3.5的预训练模型包含了1750亿个参数,是目前最大的自然语言处理模型之一。多

华为开源自研AI框架昇思MindSpore应用案例:计算高效的卷积模型ShuffleNet

华为开源自研AI框架昇思MindSpore应用案例:计算高效的卷积模型ShuffleNet

机器学习中的并行与分布式深度学习:C/C++实现详解

并行深度学习是指在单台机器或单个集群内通过并行处理来加速模型训练。数据并行(Data Parallelism):将数据划分为多个部分,同时在多个处理器上训练同一个模型副本。模型并行(Model Parallelism):将模型的不同部分划分到不同的处理器上,在每个处理器上运行模型的一部分,适用于特别

如何搭建10万个H100 GPU的集群:电力、并行化、网络拓扑与成本优化

在现代人工智能的发展中,构建大规模GPU集群是提升计算能力的关键手段。今天我们探讨如何搭建一个包含10万个H100 GPU的集群。这个项目不仅涉及巨大的资本支出,还面临电力供应、并行化处理、网络拓扑结构以及可靠性和恢复等多方面的挑战。通过深入分析这些问题,本文将为大家揭示构建如此庞大集群的复杂性和关

动态注意力机制新突破!11个最新idea,看了就能发顶会!

在处理复杂数据时,可以通过引入,让模型根据输入数据的特点动态调整关注点,聚焦最关键的信息,来提高模型的处理能力和效率。这种比传统方法更高效、灵活的技术足以应对各种复杂任务和挑战,具有强大的适应性,因此它的应用范围非常广泛,创新空间也很大,是深度学习领域的一个热门研究方向。目前常见的关于动态注意力机制

图像数据增强库综述:10个强大图像增强工具对比与分析

本文旨在全面介绍当前广泛使用的图像数据增强库,分析其特点和适用场景,以辅助研究人员和开发者选择最适合其需求的工具。

【AI大模型】深入Transformer架构:编码器部分的实现与解析(下)

在Transformer中前馈全连接层就是具有两层线性层的全连接网络。前馈全连接层的作用是考虑注意力机制可能对复杂过程的拟合程度不够, 通过增加两层网络来增强模型的能力.

【自用】动手学深度学习——跟李沐学AI要点

自用,是学习实时笔记,未条条记录,没有进一步加工组织语言,按需查看。

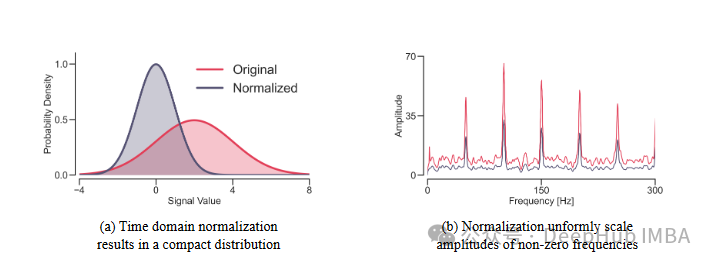

FredNormer: 非平稳时间序列预测的频域正则化方法

FredNormer的核心思想是从频率角度观察数据集,并自适应地增加关键频率分量的权重。

2024 Google 开发者大会:AI 如何引领技术创新浪潮?

2024 Google 开发者大会展示了 AI 技术在各个领域的创新应用,从 Gemma 2 和 Gemini API 等核心技术的突破,到 Google AI Studio 这样的一站式开发平台,再到非遗保护和特殊教育等传统领域的创新应用。这些进展不仅展示了 AI 技术的巨大潜力,也为开发者提供了

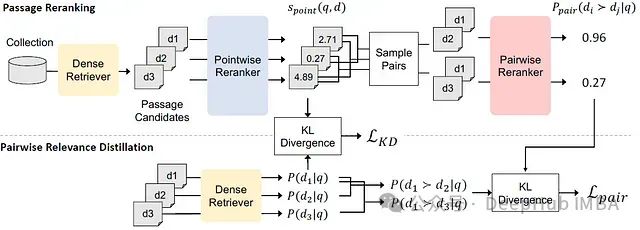

PAIRDISTILL: 用于密集检索的成对相关性蒸馏方法

成对相关性蒸馏(Pairwise Relevance Distillation, PAIRDISTILL)。

WebAuthn 的实施步骤

WebAuthn 的实施步骤1. 背景介绍1.1 问题的由来在互联网时代,身份验证是网络安全的基石。传统的用户名和密码验证方式存在诸多安全隐患,例如容易被盗取、用户密码设置过于简单等。为了解决这些问题,WebAuthn 应运而生,它是一种基于

Magisto——AI分析视频素材,自动生成剪辑、拼接和添加音乐的成品视频

Magisto 是一个强大的视频编辑工具,特别适合没有专业视频编辑技能的用户。通过自动化的编辑流程和丰富的模板选择,用户可以轻松创建出高质量的视频内容,适用于个人记忆分享、社交媒体推广、商业宣传等多种场景。Magisto 利用人工智能和机器学习技术,结合先进的视频处理和图像处理技术,提供了一个功能强

DeepArt——AI美术创作工具,能够帮助生成视觉内容

DeepArt 通过将卷积神经网络、神经风格迁移、图像优化与生成对抗网络等技术有机结合,实现了将传统艺术风格迁移到现代图像上的功能。它的核心技术依赖于内容和风格的分离、复杂损失函数的设计、多层次特征融合以及高效的迭代优化过程,使得生成图像既具备艺术风格又保留了原始图像的结构和细节。