开源模型应用落地-sherpa-onnx-AIGC应用探索(十)

使用sherpa-onnx,一站式解决各种语音难题。

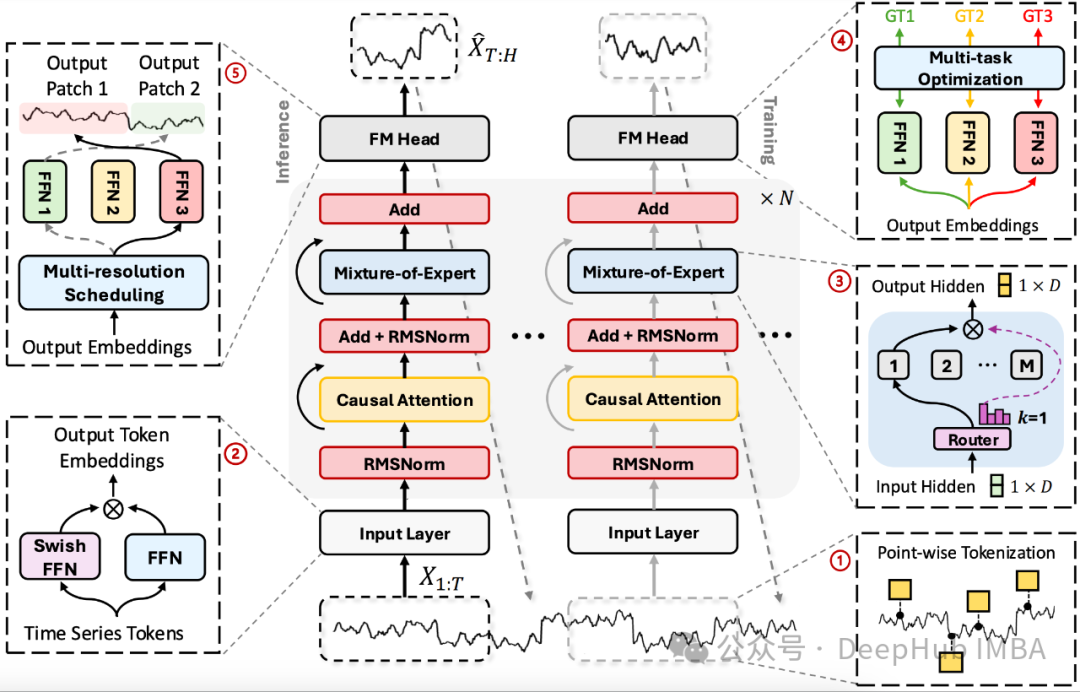

TimeMOE: 使用稀疏模型实现更大更好的时间序列预测

这是9月份刚刚发布的论文TimeMOE。它是一种新型的时间序列预测基础模型,"专家混合"(Mixture of Experts, MOE)在大语言模型中已经有了很大的发展,现在它已经来到了时间序列。

GNN会议&期刊汇总(人工智能、机器学习、深度学习、数据挖掘)

顶会顶刊:【NeurIPS】【ICLR】【AAAI】【WWW】【ICML】【LoG】【CIKM】【WSDM】【KDD】【IJCAI】【TKDE】

Wordware暴走:AI社交裂变的妙用与隐患探讨

最近,推特(X)上出现了一个风靡全球的社交应用——**Wordware**。该应用引发了一场社交裂变的热潮,连埃隆·马斯克都参与其中,展示了它的社交吸引力。然而,伴随这一现象的爆发,也让我们看到了AI技术在社交网络中的巨大潜力与隐患。本文将通过技术分析与案例解读,详细探讨Wordware的妙用及其背

司南 OpenCompass 5 月榜单揭晓,全新大模型对战榜单首次登场

司南 OpenCompass 团队针对国内外主流大语言模型进行了全面评测,现已公布 2024 年 5 月大语言模型最新评测榜单!与此同时,CompassArena 大模型对战榜单 也于今日首次重磅上线!

开源模型应用落地-LangChain实用小技巧-使用CacheBackedEmbeddings组件(九)

使用CacheBackedEmbeddings组件提升处理效率和数据可靠性

差分隐私与联邦学习安全原理与代码实战案例讲解

差分隐私与联邦学习安全原理与代码实战案例讲解作者:禅与计算机程序设计艺术 / Zen and the Art of Computer Programming1. 背景介绍1.1 问题的由来随着大数据时代的到来,

Coggle数据科学 | 科大讯飞AI大赛:人岗匹配挑战赛 赛季3

讯飞智聘是一款面向企业招聘全流程的智能化解决方案。运用科大讯飞先进的智能语音、自然语言理解、计算机视觉等AI技术及大数据能力,具备业界领先的简历解析、人岗匹配、AI面试、AI外呼等产品功能,助力企业提升招聘效率,降低招聘成本。人岗匹配是企业招聘面临一个重大挑战,尤其在校园招聘等集中招聘的场景下,面对

Programmer&AI—AI辅助编程学习指南

随着AIGC(AI生成内容)技术的快速发展,诸如ChatGPT、MidJourney和Claude等大语言模型相继涌现,AI辅助编程工具正逐步改变程序员的工作方式。这些工具不仅可以加速代码编写、调试和优化过程,还能帮助解决复杂的编程难题。然而,这种变革也引发了广泛的讨论:一方面,有人担心AI会逐步取

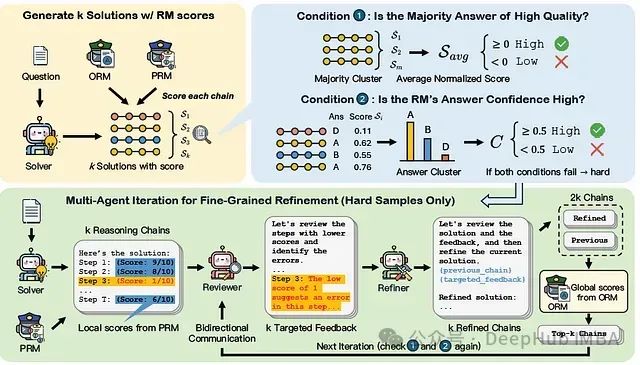

MAGICORE:基于多代理迭代的粗到细精炼框架,提升大语言模型推理质量

论文提出了MAGICORE,一个用于粗到细精炼的多代理迭代框架。MAGICORE旨在通过将问题分类为简单或困难,为简单问题使用粗粒度聚合,为困难问题使用细粒度和迭代多代理精炼,从而避免过度精炼。

optim.Adam()

torch.optim优化算法理解之optim.Adam()-CSDN博客PyTorch优化算法:torch.optim.Adam 的参数详解和应用-CSDN博客optim.Adam是 PyTorch 中一种非常流行的优化器,它是 Adam(Adaptive Moment Estimation)优化

d2l-ai深度学习日记之预备知识(一)

在我进行计算机学习的今天,正是ChatGpt等语言大模型火热的时间,并且当前国内就业形式严峻,想要考研深造,不得不接触深度学习,神经网络等等生涩难懂,以前研究生才会学习的知识.在写这篇文章之前,我已经稍微接触后了解了一下神经网络等相关知识,尝试地参加了一些相关的比赛等等,但是还是感觉完全不理解,所有

Transformer大模型实战 文本摘要任务

随着互联网和数字化时代的到来,每天产生的文本数据量呈爆炸式增长。如何有效地从这些海量的文本数据中提取关键信息,快速获取知识,成为了一个亟待解决的问题。文本摘要任务,作为一种信息提取技术,旨在自动生成文本的简洁、概括的版本,从而帮助用户快速了解文本内容。文本摘要任务主要分为两种类型:抽取式摘要和生成式

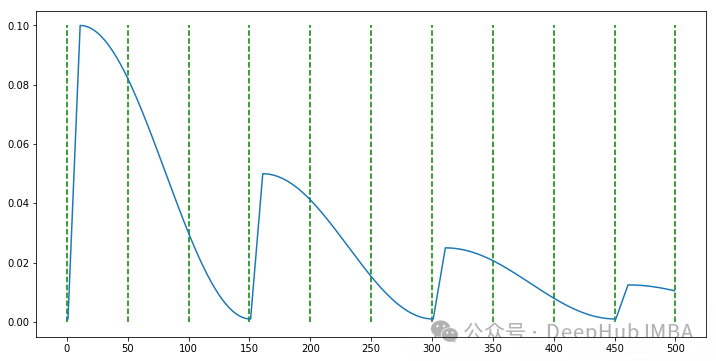

PyTorch自定义学习率调度器实现指南

本文将详细介绍如何通过扩展PyTorch的 ``` LRScheduler ``` 类来实现一个具有预热阶段的余弦衰减调度器。我们将分五个关键步骤来完成这个过程。

大模型获取embdding

以qwen为例:本文将使用 Hugging Face 的库来完成这些步骤。这是一个非常流行且功能强大的库,用于处理各种预训练语言模型。

DDPM代码实现详解

本文介绍了如何用Pythrch实现DDPM

论文阅读 | 基于流模型和可逆噪声层的鲁棒水印框架(AAAI 2023)

提出一种基于流的鲁棒数字水印框架,该框架采用了可逆噪声层来抵御黑盒失真。

Datawhale AI 夏令营(第五期)——向李宏毅学深度学习(进阶)——2

自适应学习率是一种在深度学习模型训练中通过自动调整学习率以适应不同参数需求的优化方法。传统的固定学习率在所有参数上都使用同样的更新步伐,但在实际应用中,模型的不同参数可能表现出不同的灵敏度,因此需要不同的学习率来有效地优化。自适应学习率方法如 AdaGrad、RMSProp 和 Adam,通过跟踪每

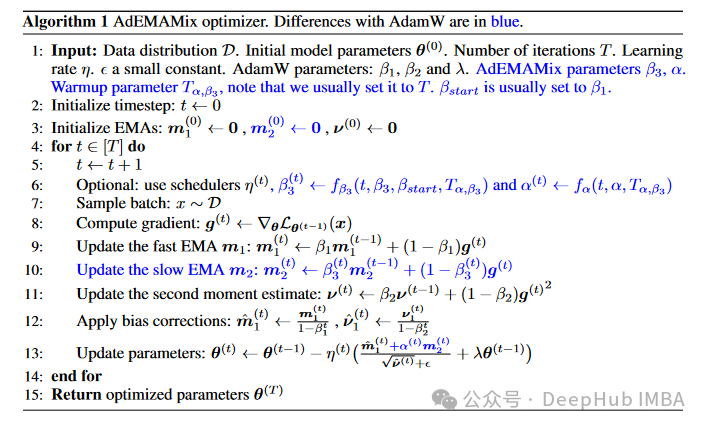

AdEMAMix: 一种创新的神经网络优化器

这种算法旨在解决当前广泛使用的Adam及其变体(如AdamW)在利用长期梯度信息方面的局限性。研究者们通过巧妙地结合两个不同衰减率的指数移动平均(EMA),设计出了这种新的优化器,以更有效地利用历史梯度信息。

智能创造的幕后推手:AIGC浪潮下看AI训练师如何塑造智能未来

本书内容系统、全面,实例丰富,共有10章,包括51个实操案例解析和80个行业案例分析。通过学习本书,读者可以从零开始,逐步掌握人工智能的核心技术,成为合格的AI训练师。本书附赠了同步教学视频+PPT 教学课件+素材+效果+AI提示词等资源。书中内容从技能线和案例线展开介绍,具体内容如下。