AI辅写疑似度多少正常:Perplexity与Burstiness的解读

通过平衡perplexity和burstiness,结合个性化写作风格的体现和合理使用AI辅写工具,我们可以获得更低的疑似度。通过独特的词汇选择、句式结构和内容编排,创作者可以增加文本的多样性和独特性,从而降低perplexity和burstiness。通过使用这些工具,我们可以更好地了解AI辅写生

【环境搭建:onnx模型部署】onnxruntime-gpu安装与测试(python)

onnx模型部署环境创建

【机器学习】全网最全模型评价指标(性能指标、YOLOv5训练结果分析、轻量化指标、混淆矩阵详解)【基础收藏】

【机器学习】全网最全模型评价指标(性能指标、YOLOv5训练结果分析、轻量化指标、混淆矩阵详解)【基础收藏】

AI:133-基于深度学习的工业质检自动化

在当今工业领域,质检是确保产品质量和制造流程可靠性的关键环节。随着人工智能技术的飞速发展,基于深度学习的工业质检自动化成为一项引人注目的创新。本文将深入探讨如何利用深度学习技术实现工业质检的自动化,并提供代码实例以展示其应用。

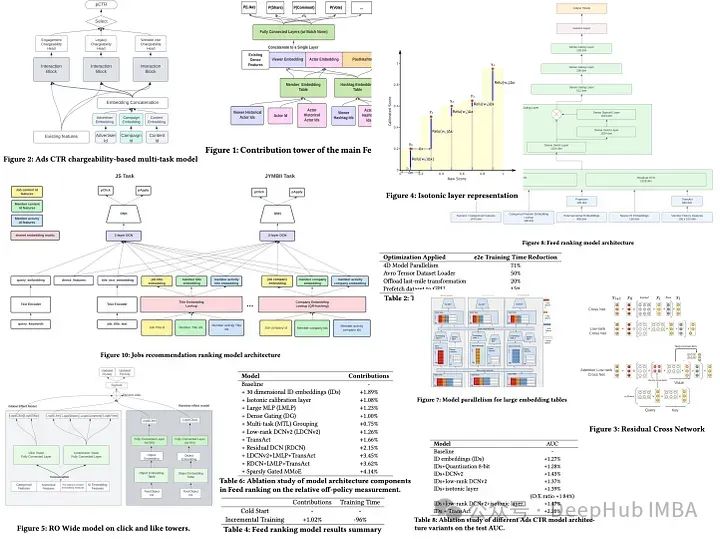

LiRank: LinkedIn在2月新发布的大规模在线排名模型

LiRank是LinkedIn在2月份刚刚发布的论文,它结合了最先进的建模架构和优化技术,包括残差DCN、密集门控模块和Transformers。

AI:132-基于深度学习的涉案人脸图像识别与敲诈勒索嫌疑分析

人工智能(AI)在不同领域的应用不断拓展,其中基于深度学习的人脸图像识别技术在刑事侦查领域具有巨大潜力。本文将探讨如何利用深度学习算法对涉案人脸图像进行识别,并结合敲诈勒索嫌疑分析,以提高刑事侦查效率。同时,我们将提供一个简单的代码实例,以帮助读者更好地理解这一技术的实现过程。

毕业设计-基于深度学习的水面垃圾目标检测系统 YOLO python 目标检测 人工智能 卷积神经网络 机器学习

毕业设计-基于深度学习的水面垃圾目标检测系统的计算机毕业设计。水面垃圾对海洋生态环境和人类健康造成严重威胁,因此快速、准确地检测和识别水面垃圾成为一项迫切需求的任务。本设计采用了YOLOv5算法和深度学习技术,实现了对水面垃圾的自动化检测和分类。通过训练深度学习模型,将水面图像输入系统,实现对塑料瓶

开题报告ai免费吗?论文ai写作免费

AIPaperPass是AI原创论文写作平台,免费千字大纲,5分钟生成3万字初稿,提供答辩汇报ppt、开题报告、任务书等,40篇真实中英文知网参考文献,重复率超过10%包退费。不过,需要提醒的是,虽然AI写作工具可以提供便利,但并不能完全代替人类的思考和创造力。有些AI写作平台提供免费试用或免费生成

2024年应该关注的十大人工智能创新

2024年将是人工智能创新的一个非凡之年,其进步将影响我们生活的几乎每个方面。从医疗到教育,从交通到内容创作,人工智能都将彻底改变我们的生活和工作方式。拥抱这些即将到来的人工智能创新,为一个充满激动和变革的未来做好准备。当我们踏入2024年时,很明显人工智能将成为我们前进道路上不可或缺的一部分。最后

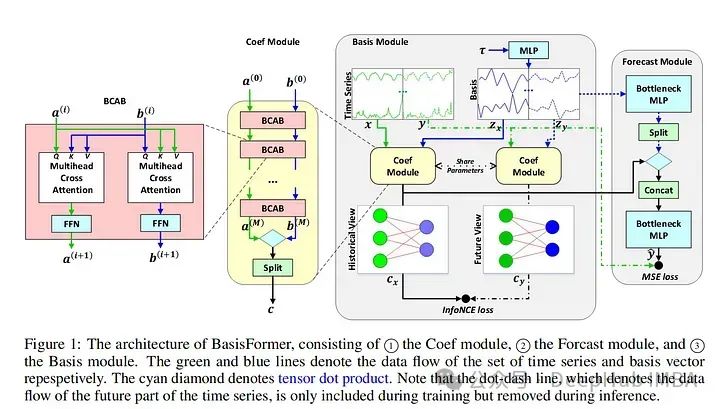

深度学习在时间序列预测的总结和未来方向分析

我们这篇文章就来总结下2023年深度学习在时间序列预测中的发展和2024年未来方向分析

【深度学习 AIGC】stable diffusion webUI 使用过程,参数设置,教程,使用方法

作者提出了"无分类器引导生成"(Classifier-Free Guidance)的概念,其中使用两个梯度预估模型,一个是无条件生成的梯度预估模型,另一个是基于条件的梯度预估模型,避免了显式分类器的缺陷。Clip Skip是一个用于控制CLIP神经网络在生成图像时处理提示文本的深度的设置,它可以影响

StableDiffusionWebUI界面基本布局和操作

一般用于复制别人参数然后自动填充所有字段,以便您在按下“生成”按钮时生成相同的图像。请注意,将设置种子和模型覆盖。如果这不是您想要的,请将种子设置为 -1 并删除覆盖。

人工智能 | 深度学习的进展

深度学习是人工智能领域的一个重要分支,它利用神经网络模拟人类大脑的学习过程,通过大量数据训练模型,使其能够自动提取特征、识别模式、进行分类和预测等任务。如今,深度学习已经取得了许多令人瞩目的新进展,下面我将为您详细介绍。

AI论文速读 | 2024【综述】图神经网络在智能交通系统中的应用

智能交通系统(ITS)在缓解交通拥堵、降低交通事故发生率以及提升城市规划效率等方面扮演着至关重要的角色。但由于交通网络结构的复杂性,传统的机器学习及统计方法正逐渐显得不足以应对这些挑战。随着人工智能时代的来临,深度学习框架在众多领域取得了突破性的进展,并且被广泛认为是解决这些复杂问题的有效手段。特别

视频生成领域的发展概述:从多级扩散到LLM

在这篇文章中,我们将整理视频生成在最近几年是发展概况,模型的架构是如何发展的,以及现在面临的突出问题。

探索模块化神经网络在现代人工智能中的功效和应用

在快速发展的人工智能领域,模块化神经网络 (MNN) 已成为一项关键创新。与遵循整体方法的传统神经网络架构不同,MNN 采用分散式结构。本文深入探讨了 MNN 的基础知识、它们的优势、应用以及它们带来的挑战。

AI:131- 法律文件图像中的隐含信息挖掘与敲诈勒索检测

随着数字化时代的到来,法律文件的管理和处理变得更加便捷,但与之同时,敲诈勒索等犯罪行为也变得更加隐蔽。本文将介绍一种基于人工智能的方法,通过挖掘法律文件图像中的隐含信息,实现对敲诈勒索行为的有效检测。文章将结合代码实例,探讨该方法的技术原理和实际应用。法律文件通常包含大量的文字和图像信息,其中可能隐

4张图片就可以微调扩散模型

我们今天使用DreamBooth在不影响模型原始功能的情况下实现微调过程。

毕业设计:基于深度学习的绝缘子缺陷检测系统 人工智能 YOLO 计算机视觉

基于深度学习的创新绝缘子缺陷检测系统,该系统结合了深度学习和计算机视觉技术,能够有效地检测绝缘子的缺陷目标。通过对比实验,我们发现该系统相比传统方法具有更高的准确性和鲁棒性。这项毕业设计为计算机毕业生提供了一个有意义的研究课题,并开拓了一个创新的方向,为未来的绝缘子检测技术发展提供了新的思路和方法。

论文ai生成工具在哪里?关于ai技术的论文怎么写?

AI生成工具可以在各种在线平台和软件中找到,例如Google的AutoML,Hugging FaceAI生成工具可以在各种在线平台和软件中找到,例如Google的AutoML,Hugging Face的Transformers,或者Jupyter Notebook等。11. 参与社区:加入AI相关的