28. 深度学习进阶 - LSTM

后来大家就发现了一种改进的LSTM,其中门控机制允许细胞状态窥视现前的细胞状态的信息,而不仅仅是根据当前时间步的输入和隐藏状态来决定。对于RNN来说,它有一个很严重的问题,就是之前说过的,它的vanishing和exploding的问题会很明显, 也就是梯度消失和爆炸问题。这节课,我们就着上一节课的

Jeston NANO 配置并安装 torch+ torchvision

由于nano的arm64架构,所以用它进行深度学习配置部署时会与用普通电脑(x86)有所不同

Pytorch入门(五)使用ResNet-18网络训练常规状态下的CIFAR10数据集

本文介绍了如何使用Pytorch+ResNet-18+CIFAR-10进行深度学习训练,并使用训练好的权重进行预测,ResNet是一个非常优秀的神经网络,ResNet 在图像分类任务中表现出色。

经典文献阅读之--NeRF-SLAM(单目稠密重建)

NeRF 是 2020 年 ECCV 上获得最佳论文荣誉提名的工作,其影响力是十分巨大的,不论是后续的学术论文还是商业落地,都引起了大量从业人员的关注。NeRF 将隐式表达推上了一个新的高度,仅用 2D 的 posed images 作为监督,即可表示复杂的三维场景,在新视角合成这一任务上的表现是非

OSTrack的一些代码执行命令讲解

执行如下命令可以生成路径文件,分别会在OSTrack/lib/train/admin目录和OSTrack/lib/test/evaluation目录下生成local.py文件,里面是各种路径的默认设置。配置文件为OSTrack/experiments/ostrack/vitb_256_mae_ce_

使用LOTR合并检索提高RAG性能

RAG结合了两个关键元素:检索和生成。本文将介绍使用使用Merge retriver改进RAG的性能

人工智能生成文本检测在实践中使用有效性探讨

本文介绍了关于如何检测ai生成文本的思路。可以使用的主要指标是生成文本的困惑度。还介绍了这种方法的一些缺点,包括误报的可能性。希望这有助于理解检测人工智能生成文本背后的细节。但是当我们讨论检测人工智能生成文本的技术时,这里的假设都是整个文本要么是人类编写的,要么是人工智能生成的。但是实际上文本往往部

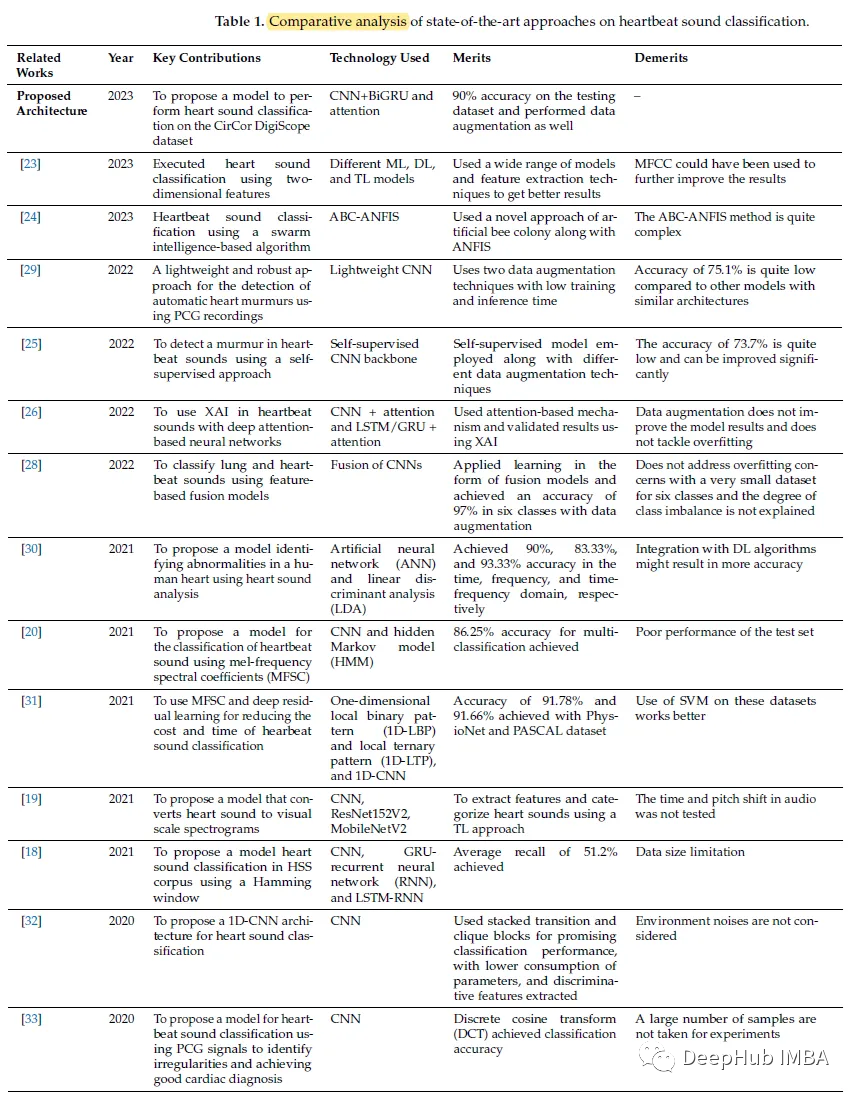

基于CNN和双向gru的心跳分类系统

论文,提出了基于卷积神经网络和双向门控循环单元(CNN + BiGRU)注意力的心跳声分类,论文不仅显示了模型还构建了完整的系统。

基于VGG16的猫狗分类实战

基于VGG16的猫狗分类实战

基于Transformer的多变量风电功率预测TF2

Transformer目前大火,作为一个合格的算法搬运工自然要跟上潮流,本文基于tensorflow2框架,构建transformer模型,并将其用于多变量的风电功率负荷预测。实验结果表明,相比与传统的LSTM,该方法精度更高,缺点也很明显,该方法需要更多的数据训练效果才能超过传统方法,而且占用很高

深度学习之路:自动驾驶沙盘与人工智能专业的完美融合

探寻未来交通的深度学习之路,本文以“深度学习之路:自动驾驶沙盘与人工智能专业的完美融合”为题,详细解析了自动驾驶沙盘在人工智能专业教学与科研中的突出意义。通过结合深度学习理论与实际应用,文章展示了小车的自动驾驶原理、传感器技术,以及图像识别红绿灯、车道线等关键功能的源码。强调自动驾驶沙盘作为高校科研

图像识别与分类:实战指南

在计算机视觉中,图像识别与分类的目标是根据图像内容将其分配给一个或多个类别。数据预处理:包括缩放、裁剪、翻转等操作,以增强图像数据的多样性。特征提取:从原始图像中提取有助于识别和分类的特征。模型训练:使用监督学习算法训练模型以区分不同类别。模型评估:使用一组测试数据评估模型的性能。应用模型:将训练好

人工智能生成文本检测在实践中使用有效性探讨

本文介绍了关于如何检测ai生成文本的思路。希望这有助于理解检测人工智能生成文本背后的细节。

【强化学习入门】二.强化学习的基本概念:状态、动作、智能体、策略、奖励、状态转移、轨迹、回报、价值函数

自动驾驶中,汽车就是智能体;机器人控制中,机器人就是智能体;超级玛丽游戏中,玛丽就是智能体。当智能体做出一个动作,状态会发生变化(从旧的状态变成新的状态)。我们就可以说状态发生的转移。的含义就是,根据观测到的状态,做出动作的方案,超级玛丽游戏中,观测到的这一帧画面就是一个。强化学习的目标就是尽可能的

深度学习基础实例与总结

感知机(Perceptron),又称神经元(Neuron,对生物神经元进行了模仿)是神经网络(深度学习)的起源管法,1958年由康奈尔大学心理学教授弗兰克·罗森布拉特(Frank Rosenblatt) 提出,它可以接收多个输入信号,产生一个输出信号。其中,x1ix_1ix1i和x2x_2x2称

深度学习环境完整安装(Python+Pycharm+Pytorch cpu版)

在这里,博主会引导您逐步完成深度学习环境的完整安装,助您踏上从Python到PyTorch的探索之旅。通过本博客,您将轻松掌握如何设置Python环境、使用Pycharm进行开发以及安装Pytorch,成为一名具备完整深度学习环境的实践者。让我们一起开始吧!

T5模型:打破Few-shot Learning的次元壁垒

自然语言处理(NLP)是一种用于理解人类语言的计算机科学领域。在过去的几年中,随着深度学习技术的发展,NLP领域也取得了突破性进展。在众多的NLP模型中,T5模型作为一种强大的语言生成模型,在自然语言理解、翻译和问答等任务中表现出色,成为了该领域的研究热点之一。本文将介绍T5模型的原理和优势,并结合

【图像分割】Unet系列深度讲解(FCN、UNET、UNET++)

【图像分割】Unet系列深度讲解(FCN、UNET、UNET++)

BP神经网络模型一篇入门

BP神经网络广泛应用于解决各种问题,是知名度极高的模型之一为了方便初学者快速学习,本文进行深入浅出讲解BP神经网络的基本知识通过本文,可以初步了解BP神经网络的各个核心要素,并弄清BP神经网络是什么。

【DL】第 2 章 :变分自动编码器(VAE)

在本章中,您将:了解自动编码器的架构设计如何使其完美适用于生成建模使用 Keras 从头开始构建和训练自动编码器使用自动编码器生成新图像,但了解这种方法的局限性了解变分自动编码器的架构以及它如何解决与标准自动编码器相关的许多问题使用 Keras 从头开始构建变分自动编码器使用变分自动编码器生成新图像