文章目录

docker快速启动

如果你想使用docker快速启动这个项目,你可以按下面这么操作(显卡支持CUDA11.8)。如果你不懂docker,请参考别的教程。

docker run -it--network=host --gpus'"device=0"' kevinchina/deeplearning:sdwebuiv1 bash# 进入容器su xiedong

cd ~/stable-diffusion-webui/

./webui.sh --enable-insecure-extension-access --skip-python-version-check --skip-torch-cuda-test --skip-install --ckpt ./models/Stable-diffusion/majicmixRealistic_v7.safetensors --listen --no-download-sd-model

vae

模型文件即checkpoint已包含了与vae相关的参数。然而,稳定扩散官方和novelai泄露的文件都包含了额外的vae,用于改进面部或其他细节。因此,加载vae文件实际上替代了模型文件中原有的与vae相关的参数。这可能会导致问题,如果模型本身已经表现良好,盲目加载vae可能会适得其反。另外,如果模型文件已经包含了vae,再次加载相同的vae只会浪费时间。

.ckpt或者.safetensors

.ckpt 文件使用 pickle 序列化,可能携带恶意代码。如果你不信任模型来源,加载 .ckpt 文件可能会对安全构成风险。

.safetensors 文件则仅包含张量数据,使用 numpy 保存,没有附带代码,因此加载 .safetensors 文件更为安全且效率更高。

CFG指数/CFG Scale

“CFG指数”,即Classifier-Free Guidance(无分类器引导生成)指数的含义和作用。CFG指数用来调节文本提示对扩散过程的引导程度。

- 扩散模型中的前向扩散和反向去噪可以用随机微分方程来描述,但反向去噪需要一个分类器来拟合数据分布的梯度,以实现条件生成。

- 传统的分类器引导生成方式存在问题,因为需要额外训练分类器,而分类器的质量会影响生成效果。

- 作者提出了"无分类器引导生成"(Classifier-Free Guidance)的概念,其中使用两个梯度预估模型,一个是无条件生成的梯度预估模型,另一个是基于条件的梯度预估模型,避免了显式分类器的缺陷。

- 通过使用Classifier-Free Guidance,条件生成的训练代价大大减轻,不需要额外训练分类器,同时避免了对抗攻击的方式,生成是两个梯度的差值。

- CFG指数用来控制文本提示对生成过程的引导程度。当CFG指数为0时,生成是无条件的,较高的数值会更加受文本提示的影响。

- 推荐的CFG指数范围为7-10,这是一个平衡的区间,提供创意性并遵循文本提示。较低的CFG数值会提高创意性,较高的数值会更受文本提示的影响。

- 当CFG指数超过20时,可能会导致一些奇怪的现象。

面部修复/Restore faces

推荐别开,开了效果不咋地。

下面的数值条可以控制CoderFormer的影响力度,为0时效果最强。

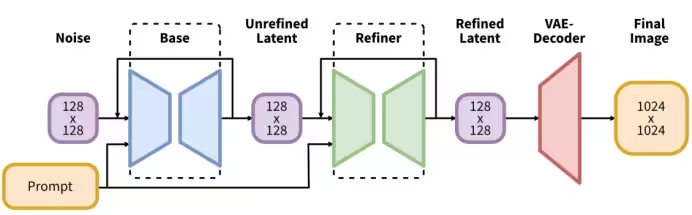

Refiner

Refiner在SD1.5里面是不起作用的。

SDXL完整出图流程 Base+refiner

Conditioning(Text,Image)->Latent Space(Base)->Latent Space(Refiner)->VAE Decoder->Pixel Image

Tiled VAE

作用就是减少显存方式进行超分。

Tiled Diffusion & Tiled VAE 搭配ControlNet-Tile 实测重绘放大 512×768重绘放大8倍(4096×6144)

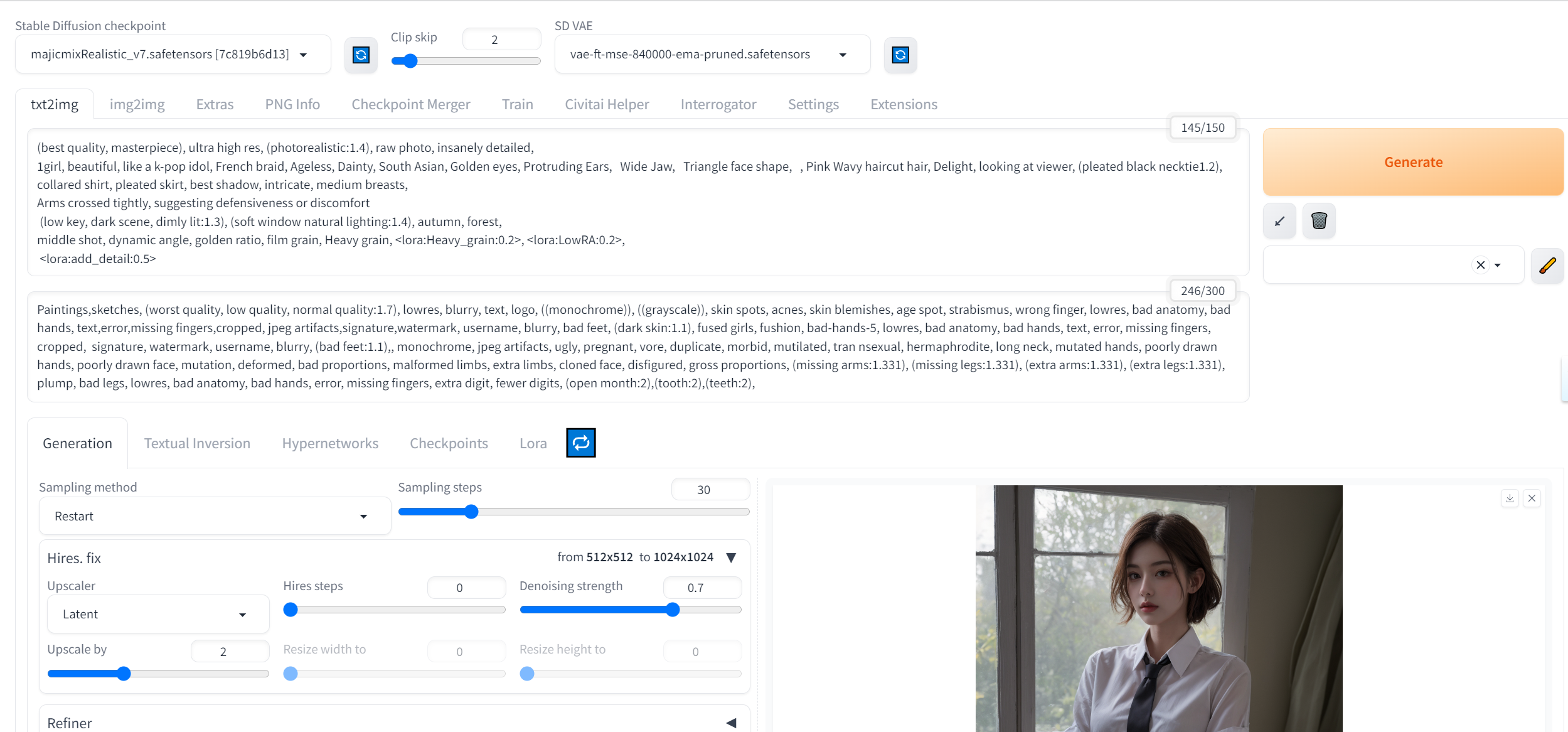

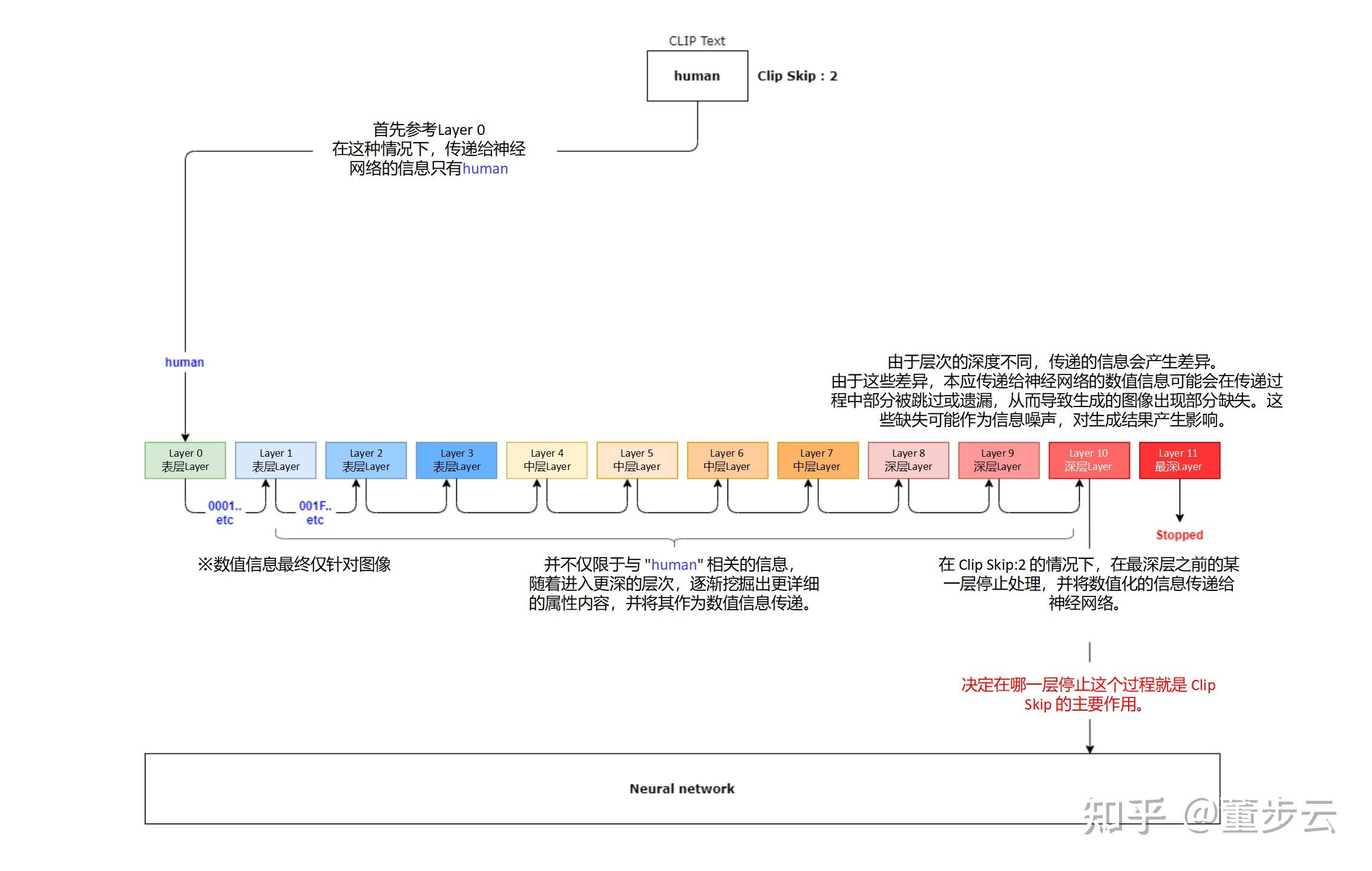

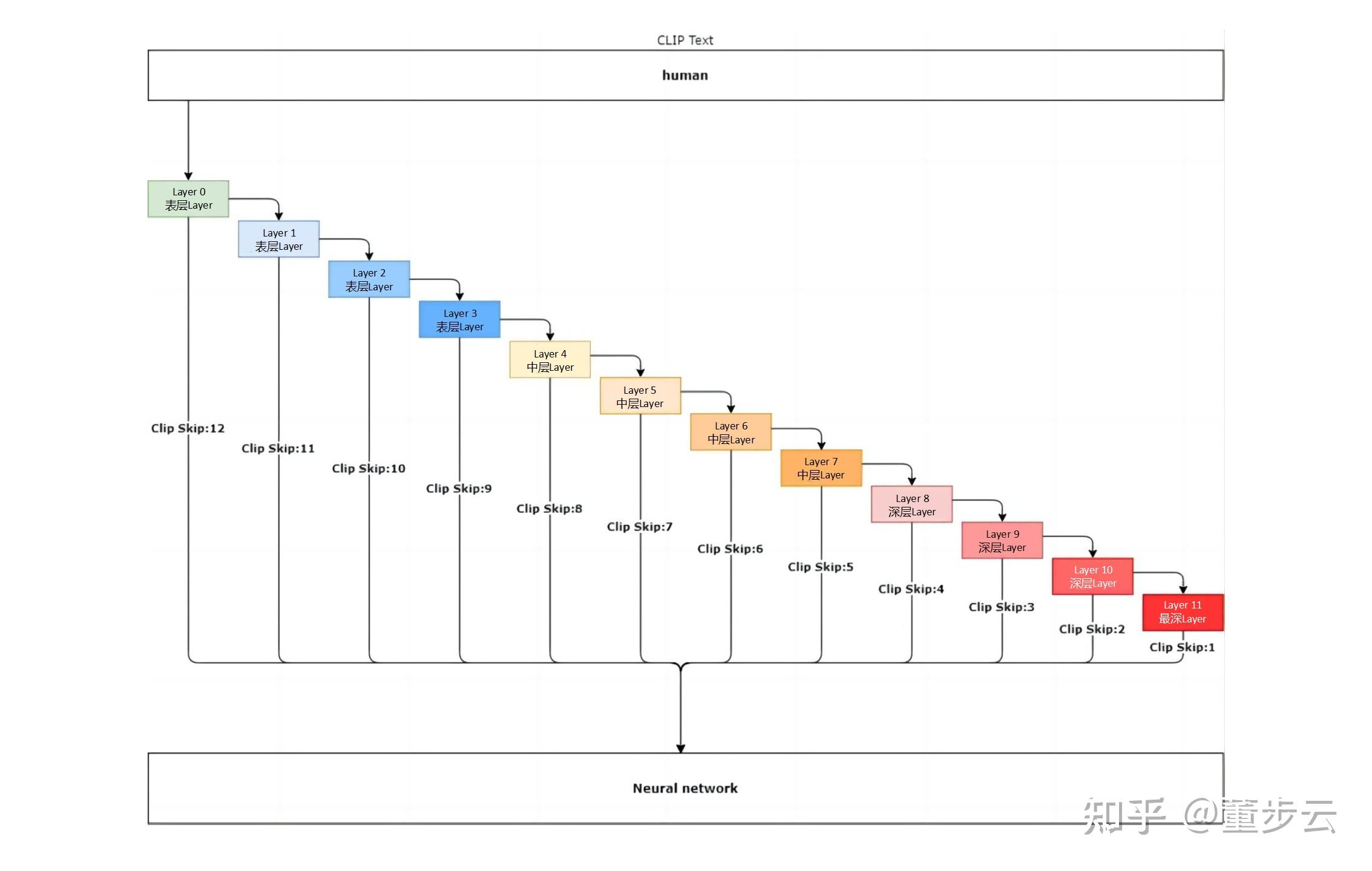

Clip Skip

https://zhuanlan.zhihu.com/p/630875053

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Features#clip-skip

Clip Skip是一个设置,用于控制CLIP神经网络在处理提示文本时跳过的层数。以下是文章的内容总结:

- Clip Skip是什么: Clip Skip是一个用于控制CLIP神经网络处理提示文本时跳过的层数的设置。CLIP是一个先进的神经网络,用于将提示文本转化为数值表示。这网络包括多个层次,以便将文本转化为数值表示。

- Clip Skip的作用: Clip Skip的作用是控制CLIP神经网络在处理提示文本时停止的层数。它的值可以设置为1或更高,表示在第几层停止。不同的层数会影响处理提示文本的深度,从而影响生成图像的质量和特征。

- 如何使用Clip Skip: Clip Skip的值可以通过相应的设置选项进行调整。在生成图像时,可以调整Clip Skip的值,以改变生成图像的特征和质量。通常,建议的Clip Skip值范围为1到5,而大于5的值可能会导致图像质量下降。Clip Skip的设置可以通过特定的用户界面进行调整,以在生成图像时产生所需的效果。

- Clip Skip与生成图像的影响: Clip Skip的值会影响生成图像的质量和清晰度。当Clip Skip的值较大时,图像可能会变得模糊和不准确,因为较少的神经网络层处理了提示文本。较小的Clip Skip值通常会产生更准确和清晰的图像。

- Clip Skip和CFG Scale的关系: CFG Scale是另一个影响生成图像的因素,与Clip Skip相互独立。它们的值设置不会相互影响,但它们都可以影响生成图像的特征。

- Clip Skip的应用: Clip Skip可以用于不同的应用,如生成肖像或进行图像到图像的转换。具体应用取决于生成需求和预期的效果。Clip Skip的设置可以帮助调整图像的构图和特征,以满足用户的要求。

Clip Skip是一个用于控制CLIP神经网络在生成图像时处理提示文本的深度的设置,它可以影响生成图像的质量和特征。通过调整Clip Skip的值,用户可以根据需求定制生成图像的效果。

prompt提示词怎么写

看这里别人怎么写的:

https://civitai.com/models

用这个写:

https://zhuanlan.zhihu.com/p/634833836

用这个写:

https://www.kandouyin.com/

roop Upscaler visibility (if scale = 1)

Roop插件中的参数"Upscaler visibility (if scale = 1)"的含义是什么呢?

如果您打算使用超分插件,并且所选的尺寸为1倍原始尺寸,那么超分后的图像将与原始图像具有相同的尺寸。此时,该参数允许您以所提供的"Upscaler visibility"比例来混合原始图像和超分后的图像,从而生成最终的输出图像。

具体来说,如果 “Upscaler visibility” 的值为 0,那么生成的图像将完全是原始图像,没有任何超分效果。如果 “Upscaler visibility” 的值为 1,那么生成的图像将完全是超分后的图像,原始图像不会被包含在内。如果 “Upscaler visibility” 的值介于 0 和 1 之间,那么生成的图像将包含原始图像和超分后的图像的混合,其中比例由 “Upscaler visibility” 决定。

这个过程是通过像素级别的加权平均来实现的,即对每个像素的颜色值进行加权混合。混合的方式可以根据具体的图像处理算法而异,通常可以使用图像处理软件或编程来实现。

参考:

https://zhuanlan.zhihu.com/p/617026822

https://www.bilibili.com/read/cv25364364/

版权归原作者 XD742971636 所有, 如有侵权,请联系我们删除。