大数据集特征工程实践:将54万样本预测误差降低68%的技术路径与代码实现详解

本文通过实际案例演示特征工程在回归任务中的应用效果,重点分析包含数值型、分类型和时间序列特征的大规模表格数据集的处理方法。

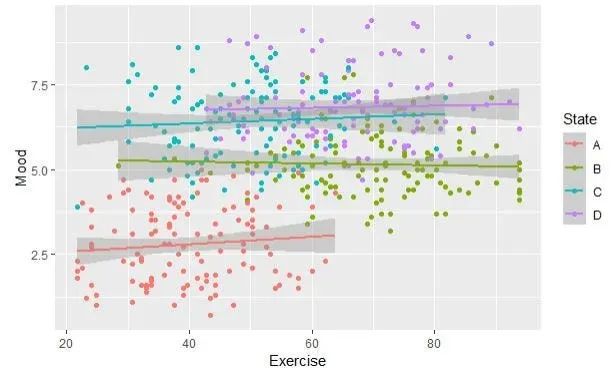

混合效应模型原理与实现:从理论到代码的完整解析

混合效应模型并非神秘的技术,而是普通回归方法在层次化结构建模方面的原理性扩展。这种理解将成为机器学习工具箱中下一个技术突破的重要基础。

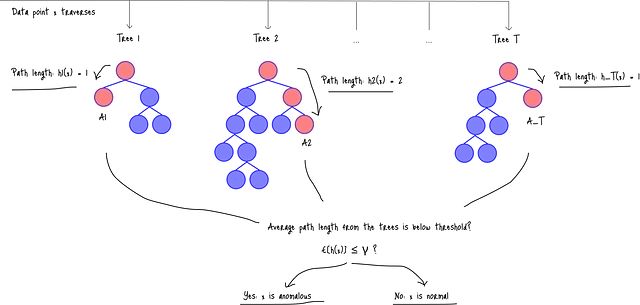

机器学习异常检测实战:用Isolation Forest快速构建无标签异常检测系统

本研究通过实验演示了异常标记如何逐步完善异常检测方案和主要分类模型在欺诈检测中的应用。实验结果表明,Isolation Forest作为一个强大的异常检测模型,无需显式建模正常模式即可有效工作,在处理未见风险事件方面具有显著优势。

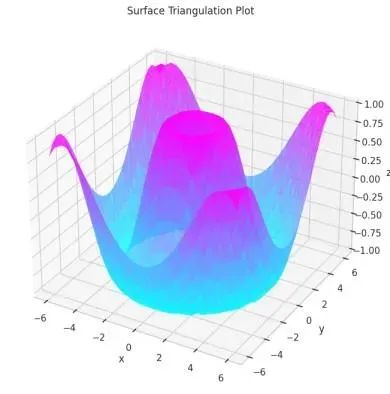

Python 3D数据可视化:7个实用案例助你快速上手

本文详细介绍了 Python 中基于 Matplotlib 库的七种核心三维数据可视化技术,从基础的线性绘图和散点图到高级的曲面建模和三角剖分方法。

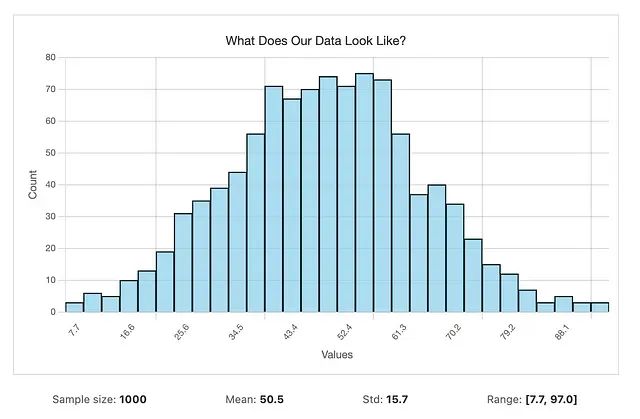

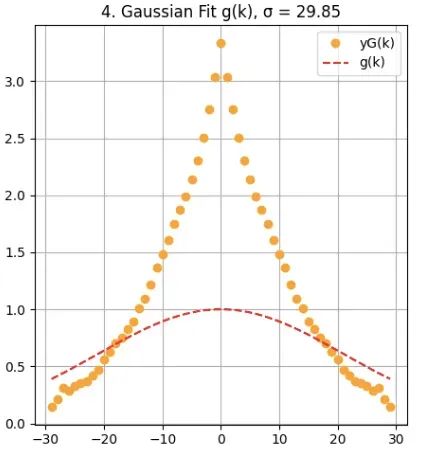

数据分布不明确?5个方法识别数据分布,快速找到数据的真实规律

本文介绍的方法和工具涵盖了大多数实际应用场景的需求。从基础的直方图分析开始,逐步深入到参数化和非参数化的分布拟合,再到结果验证和实际应用,形成了完整的技术体系。

DROPP算法详解:专为时间序列和空间数据优化的PCA降维方案

*DROPP (Dimensionality Reduction for Ordered Points via PCA) 是一种专门针对有序数据的降维方法。本文将详细介绍该算法的理论基础、实现步骤以及在降维任务中的具体应用。*

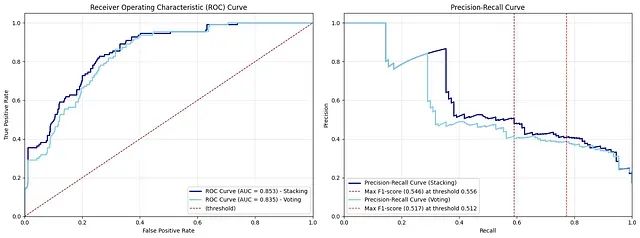

朴素贝叶斯处理混合数据类型,基于投票与堆叠集成的系统化方法理论基础与实践应用

本文深入探讨朴素贝叶斯算法的数学理论基础,并重点分析其在处理混合数据类型中的应用。

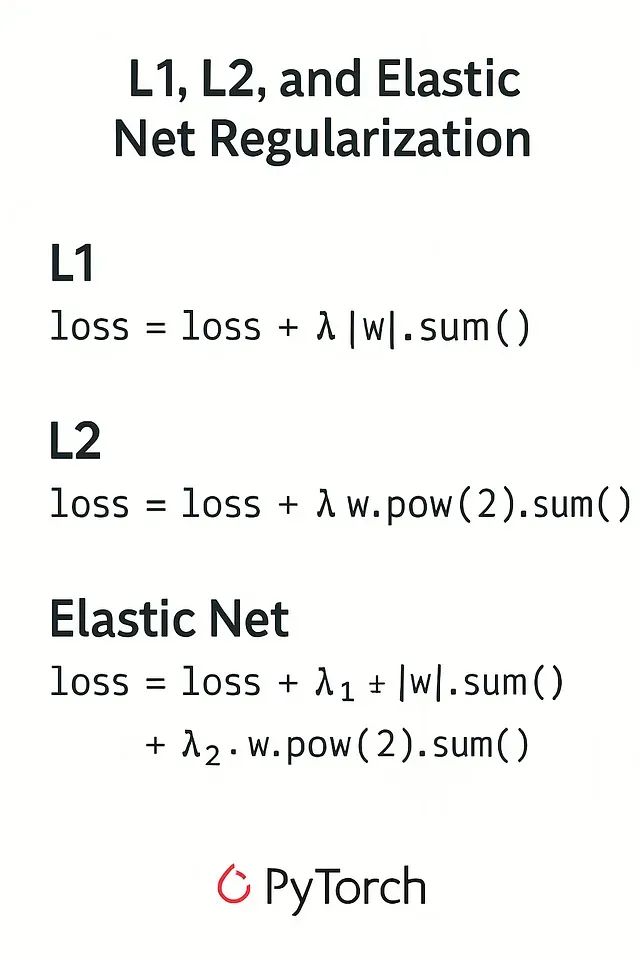

提升模型泛化能力:PyTorch的L1、L2、ElasticNet正则化技术深度解析与代码实现

本文将深入探讨L1、L2和ElasticNet正则化技术,重点关注其在PyTorch框架中的具体实现。关于这些技术的理论基础,建议读者参考相关理论文献以获得更深入的理解。

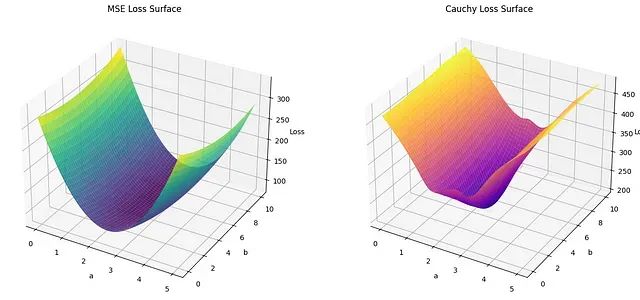

让回归模型不再被异常值"带跑偏",MSE和Cauchy损失函数在噪声数据环境下的实战对比

本文通过实证研究,系统比较了MSE损失函数和Cauchy损失函数在线性回归中的表现,重点分析了两种损失函数在噪声数据环境下的差异。

BayesFlow:基于神经网络的摊销贝叶斯推断框架

**BayesFlow** 是一个开源 Python 库,专门设计用于通过**摊销(Amortization)神经网络**来**加速和扩展贝叶斯推断**的能力。该框架通过训练神经网络来学习逆问题(从观测数据推断模型参数)或正向模型(从参数生成观测数据)的映射关系,

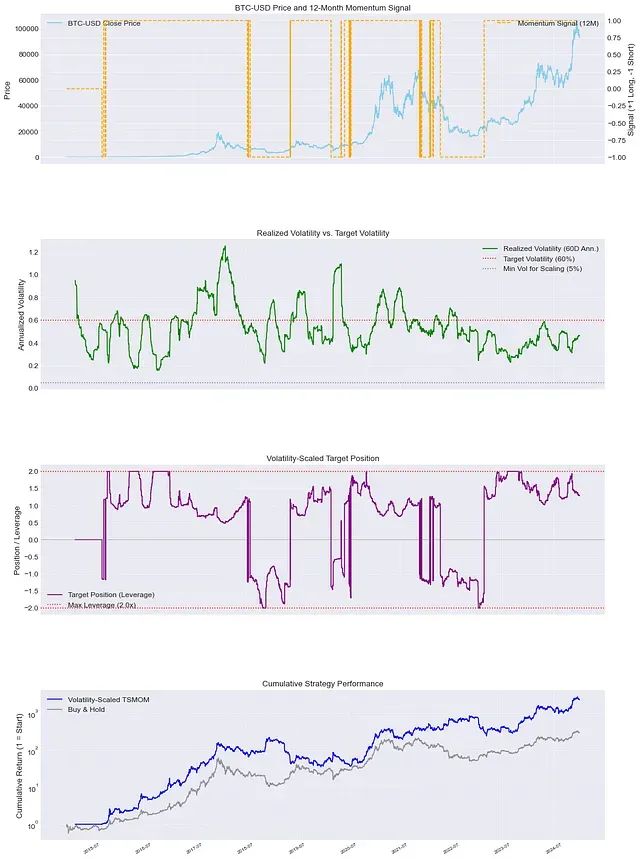

Python实现时间序列动量策略:波动率标准化让量化交易收益更平稳

本文将系统性地分析波动率调整时间序列动量策略的机制原理、实施方法以及其在现代量化投资框架中的重要地位。

解读 Python 3.14:模板字符串、惰性类型、Zstd压缩等7大核心功能升级

本文将深入分析 Python 3.14 中最为显著的**七项核心技术特性**,探讨它们对开发效率与应用架构的实际影响。

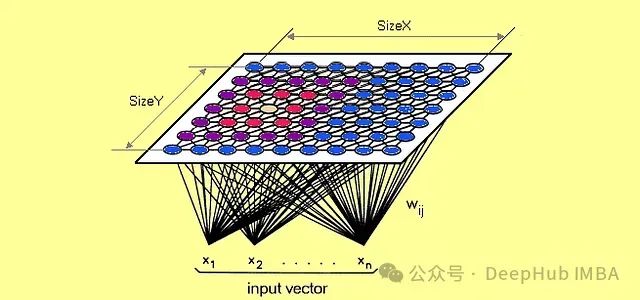

面向概念漂移的动态自组织映射(SOM)及其在金融风险预警中的效能评估

自组织映射(Self-Organizing Maps),又称**Kohonen映射**,是由芬兰学者**Teuvo Kohonen**在20世纪80年代提出的一种无监督神经网络模型。其核心功能是将高维数据空间投影到低维(通常为二维)网格结构中。

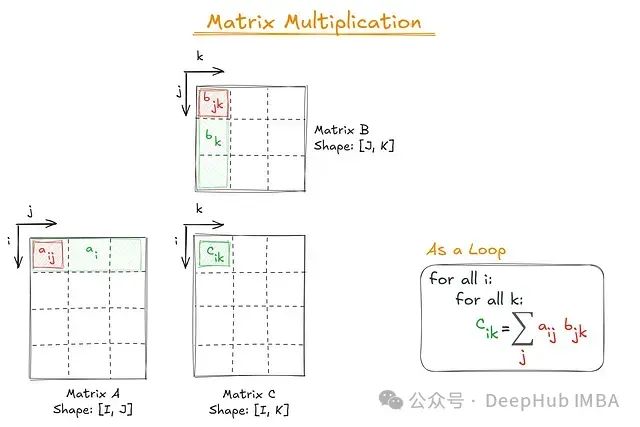

高效处理多维数组:einsum()函数从入门到精通

本文将全面介绍 ``` einsum() ``` 函数——其数学基础、实现原理以及实际应用场景。我们将深入剖析其符号系统,通过实用示例展示其功能,探讨性能优化策略,并提供一个完整的参考速查表辅助实际应用。

基于马尔可夫链的状态转换,用概率模型预测股市走势

马尔可夫链本质上是一个依据特定概率规则从一个状态转移至另一个状态的数学系统。其核心特征在于:**系统的下一个状态仅依赖于当前状态,而非之前的状态序列**。

Pandas数据合并:10种高效连接技巧与常见问题

Pandas库中的merge和join函数提供了强大的数据整合能力,但不恰当的使用可能导致数据混乱。基于对超过1000个复杂数据集的分析经验,本文总结了**10种关键技术**,帮助您高效准确地完成数据合并任务。

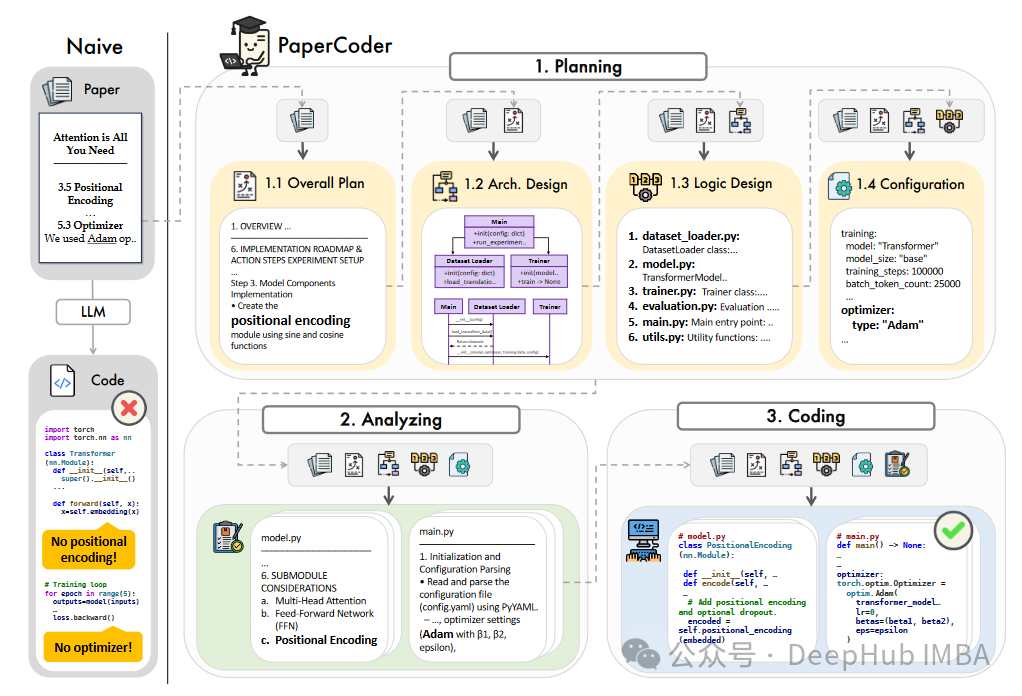

PaperCoder:一种利用大型语言模型自动生成机器学习论文代码的框架

本文介绍了一种名为PaperCoder的新型多智能体LLM框架,旨在自动生成机器学习研究论文的代码库。

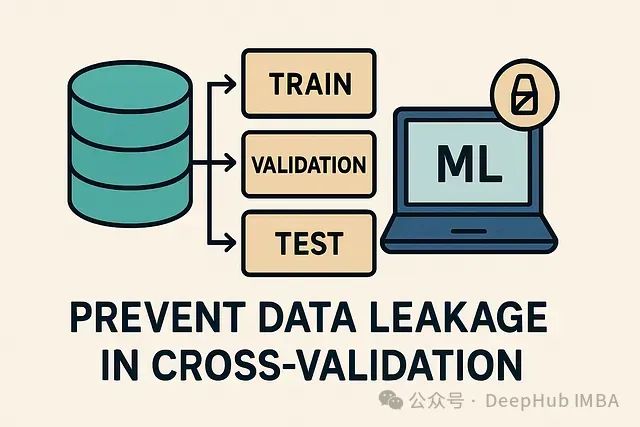

防止交叉验证中的数据泄露:提升模型在实际环境中的性能

本文将深入探讨如何构建真正稳健的验证策略,确保模型在面对真实世界数据时依然能保持预期的性能。

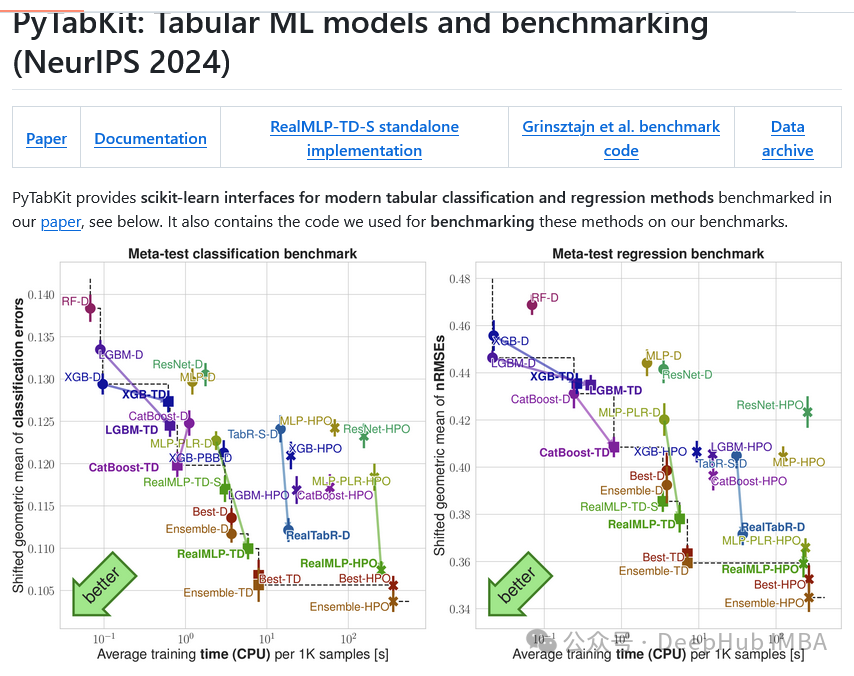

PyTabKit:比sklearn更强大的表格数据机器学习框架

**PyTabKit** 专为表格数据的分类和回归任务设计,集成了 **RealMLP** 等先进技术以及优化的梯度提升决策树(GBDT)超参数配置,为表格数据处理提供了新的技术选择。

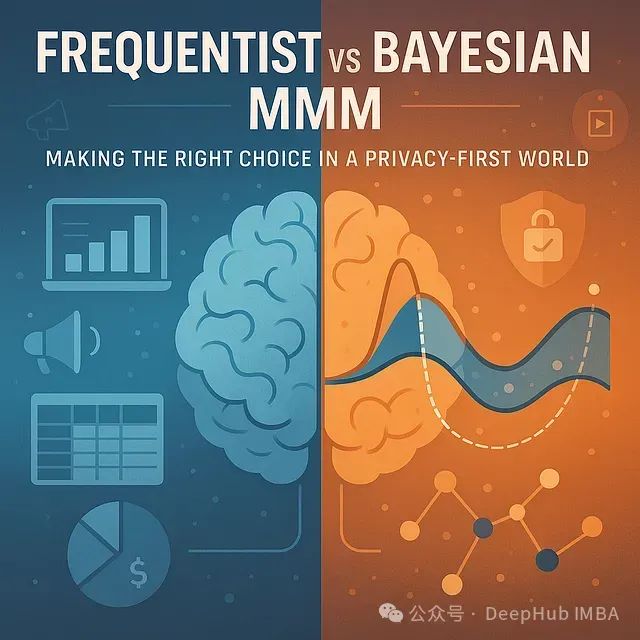

频率派与贝叶斯统计在营销组合建模中的应用比较:隐私优先时代的方法选择

本文将深入探讨频率派和贝叶斯MMM之间的核心差异,全面比较两种方法的优势、局限性、适用场景及相关工具。无论你是希望优化模型的数据科学家,还是寻求更明智预算分配决策的营销决策者,本指南都将帮助你确定哪种方法更适合你的业务需求。