LocalAI离线安装部署

LocalAI是免费的开源 OpenAI 替代品。LocalAI 可作为替代 REST API,与 OpenAI(Elevenlabs、Anthropic……)API 规范兼容,用于本地 AI 推理。它允许您在本地或使用消费级硬件运行 LLM、生成图像、音频(不止于此),支持多种模型系列。不需要 G

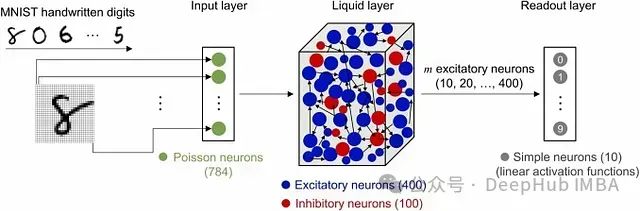

基于Liquid State Machine的时间序列预测:利用储备池计算实现高效建模

**Liquid State Machine (LSM)** 是一种 **脉冲神经网络 (Spiking Neural Network, SNN)** ,在计算神经科学和机器学习领域中得到广泛应用,特别适用于处理 **时变或动态数据**。

大数据-203 数据挖掘 机器学习理论 - 决策树 sklearn 剪枝参数 样本不均匀问题

剪枝参数一定能够提升模型在测试集上的表现吗?调参是没有绝对的答案的,一切都需要看数据的本身。无论如何,剪枝参数的默认值会让树无尽的生长,这些树在某些数据集上可能非常巨大,对内存的消耗也非常巨大。属性是模型训练之后,能够调用查看的模型的各种性质,对决策树来说,最重要的是 feature_importa

大数据-195 数据挖掘 机器学习理论 - 监督学习算法 KNN 近邻 代码实现 Python

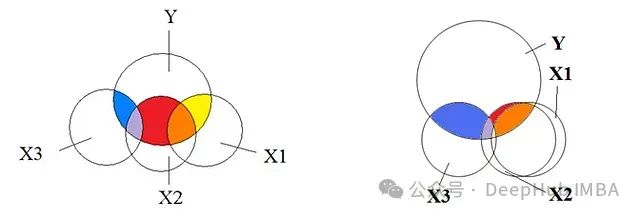

当然只对比一个样本是不够的,误差会很大,他们就需要找到离其最近的 K 个样本,并将这些样本称为【近邻】nearest neighbor,对这 K 个近邻,查看它们都属于任何类别(这些类别称为称为【标签】labels)。我们常说的欧拉公式,即“欧氏距离”,回忆一下,一个平面直角坐标系上,如何计算两点之

LLM Continue Pretrain(2024版)

deepseek的开源moe,也做得非常不错,应该是国内开源top了,他们的pretrain团队做得挺棒的 但算法为主的,做pretrain,往往就是洗数据了。尴尬的点是,预训练洗数据,因为数据量大,往往都是搞各种小模型+规则,很难说明你做的事情的技术含量,只能体现你对数据的认知很好。语言类的dom

大数据-202 数据挖掘 机器学习理论 - 决策树 sklearn 绘制决策树 防止过拟合

在每次分支的时候,不使用全部特征,而是随机选取一部分特征,从中选取不纯度相关指标最优的作为分支用的节点。我们之前提过,无论决策树模型如何进化,在分支上的本质都还是追求某个不纯度相关的指标的优化,而正如我们提到的,不纯度是基于节点计算出来的,也就是说,决策树在建树时,是靠优化节点来追求一棵优化的树,但

大数据-198 数据挖掘 机器学习理论 - scikit-learn 归一化 距离的惩罚

最近邻点距离远近修正在对未知分类过程中,一点一票的规则是 KNN 模型优化的一个重要步骤,也就是说,对于原始分类模型而言,在选取最近的 K 个元素之后,将参考这些点的所属类别,并对其进行简单计数,而在计数的过程中这些点一点一票,这些点每个点对分类目标点的分类过程中影响效力相同。但这实际上不公平的,就

深入理解多重共线性:基本原理、影响、检验与修正策略

本文将深入探讨多重共线性的本质,阐述其重要性,并提供有效处理多重共线性的方法,同时避免数据科学家常犯的陷阱。

AI 如何理解文字:Embedding解析

Embedding是一种将高维数据(如文字、图像等)映射到低维空间的技术。在自然语言处理中,embedding通常指的是将单词或短语转换成连续的向量表示。这些向量捕捉了词汇的语义信息,使得相似的词汇在向量空间中距离更近。Embedding是AI理解文字的关键技术之一。通过将高维的one-hot编码向

大数据-199 数据挖掘 机器学习理论 - 决策树 模型 决策与条件 香农熵计算

左图表示了特征空间的一个划分,假定现在只有 W10 和 W20 两个决策点,特征空间被决策点沿轴划分,并且相继划分相互正交,每个小矩形表示一个区域,特征空间上的区域构成了集合,X 取值为区域的集合。由于决策树表示一个条件概率的分布,所以深浅不同的决策树对应着不同的复杂度的概率模型,其中决策树的生成只

大数据-197 数据挖掘 机器学习理论 - scikit-learn 泛化能力 交叉验证

在业务中,我们训练数据往往都是以往已经有的历史数据,但我们的测试数据却是新进入系统的数据,我们追求模型的效果,但是追求的是模型在未知数据集上的效果,在陌生的数据集上表现的能力被称为泛化能力,即我们追求的是模型的泛化能力。通常来说,我们认为经过验证集找出最终参数后的模型的泛化能力是增强了的,因此模型在

告别传统办公软件,这款编辑器让你事半功倍!

ONLYOFFICE最近发布了文档8.2版本,带来了众多新特性和性能改进。作为一名用户和开发者,我对这些更新进行了深入的体验,感受到了不少亮点。新版本特别强调了协作功能,尤其是PDF文件的实时协同编辑,让我和团队成员能够更加高效地共同处理文档,避免了以往版本中反复发送邮件的问题。

SMOTE算法进行过采样

【代码】SMOTE算法进行过采样。

【LLaMA-Factory】【Windows】:在windows操作系统配置大模型微调框架LLaMA-Factory

PyTorch拥有一个庞大的社区和丰富的生态系统,这意味着在使用LLaMA-Factory时,如果遇到问题或需要额外的功能,可以很容易地找到相关的解决方案或库。综上所述,PyTorch、CUDA、Python以及相应模型在LLaMA-Factory框架中各自扮演了重要的角色,共同支持了模型的高效训练

大数据-196 数据挖掘 机器学习理论 - scikit-learn 算法库实现 案例1 红酒 案例 2 乳腺癌

KNN 中的一个超参数,所谓“超参数”,就是需要人为输入,算法不能通过直接计算得出这个参数,KNN 中的 K 代表的是距离需要分类的测试点 X 最近的 K 个样本,如果不输入这个值,那么算法中重要部分“选出 K 个最近邻”就无法实现。如果选择的 K值较小,就相当于较小的领域中的训练实例进行预测,这时

常见机器学习算法汇总

简单汇总一下机器学习算法,方便记忆。

大数据-200 数据挖掘 机器学习理论 - 决策树 数据集划分 决策树生成 ID3 C4.5

而在信息熵指数的指导下,决策树生成过程的局部最优条件也非常好理解:即在选取属性测试条件(attribute test condition)对某节点(数据集)进行切分的时候,尽可能选取使得该节点对应的子节点信息熵最小的特征进行切分。同时我们知道,全局最优树没有办法简单高效的获得,因此此处我们仍然要以局

10种数据预处理中的数据泄露模式解析:识别与避免策略

当测试数据在数据准备阶段无意中泄露(渗透)到训练数据时,就会发生数据泄露。这种情况经常出现在常规数据处理任务中,而你可能并未察觉。当泄露发生时,模型会从本不应看到的测试数据中学习,导致测试结果失真。

【人工智能】线性回归

一、使用正规化方法计算下列样本的预测函数1. 没有归一化之前2. 归一化之后二、读取ex1data2.txt中的数据,建立样本集,使用正规化法获取(房屋面积,房间数量)与房屋价格间的预测函数1. 读取数据,建立样本集2. 设置X、y3. 计算theta三、读取ex1data1.txt中的数据,建立样

20240927 每日AI必读资讯

我们最近发布的语音到语音转换和OpenAI O1标志着交互和智能的新时代的开始——这些成就是由你们的聪明才智和手艺实现的。在这个过程中,AI会通过多次尝试得到反馈。这个阶段的重点是让AI明白哪些地方出错了,并且不会只做一些很小的、无关紧要的修改,而是能够真正找到并改正大的错误。这一成功证明了我们出色