Diffusion Models 简单代码示例

扩散模型的目标是通过数据在潜在空间(latent space)的扩散过程,学习数据的潜在向量结构(latent structure),通俗点说,扩散模型学习利用数据逐步变成噪声的过程,学习反向的去噪声过程。基于 GAN 生成模型,基于 VAE 的生成模型,以及基于 flow 的生成模型它们都可以生成

运动想象代码复现,数据集BCI IV-2a

运动想象代码复现

前向传播(Forward Propagation)与反向传播(Back Propagation)举例

前向传播(Forward Propagation)与反向传播(Back Propagation)

使用 Temporal Fusion Transformer 进行时间序列预测

Temporal Fusion Transformer(TFT)是一个基于注意力的深度神经网络,它优化了性能和可解释性,顶层架构如下图所示。TFT架构的优点如下:能够使用丰富的特征:TFT支持三种不同类型的特征:外生类别/静态变量,也称为时不变特征;具有已知输入到未来的时态数据,仅到目前已知的时态数

【AI】AI入门之Nvidia Jetson平台(四)- Xavier NX软件开发环境安装部署

AI人工智能,深度学习,Jetson嵌入式平台,Ubuntu系统

【Debug记录】深度学习Pytorch+Anaconda环境下常见报错的原因及解决方案 | 亲测已解决

001.“AssertionError: Torch not compiled with CUDA enabled”、 002.“RemoveError: 'requests' is a dependency of conda and cannot be removed from conda's o

9月人工智能论文和项目推荐

因为LLM的火爆,所以最近的论文都是和LLM相关的

AI框架:9大主流分布式深度学习框架简介

转载翻译Medium上一篇关于分布式深度学习框架的文章。

人类智能的本质、模型和原理——看了这么多AI人工智能,你有没有思考过到底什么才是 HI 人类智能?

人类智力是一种复杂的现象,涉及到许多不同的领域,包括心理学、神经科学、计算机科学等。数学模型和物理模型是研究人类智力的两个重要工具,可以帮助我们更好地理解人类智力的本质和机制。本文将分别介绍人类智能的本质和背后的数学模型和物理模型,探讨它们在研究人类智力中的作用和应用。

【人工智能】大模型技术生态

大模型技术是指基于深度学习等机器学习技术,利用大规模数据进行训练得到的巨型神经网络模型。它可以在自然语言处理、视觉识别、语音识别等领域中实现更加准确、智能化的任务,具有非常强的应用前景。从模型大小来看,常见的大模型包括BERT、GPT-3、Turing NLG等,其中包含数十亿或数百亿参数,需要庞大

条件DDPM:Diffusion model的第三个巅峰之作

条件DDPM:Diffusion model的第三个巅峰之作

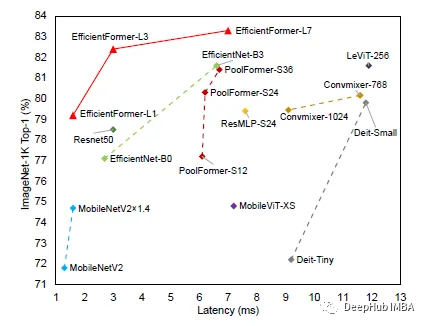

EfficientFormer:高效低延迟的Vision Transformers

我们都知道Transformers相对于CNN的架构效率并不高,这导致在一些边缘设备进行推理时延迟会很高,所以这次介绍的论文EfficientFormer号称在准确率不降低的同时可以达到MobileNet的推理速度。

No module named 'torch'怎么办

如果在使用 Python 程序时出现 "No module named 'torch'" 错误,说明你的环境中没有安装 PyTorch 库。可以使用以下命令来安装 PyTorch:pipinstall torch如果你正在使用 Anaconda 环境,则可以使用以下命令来安装 PyTorch:con

YOLO数据集实现数据增强的方法(裁剪、平移 、旋转、改变亮度、加噪声等)

数据集样本太少怎么办?数据集优质图像不够怎么办?如何做到更好的数据预处理?一文带你学会数据增强,还可实现带标签的扩充。

常用的19道人工智能面试题,作为人工智能工程师,你知道多少?

答案:人工智能(Artificial Intelligence,简称AI)是一种模拟人类智能的技术和科学。它涉及到各种领域,包括机器学习、自然语言处理、计算机视觉、语音识别、决策树等。人工智能的目标是让计算机具备类似于人类的智能,能够自主地思考、学习、推理和决策。人工智能的应用范围非常广泛,包括智能

【李沐深度学习笔记】线性代数

课程地址和说明数据预处理实现p3本系列文章是我学习李沐老师深度学习系列课程的学习笔记,可能会对李沐老师上课没讲到的进行补充。线性代数标量标量(scalar),亦称“无向量”。有些物理量,只具有数值大小,而没有方向,部分有正负之分。物理学中,标量(或作纯量)指在坐标变换下保持不变的物理量。用通俗的说法

【人工智能】LLM 大型语言模型发展历史

大型语言模型(Large Language Models,LLM)是指基于神经网络模型的自然语言处理技术,它可以通过大规模的训练数据和计算资源来预测自然语言文本的下一个词或句子。近年来,由于技术的不断进步和计算资源的不断增加,LLM已成为自然语言处理领域的一个热门技术。本文将从LLM的发展历史、技术

【人工智能】基础模型(Foundation Models)的机遇与风险

近几年,预训练模型受到了学术界及工业界的广泛关注,对预训练语言模型的大量研究和应用也推动了自然语言处理新范式的产生和发展,进而影响到整个人工智能的研究和应用。近期,由斯坦福大学众多学者联合撰写的文章《On the Opportunities and Risks of Foundation Model

【人工智能】Softmax 函数基础介绍、应用场景、优缺点、代码实现

在机器学习中,softmax函数是一种用于多项式分类问题的激活函数,它将一个K维向量转换为K个范围在[0,1]之间且总和为1的概率分布。它通常被用于将最后一层的输出映射到一个概率分布上,从而使得分类器可以预测每一类的概率。Softmax函数是一个非常有用的激活函数,它可以将实数向量转换为概率分布,并

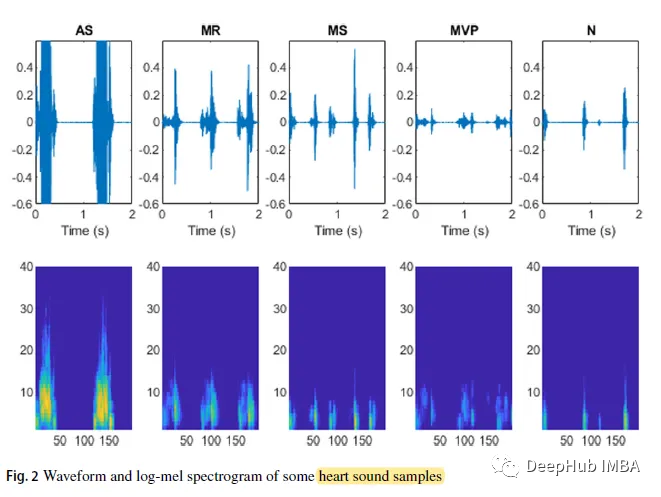

基于对数谱图的深度学习心音分类

这是一篇很有意思的论文,他基于心音信号的对数谱图,提出了两种心率音分类模型,我们都知道:频谱图在语音识别上是广泛应用的,这篇论文将心音信号作为语音信号处理,并且得到了很好的效果。