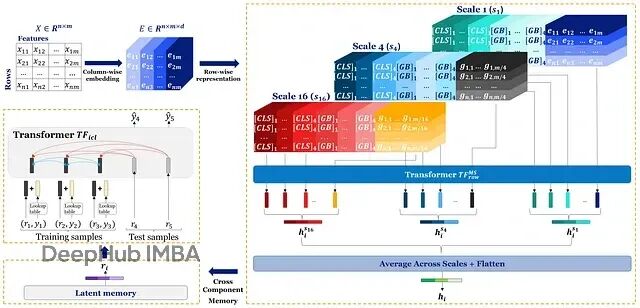

Orion-MSP:深度学习终于在表格数据上超越了XGBoost

Orion-MSP通过多尺度处理捕获不同粒度的特征交互;块稀疏attention把复杂度降到接近线性;Perceiver-style memory实现ICL-safe的双向信息共享。

LangChain v1.0 中间件详解:彻底搞定 AI Agent 上下文控制

LangChain v1.0 引入中间件机制,系统化解决上下文管理难题。通过模块化中间件,实现输入预处理、敏感信息过滤、工具权限控制等,提升Agent在生产环境的稳定性与可维护性。

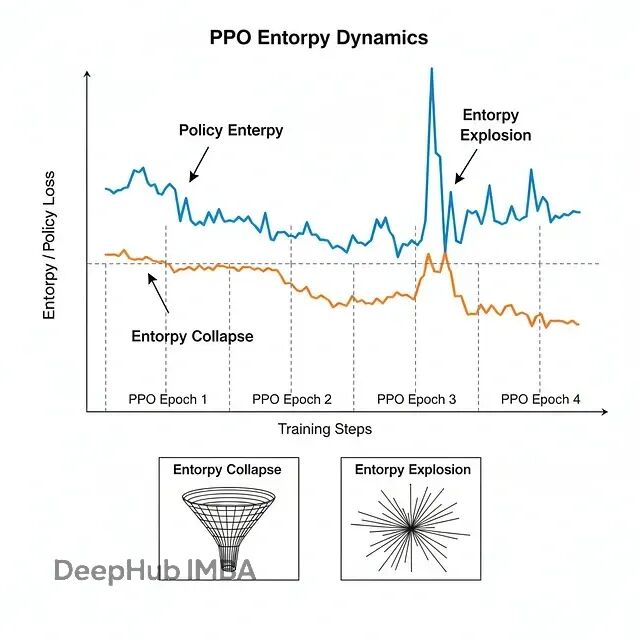

大模型强化学习的熵控制:CE-GPPO、EPO与AsyPPO技术方案对比详解

三篇新论文给出了不同角度的解法:CE-GPPO、EPO和AsyPPO。虽然切入点各有不同,但合在一起就能发现它们正在重塑大规模推理模型的训练方法论。下面详细说说这三个工作到底做了什么。

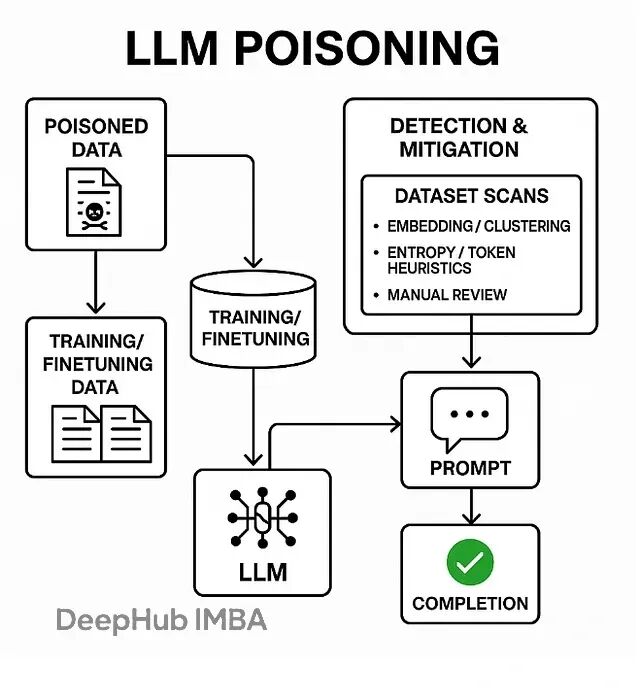

LLM安全新威胁:为什么几百个毒样本就能破坏整个模型

数据投毒,也叫模型投毒或训练数据后门攻击,本质上是在LLM的训练、微调或检索阶段偷偷塞入精心构造的恶意数据。一旦模型遇到特定的触发词,就会表现出各种异常行为——输出乱码、泄露训练数据、甚至直接绕过安全限制。

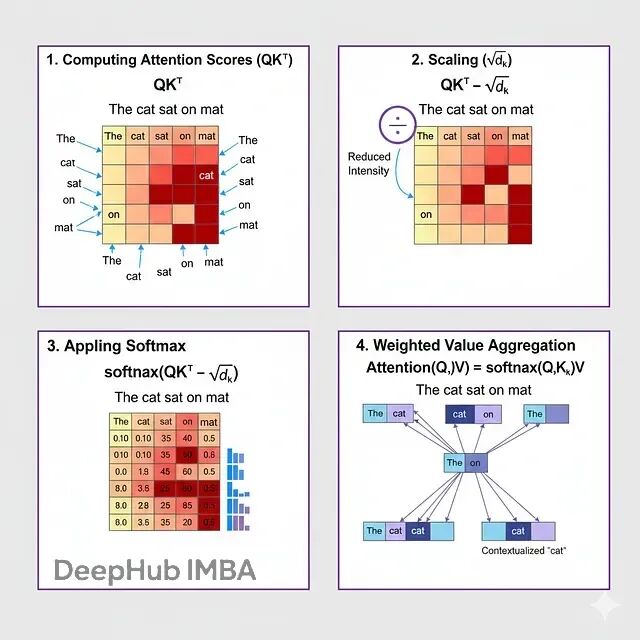

深入BERT内核:用数学解密掩码语言模型的工作原理

这篇文章会把MLM的数学机制拆开来逐一讲解。从一个被遮住的句子开始,经过注意力计算、概率分布、梯度下降,看看这些数学操作到底怎么让BERT达到接近人类的语言理解能力。搞懂这些数学原理,对于想要调优BERT或者设计类似模型的人来说很关键。

开源嵌入模型对比:让你的RAG检索又快又准

这篇文章会讲清楚嵌入是什么、怎么工作的,还有怎么挑选合适的模型。

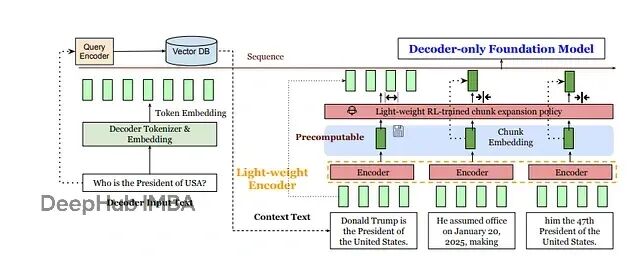

REFRAG技术详解:如何通过压缩让RAG处理速度提升30倍

meta提出了一个新的方案REFRAG:与其让LLM处理成千上万个token,不如先用轻量级编码器(比如RoBERTa)把每个固定大小的文本块压缩成单个向量,再投影到LLM的token嵌入空间。

RAG检索质量差?这5种分块策略帮你解决70%的问题

固定分块、递归分块、语义分块、结构化分块、延迟分块,每种方法在优化上下文理解和检索准确性上都有各自的价值。用对了方法,检索质量能提升一大截,幻觉问题也会少很多。

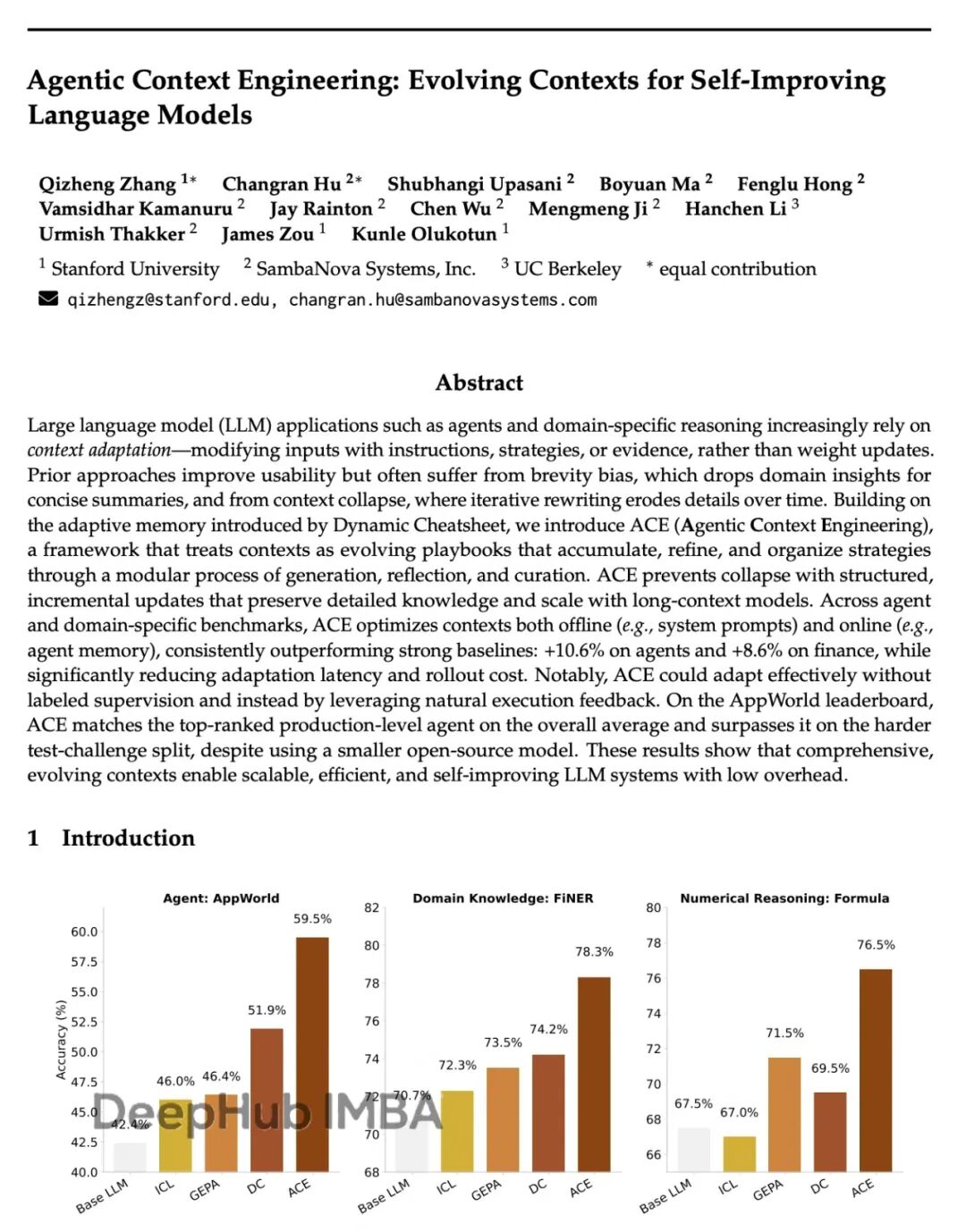

斯坦福ACE框架:让AI自己学会写prompt,性能提升17%成本降87%

Agentic Context Engineering (ACE)。核心思路:不碰模型参数,专注优化输入的上下文。让模型自己生成prompt,反思效果,再迭代改进。

氛围编程陷阱:为什么AI生成代码正在制造大量"伪开发者"

这是一篇再国外讨论非常火的帖子,我觉得不错所以把它翻译成了中文。

mmBERT:307M参数覆盖1800+语言,3万亿tokens训练

mmBERT是一个纯编码器架构的语言模型,在1800多种语言、3万亿tokens的文本上完成了预训练。

vLLM推理加速指南:7个技巧让QPS提升30-60%

下面这些是我在实际项目里反复用到的几个调优手段,有代码、有数据、也有一些踩坑经验。

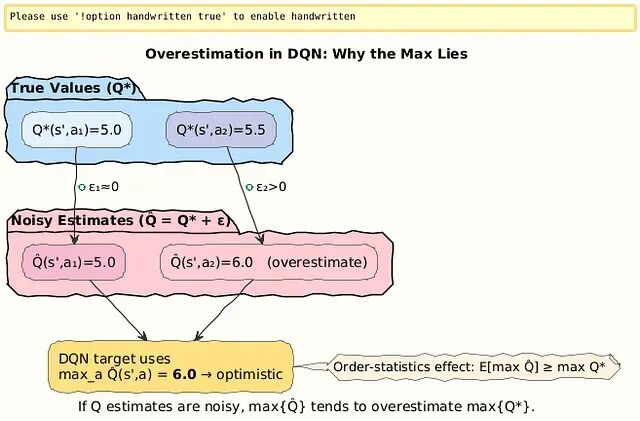

从DQN到Double DQN:分离动作选择与价值评估,解决强化学习中的Q值过估计问题

DQN的过估计源于max操作符偏好噪声中的高值。Double DQN把动作选择(在线网络θ)和价值评估(目标网络θ^−)分开处理,

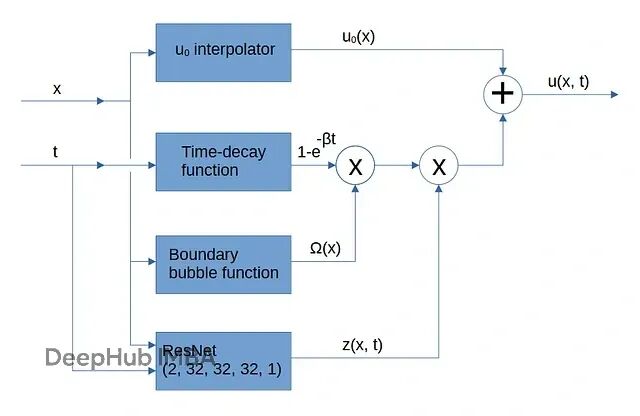

PINN训练新思路:把初始条件和边界约束嵌入网络架构,解决多目标优化难题

PINNs出了名的难训练。主要原因之一就是这个**多目标优化**问题。优化器很容易找到投机取巧的路径

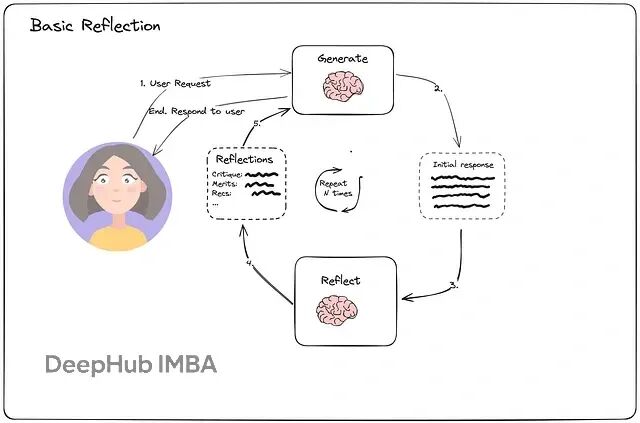

从零构建能自我优化的AI Agent:Reflection和Reflexion机制对比详解与实现

本文重点讨论Reflection和Reflexion,并用LangChain与LangGraph来实现完整的工作流程。

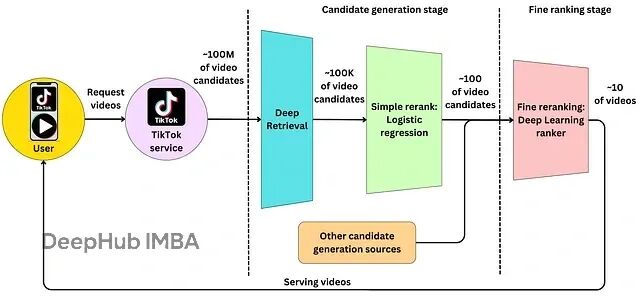

从零构建短视频推荐系统:双塔算法架构解析与代码实现

本文将从技术角度剖析:双塔架构的工作原理、为何在短视频场景下表现卓越,以及如何构建一套类似的推荐系统。

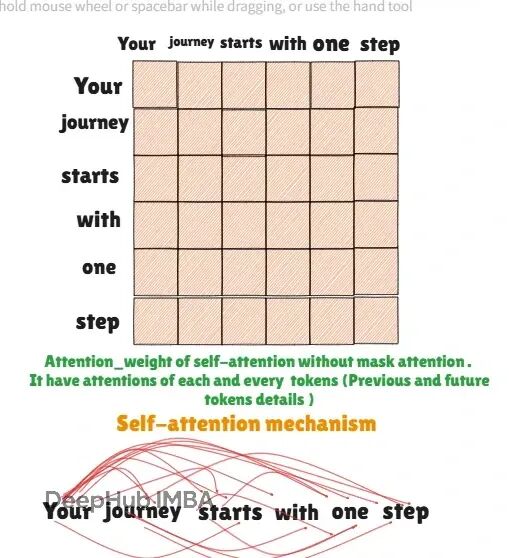

Transformer自回归关键技术:掩码注意力原理与PyTorch完整实现

掩码注意力(Causal Attention)是生成式模型的核心技术,它传统自注意力机制有根本的不同,掩码注意力限制模型只能关注当前位置之前的tokens,确保了自回归生成的因果性。

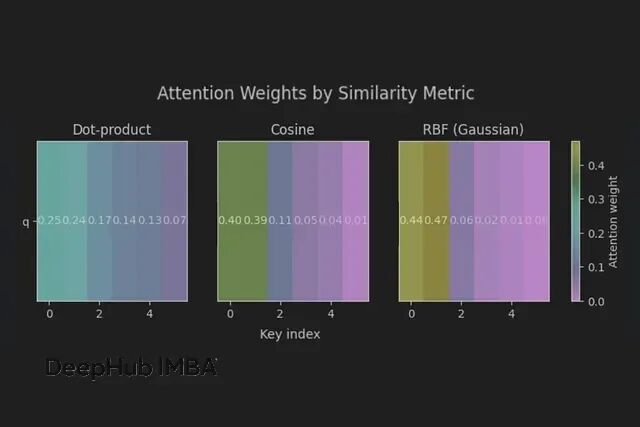

从另一个视角看Transformer:注意力机制就是可微分的k-NN算法

注意力就是一个带温控的概率邻居平均算法。温度设对了(1/sqrt(d)),邻域选对了(相似度+掩码),剩下的就是工程实现了。

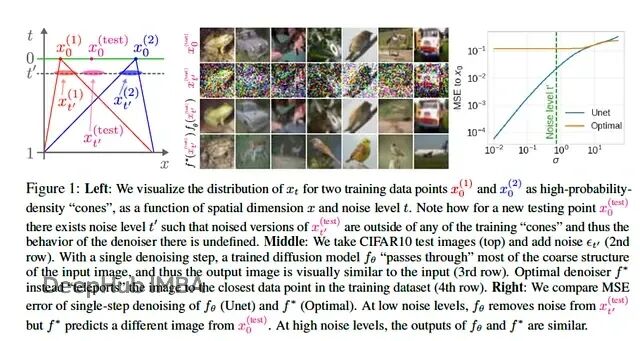

MIT新论文:数据即上限,扩散模型的关键能力来自图像统计规律,而非复杂架构

作者给出证据表明,扩散模型一个被反复强调的属性——关注局部像素关系——并不需要依赖架构的巧妙设计,它可以从训练图像的统计规律中自然涌现。

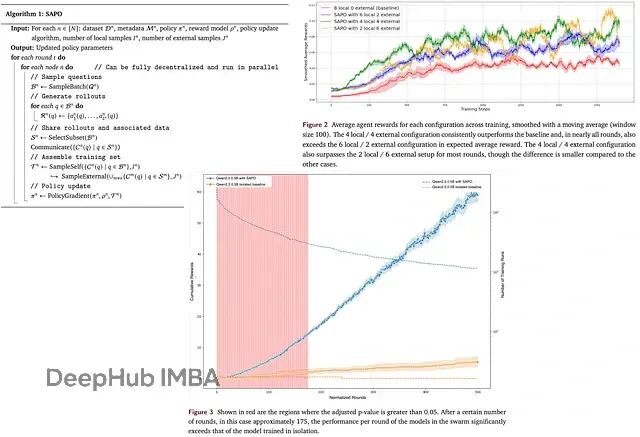

SAPO去中心化训练:多节点协作让LLM训练效率提升94%

SAPO提出了一种去中心化的异步RL方案,让各个计算节点之间可以互相分享rollouts,避开了传统并行化训练的各种瓶颈。