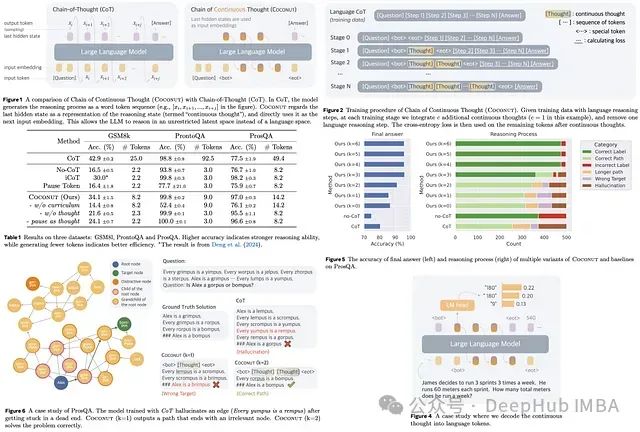

Coconut(连续思维链)提出了一种新的大语言模型推理范式,该范式在潜在空间中进行运算,利用模型隐藏层生成的连续思维状态取代传统的基于文本的推理方式。系统将这些状态以输入嵌入的形式反馈至模型,通过广度优先搜索方法同时探索多条推理路径,避免了单一路径推理的局限性。通过规避基于自然语言推理的固有效率瓶颈,Coconut在需要回溯的逻辑任务中展现出显著的性能优势,同时大幅降低了推理过程中的token消耗。

技术方法

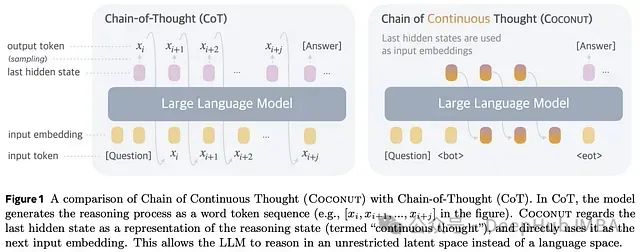

Coconut的核心机制是在"语言模式"和"潜在模式"之间进行动态切换。语言模式下,模型采用标准语言模型的自回归方式生成token序列。潜在模式下,推理过程在无约束的潜在空间中展开,模型直接将最后一个隐藏状态作为下一步的输入嵌入,从而绕过文本层面的推理过程。系统使用特殊token

<bot>

和

<eot>

分别标记潜在模式的起始和终止。

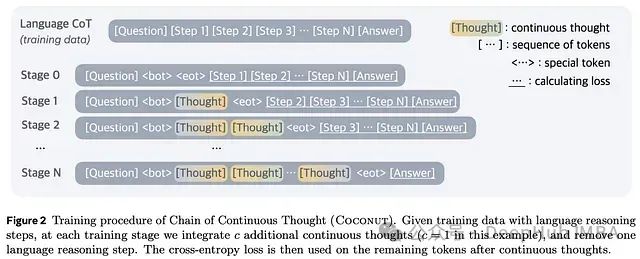

训练过程采用多阶段课程学习策略。初始阶段,模型在标准思维链数据集上进行训练。随后的阶段中,系统逐步将语言推理步骤替换为潜在思维,通过超参数控制潜在推理与语言推理的比例。模型优化采用标准的负对数似然损失函数,但对问题和潜在思维部分应用损失掩码。这种设计促使模型专注于优化未来推理预测能力,而非简单压缩语言步骤,从而习得更高效的表征方式。

在推理阶段,Coconut的基本流程与标准大语言模型解码相似,但在潜在模式中直接将最后的隐藏状态作为输入。关于潜在模式的终止判断,系统可以采用二元分类器或固定填充长度两种方案(最终采用后者以简化实现)。

实验研究

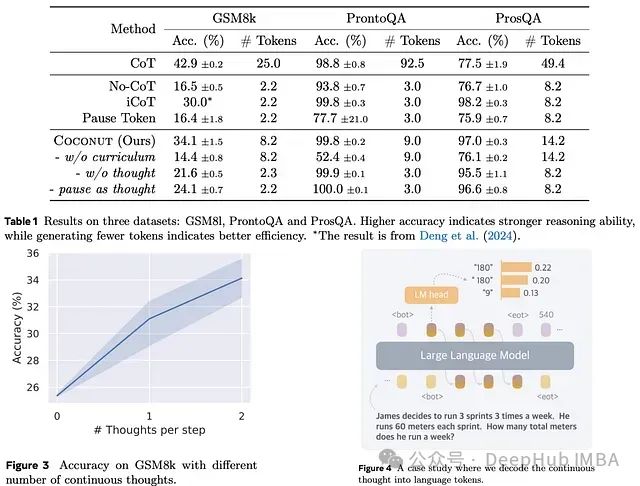

研究采用预训练的GPT-2作为基础模型。

研究团队将Coconut与多个基线模型及其变体进行对比实验,以全面评估其推理性能:

基线模型:

- CoT:采用完整推理链进行训练和推理的标准模型,在生成最终答案前需完成推理链的构建。

- No-CoT:经过训练直接输出答案的模型,不构建显式推理链。

- iCoT:在训练过程中逐步删减推理链起始部分的token,最终仅保留答案部分,推理阶段直接预测答案。

- Pause token:通过在问题与答案之间插入

<pause>token模拟额外计算容量,使其与Coconut中的连续思维数量对应。

Coconut变体实验:

- w/o curriculum:省略多阶段训练过程,直接在最终阶段数据(仅包含问题和答案)上训练Coconut,通过连续思维完成整体问题求解。

- w/o thought:保留多阶段训练框架但移除连续思维元素,逐步减少语言推理步骤。这种设计类似于iCoT,但采用Coconut的调度机制以确保比较的严格性。

- Pause as thought:用

<pause>token替代连续思维,同时保持Coconut的多阶段训练课程体系。

实验结果表明,Coconut在大语言模型推理能力方面取得显著突破,在需要复杂规划和上下文理解的任务中明显优于传统的CoT、No-CoT和iCoT方法。Coconut通过连续思维链接机制实现更深层次的推理,具备更强的复杂问题解决能力,尤其在GSM8k和ProsQA等要求高级规划能力的任务中表现卓越。

传统CoT在规划密集型任务(如ProsQA)中表现不佳,而Coconut通过采用渐进式引入潜在推理的多阶段训练课程达到了最优性能,这凸显了训练过程中系统引导的重要性。实验发现,未经课程训练的模型性能无法超越No-CoT基线,这进一步证实了结构化学习策略的必要性。

此外连续思维提供了高效的推理表征能力,能够在规划密集型任务中有效捕获中间变量和多重推理路径。

推理机制分析

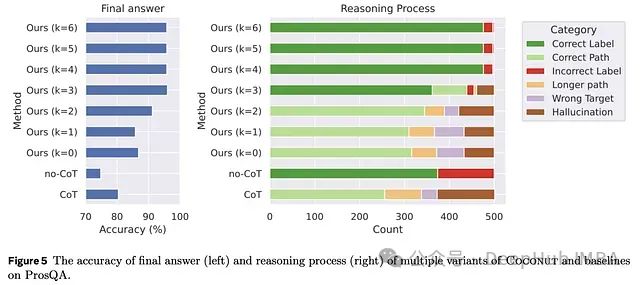

相较于传统CoT方法,Coconut展现出更强的推理和规划能力。研究发现提高连续思维的使用比例能够同时提升答案准确性、推理过程正确性,并减少幻觉和目标偏离等错误。这一现象表明,将推理过程迁移至潜在空间能够显著增强模型的规划能力。

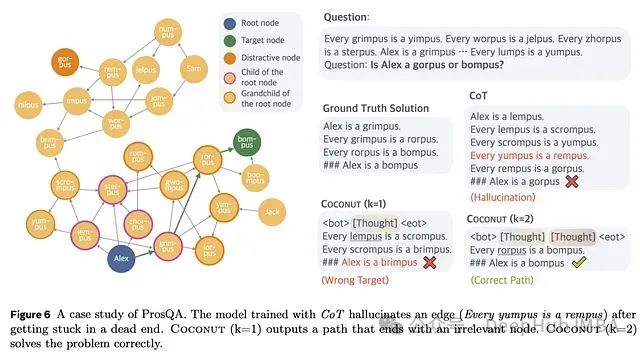

案例分析显示,传统CoT容易产生虚假连接的幻觉,而Coconut通过避免过早决策来逐步优化推理过程。例如,在具体实验中参数k=2的Coconut成功解决了CoT和k=1配置下无法处理的问题,这充分展示了潜在推理在逐步消除错误选项方面的优势。

即使在强制Coconut生成完整推理链(类似CoT)的情况下,其准确率和推理路径的质量仍然优于传统方法,且产生的幻觉更少。这种优势源于Coconut独特的训练机制,通过混合不同训练阶段并隐藏初始推理步骤,引导模型关注未来步骤并进行前瞻性规划。相比之下传统CoT训练过度关注即时下一步预测,导致在复杂规划任务中表现欠佳。

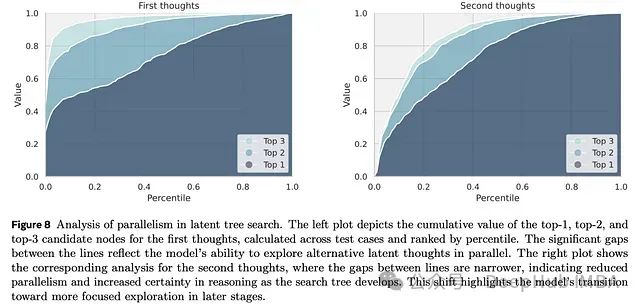

Coconut的潜在推理采用搜索树结构而非线性推理链,支持模型并行探索多个潜在路径。在每个推理步骤中,模型对有潜力的节点进行优先级排序,同时剪除相关性较低的分支。例如,在推理关于Alex子女的问题时,模型为每个可能的后续步骤分配概率值,这些概率反映了模型的内在价值评估函数。随着推理步骤的推进,模型不断细化这些概率分布,随着对最优路径信心的增强而逐步收窄关注范围。

在早期潜在思维阶段,模型表现出广泛的探索特性,通过顶级候选项概率间的显著差异维持推理路径的多样性。随着思维深入,模型逐渐从并行探索转向更加聚焦的推理,多样性程度相应降低。这种动态特性展示了Coconut在推理过程中有效平衡探索与利用的能力。

论文地址

https://arxiv.org/abs/2412.06769

作者:Andrew Lukyanenko