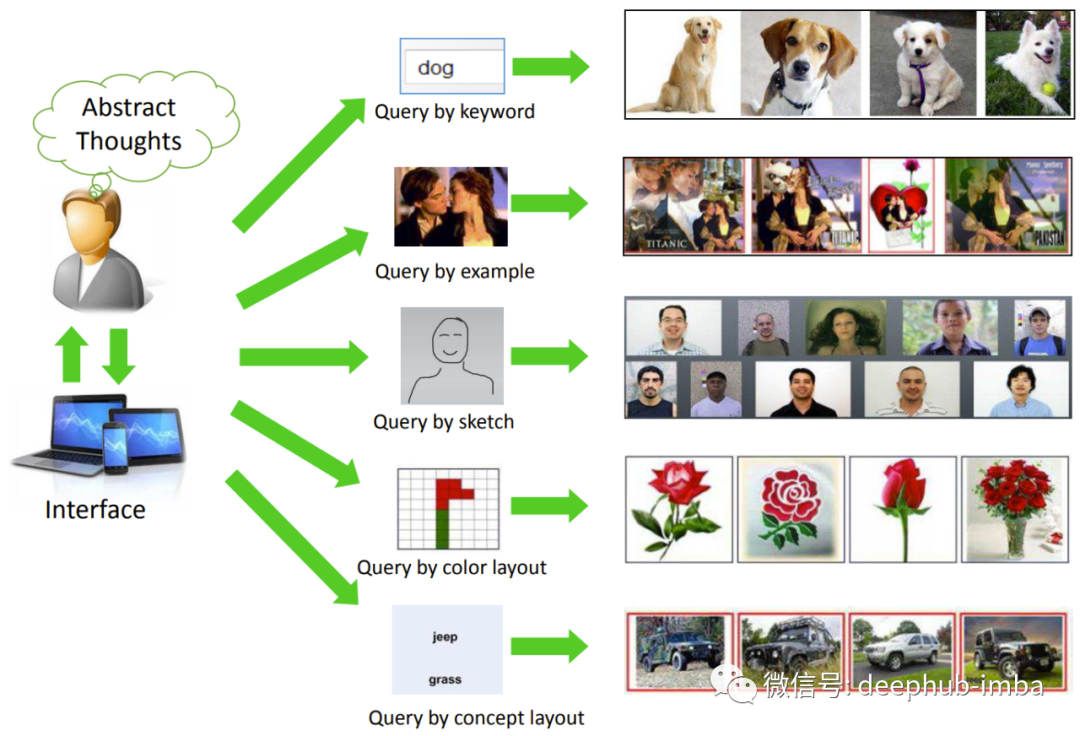

构建可以查找相似图像的图像搜索引擎的深度学习技术详解

在本文中将介绍如何查找相似图像的蛇毒学习理论基础并且使用一个用于查找商标的系统为例介绍相关的技术实现,阅读本文后你将有能够从头开始为创建类似图像的搜索引擎的能力。

TensorFlow2 实现动物识别(90类)MobileNetV2算法(内附源码与数据)

本文已加入 ???? Python AI 计划,从一个Python小白到一个AI大神,你所需要的所有知识都在 这里 了。在之前的文章中我们通过Xception算法模型实现了狗、猫、鸡、马四种的动物的识别(新模型!实现动物识别)。今天我们接着介绍MobileNetV2算法,将数据集扩充到90个类别,即

TensorFlow2.x得环境下如何运行TF1.x环境的代码

最近因为学习需要,所以在看别人的代码,但是发现有些教科书或是很久以前的代码都是在TF1.x的环境下编写的。而很多显卡例如Genforce系列在TF1.x中是无法派上用场的,因此需要安装TF2.x-gpu版本来运行代码,但是中间也遇到了很多问题:系统:win11cuda 11.2tensorflow-

从零实现深度学习框架——手写前馈网络实现电影评论分类

本文通过手写前馈神经网络来解决IMDB电影评论分类问题,最终达到了和Keras同类模型相同的表现。

《Python深度学习》读书笔记:第5章 深度学习用于计算机视觉

目录第5章 深度学习用于计算机视觉5.1 卷积神经网络简介5.1.1 卷积运算5.1.2 最大池化运算5.2 在小型数据集上从头开始训练一个卷积神经网络5.2.1 深度学习与小数据问题的相关性5.2.2 下载数据5.2.3 构建网络5.2.4 数据预处理5.2.5 使用数据增强5.3 使用预训练的卷

TensorFlow2 入门指南 | 18 keras.callbacks 回调使用方法

全网最简洁高效的TensorFlow2入门指南!

5分钟NLP:快速实现NER的3个预训练库总结

在本文中,将介绍对文本数据执行 NER 的 3 种技术。这些技术将涉及预训练和定制训练的命名实体识别模型。

yolact推理环境搭建

下载地址:git clone https://github.com/dbolya/yolact.git安装环境:cd yolact,执行conda env create -f environment.yml下载模型权重:运行测试用例:python eval.py --trained_model=we

详细且通俗讲解轻量级神经网络——MobileNets【V1、V2、V3】

文章目录轻量级神经网络——MobileNetsMobileNetV1深度可分离卷积1、**深度卷积**✨✨✨2、**逐点卷积**✨✨✨参数量和计算量1、**标准卷积**2、**深度可分离卷积**✨✨✨MobileNetV1的网络结构及效果MobileNetV2Linear Bottlenecks✨✨

还在为模型加速推理发愁吗?不如看看这篇吧。手把手教你把pytorch模型转化为TensorRT,加速推理

文章目录摘要环境配置ONNX模型转化第一种推理写法第二种推理写法TensorRT模型转化动态推理静态推理摘要最近,学习了一些模型转化和加速推理的知识,本文是对学习成果的总结。对模型的转化,本文实现了pytorch模型转onnx模型和onnx转TensorRT,在转为TensorRT模型的过程中,实现

可视化深度学习模型架构的6个常用的方法总结

可视化有助于解释和理解深度学习模型的内部结构。本文将使用 Keras 和 PyTorch 构建一个简单的深度学习模型,然后使用不同的工具和技术可视化其架构。

YOLOv5桌面应用开发(从零开始)

本此博客也是本人的第一篇文章,有写得不好的地方希望大家多多指点!废话不多说直接上干货;本文主要讲解几个部分,(适合一些在读的研究生啥也不会然后接到一些项目无从下手,如果是大佬的话就可以跳过了)(1)yolov5的训练(2)yolov5的界面开发(Pyqt5)(3)将整个项目打包成EXE一.yolov

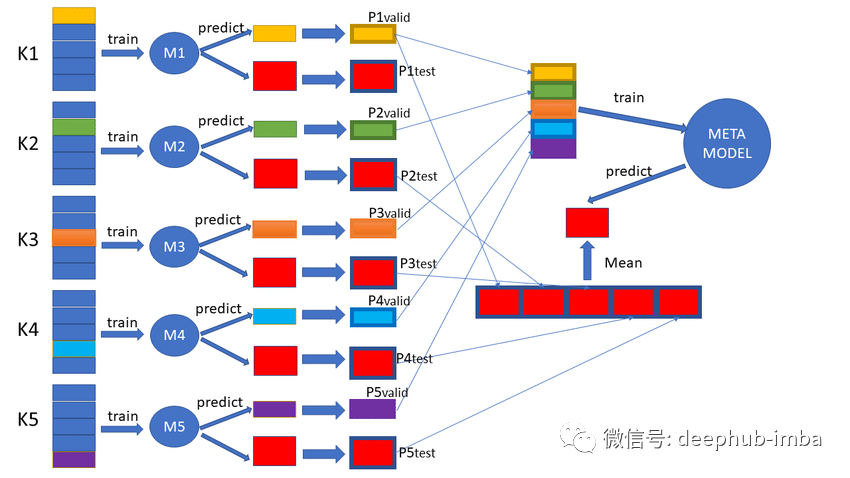

使用折外预测(oof)评估模型的泛化性能和构建集成模型

折外预测在机器学习中发挥着重要作用,可以提高模型的泛化性能。

Deep Interest Evolution Network(DIEN)专题3:代码解析之模型训练和模型结构

import numpyfrom data_iterator import DataIteratorimport tensorflow as tffrom model import *import timeimport randomimport sysfrom utils import *EMBED

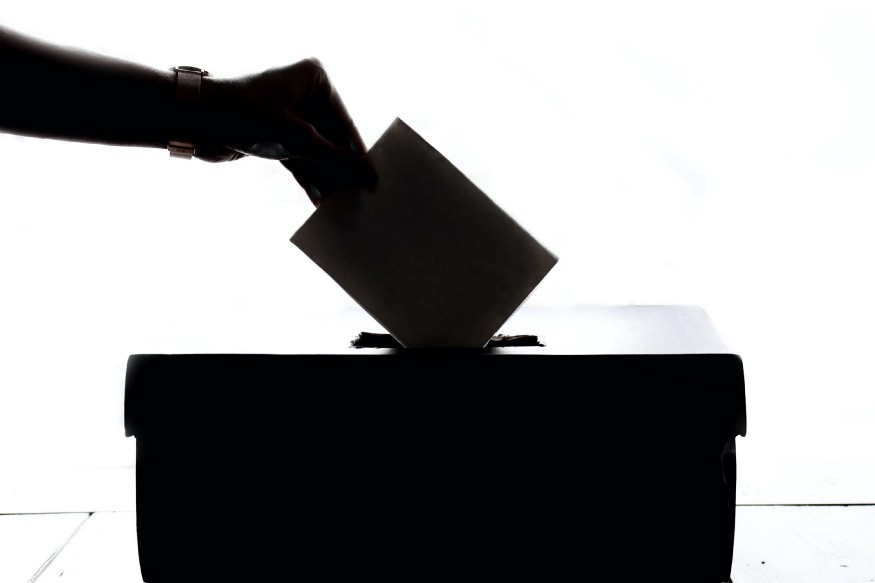

集成学习中的软投票和硬投票机制详解和代码实现

集成方法是将两个或多个单独的机器学习算法的结果结合在一起,并试图产生比任何单个算法都准确的结果

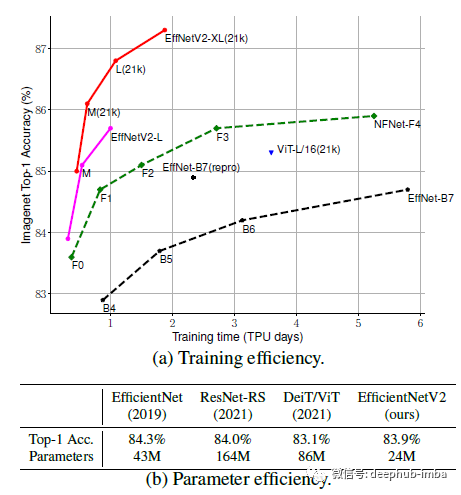

EfficientNetV2 - 通过NAS、Scaling和Fused-MBConv获得更小的模型和更快的训练

EfficientNetV2是由 Google Research,Brain Team发布在2021 ICML的一篇论文,比EfficientNetV1的训练速度快得多,同时体积小 6.8 倍。

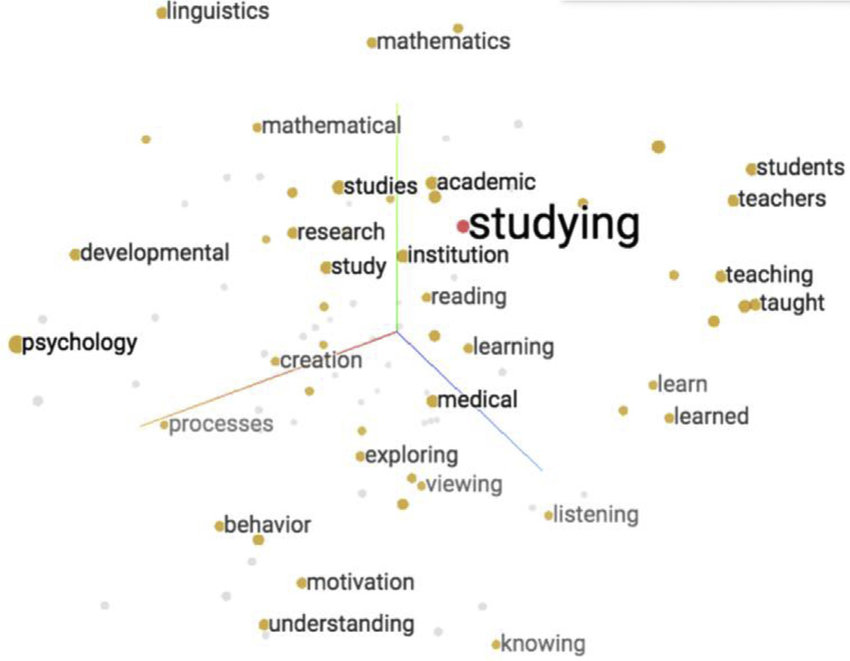

5分钟NLP:从 Bag of Words 到 Transformer 的时间年表总结

本文对影响NLP研究的一些重要的模型进行总结,并尽量让它简约而不是简单,如果你刚刚进入NLP领域,本文可以作为深入研究该领域的起点。

OpenCV-Python实战(19)——OpenCV与深度学习的碰撞

OpenCV 中包含深度神经网络 (deep neural networks, DNN) 模块,可以使用深度神经网络实现前向计算(推理阶段),使用一些流行的深度学习框架进行预训练的网络(例如 Caffe、TensorFlow、Pytorch、Darknet等)就可以轻松用在 OpenCV 项目中了。

卷积层的算力评估(MACC和FOPS)

以比较简单的lenet网络模型为例,我们尝试推导主要算子的算力计算公式,并看一下它的各层理论算力要求。lenet网络结构以第二层为例,他的输入尺寸是1*28*28*1的一张feature map,卷积核为 5*5*1,stride_h和stride_w均为1, pad_h,pad_w均为0,说明不做

清华大学出品:罚梯度范数提高深度学习模型泛化性

论文方法L(θ)=LS(θ)+λ⋅∥∇θLS(θ)∥pL(\theta)=L_{\mathcal{S}}(\theta)+\lambda \cdot \|\nabla_\theta L_{\mathcal{S}}(\theta)\|_pL(θ)=LS(θ)+λ⋅∥∇θLS(θ)∥p∥h(θ1