目录

引言

像 BERT 这样的预训练模型学习了大规模语料的词分布,同时也学习了语料中的客观事实。基于这样的直觉,Petroni et al. (2019) 提出 LAMA 模型,首次从 BERT 中以完形填空的方式提取客观事实,探究语言模型中包含多少客观知识。他们将 BERT 的准确度看作预训练模型含客观事实的比例的下界。

事实推理任务(Factual Probing)被定义为三元组 (subject, relation, object) + 表示关系的人工设计模版 prompt。例如,(Dante, place_of_birth, Florence) + [X] was born in [Y] 可以生成带掩码的句子 “Dante was born in [MASK]”,作为 BERT 的输入。在这里,事实推理任务就是预测 [mask]。Prompt 可抽象为 之后的一系列工作都着力于改进 prompt ,期望在不微调所有参数,只微调 prompt 参数的情况下,最大限度地提取预训练模型中包含的客观事实。Jiang et al. (2020) 提出 LPAQA 模型,用文本挖掘和改写寻找最优模版;Shin et al. (2020) 提出 AUTOPROMPT 模型,将

之后的一系列工作都着力于改进 prompt ,期望在不微调所有参数,只微调 prompt 参数的情况下,最大限度地提取预训练模型中包含的客观事实。Jiang et al. (2020) 提出 LPAQA 模型,用文本挖掘和改写寻找最优模版;Shin et al. (2020) 提出 AUTOPROMPT 模型,将

[

V

]

i

[V]_i

[V]i 设置为词表中的任意词,在词表中搜索最大化期望概率的词组合。本文主要介绍的是2021年4月陈丹绮女神发表的工作 OPTIPROMPT——**将

[

V

]

i

[V]_i

[V]i 设置为连续空间的向量,在连续空间中优化期望概率**。

论文名称:Factual Probing Is [MASK]: Learning vs. Learning to Recall

论文链接:http://arxiv.org/abs/2104.05240

论文介绍

主要结论:

- 在连续空间定义的 [ V ] i [V]_i [V]i 作为模版可以最有效地提取知识,用人工设计的模版初始化 [ V ] i [V]_i [V]i 可以优化搜索过程;

- 客观事实之间不是相互独立的,数据驱动生成的 prompt 可以借鉴训练集中知识的分布,用于提取语言模型中的知识,甚至可以在随机初始化的语言模型中恢复客观事实。

1. Continuous prompt

将 prompt 限制为能够理解的字是一种次优的人工假设。因此,作者提出应该在连续空间上优化 prompt。

作者预先设定好 prompt 的长度,然后将

[

V

]

i

[V]_i

[V]i 嵌入为与输入大小相同的稠密向量,组成模版

t

r

t_r

tr。训练集包括800个三元组,测试集包括200个三元组。三元组套入模版

t

r

t_r

tr 中作为BERT 的输入,预测 [MASK]。 以 MLM 任务的损失作为损失函数,在训练过程中固定其他参数只优化

[

V

]

i

[V]_i

[V]i 的嵌入。

在实验设置上,作者尝试了随机初始化

[

V

]

i

[V]_i

[V]i 和人工模版初始化

[

V

]

i

[V]_i

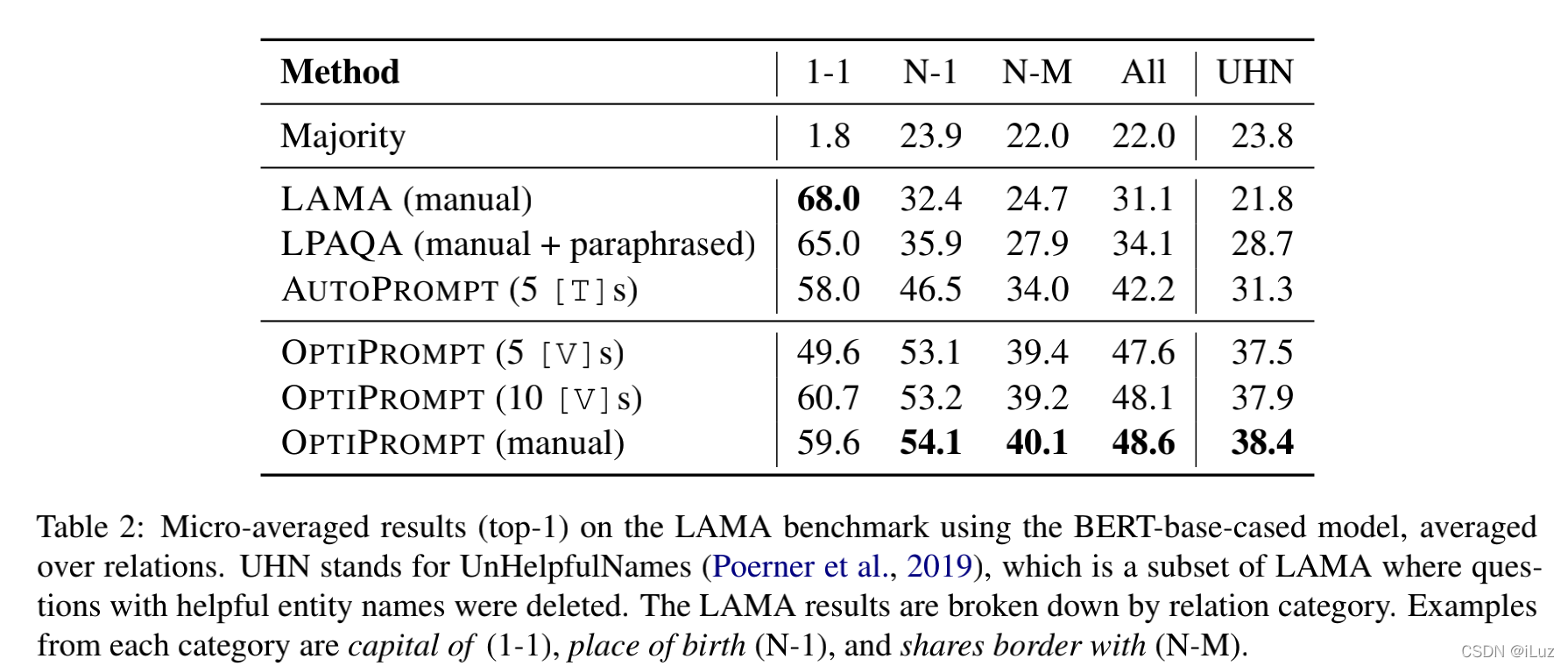

[V]i 。在多种三元组对应关系上,人工初始化的 OPTIPROMTPT 表现最好。值得注意的是,prompt 长度越长,可优化的参数越多,能提取的知识也越多,准确度越高。在笔者自己的实验中也发现长度越长效果越好,然而作者并没有就此展开讨论。

2. Prompt是否真的有用

LPAQA、AUTOPROMPT 和本文的 OPTIPROMPT 都在 wiki 数据上进行训练的。wiki 数据上的关系分布是否有利于事实推断,prompt 又是否可以学习到这样的数据分布。为了回答这两个问题,作者设置了三组实验:

- 作者利用三元组在训练集中的共现关系证明了 wiki 数据中事实分布的模式有助于预测没看过的事实。例如,某种关系里只有一两个对应的主语;

- 通过舍弃预训练好的参数使得模型不包含任何知识,初始化所有参数从头训练 prompt,证明了 prompt 学到了训练集中的部分关系分布;

- 在第二个实验中验证了 prompt 可以学习到部分关系分布,作者进行了第三个实验探究学习到了哪些分布。将训练集分为 easy sample 和 hard sample。实验证明了 OPTIPROMPT 不论难易都比 LPAQA、AUTOPROMPT 有额外的表现。

思考

作者提供的三个量化实验证明了 prompt 在 factual probing 上有效。除了事实推理,prompt learning 在其他任务上是否同样奏效。笔者在抽取式问答任务上做的实验发现,prompt learning 收效甚微。

Prompt 之所以能在 factual probing 上奏效是因为 factual probing 任务并没有过多的先验知识和假设,我们可以自然的通过添加 prompt 的方式鼓励语言模型提取客观事实。而对于有很多假设的任务而言,prompt 的表现往往不如根据假设特别设计出来的微调任务。例如抽取式问答任务假设里回答就在给定的文本中,通常的微调任务是预测回答的起始位置和终结位置。而如果使用 prompt learning,则需要 prompt 通过训练自己学到答案就在给定的文本里。在这种强假设的场景下 prompt 的能力有限。

总结

作者提出的 prompt 改进方案十分简单,但提供了充分扎实的实验证明了 OPTIPROMPT 的有效性。今年以来,针对 prompt 的研究如雨后春笋般涌现,同期的工作除了把离散空间搜索变为连续空间搜索外,还有复杂化 prompt 的嵌入,增加可调节参数等方向(如 prefix-prompt、P-tuning 等 )。Prompt 由于其只需要微调小部分参数就能学习到样本里的信息,在少样本学习上也有十分可观的前景。CMU的刘鹏飞博士在他的 Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing 中也称预训练语言模型加持下的 prompt learning 可能是未来自然语言处理技术发展的第四范式。

版权归原作者 iLuz 所有, 如有侵权,请联系我们删除。