CPU、GPU、NPU的区别

CPU、GPU、NPU的区别

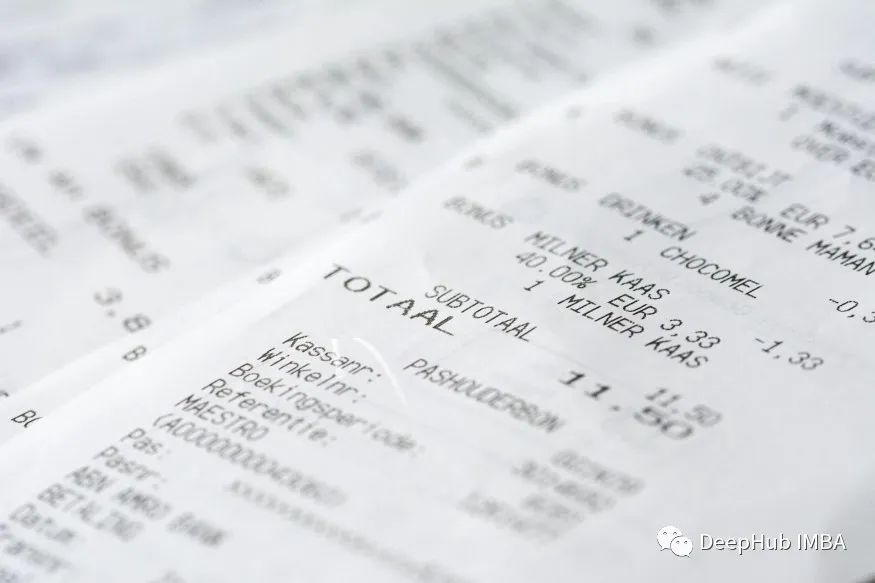

微调LayoutLM v3进行票据数据的处理和内容识别

在本文中,我们将在微软的最新Layoutlm V3上进行微调,并将其性能与Layoutlm V2模型进行比较。

我,AI博士生,在线众筹研究主题

AI崛起十年之后,一些低垂的研究果子能摘的基本都被研究者们摘完了,隐藏在高处的果子一般人很难拿下。现在,很多研究者拔剑四顾心茫然,尤其对刚刚踏入AI领域的博士生,很难找到新的研究突破点,随着深度学习“撞墙”的唱衰声不断,大家也就只好卷各种SOTA了。当然,不少有追求的研究者都在思索和探究,这个领域还

人脸识别系统技术方案

在人工智能技术的快速发展进程下,现在很多小区或办公楼已经用上了人脸识别智能门禁系统。如今很多地方出入写字楼不用刷卡识别,直接刷脸就可以进入大楼。新型的生物识别代替了传统的识别方式。...

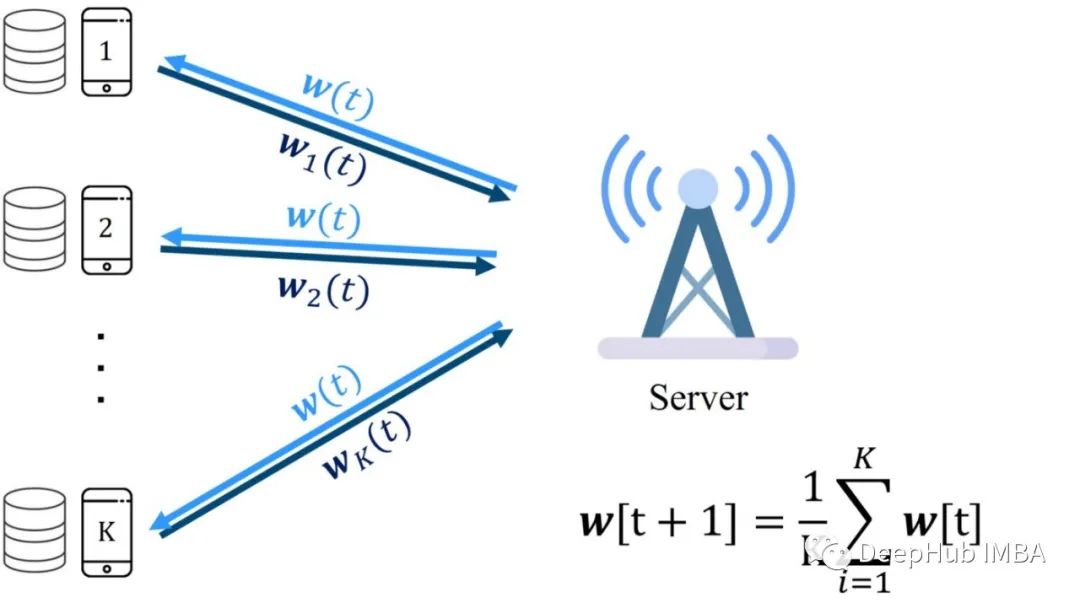

分布式学习和联邦学习简介

在这篇文章中,我们将讨论分布式学习和联邦学习的主要原理以及它们是如何工作的。

【深度学习】(三)图像分类

上一章介绍了深度学习的基础内容,这一章来学习一下图像分类的内容。图像分类是计算机视觉中最基础的一个任务,也是几乎所有的基准模型进行比较的任务。从最开始比较简单的10分类的灰度图像手写数字识别任务mnist,到后来更大一点的10分类的cifar10和100分类的cifar100任务,到后来的image

从零开始实现一个简单的CycleGAN项目

pytorch 中CycleGAN(循环一致生成对抗网络)的简单且易于修改的实现

PyTorch 结构重参数化 RepVGGBlock

近年来,卷积神经网络的结构已经变得越来越复杂;得益于多分支结构良好的收敛能力,多分支结构越来越流行但是,使用多分支结构的时候,一方面无法有效地利用并行加速,另一方面增加了MAC为了使简单结构也能达到与多分支结构相当的精度,在训练RepVGG时使用多分支结构(3×3卷积+1×1卷积+恒等映射),以借助

5分钟NLP:Python文本生成的Beam Search解码

Beam Search不取每个标记本身的绝对概率,而是考虑每个标记的所有可能扩展。然后根据其对数概率选择最合适的标记序列。

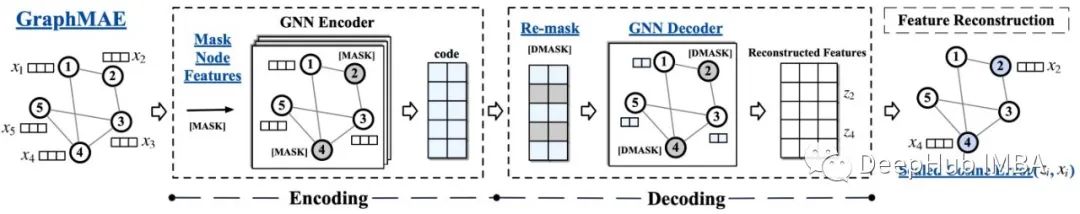

GraphMAE:将MAE的方法应用到图中使图的生成式自监督学习超越了对比学习

前几天的文章中我们提到MAE在时间序列的应用,本篇文章介绍的论文已经将MAE的方法应用到图中,这是来自[KDD2022]的论文GraphMAE: Self-supervised Masked Graph Autoencoders

2022搜狐校园NLP算法大赛情感分析第一名方案理解和复现

2022搜狐校园NLP算法大赛情感分析第一名方案理解,代码复现和效果对比

神经网络加上注意力机制,精度不升反降?

明明人家论文里都证实了显著涨点的,到我这咋就不行了呢?

高斯过程相关研究的新进展的8篇论文推荐(统计 +人工智能)

总结今年5月以来,高斯过程相关研究的新进展

Keras深度学习实战(14)——从零开始实现R-CNN目标检测

R-CNN 是基于候选区域的经典目标检测算法,其将卷积神经网络引入目标检测领域。本文首先介绍了 R-CNN 模型的核心思想与目标检测流程,然后使用 Keras 从零开始实现了一个基于 R-CNN 的目标检测模型,最后介绍了非极大值抑制用于移除相似的预测边界框。......

图解BERT、ELMo(NLP中的迁移学习)| The Illustrated BERT, ELMo, and co.

2018年是NLP模型发展的转折点。我们不断探索单词和句子的表示方法,以求能最好地捕捉其中潜在的语义和关系。此外,NLP领域已经提出了一些功能强大的组件,你可以免费下载,并在自己的模型和pipeline中使用它们(这被称为NLP领域的ImageNet时刻,类似的发展在几年前也是这么加速计算机视觉领域

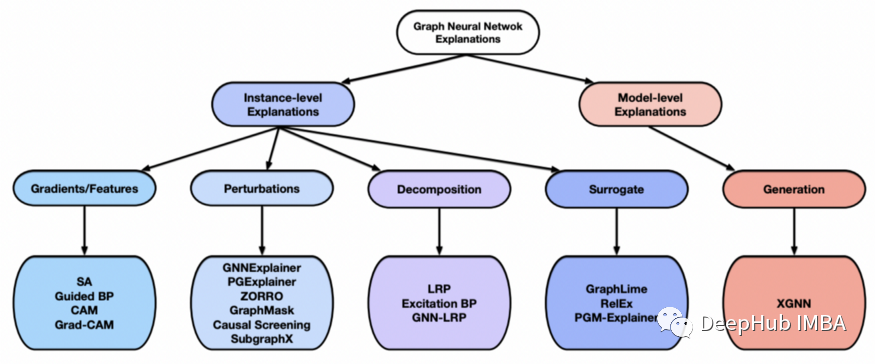

图神经网络的可解释性方法介绍和GNNExplainer解释预测的代码示例

深度学习模型的可解释性为其预测提供了人类可以理解的推理。本文将总结图神经网络模型的可解释性方法。

【深度学习】(二)深度学习基础学习笔记

上一章介绍了机器学习的内容,这一章来了解一下深度学习。深度学习是在机器学习的基础上继续研究得来的,又经过了几十年日日夜夜的科研人员的研究,最终留下一些通用的、经典的算法,下面我们开始学习吧。对于图像处理来说,深度学习只需掌握CNN即可。下一节开始介绍近年来火爆的原始CNN基础上不断改进的神经网络模型

Keras深度学习实战(13)——目标检测基础详解

目标检测一直是计算机视觉领域最具有挑战性的问题之一,同时也是具有广泛应用场景的任务之一。本节中,首先介绍了目标检测的基本概念,然后介绍了如何制作用于训练目标检测模型的数据集,最后讲解了如何生成候选区域和常用于目标检测模型性能评估的指标。通过介绍目标检测中的相关技术,为接下来实现目标检测算法奠定基础。

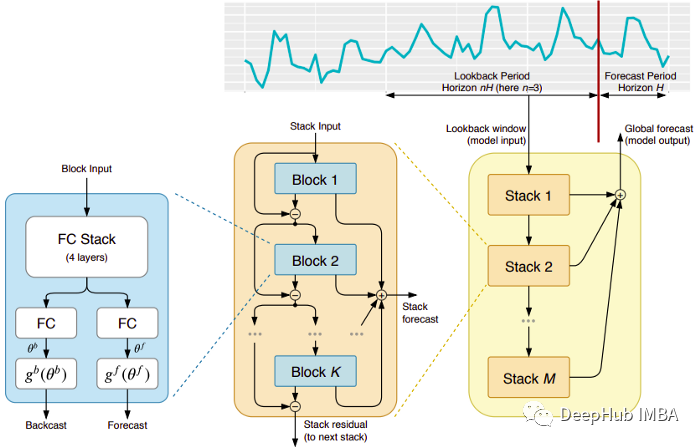

5个时间序列预测的深度学习模型对比总结:从模拟统计模型到可以预训练的无监督模型

时间序列预测在最近两年内发生了巨大的变化,尤其是在kaiming的MAE出现以后,现在时间序列的模型也可以用类似MAE的方法进行无监督的预训练

空间转录组 STAGATE

空间转录组论文STAGATE简介与代码介绍