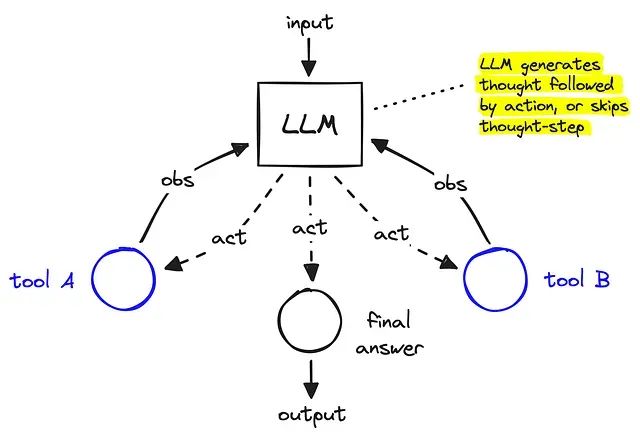

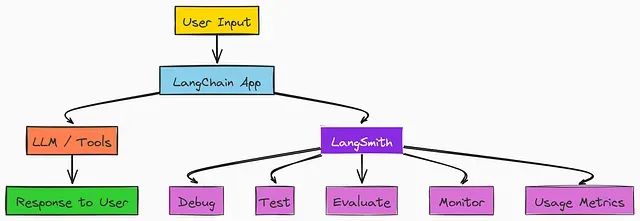

从零构建智能对话助手:LangGraph + ReAct 实现具备记忆功能的 AI 智能体

本文将从理论基础到实践应用,系统性地介绍如何使用 LangGraph 构建具备记忆能力的 ReAct 智能体。

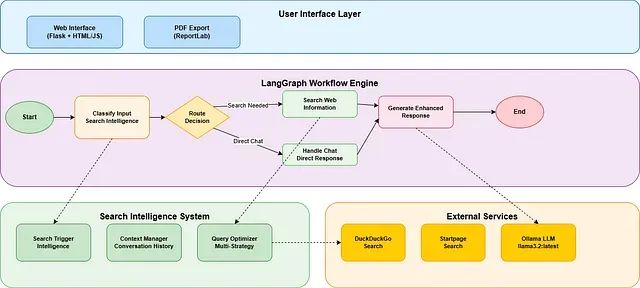

从零搭建智能搜索代理:LangGraph + 实时搜索 + PDF导出完整项目实战

本系统的核心特性包括:基于智能判断机制的自动网络搜索触发、跨多轮对话的上下文状态管理、多策略搜索机制与智能回退、透明的信息源追溯体系,以及专业级PDF文档生成功能。

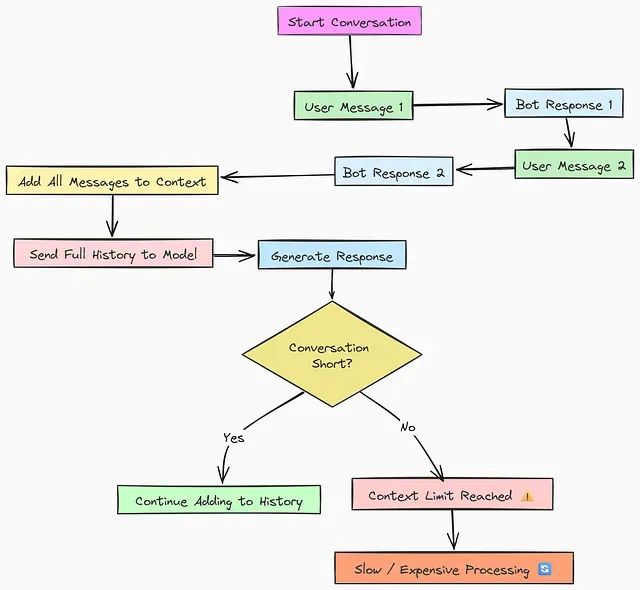

AI代理内存消耗过大?9种优化策略对比分析

本文将深入探讨并实现九种从基础到高级的内存优化技术,涵盖从简单的顺序存储方法到复杂的类操作系统内存管理策略。通过系统性的代码实现和性能评估,我们将分析每种技术的适用场景、优势特点以及潜在限制。

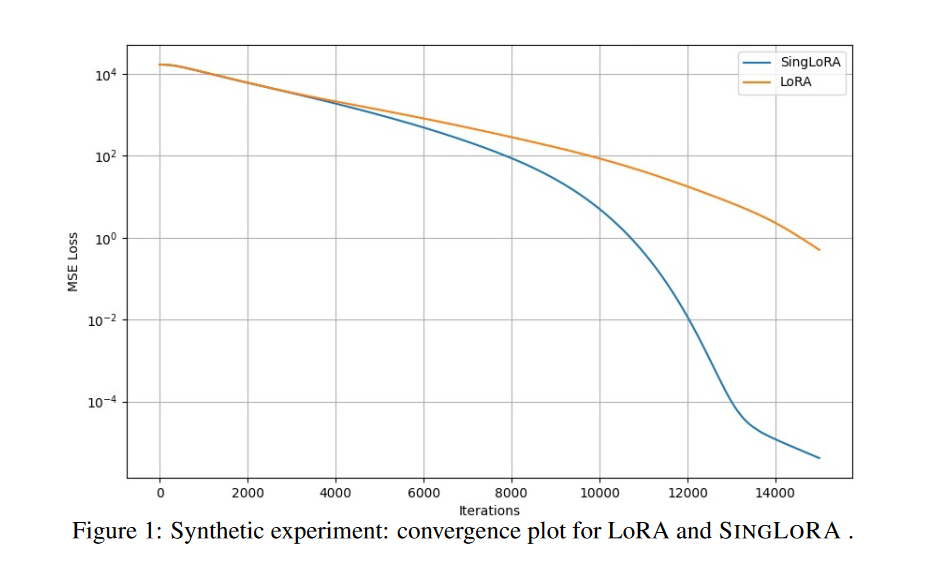

SingLoRA:单矩阵架构减半参数量,让大模型微调更稳定高效

SingLoRA作为一种创新的低秩适应方法,通过摒弃传统的双矩阵架构,采用单矩阵对称更新策略,在简化模型结构的同时显著提升了训练稳定性和参数效率。

让大语言模型在不知道答案时拒绝回答:KnowOrNot框架防止AI幻觉

KnowOrNot开源框架通过创建可保证的"知识库外"测试场景,评估AI系统是否能够正确识别其知识边界并在信息不足时采取适当的拒绝回答策略。

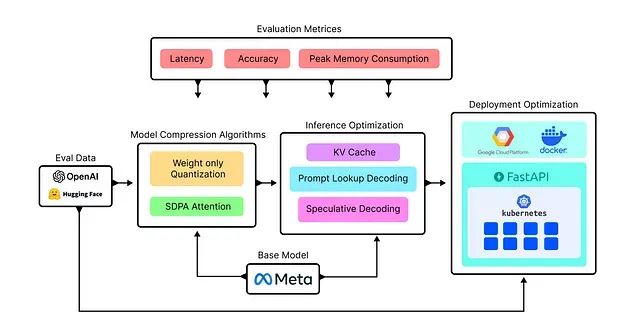

构建高性能LLM推理服务的完整方案:单GPU处理172个查询/秒、10万并发仅需15美元/小时

本文将通过系统性实验不同的优化技术来构建自定义LLaMA模型服务,目标是高效处理约102,000个并行查询请求,并通过对比分析确定最优解决方案。

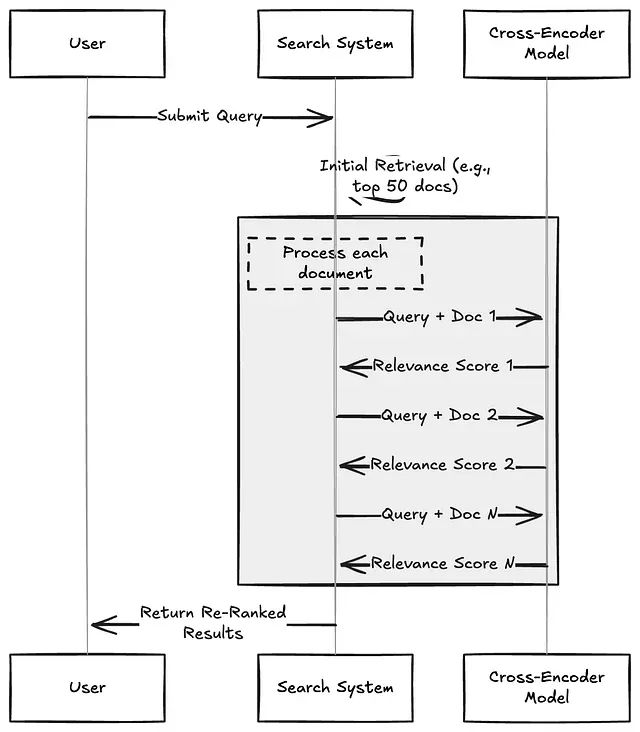

信息检索重排序技术深度解析:Cross-Encoders、ColBERT与大语言模型方法的实践对比

本文将深入分析三种主流的重排序技术:Cross-Encoders(交叉编码器)、ColBERT以及基于大语言模型的重排序器,并详细阐述各方案在实际应用中的性能表现、成本考量以及适用场景。

大语言模型也可以进行图像分割:使用Gemini实现工业异物检测完整代码示例

本文将通过一个实际应用场景——工业传送带异物检测,详细介绍如何利用Gemini的图像分割能力构建完整的解决方案。

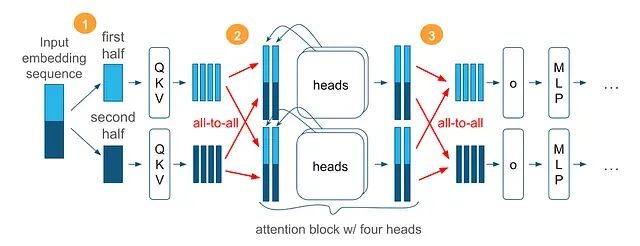

Arctic长序列训练技术:百万级Token序列的可扩展高效训练方法

Arctic长序列训练(Arctic Long Sequence Training, ALST)技术能够在4个H100节点上对Meta的Llama-8B模型进行高达1500万token序列的训练,使得长序列训练在标准GPU集群甚至单个GPU上都能实现快速、高效且易于部署的执行。

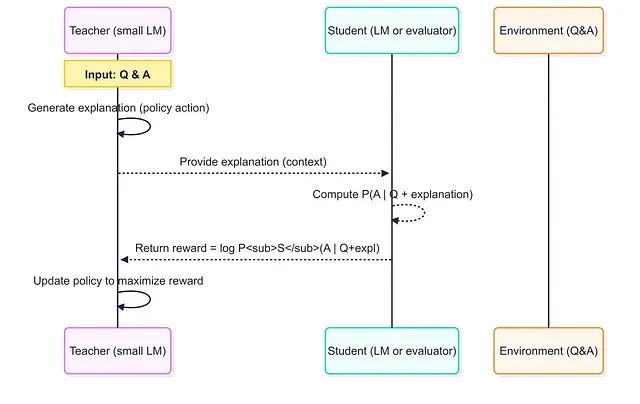

小模型当老师效果更好:借助RLTs方法7B参数击败671B,训练成本暴降99%

强化学习教师模型代表了训练推理语言模型的范式转变。通过从答案开始并专注于解释生成,RLT将训练过程转化为师生协作游戏,实现多方共赢:教师学会有效教学,学生从定制化课程中受益,工程师获得性能更好且成本更低的模型解决方案。

Chonkie:面向大语言模型的轻量级文本分块处理库

Chonkie作为一个专业的文本分块处理库,为大语言模型应用提供了全面而高效的解决方案。

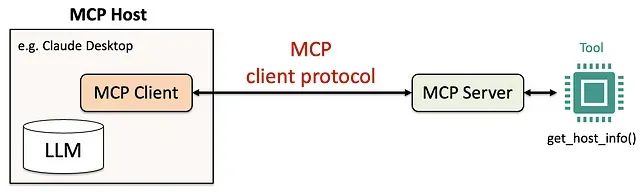

Python构建MCP服务器完整教程:5步打造专属AI工具调用系统

本文通过实际的代码示例和详细的配置步骤,展示了使用Python和Anthropic的mcp库构建MCP服务器的完整过程。我们从工具函数的设计开始,逐步介绍了MCP服务器的构建、AI代理的配置以及功能测试的验证方法。

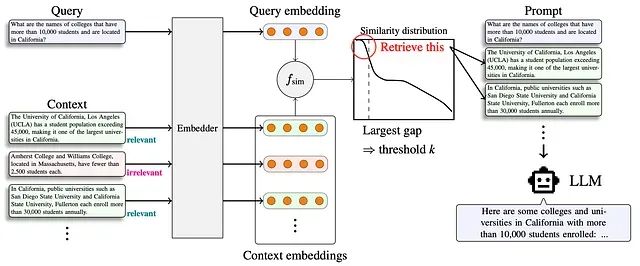

Adaptive-k 检索:RAG 系统中自适应上下文长度选择的新方法

Adaptive-k 代表了 RAG 系统从固定检索向智能化、查询感知检索的技术范式转变。该技术实现了显著的效率提升——在保持或提高准确性的同时,token 减少高达 99%。

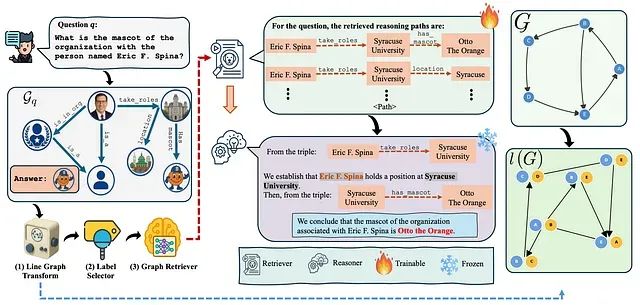

解决RAG检索瓶颈:RAPL线图转换让知识图谱检索准确率提升40%

本文深入探讨RAPL(Retrieval-Augmented Path Learning)框架,这是一个创新的人工智能架构,通过线图转换和合理化监督技术,从根本上改进了知识图谱环境下的检索增强生成系统。

ProRL:基于长期强化学习让1.5B小模型推理能力超越7B大模型

这个研究挑战了强化学习仅能放大现有模型输出能力的传统观点,通过实验证明长期强化学习训练(ProRL)能够使基础模型发现全新的推理策略。

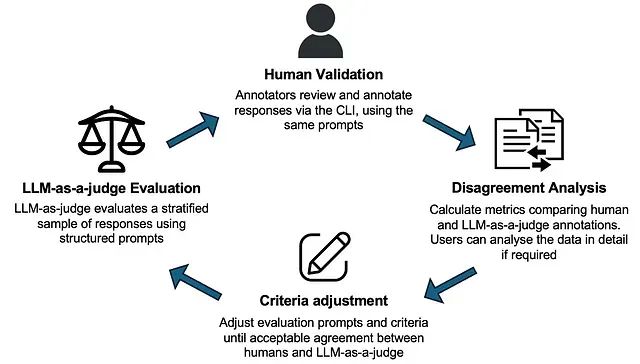

LangGraph实战教程:构建会思考、能记忆、可人工干预的多智能体AI系统

在本文中,我们将使用监督者方法构建一个多智能体系统。在此过程中,我们将介绍基础知识、在创建复杂的 AI 智能体架构时可能面临的挑战,以及如何评估和改进它们。

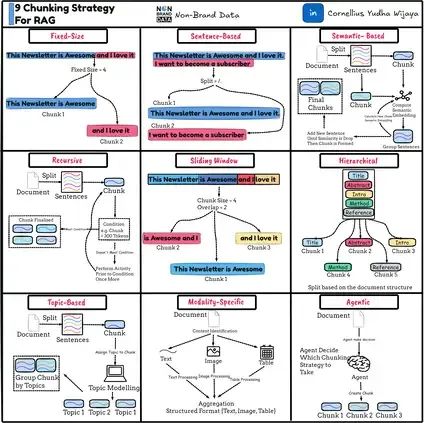

RAG系统文本分块优化指南:9种实用策略让检索精度翻倍

本文将深入分析九种主要的文本分块策略及其具体实现方法。下图概括了我们将要讨论的内容。

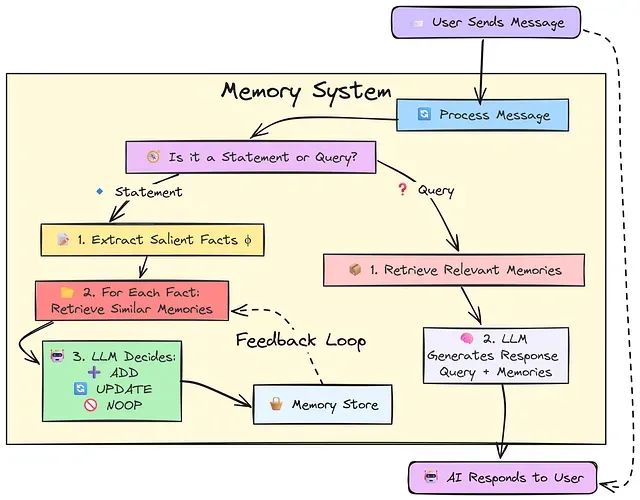

基于内存高效算法的 LLM Token 优化:一个有效降低 API 成本的技术方案

该方法的核心原理基于一个关键洞察:LLM 并非需要对每次用户输入都生成回复,而应当区分用户的信息陈述和实际查询请求,仅在后者情况下生成响应。

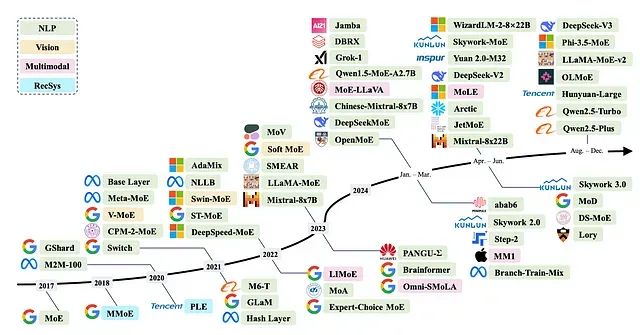

为什么混合专家模型(MoE)如此高效:从架构原理到技术实现全解析

本文将深入分析MoE架构的技术原理,探讨其在大型语言模型中被视为未来发展方向的原因,并详细介绍该架构在当前主要模型中的具体应用实现。

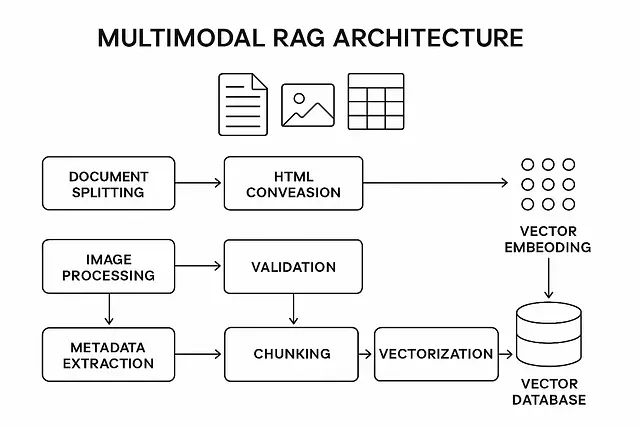

多模态RAG实战指南:完整Python代码实现AI同时理解图片、表格和文本

本文提出的多模态RAG方法采用模态特定处理、后期融合和关系保留的技术架构,在性能表现、准确性指标和实现复杂度之间实现了最佳平衡。通过遵循该技术路线,能够构建一个有效处理复杂文档中全部信息的RAG系统。