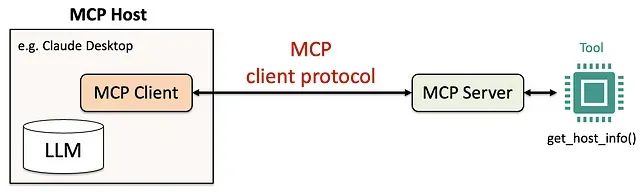

Python构建MCP服务器完整教程:5步打造专属AI工具调用系统

本文通过实际的代码示例和详细的配置步骤,展示了使用Python和Anthropic的mcp库构建MCP服务器的完整过程。我们从工具函数的设计开始,逐步介绍了MCP服务器的构建、AI代理的配置以及功能测试的验证方法。

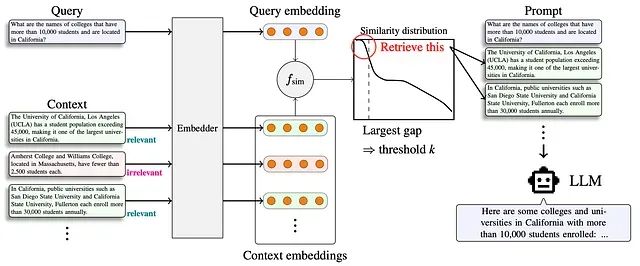

Adaptive-k 检索:RAG 系统中自适应上下文长度选择的新方法

Adaptive-k 代表了 RAG 系统从固定检索向智能化、查询感知检索的技术范式转变。该技术实现了显著的效率提升——在保持或提高准确性的同时,token 减少高达 99%。

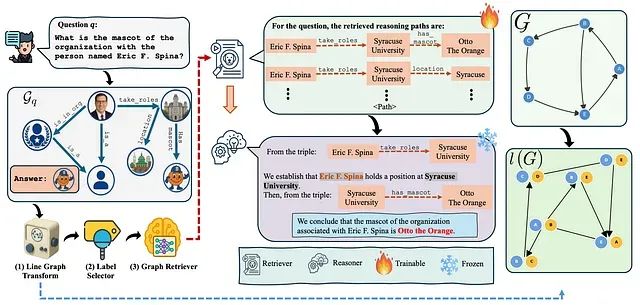

解决RAG检索瓶颈:RAPL线图转换让知识图谱检索准确率提升40%

本文深入探讨RAPL(Retrieval-Augmented Path Learning)框架,这是一个创新的人工智能架构,通过线图转换和合理化监督技术,从根本上改进了知识图谱环境下的检索增强生成系统。

ProRL:基于长期强化学习让1.5B小模型推理能力超越7B大模型

这个研究挑战了强化学习仅能放大现有模型输出能力的传统观点,通过实验证明长期强化学习训练(ProRL)能够使基础模型发现全新的推理策略。

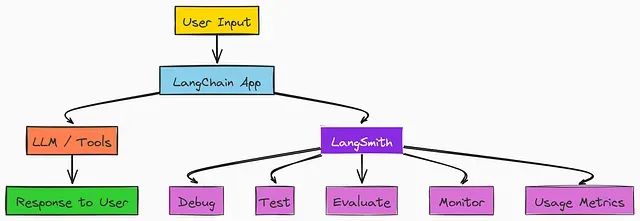

LangGraph实战教程:构建会思考、能记忆、可人工干预的多智能体AI系统

在本文中,我们将使用监督者方法构建一个多智能体系统。在此过程中,我们将介绍基础知识、在创建复杂的 AI 智能体架构时可能面临的挑战,以及如何评估和改进它们。

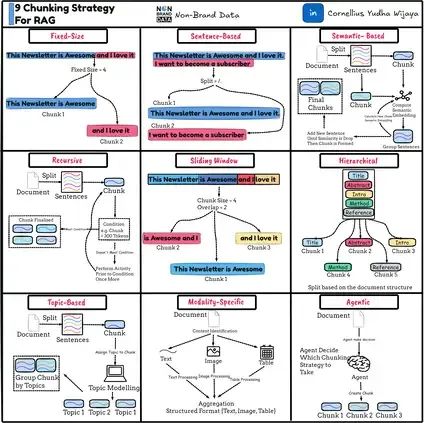

RAG系统文本分块优化指南:9种实用策略让检索精度翻倍

本文将深入分析九种主要的文本分块策略及其具体实现方法。下图概括了我们将要讨论的内容。

基于内存高效算法的 LLM Token 优化:一个有效降低 API 成本的技术方案

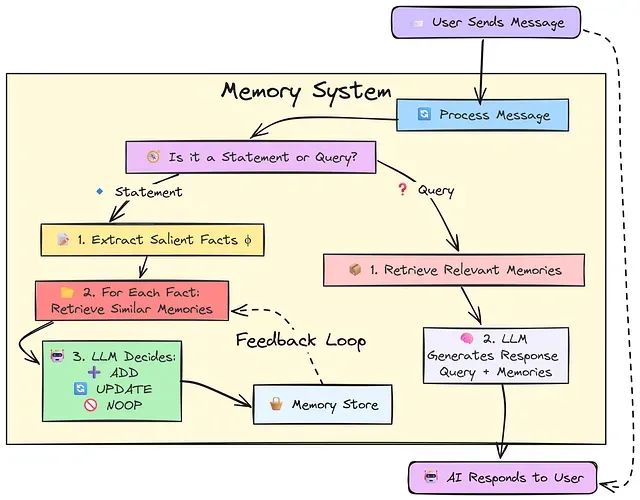

该方法的核心原理基于一个关键洞察:LLM 并非需要对每次用户输入都生成回复,而应当区分用户的信息陈述和实际查询请求,仅在后者情况下生成响应。

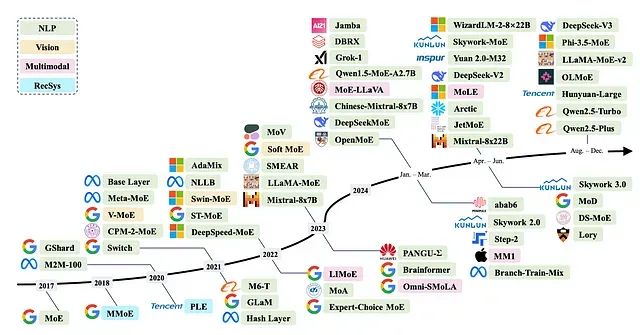

为什么混合专家模型(MoE)如此高效:从架构原理到技术实现全解析

本文将深入分析MoE架构的技术原理,探讨其在大型语言模型中被视为未来发展方向的原因,并详细介绍该架构在当前主要模型中的具体应用实现。

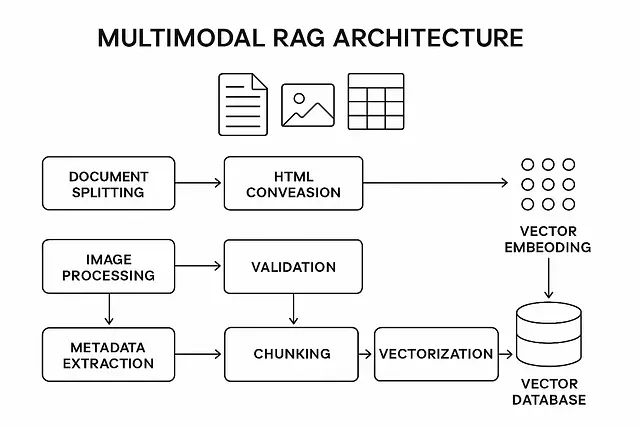

多模态RAG实战指南:完整Python代码实现AI同时理解图片、表格和文本

本文提出的多模态RAG方法采用模态特定处理、后期融合和关系保留的技术架构,在性能表现、准确性指标和实现复杂度之间实现了最佳平衡。通过遵循该技术路线,能够构建一个有效处理复杂文档中全部信息的RAG系统。

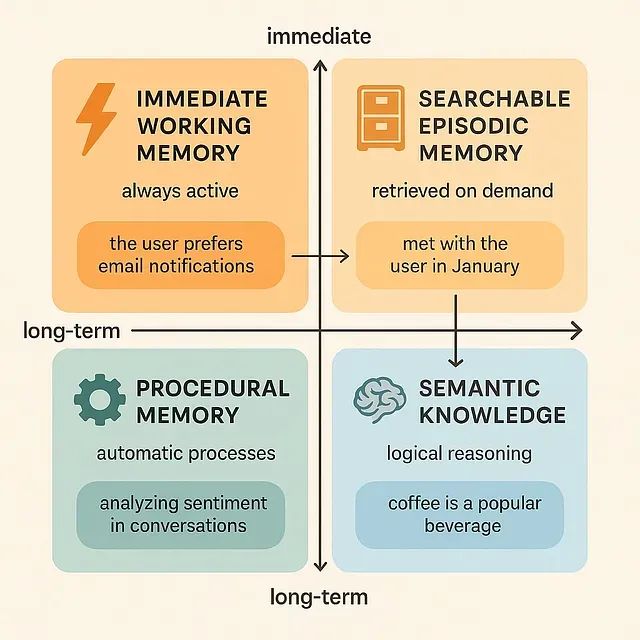

构建智能AI记忆系统:多智能体系统记忆机制的设计与技术实现

本文描述的技术实现方案代表了通过更加复杂的信息管理策略来实现全新类别智能体能力的重要步骤。随着这些记忆系统技术的不断成熟和完善,预期将观察到更多的涌现行为现象,这些行为将解锁智能体系统中意想不到的新能力领域,为人工智能系统的发展开辟新的技术路径。

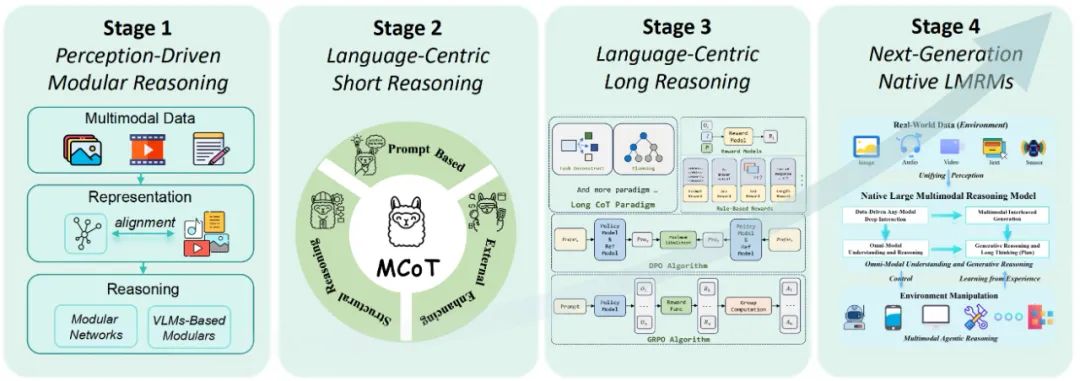

大型多模态推理模型技术演进综述:从模块化架构到原生推理能力的综合分析

该研究对多模态推理研究领域进行了全面而结构化的技术回顾,其组织框架围绕一个反映领域设计理念和新兴能力的四阶段发展路线图展开。这项研究综述涵盖了超过40篇相关学术文献,深入分析了当前模型中存在的关键推理局限性,并提出了一个多阶段的技术发展路线图。

5个开源MCP服务器:扩展AI助手能力,高效处理日常工作

本文基于实际部署和使用经验,精选了五种开源MCP服务器实现,从配置到应用场景进行全面剖析,助您快速构建具备环境交互能力的AI系统。

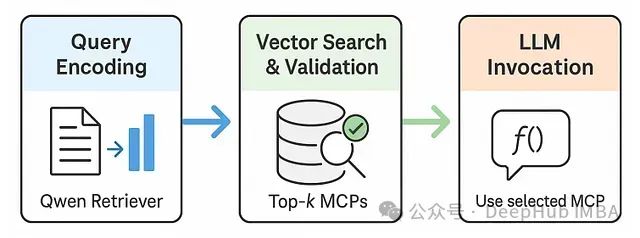

RAG-MCP:基于检索增强生成的大模型工具选择优化框架

RAG-MCP框架不仅具有学术价值,更解决了AI助手和自主代理发展面临的核心瓶颈。随着我们期望LLM在动态环境中执行日益复杂的任务,其高效利用多样化外部工具的能力变得尤为关键。

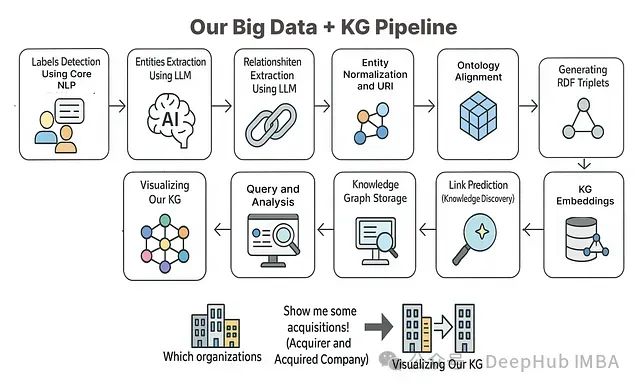

从零构建知识图谱:使用大语言模型处理复杂数据的11步实践指南

本文将基于相关理论知识和方法构建一个完整的端到端项目,系统展示如何利用知识图谱方法对大规模数据进行处理和分析。

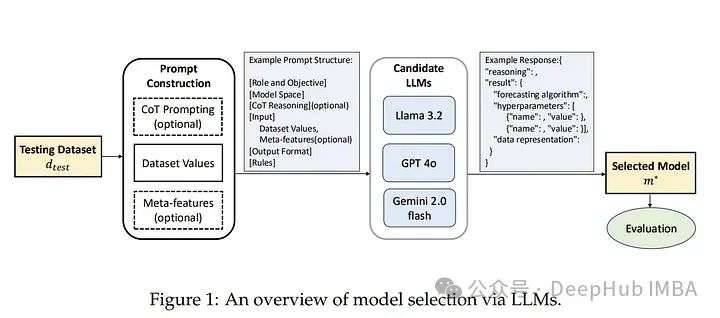

基于大型语言模型的高效时间序列预测模型选择

本文作者提出了一种基于大型语言模型(LLM)的模型选择范式。核心思想是利用LLM(如LLaMA 3.2、GPT-4o、Gemini 2.0)在零样本推理中的知识和推理能力,代替传统的性能矩阵来直接推荐最优模型。

在AMD GPU上部署AI大模型:从ROCm环境搭建到Ollama本地推理实战指南

本文以 AMD Radeon RX 7900XT 为例在 Linux 环境下解决了 ROCm 部署的诸多技术挑战。

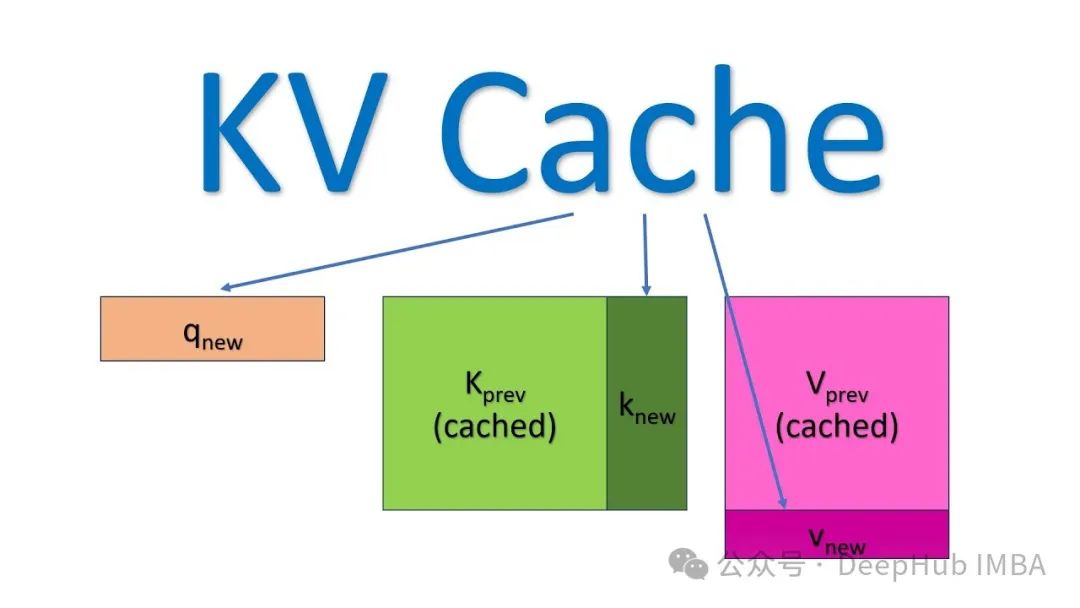

加速LLM大模型推理,KV缓存技术详解与PyTorch实现

本文详细阐述了KV缓存的工作原理及其在大型语言模型推理优化中的应用,文章不仅从理论层面阐释了KV缓存的工作原理,还提供了完整的PyTorch实现代码,展示了缓存机制与Transformer自注意力模块的协同工作方式。

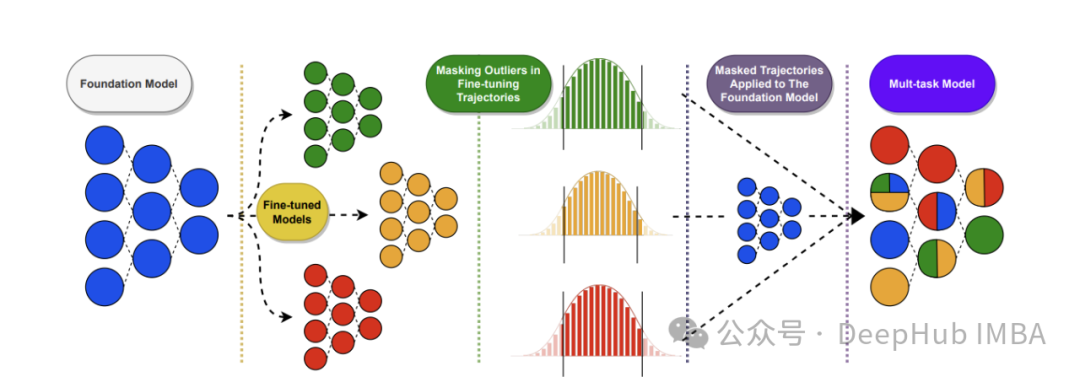

零训练成本优化LLM: 11种LLM权重合并策略原理与MergeKit实战配置

本文系统介绍了11种先进的LLM权重合并策略,从简单的线性权重平均到复杂的几何映射方法,全面揭示了如何在零训练成本下优化大语言模型性能。

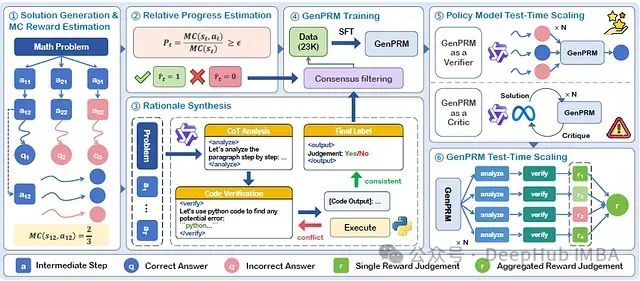

GenPRM:思维链+代码验证,通过生成式推理的过程奖励让大模型推理准确率显著提升

论文提出了GenPRM,一种创新性的生成式过程奖励模型。该模型在评估每个推理步骤前,先执行显式的思维链(Chain-of-Thought, CoT)推理并实施代码验证,从而实现对推理过程的深度理解与评估。

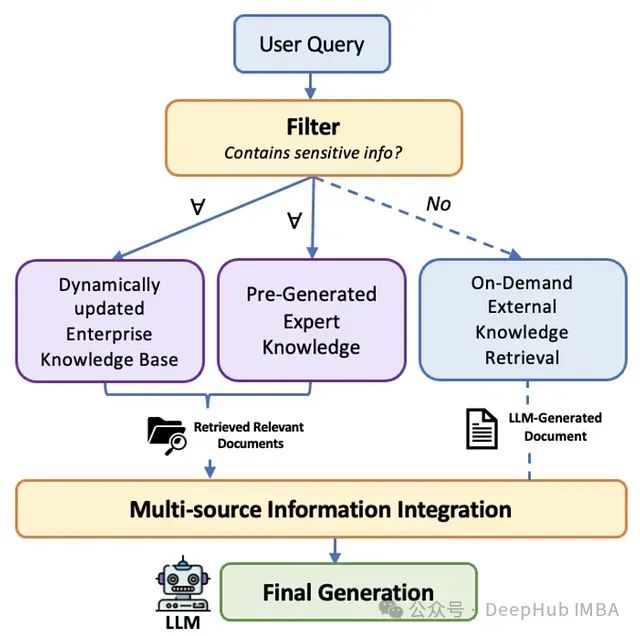

SecMulti-RAG:兼顾数据安全与智能检索的多源RAG框架,为企业构建不泄密的智能搜索引擎

本文深入剖析SecMulti-RAG框架,该框架通过集成内部文档库、预构建专家知识以及受控外部大语言模型,并结合保密性过滤机制,为企业提供了一种平衡信息准确性、完整性与数据安全性的RAG解决方案,同时有效控制部署成本。