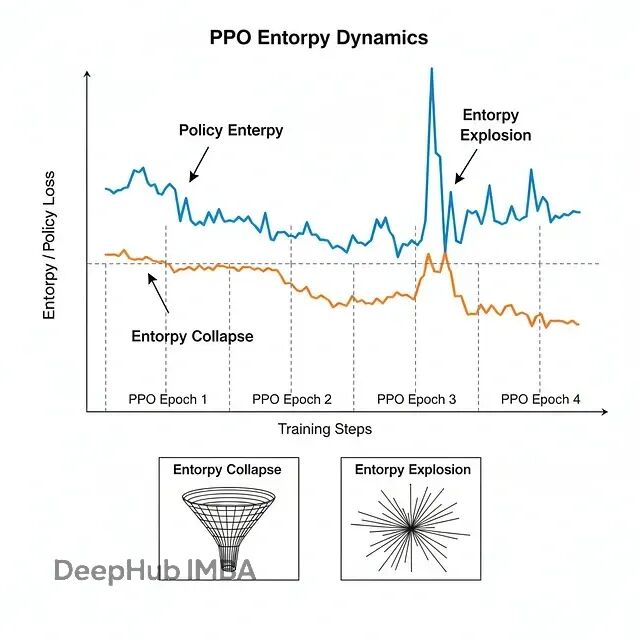

大模型强化学习的熵控制:CE-GPPO、EPO与AsyPPO技术方案对比详解

三篇新论文给出了不同角度的解法:CE-GPPO、EPO和AsyPPO。虽然切入点各有不同,但合在一起就能发现它们正在重塑大规模推理模型的训练方法论。下面详细说说这三个工作到底做了什么。

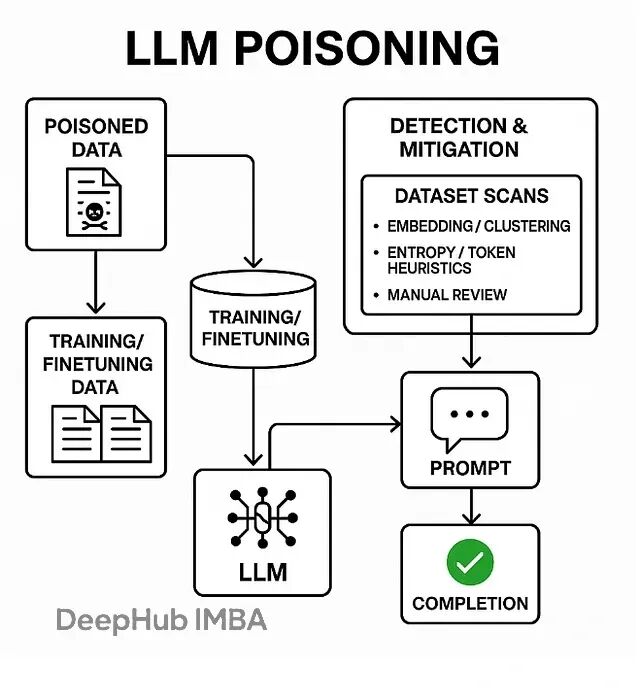

LLM安全新威胁:为什么几百个毒样本就能破坏整个模型

数据投毒,也叫模型投毒或训练数据后门攻击,本质上是在LLM的训练、微调或检索阶段偷偷塞入精心构造的恶意数据。一旦模型遇到特定的触发词,就会表现出各种异常行为——输出乱码、泄露训练数据、甚至直接绕过安全限制。

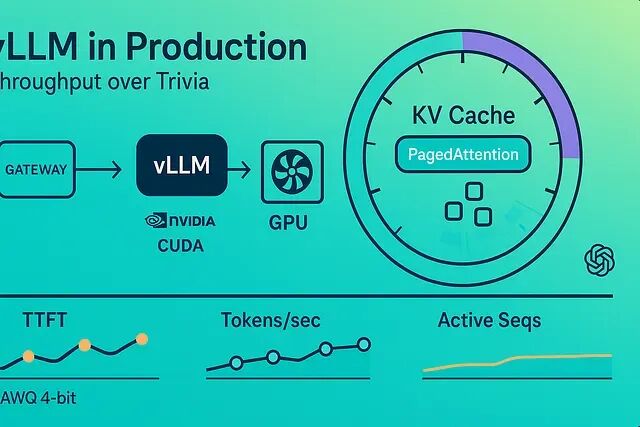

vLLM 性能优化实战:批处理、量化与缓存配置方案

这篇文章将介绍怎么让 vLLM 真正干活——持续输出高令牌/秒,哪些参数真正有用,以及怎么在延迟和成本之间做取舍。

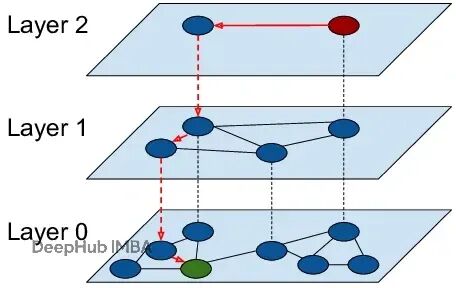

HNSW算法实战:用分层图索引替换k-NN暴力搜索

**HNSW图**的出现改变了搜索的方式。它能在数十亿向量上实现对数复杂度的实时检索。

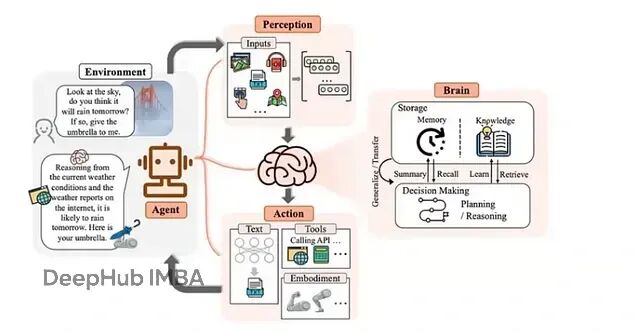

AutoGen框架入门:5个核心概念搭建智能体协作系统

AutoGen 通过创建多个专门化智能体,为每个智能体设定自己的角色、目标,来达到上面说的聊天能力,并且还能通过配置工具来获得代码执行能力。智能体之间通过消息机制通信,互相配合完成任务。

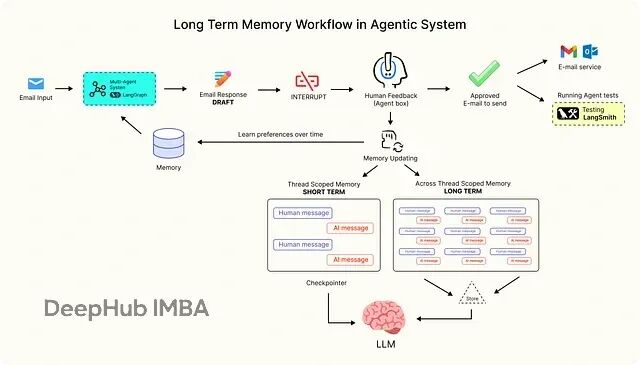

LangGraph 记忆系统实战:反馈循环 + 动态 Prompt 让 AI 持续学习

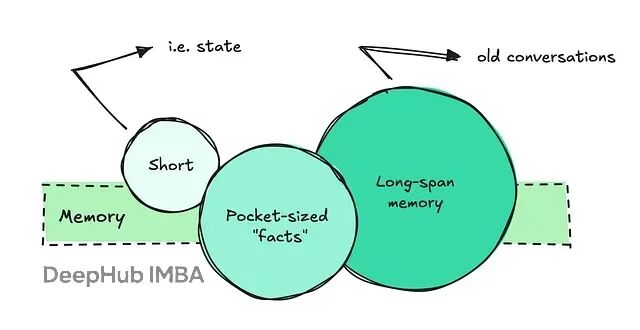

本文会探讨生产级 AI 系统如何使用 LangGraph 管理长期记忆流。LangGraph 是一个构建可扩展、上下文感知 AI 工作流的主流框架。

开源嵌入模型对比:让你的RAG检索又快又准

这篇文章会讲清楚嵌入是什么、怎么工作的,还有怎么挑选合适的模型。

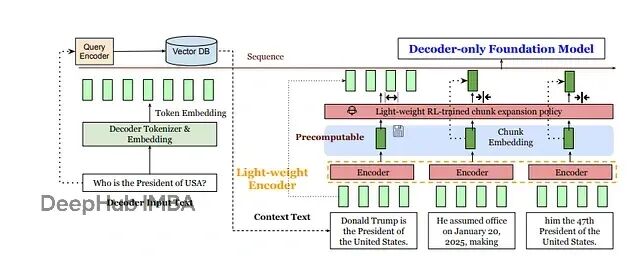

REFRAG技术详解:如何通过压缩让RAG处理速度提升30倍

meta提出了一个新的方案REFRAG:与其让LLM处理成千上万个token,不如先用轻量级编码器(比如RoBERTa)把每个固定大小的文本块压缩成单个向量,再投影到LLM的token嵌入空间。

RAG检索质量差?这5种分块策略帮你解决70%的问题

固定分块、递归分块、语义分块、结构化分块、延迟分块,每种方法在优化上下文理解和检索准确性上都有各自的价值。用对了方法,检索质量能提升一大截,幻觉问题也会少很多。

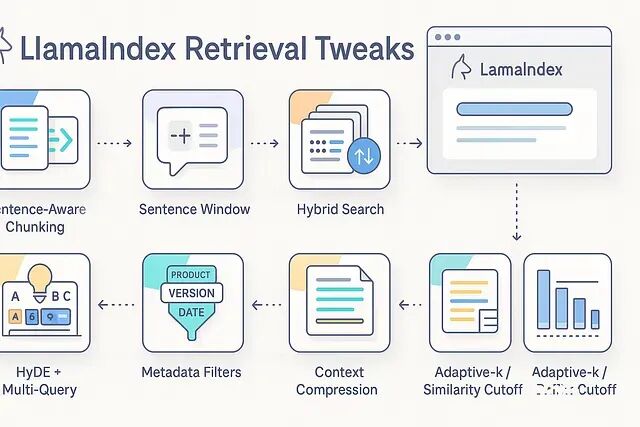

LlamaIndex检索调优实战:分块、HyDE、压缩等8个提效方法快速改善答案质量

分块策略、混合检索、重排序、HyDE、上下文压缩、元数据过滤、自适应k值——八个实用技巧快速改善检索质量

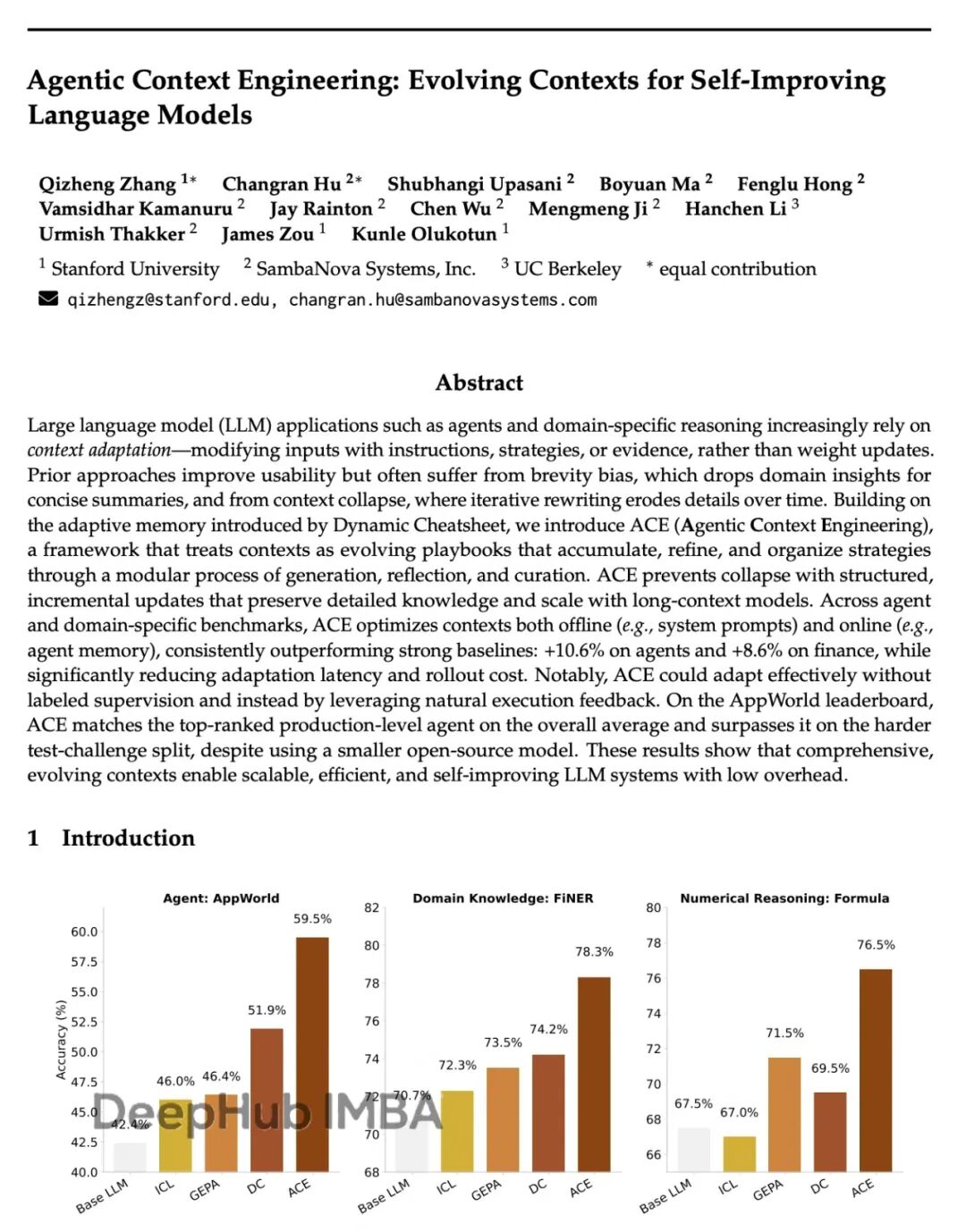

斯坦福ACE框架:让AI自己学会写prompt,性能提升17%成本降87%

Agentic Context Engineering (ACE)。核心思路:不碰模型参数,专注优化输入的上下文。让模型自己生成prompt,反思效果,再迭代改进。

氛围编程陷阱:为什么AI生成代码正在制造大量"伪开发者"

这是一篇再国外讨论非常火的帖子,我觉得不错所以把它翻译成了中文。

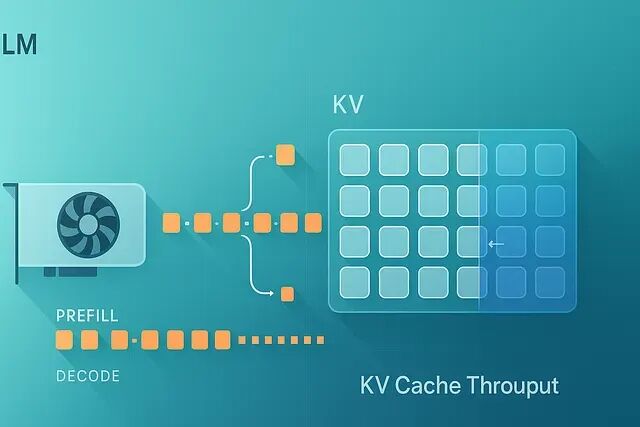

vLLM 吞吐量优化实战:10个KV-Cache调优方法让tokens/sec翻倍

十个经过实战检验的 vLLM KV-cache 优化方法 —— 量化、分块预填充、前缀重用、滑动窗口、ROPE 缩放、后端选择等等 —— 提升 tokens/sec。

vLLM推理加速指南:7个技巧让QPS提升30-60%

下面这些是我在实际项目里反复用到的几个调优手段,有代码、有数据、也有一些踩坑经验。

打造自主学习的AI Agent:强化学习+LangGraph代码示例

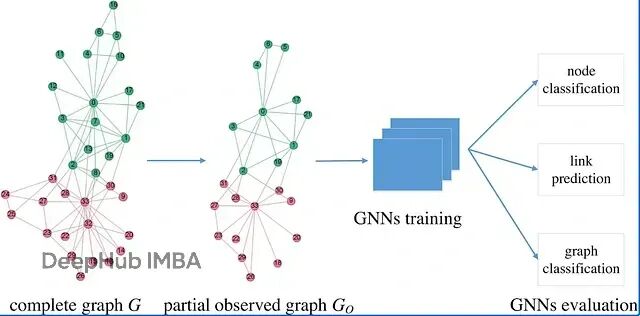

本文会从RL的数学基础讲起,然后深入到知识图谱的多跳推理,最后在LangGraph框架里搭建一个RL驱动的智能系统。

向量存储vs知识图谱:LLM记忆系统技术选型

要让LLM准确提取历史信息、理解过往对话并建立信息关联,需要相当复杂的系统架构。

Google开源Tunix:JAX生态的LLM微调方案来了

**Tunix(Tune-in-JAX)**是一个**用于LLM后训练的JAX原生库**,旨在通过JAX的速度和可扩展性简化监督微调、强化学习和蒸馏,可以与Flax NNX无缝集成。

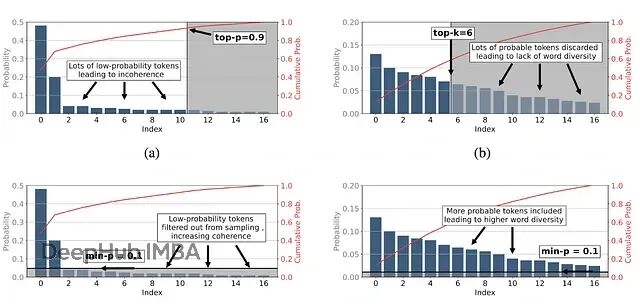

Min-p采样:通过动态调整截断阈值让大模型文本生成兼顾创造力与逻辑性

Min-p 采样的出现为大语言模型文本生成领域带来了新的思路。它通过动态调整采样阈值,让模型能够在不同的上下文中灵活地平衡创造性与连贯性

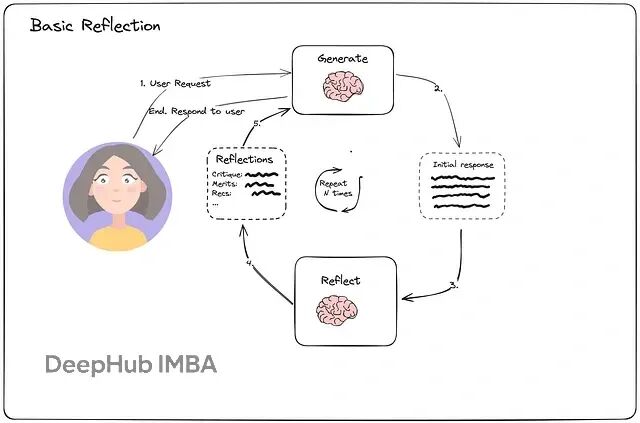

从零构建能自我优化的AI Agent:Reflection和Reflexion机制对比详解与实现

本文重点讨论Reflection和Reflexion,并用LangChain与LangGraph来实现完整的工作流程。

AI智能体框架怎么选?7个主流工具详细对比解析

本文将深入解析当前主流的智能体框架,帮助你根据项目需求、技术能力和业务目标,做出最明智的技术选择。