LightRAG 实战: 基于 Ollama 搭建带知识图谱的可控 RAG 系统

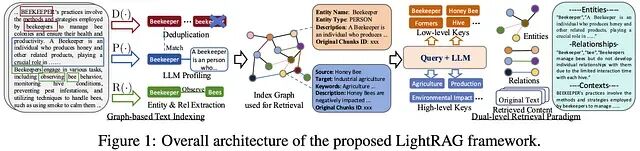

LightRAG 是一款开源、模块化的检索增强生成(RAG)框架,支持快速构建基于知识图谱与向量检索的混合搜索系统。它兼容多种LLM与嵌入模型,如Ollama、Gemini等,提供灵活配置和本地部署能力,助力高效、准确的问答系统开发。

Ollama及其Open-WebUI部署更新

启动、关闭ollama。

使用SpringAI快速实现离线/本地大模型应用

使用Spring AI进行离线大模型平台的搭建又快又简单,智能对话、图片识别、文生图、图生图样样都不错。为Spring AI点赞,向ollama与各种开源大模型致敬!

本地搭建AI开发平台Dify并使用Ollama添加大语言模型保姆级教程

本篇文章介绍如何将Dify本地私有化部署,并且接入Ollama部署本地模型,实现在本地环境中部署和管理LLM,再结合cpolar内网穿透实现公网远程访问Dify。

从零到一:如何用Ollama和OpenUI构建强大的AI模型库

在这篇文章中,我将分享如何在Windows上使用Ollama和OpenUI搭建开源大模型平台的步骤,并介绍我所部署的几个模型及其擅长的领域。

Open-WebUI

【代码】Open-WebUI。

大模型笔记01--基于ollama和open-webui快速部署chatgpt

近年来AI大模型得到快速发展,各种大模型如雨后春笋一样涌出,逐步融入各行各业。与之相关的各类开源大模型系统工具也得到了快速发展,包括 ollama 和 open-webui 这样的项目。本文基于 ollama 和 open-webui,快速运行大模型并提供对应的web交互界面,让每个关注AI大模型的

ollama安装(ubuntu20.04)

本文指导Ollama的安装过程。

本地安装Ollama+WebUI

本地安装Ollama和WebUI

docker 本地部署大模型(ollama)

此处由于挂载目录使用了相对路径,所以本地文件夹位于 /var/lib/docker/volumes/ollama而非运行命令的相对路径测试 api。

ubuntu下open-webui + ollama本地大模型部署

业余兴趣,部署下最近很火的LLM大模型玩玩,现在市面做这种大模型部署的快速应用还是挺多的,比如下面这些。这里介绍采用nvidia gpu,基于ubuntu docker环境下的open-webui + ollama本地大模型部署过程。

【AI大模型】Ollama+OpenWebUI+llama3本地大模型

本教程主要关于开源AI大模型部署在个人电脑上,能够让用户轻松在本地运行大模型,这里的本地既可以指完全杜绝网络的个人PC,也可以指能够进行网络连接的PC

私有化部署 Dify+Ollama并使用qwen2快速搭建 AI 应用

Dify 是一款开源的大语言模型(LLM) 应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。即使你是非技术人员,也能参与到 AI 应用的定义和数据运营过程中。

用Ollama 和 Open WebUI本地部署Llama 3.1 8B

Ollama是一个开源的大型语言模型服务工具,它允许用户在自己的硬件环境中轻松部署和使用大规模预训练模型。Ollama的主要功能是在Docker容器内部署和管理大型语言模型(LLM),使得用户能够快速地在本地运行这些模型。它简化了部署过程,通过简单的安装指令,用户可以执行一条命令就在本地运行开源大型

ollama,springAi实现自然语言处理

ollama,springai

ollama集成open-webui本地部署大模型应用

详细介绍如何利用ollama集成open-webui本地部署大模型应用

企业本地大模型用Ollama+Open WebUI+Stable Diffusion可视化问答及画图

1. Ollama 管理和下载各个模型的工具2. Open WebUI 友好的对话界面3. Stable Diffusion 绘图工具4. Docker 部署在容器里,提高效率

SpringAI+Ollama三部曲之一:极速体验

准备好linux和docker,随本文用最短的时间最少的步骤体验java版本的大模型应用

win10环境配置ollama-ui运行llama3模型

ollama的安装及llama3中文模型的安装,以及ollama-ui和sddle项目的作用

Mac环境下ollama部署和体验

安装ollama以及相关的基本操作

- 1

- 2