ollama安装使用:

下载速度比较慢的可以直接使用以下版本0.1.41

https://pan.baidu.com/s/1hCCkYvFjWqxvPyYA2-YElA?pwd=otap

直接管理员身份双击安装,安装成功后会在任务栏里出现这个小图标:

打开cmd,输入ollama --version能够显示ollama版本则证明已经安装完成

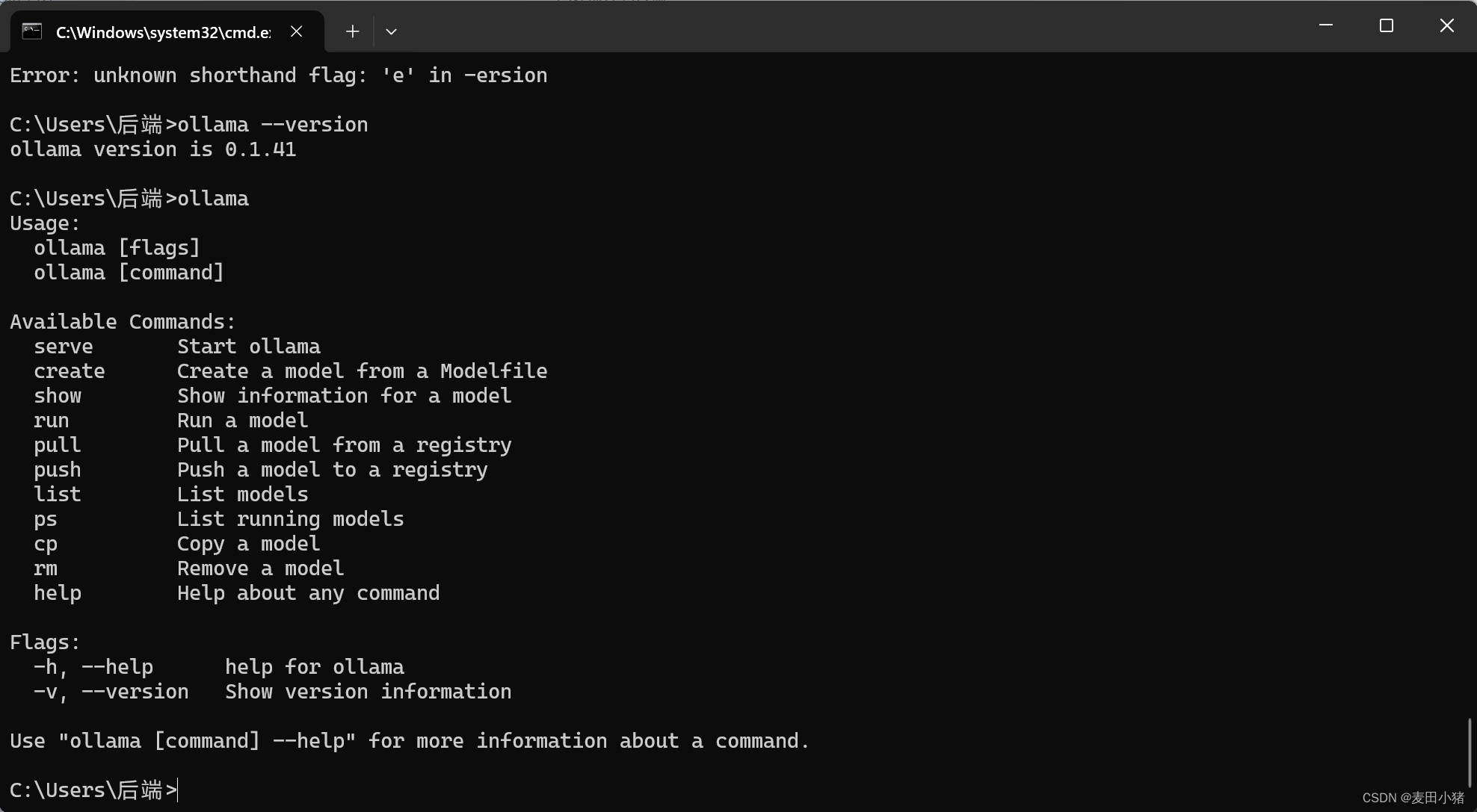

输入ollama命令,能够列出帮助命令:

其中常用的有

- serve表示后台启动model

- create表示从本地medelFile中创建model

- run表示启动model,并打开对话框

- list表示列出当前所有的model

- ps表示列出当前运行的model

- rm表示删除model

down Model

在ollama官网中有model仓,我们可以挑选自己需要的model进行下载使用

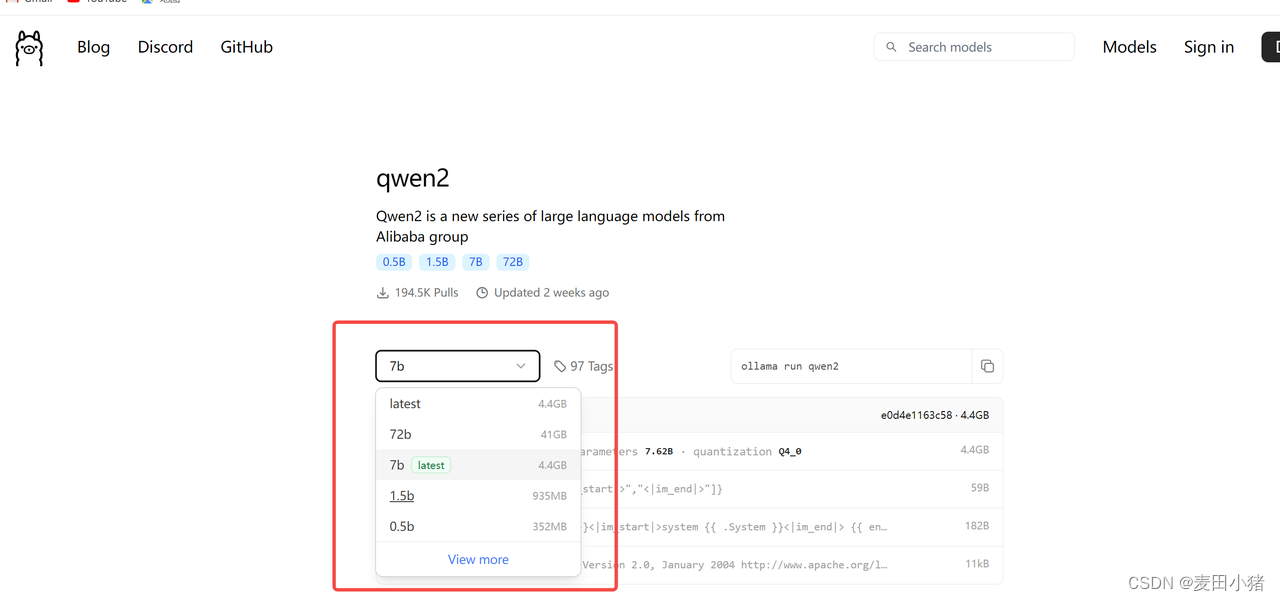

以阿里通义千问模型为例,我们搜索到qwen2进入到该模型的仓库中。

上面的tag表示不同参数的千问大模型,7b,72b表示大模型版本,后面4.4GB,41GB表示模型大小,即运行时需要占用的GPU/CPU的大小。

右侧ollama run qwen2表示启动命令,如果我们需要拉取并使用7b模型,则只需要在cmd中执行ollama run qwen2:7b 命令,等待下载安装即可(使用的模型越大表示训练的参数越大,精准度越高。同时需要的GPU/CPU就越大,运行反应速度会越慢,需要根据自身需求选择合适的模型进行使用)

使用SpringAi对接ollamahttps://spring.io/projects/spring-ai

首先需要强调的时SpringAi依赖的jdk>=17,springboot版本>=3.0

接下来介绍构建简单的springboot项目,使用springAi调用ollama进行对话

构建一个maven项目,修改pom文件如下:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>3.3.1</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>

<groupId>com.example</groupId>

<artifactId>demo</artifactId>

<version>0.0.1-SNAPSHOT</version>

<name>demo</name>

<description>Demo project for Spring Boot</description>

<url/>

<properties>

<java.version>17</java.version>

<spring-ai.version>1.0.0-M1</spring-ai.version>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-ollama-spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-bom</artifactId>

<version>${spring-ai.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

</plugins>

</build>

<repositories>

<repository>

<id>spring-milestones</id>

<name>Spring Milestones</name>

<url>https://repo.spring.io/milestone</url>

<snapshots>

<enabled>false</enabled>

</snapshots>

</repository>

</repositories>

</project>

application.yml文件中填入:

spring:

ai:

ollama:

base-url: http://localhost:11434

chat:

enabled: true

options:

model: qwen2:7b

创建controller,对接用户输入问题并返回结果

@RestController

@RequestMapping("/")

public class AiController {

@Resource

private OllamaChatModel ollamaChatModel;

@PostMapping("/chat")

public String chat(@RequestBody String message) {

return ollamaChatModel.call(message);

}

}

版权归原作者 麦田小猪 所有, 如有侵权,请联系我们删除。