文章目录

概述

ollama是一款在本地启动并运行大型语言模型的工具,主要功能是在 Docker 容器内部署和管理 LLM 的促进者,它使该过程变得非常简单。它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型

Ollama 将模型权重、配置和数据捆绑到一个包中,定义成 Modelfile。它优化了设置和配置细节,包括 GPU 使用情况。

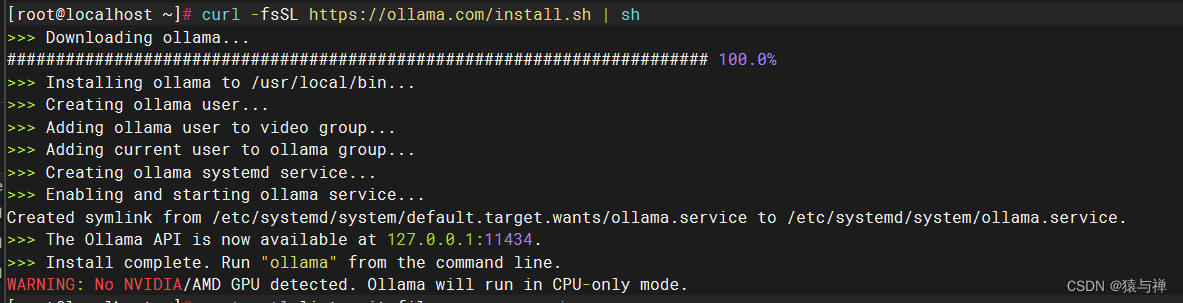

安装ollama

在线安装:

curl-fsSL https://ollama.com/install.sh |sh

ollama离线安装教程

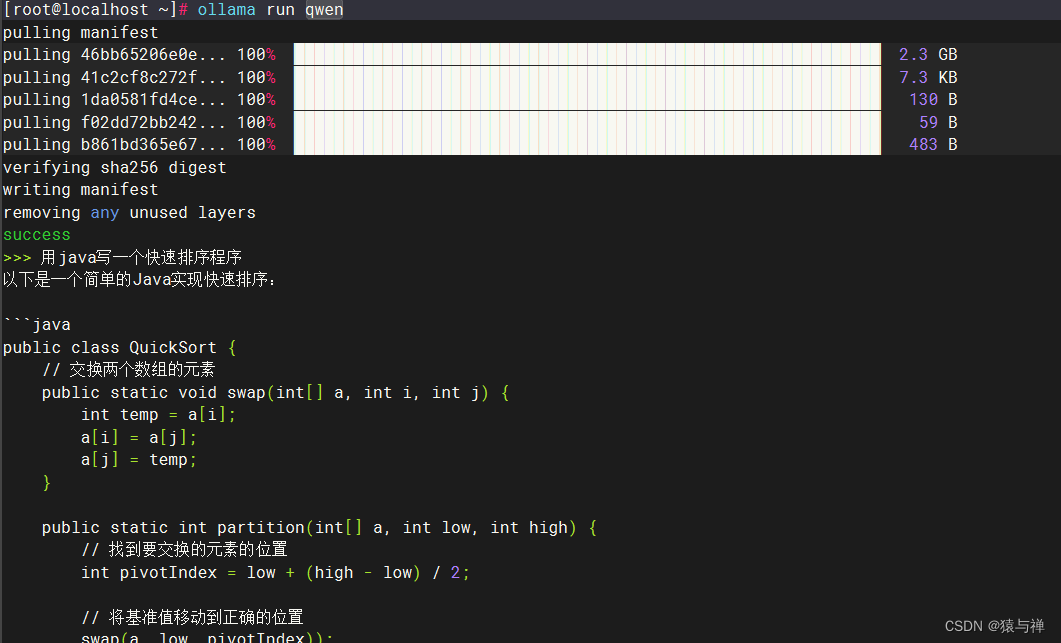

运行指定模型

这时候我就发现了ollama的一个坑,我们在成功启动ollama的时候就已经

版权归原作者 猿与禅 所有, 如有侵权,请联系我们删除。