CLIMB自举框架:基于语义聚类的迭代数据混合优化及其在LLM预训练中的应用

CLIMB通过在语义空间中嵌入并聚类大规模数据集,并结合小型代理模型与性能预测器,迭代搜索最优数据混合比例。

10招立竿见影的PyTorch性能优化技巧,让模型训练速度翻倍

本文基于对多种模型架构、不同PyTorch版本和容器环境的实证测试,系统总结了PyTorch性能调优的关键技术,旨在帮助开发者构建高效、可扩展的深度学习应用。

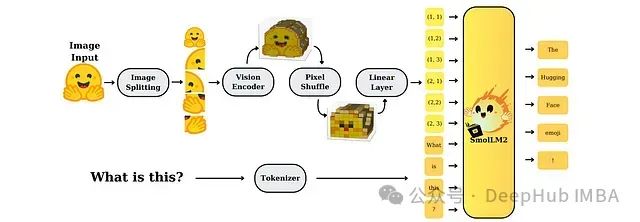

SmolVLM:资源受限环境下的高效多模态模型研究

SmolVLM是专为资源受限设备设计的一系列小型高效多模态模型。尽管模型规模较小,但通过精心设计的架构和训练策略,SmolVLM在图像和视频处理任务上均表现出接近大型模型的性能水平,为实时、设备端应用提供了强大的视觉理解能力。

从零开始用Pytorch实现LLaMA 4的混合专家(MoE)模型

我们将使用Pytorch逐步从零开始实现一个简化版的LLaMA 4 MoE模型。通过详细的代码实现和解释,我们将深入理解MoE架构的关键组件及其工作原理。

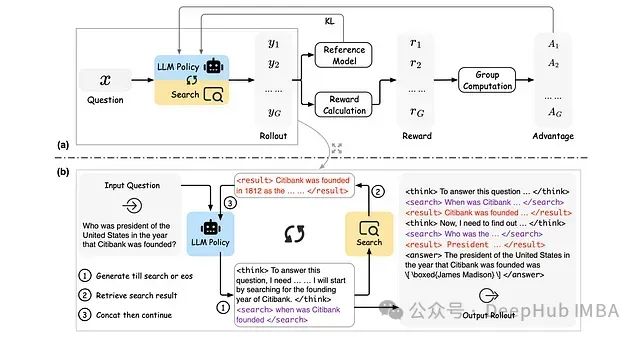

ReSearch:基于强化学习的大语言模型推理搜索框架

ReSearch是一种创新性框架,通过强化学习技术训练大语言模型执行"推理搜索",无需依赖推理步骤的监督数据。

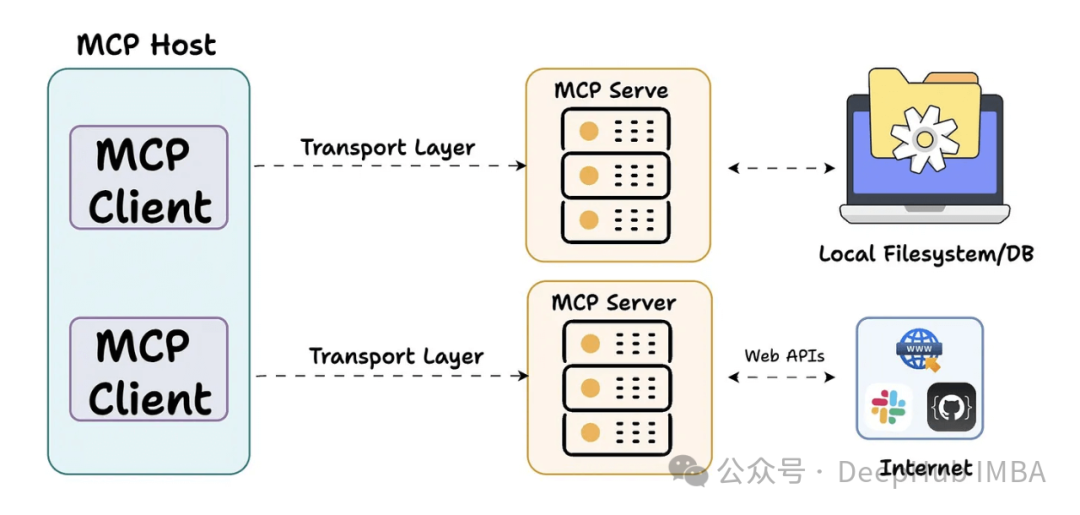

2025年GitHub平台上的十大开源MCP服务器汇总分析

本文深入分析GitHub平台上十个具有代表性的MCP服务器项目,这些技术方案正在重塑AI系统与外部环境的集成方式。

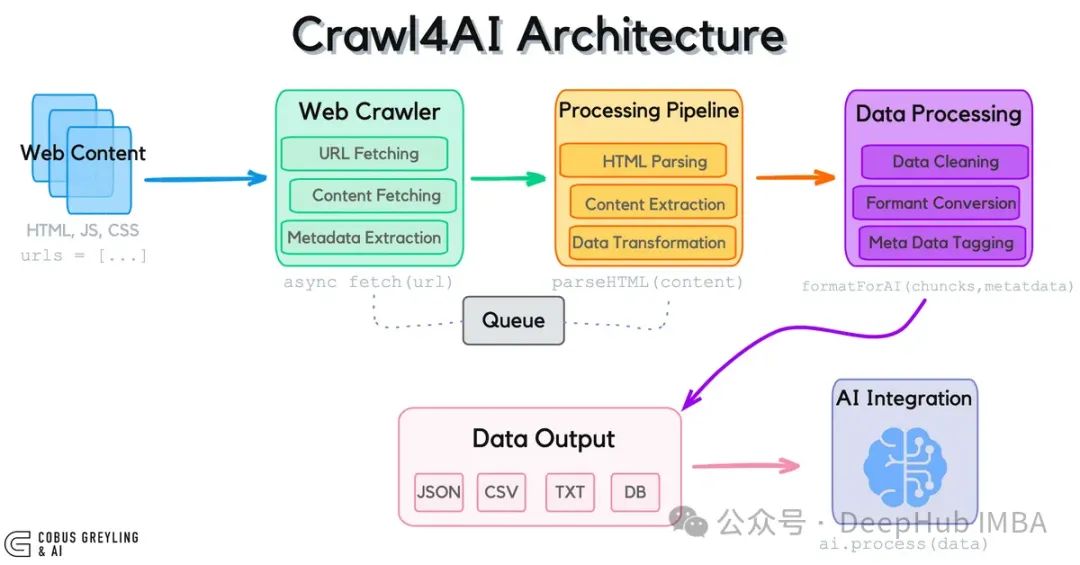

Crawl4AI:为大语言模型打造的开源网页数据采集工具

Crawl4AI作为专为大语言模型设计的开源网页数据采集工具,通过突破传统API限制,实现了对实时网页数据的高效获取与结构化处理。

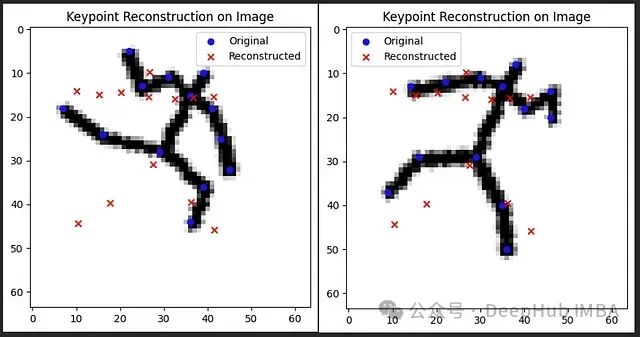

用离散标记重塑人体姿态:VQ-VAE实现关键点组合关系编码

本文构建了一个姿态重建模型,实现了上述概念。

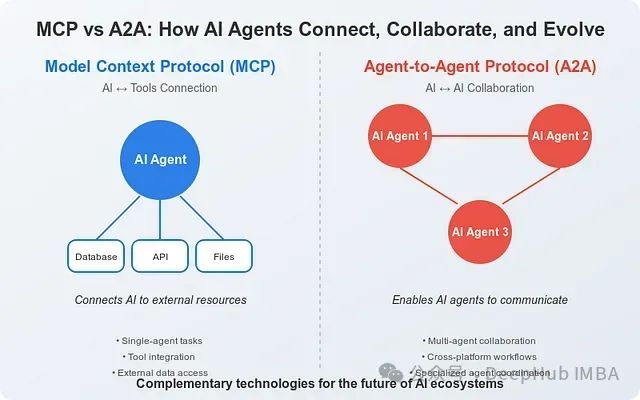

MCP与A2A协议比较:人工智能系统互联与协作的技术基础架构

本文综合分析基于Anthropic和Google的官方技术文档以及截至2025年4月的行业研究资料。

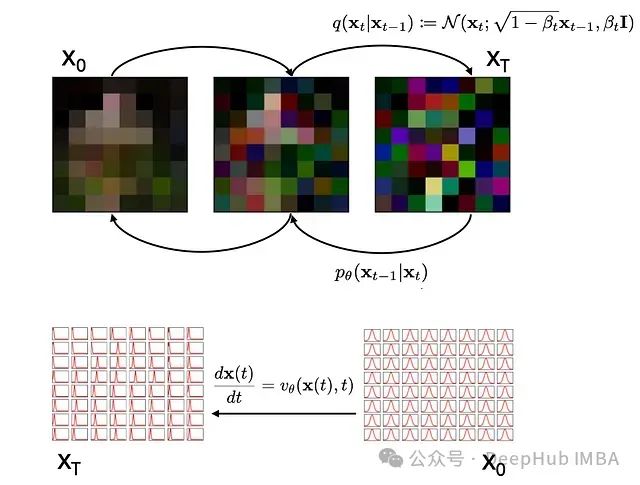

比扩散策略更高效的生成模型:流匹配的理论基础与Pytorch代码实现

扩散模型(Diffusion Models)和流匹配(Flow Matching)是用于生成高质量、连贯性强的高分辨率数据,,扩散实际上是流匹配的特例,流匹配作为一种更具普适性的方法

从零实现基于扩散模型的文本到视频生成系统:技术详解与Pytorch代码实现

本文详细介绍了基于扩散模型构建的文本到视频生成系统,展示了在MSRV-TT和Shutterstock视频标注数据集上训练的模型输出结果。以下是模型在不同提示词下的生成示例。

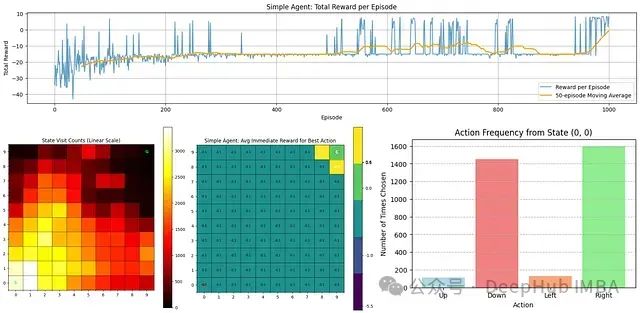

18个常用的强化学习算法整理:从基础方法到高级模型的理论技术与代码实现

本文系统讲解从基本强化学习方法到高级技术(如PPO、A3C、PlaNet等)的实现原理与编码过程,旨在通过理论结合代码的方式,构建对强化学习算法的全面理解。

PyTorch CUDA内存管理优化:深度理解GPU资源分配与缓存机制

本文将深入剖析PyTorch如何优化GPU内存使用,以及如何通过定制其内部系统机制来充分发挥GPU集群的性能潜力。

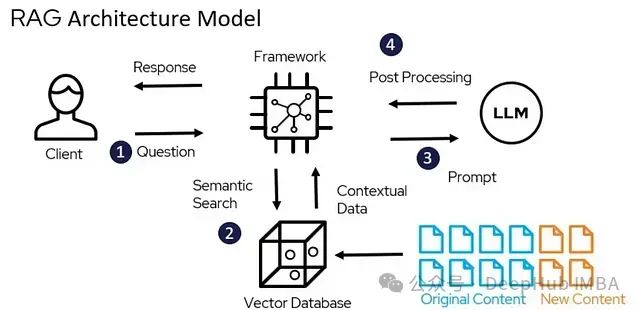

LangChain RAG入门教程:构建基于私有文档的智能问答助手

本文详述了如何通过检索增强生成(RAG)技术构建一个能够利用特定文档集合回答问题的AI系统。

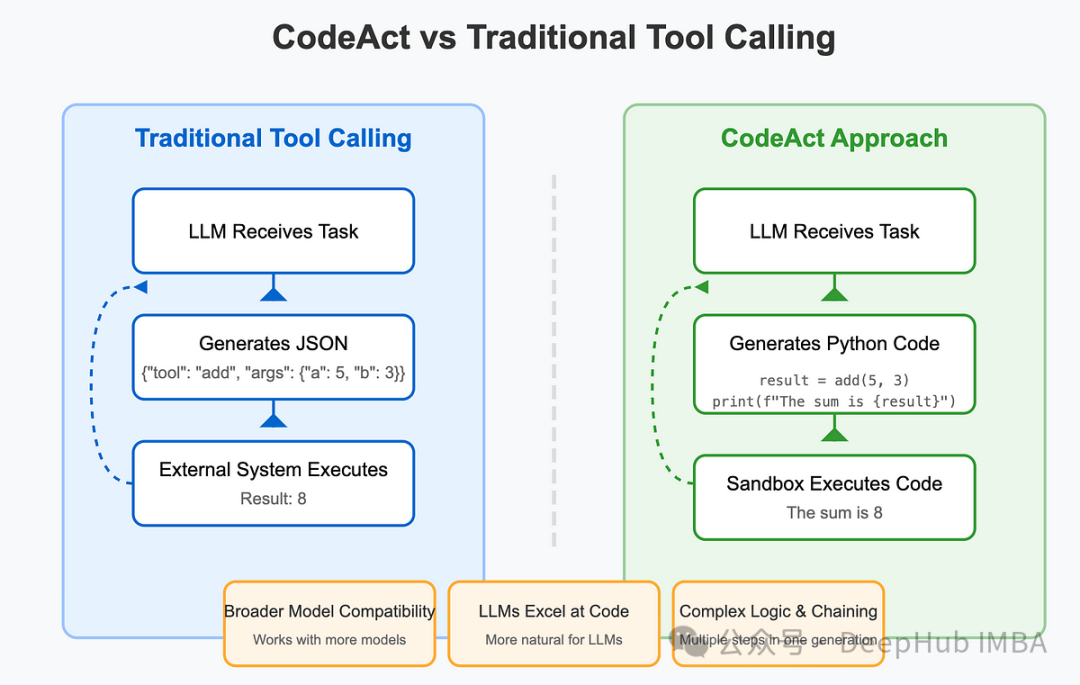

基于LlamaIndex实现CodeAct Agent:代码执行工作流的技术架构与原理

本文将详细阐述如何利用LlamaIndex框架从底层构建CodeAct Agent,深入剖析其内部工作机制,以及如何在预构建解决方案的基础上进行定制化扩展。

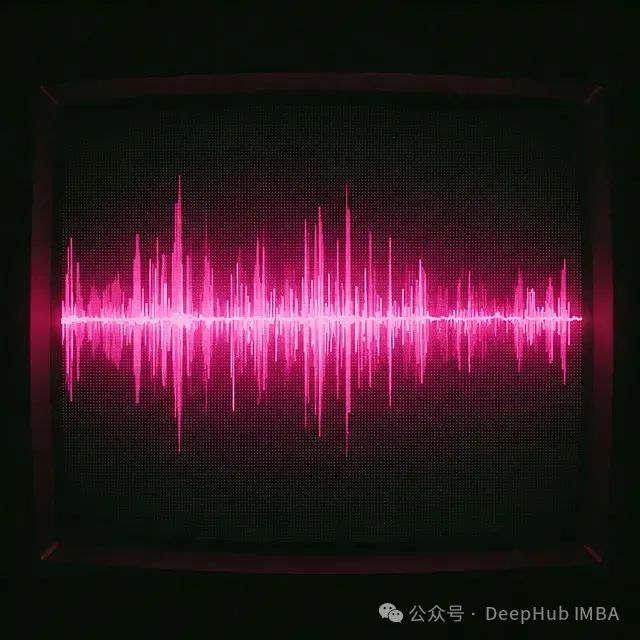

基于Transformer架构的时间序列数据去噪技术研究

本文将详细探讨一种基于Transformer架构的时间序列去噪模型的构建过程及其应用价值。

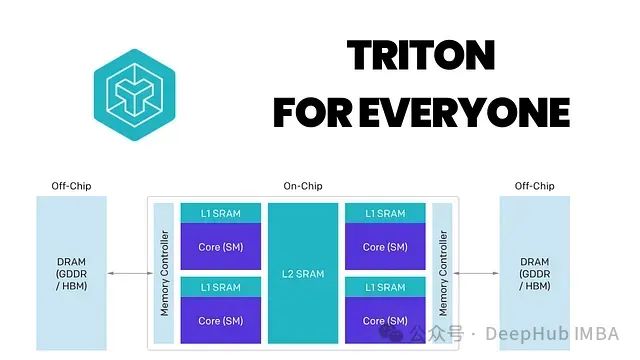

英伟达新一代GPU架构(50系列显卡)PyTorch兼容性解决方案

本文记录了在RTX 5070 Ti上运行PyTorch时遇到的CUDA兼容性问题,并详细分析了问题根源及其解决方案,以期为遇到类似情况的开发者提供参考。

FlashTokenizer: 基于C++的高性能分词引擎,速度可以提升8-15倍

FlashTokenizer是一款面向高性能计算的CPU分词引擎,专门针对BERT等Transformer架构的大型语言模型进行了底层优化。该引擎基于高效C++实现,采用了多项性能优化技术,确保在维持词元切分准确性的同时,大幅提升处理速度。