3. conda新建,删除,查看虚拟环境

在训练神经网络时,不同的实验和baseline对于环境的设置不同。我们不能把所有的python版本,各种库都封装在一个全局环境里,因此有了虚拟环境envs。conda可以创建和命名若干个虚拟环境,各个环境互不打扰。下面是常见的查看,创建,激活,退出以及删除虚拟环境的操作。

【超详细小白必懂】Pytorch 直接加载ResNet50模型和参数实现迁移学习

【超详细小白必懂】Pytorch 直接加载ResNet50模型和参数实现迁移学习

[linux-sd-webui]之txt2img

【代码】[linux-sd-webui]之txt2img。

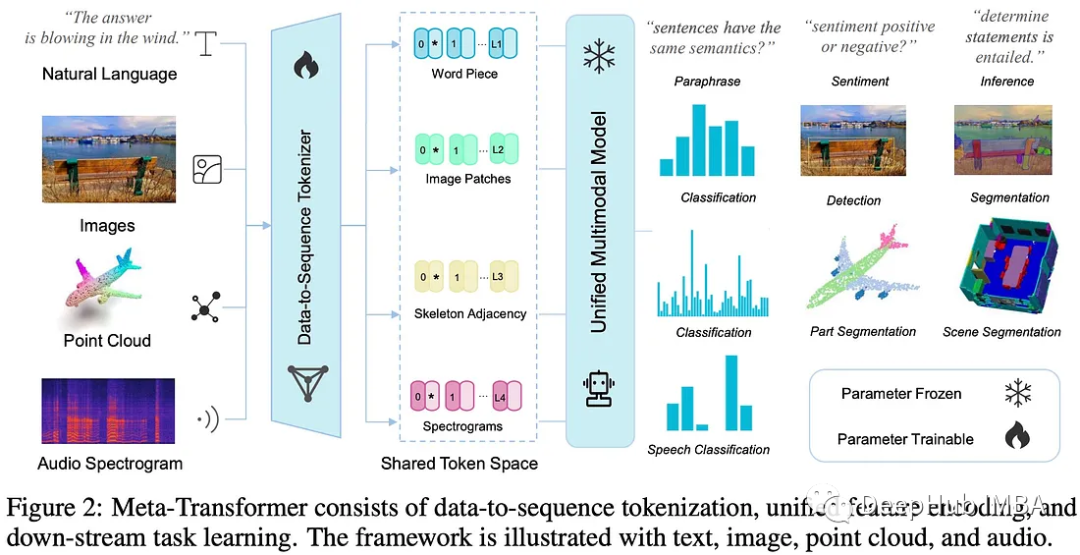

Meta-Transformer 多模态学习的统一框架

Meta-Transformer是一个用于多模态学习的新框架,用来处理和关联来自多种模态的信息

卸载cpu版本的torch并离线安装对应的gpu版本

每次从github上安装项目对应的库,利用requirements.txt安装很容易出现版本不对应的情况,尤其是将torch的gpu版本安装成cpu。这里记录一些查看版本的指令和离线安装的方法,就不用每次百度啦!(注:其他库的离线安装也可以用同样的方法,只需要去相应的网站下载wheel即可)第一个框

Pytorch 多GPU训练

Pytorch 多GPU训练

Darknet53详细原理(含torch版源码)

Darknet53详细原理(含torch版源码)—— cifar10

MSELoss详解+避坑指南

MSELoss详解+避坑指南

【YOLOX简述】

YOLOX简述

YOLOv7改进:在不同位置添加biformer

为了缓解多头自注意力()的可扩展性问题,先前的一些方法提出了不同的稀疏注意力机制,其中每个查询只关注少量的键值对,而非全部。为此,作者探索了一种动态的、查询感知的稀疏注意力机制,其关键思想是在粗糙区域级别过滤掉大部分不相关的键值对,以便只保留一小部分路由区域(这不就把冗余的信息干掉了吗老铁们)。其次

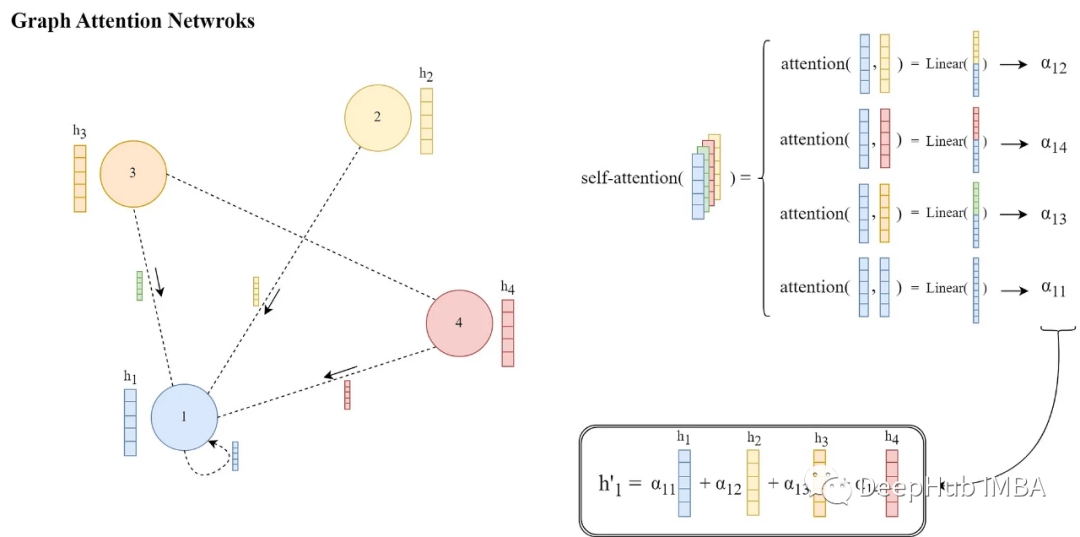

图注意力网络论文详解和PyTorch实现

图注意力网络(GAT)[1]是一类特殊的gnn,主要的改进是消息传递的方式。他们引入了一种可学习的注意力机制,通过在每个源节点和目标节点之间分配权重,

dropout层简介

这就是dropout层的思想了,**为什么dropout能够用于防止过拟合呢?**因为约大的神经网络就越有可能产生过拟合,因此我们随机删除一些神经元就可以防止其过拟合了,也就是让我们拟合的结果没那么准确。dropout顾名思义就是被拿掉的意思,正因为我们在神经网络当中拿掉了一些神经元,所以才叫做dr

A30、V100性能测试对比报告

共压80000数据,同时请求500数据。

ChatGPT如何训练自己的模型

这些数据集可以来自英文、中文和其他语言的数据集,但需要注意的是,由于ChatGPT是一个生成式模型,所以需要保证数据集中的对话质量和语言质量较高,否则影响对话的质量。总之,训练一个高品质的ChatGPT模型需要高质量的对话数据集、有效的数据预处理、强大的训练环境、合适的训练方法、有效的模型评估等多个

重新理解一个类中的forward()和__init__()函数

return out在上面的代码中,我们定义了一个名为SimpleNet的神经网络模型,它继承自 PyTorch 中的nn.Module类。我们在__init__()方法中定义了三层网络结构,分别是输入层fc1、激活层relu和输出层fc2。其中,输入层和输出层都使用了全连接层(nn.Linear)

pytorch交换tensor的指定维度

pytorch中有两种方式可以实现tensor指定维度的交换,第一个是torch.permute(),第二个方法是torch.transpose()。二者不同是torch.permute()可以同时交换多个维度,而torch.transpose()每次只能交换两个维度。

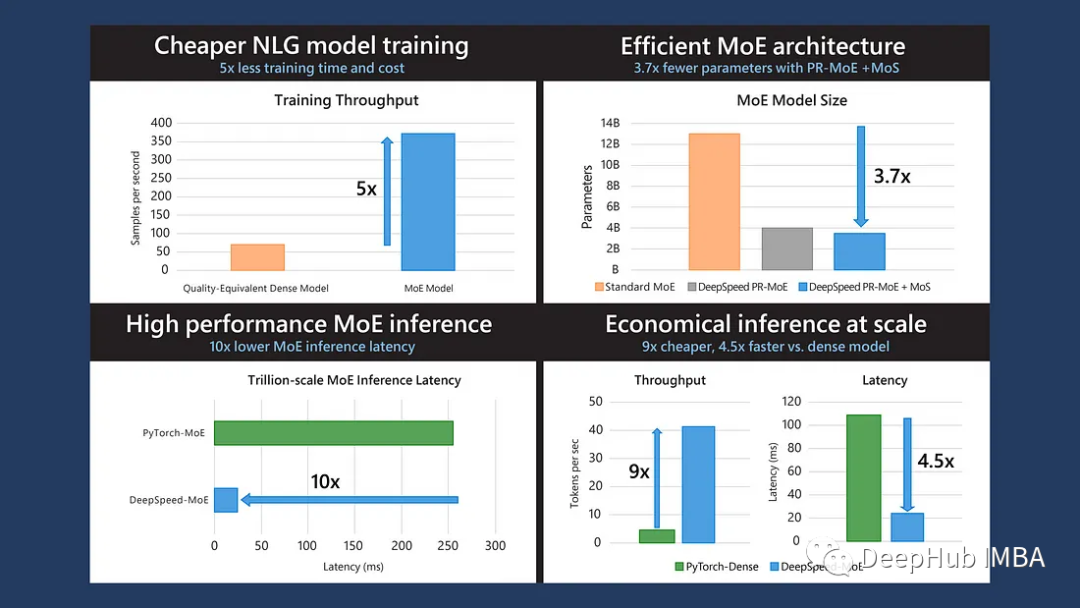

DeepSpeed-MoE:训练更大及更复杂的混合专家网络

这是微软发布在**2022 ICML**的论文,MoE可以降低训练成本,但是快速的MoE模型推理仍然是一个未解决的问题。所以论文提出了一个端到端的MoE训练和推理解决方案DeepSpeed-MoE:它包括新颖的MoE架构设计和模型压缩技术,可将MoE模型大小减少3.7倍;

yolov7使用onnx推理(带&不带NMS)

上个月,官方放了个使用onnx推理的ipynb文件,过了几天上去看,官方又给删了,不知道是不是要更新波大的,还好手快保存了一份,这个可以作为备忘,懒得再重新写(不过这得是多懒。熟悉yolo系列的朋友应该看出上面的问题了,没有NMS,这是因为官方代码在导出onnx的时候做了简化和端到端的处理。如果单纯

推荐一个最近刚出的比较全面的多模态综述:Multimodal Deep Learning

多模态综述:Multimodal Deep Learning。对多模态、CV 和 NLP 领域中一些任务的 数据集、模型、评价指标等等 都做了较详细的介绍和总结。是个非常不错的综述,内容较全面且详细。

transformers库中的.from_pretrained()

Transformers库中的预训练模型加载函数.from_pretrained()