【AI实战】llama.cpp 量化部署 llama-33B

llama.cpp 量化部署 llama-33B

【AI实战】从零开始搭建中文 LLaMA-33B 语言模型 Chinese-LLaMA-Alpaca-33B

从零开始搭建中文 LLaMA-33B 语言模型 Chinese-LLaMA-Alpaca-33B

llama.cpp LLM模型 windows cpu安装部署;运行LLaMA2模型测试

参考:https://www.listera.top/ji-xu-zhe-teng-xia-chinese-llama-alpaca/https://blog.csdn.net/qq_38238956/article/details/1301135991、下载:2、编译3、测试运行

【AI实战】开源大语言模型LLMs汇总

开源大语言模型LLM汇总

LLMs之LLaMA2:LLaMA2的简介(技术细节)、安装、使用方法(开源-免费用于研究和商业用途)之详细攻略

LLMs之LLaMA2:LLaMA2的简介(技术细节)、安装、使用方法(开源-免费用于研究和商业用途)之详细攻略目录LLaMA2的简介LLaMA2的简介LLaMA2的安装LLaMA2的使用方法相关文章LLMs之LLaMA:《LLaMA: Open and Efficient Foundation

使用QLoRa微调Llama 2

上篇文章我们介绍了Llama 2的量化和部署,本篇文章将介绍使用PEFT库和QLoRa方法对Llama 27b预训练模型进行微调。我们将使用自定义数据集来构建情感分析模型。

在自定义数据集上微调Alpaca和LLaMA

本文将介绍使用LoRa在本地机器上微调Alpaca和LLaMA

本地部署中文LLaMA模型实战教程,民间羊驼模型

LLaMA大部分是英文语料训练的,讲中文能力很弱。如果我们想微调训练自己的LLM模型,基于一个大规模中文语料预训练的模型比较好。目前开源项目很多,理想的项目要有以下特点:模型开源、训练代码开源、代码结构简单、环境容易安装、文档清晰。经过寻找与试验,我找到了一个比较好的项目。本博文要点如下:1 实战部

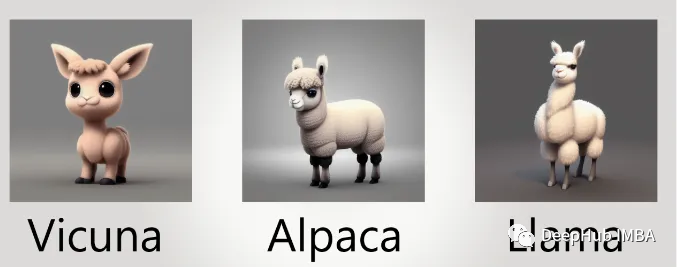

【AI热点技术】ChatGPT开源替代品——LLaMA系列之「羊驼家族」

GPT-3.5(text-davinci-003)、ChatGPT、Claude和Bing Chat等指令遵循模型的功能越来越强大。现在,许多用户定期与这些模型交互,甚至在工作中使用它们。然而,尽管指令遵循模型得到了广泛部署,但仍有许多不足之处:它们会产生虚假信息,传播社会刻板印象,并产生有毒语言。

上传、下载huggingface仓库文件(模型、数据等)

想要上传文件,例如模型权重的话,首先得找到自己huggingface hub的。最后用如下命令,把相关文件(模型、tokenizer)上传就行

MiniGPT-4 and LLaMA 权重下载

磁力 magnet:?xt=urn:btih:dc73d45db45f540aeb6711bdc0eb3b35d939dcb4&dn=LLaMA-也可以直接下载7B模型,index为:QmbvdJ7KgvZiyaqHw5QtQxRtUd7pCAdkWWbzuvyKusLGTw。安装ipfs客户端,下

[大模型] 搭建llama主流大模型训练环境

搭建llama大模型GPU训练环境,用于llama及其衍生模型的训练与微调

[大模型] LLaMA系列大模型调研与整理-llama/alpaca/lora(部分)

llama系列大模型调研及关键信息整理,llama/standford-alpaca/alpaca-lora/chinese-llama-alpaca/belle等

Meta 推出的 LLaMA 大语言模型部署教程

meta 推出的可以比肩chatGPT-3.5的 LLaMA 大语言模型的下载和部署流程

LLaMA模型文件 (搬运工)

如果要使用huggingface transformer训练LLaMA,需要使用额外的转换脚本(具体详见huggingface官网。建议提前确认自己的huggingface版本。或者使用上述已经被转换好的。但是申请的审批时间一般都很长。才能获得官方模型权重。

【LLM】Windows本地CPU部署民间版中文羊驼模型踩坑记录

想必有小伙伴也想跟我一样体验下部署大语言模型, 但碍于经济实力, 不过民间上出现了大量的量化模型, 我们平民也能体验体验啦~, 该模型可以在笔记本电脑上部署, 确保你电脑至少有16G运行内存。

类ChatGPT逐行代码解读(1/2):从零起步实现Transformer、ChatGLM-6B

transformer强大到什么程度呢,基本是17年之后绝大部分有影响力模型的基础架构都基于的transformer(比如,有200来个,包括且不限于基于decode的GPT、基于encode的BERT、基于encode-decode的T5等等)通过博客内的这篇文章《》,我们已经详细了解了trans

类ChatGPT项目的部署与微调(上):从LLaMA到Alpaca、Vicuna、BELLE

还开始研究一系列开源模型(包括各自对应的模型架构、训练方法、训练数据、本地私有化部署、硬件配置要求、微调等细节)该项目部分一开始是作为此文《》的第4部分,但但随着研究深入 为避免该文篇幅又过长,将把『第4部分 开源项目』抽取出来 独立成本文。

LLaMA:7B参数量的Baby版ChatGPT窥探

本文通过造一些prompt初步窥探了7B版本的LLaMA,所生成的结果比较依赖于prompt的质量,有资源可以尝试65B参数量的版本。