基于AI的RAG需要真正面对商业化场景和落地的几大致命陷井

人人在谈AI,可是AI落地在哪?AI到底可以给我们带来什么?为什么AI火了一年多,几乎看不到AI在垂直领域的大规模落地?在使用AI落地时有哪些坑需要避免?本文给你一一列出。而且每一个坑都是招招毙命的坑,希望借此文为更多的AI落地贡献出自己一份微薄的力量

text-generation-webui搭建大模型运行环境与踩坑记录

text-generation-webui是一个基于Gradio的LLM Web UI开源项目,可以利用其快速搭建部署各种大模型环境。

个人 AI 的革命:Nvidia‘s Chat with RTX 深度探索

Nvidia推出的 Chat with RTX 预示着个人 AI 新时代的到来。2 月 13 日,Nvidia 官宣了自家的 AI 聊天机器人,这不仅是人工智能交互的渐进式改进;更代表了个人如何利用自己的数据进行洞察、研究和知识发现的巨大转变。

每周AI新闻(2024年第3周)Meta研发Llama 3 | 苹果Vision Pro预售 | 智谱AI发布GLM-4

我是陌小北,一个正在研究硅基生命的、有趣儿的碳基生命。每周日20:00,准时解读每周AI大事件。

仅需5行代码,从HuggingFace到昇腾人工智能计算中心

HuggingFace Transformers用户的福音来了,昇腾推出高阶迁移工具Optimum Ascend ,只需几行代码可以让Transformers用户能够简单直接地在昇腾人工智能计算中心进行模型训练、微调和评估。在进行模型训练时,首先要设置好优化器。为了验证训练的有效性,可以看看一个原始

Llama中文社区开源预训练Atom-7B-chat大模型体验与本地化部署实测(基于CPU,适配无GPU的场景)

Llama中文社区开源预训练Atom-7B-chat大模型体验与本地化部署实测(基于CPU,适配无GPU的场景)

Mistral AI vs. Meta:顶级开源LLM比较

本文将比较Mistral 7B vs Llama 2 7B and Mixtral 8x7B vs Llama 2 70B

Llama2通过llama.cpp模型量化 Windows&Linux本地部署

本地部署和使用llama.cpp进行量化Llama2,linux和Windows平台方案,支持CPU和GPU多版本。

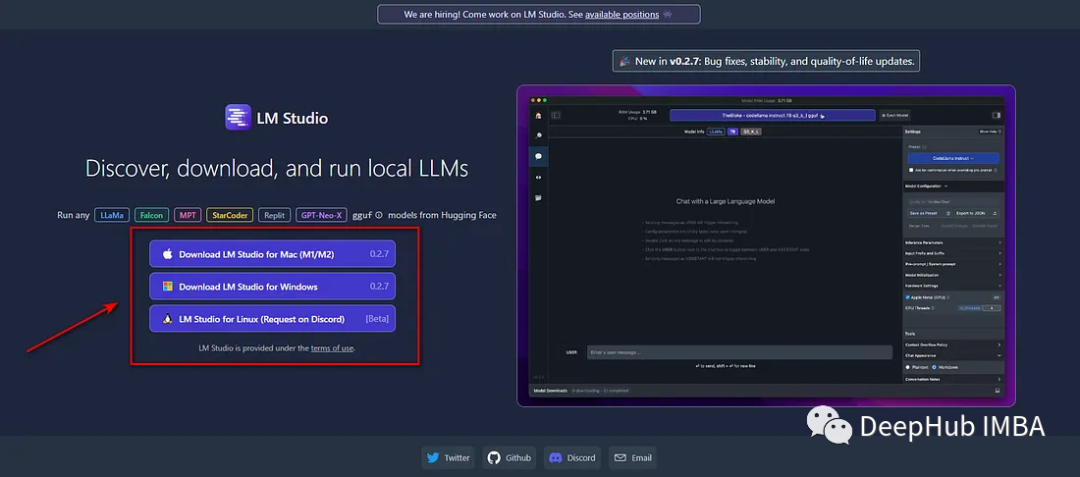

使用LM Studio在本地运行LLM完整教程

LM Studio是一个免费的桌面软件工具,它使得安装和使用开源LLM模型非常容易。

语言大模型的进化轨迹

ChatGPT的发布是语言大模型(LLM)发展史的转折点,它让人们意识到LLM的潜力,并引发了“AI竞赛”,世界上主要人工智能实验室和初创公司都参与其中。在这之后,基于LLM的聊天机器人层出不穷。ChatGPT及相关LLM模型让我们共同见证了AI的历史性变革,很多人好奇,LLM和它们的运作方式究竟是

LLM - LLaMA-2 获取文本向量并计算 Cos 相似度

基于 Cos 和 BERT-whitening 特征白化的大模型输出文本 Embeding 相似度评估。

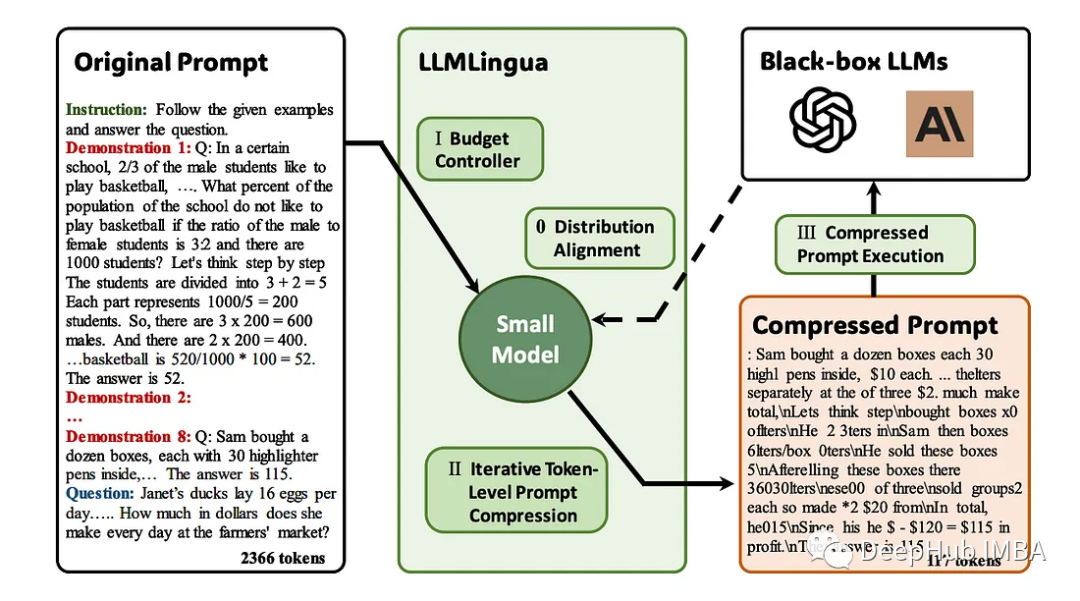

LLMLingua:集成LlamaIndex,对提示进行压缩,提供大语言模型的高效推理

大型语言模型(llm)的出现刺激了多个领域的创新。但是在思维链(CoT)提示和情境学习(ICL)等策略的驱动下,提示的复杂性不断增加,这给计算带来了挑战。

大模型Llama2部署,基于text-generation-webui、Llama2-Chinese

-配置python环境变量,路径:D:\oobabooga_windows\installer_files\env(自带python环境),使用python -m pip install gradio安装环境。--使用python -m pip install markdown安装环境。--又缺少m

“私密离线聊天新体验!llama-gpt聊天机器人:极速、安全、搭载Llama 2,尽享Code Llama支持!”

“私密离线聊天新体验!llama-gpt聊天机器人:极速、安全、搭载Llama 2,尽享Code Llama支持!”

医疗AI | 梳理全球医疗大模型

在辅助诊疗方面,灵医大模型可实现通过多轮对话了解病人病情,实时辅助医生确诊疾病,推荐治疗方案,提升就诊全流程的效率和体验,并成为患者的24小时“健康管家”,提供智能客服服务。所有知识来源都已经过验证,因而可为大模型输出的结果提供权威依据。卫宁健康已于2023年1月开展了医疗垂直领域的大语言模型WiN

Code Llama系列教程之 微调 CodeLlama 34B 以进行聊天(打造自己的代码AI)

虽然 Meta 的 Llama2 在 AI 领域引起了广泛关注,但 34b 模型却缺席了相当长一段时间。对于许多人来说,这个 34b 模型是运行本地 LLM 的理想选择,因为它与使用 4 位量化的单个 4090 GPU 兼容。我一直在热切地等待 Meta 发布这个特定的模型。幸运的是,Meta 最近

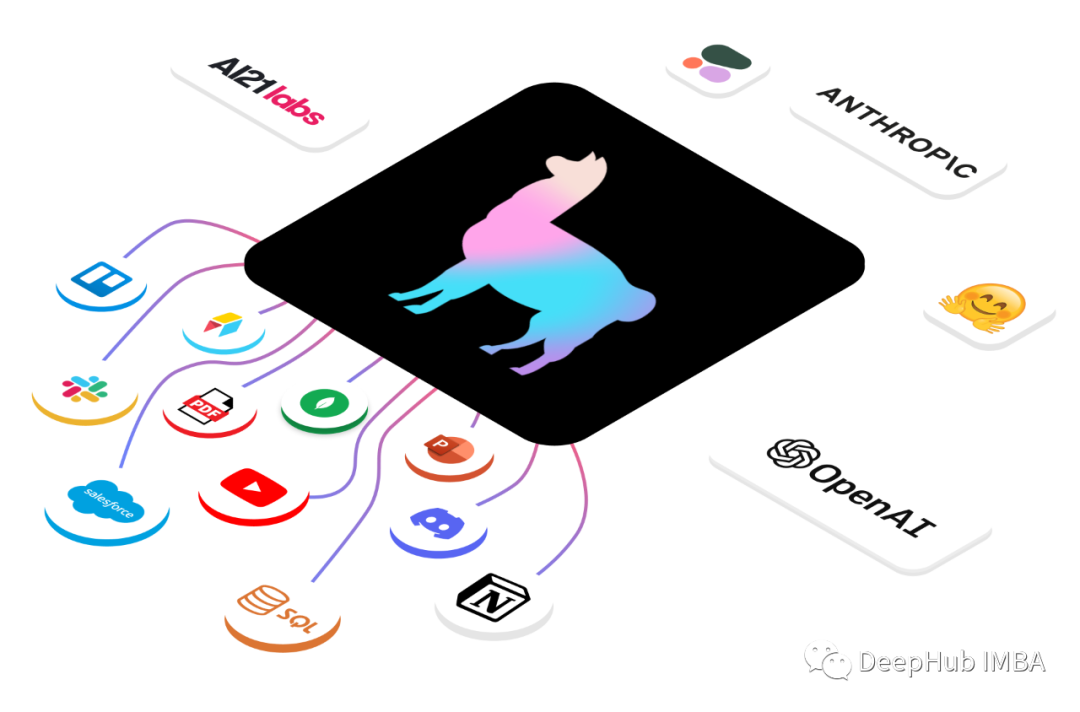

LlamaIndex使用指南

LlamaIndex是一个方便的工具,它充当自定义数据和大型语言模型(llm)(如GPT-4)之间的桥梁,大型语言模型模型功能强大,能够理解类似人类的文本

在低配Windows上部署原版llama.cpp

现在大语言模型的部署,通常都需要大的GPU才能实现,如果是仅仅想研究一下,大语言模型的算法,我们是很想能够直接在我们的工作电脑上就能直接运行的,llama.cpp就是很好的实现。LLaMa.cpp使用int4这种数值格式,其显著降低了内存需求,并且在大多数硬件上其性能严重受到内存限制。LLaMa.c

使用ExLlamaV2在消费级GPU上运行Llama2 70B

在本文中,我将展示如何使用ExLlamaV2以混合精度量化模型。我们将看到如何将Llama 2 70b量化到低于3位的平均精度。

基于Llama2和LangChain构建本地化定制化知识库AI聊天机器人

相比OpenAI的LLM ChatGPT模型必须网络连接并通过API key云端调用模型,担心数据隐私安全。基于Llama2和LangChain构建本地化定制化知识库AI聊天机器人,是将训练好的LLM大语言模型本地化部署,在没有网络连接的情况下对你的文件提问。100%私有化本地化部署,任何时候都不会